论文: https://doi.org/10.1016/j.inffus.2022.03.007

如有侵权请联系博主

介绍

最近在information fusion上又看到了一篇关于红外可视图像融合的论文,相对于之前的最大值和平均损失函数而言,这篇论文中提出了一种基于照明感知来确定损失函数权重的方法,我们一起来康康吧

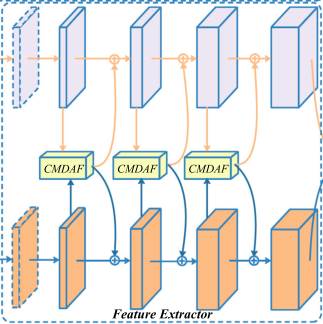

网络架构

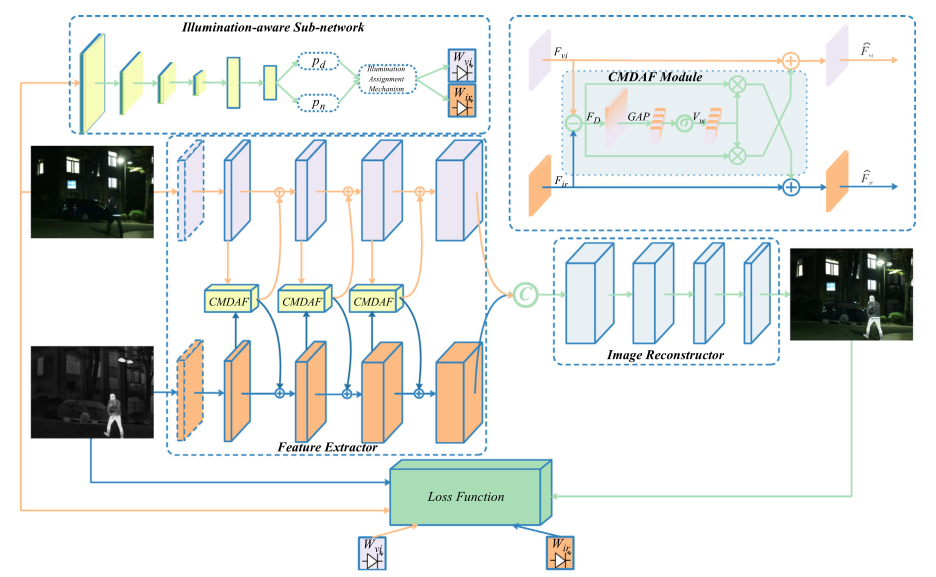

整体的网络架构如上图所示,整个网络架构并不是很复杂,可以简单的把网络分为特征提取,图像还原和光照感知网络三部分,接下来我们一起来看看。

光照感知网络

在介绍这个网络之前,我们先聊聊这个网络的作用是什么。

在介绍中我们已经提到了该篇论文采用照明感知来确定损失函数的权重,那么什么是照明感知?

在这篇论文中照明感知其实就是图像属于白天还是黑夜的概率,这个有什么用呢?

先看上面这四张图片,每一行分别为对应的可视和红外图像,第一行为白天图像,第二行为黑夜图像。

可以看到的是,白天图像中可视图像有着极佳的强度信息,而红外图像中的强度信息则不尽人意,因此作者希望尽可能保留白天可视图像中的强度信息。

而到了晚上之后,即第二行的图像,可以看到可视图像中包含极差的强度信息,相反,红外图像中则有很好的强度信息,此时作者就希望尽可能保留红外图像中的强度信息。

总结就是白天尽可能保留可视图像的强度,夜晚尽可能保留红外图像的强度。

那么怎么实现上述的操作呢?如果是你的话,你会怎么解决?

首先你是不是要知道这张图片是白天还是夜晚,那是不是要训练一个网络判断可视图像是白天还是夜晚,然后得到两个概率,白天概率和夜晚概率,然后以这个概率作为损失函数的权重。

如果你是这样想的话,那么恭喜你,作者就是这么想的,这就是我们要介绍的光照感知网络。

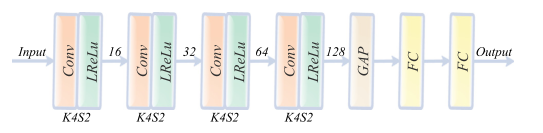

前面说了这么多,终于可以看网络架构了

整个网络很简单,由四个卷积层,两个全连接层和一个全局平均池化层组成。卷积层和全连接层我们都很熟悉了,但是全局平均池化可能不是很熟悉(也可能只有我一个人不熟悉)

全局平均池化和池化的区别就在于全局池化一个通道的数据会转换为一个值,而平均池化则取决于卷积核的大小等,也就是你输入一个三通道的数据到全局平局池化中,会生成三个均值,每一个均值对应一个通道。

通过这种方式,一方面我们可以提取每一个通道的特征,另一方面可以极大的减少参数量。

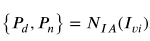

整个网络会根据输入的图像生成两个概率,分别是白天的概率和晚上的概率,公式如下图,Pd为白天的概率,Pn为晚上的概率,NIA就是我们上面提到的照明感知网络。

到现在为止我们就晓得了啥是光照感知网络,也知道这个网络的作用,接下来就来一起看看特征提取和图像还原两部分。

特征提取

CNN部分

特征提取的网络架构如上图所示。

注意看第一层,可以发现这一层的画风和其他层都不相同,这是不是作者画错了?显然不是

作者在这里介绍了,第一层是一个1x1的卷积层,主要的作用就是减少红外和可视两种模态特征的差异,为了达到这种效果,作者专门对第一层进行训练,然后遗憾的是作者没有写咋训练的。。。。。大佬们帮解答下

而后的的四层卷积都是3x3的并且是共享权重的,那么问题来了,为啥要是共享权重的?

因为前面我们已经提过了,第一层的作用就是尽可能减少两种模态之间的特征的差异。因为两种模态的图像表达信息的方式是不同的,但是我们希望表达这两类信息的方式应该是相同的,这样才可以方便后续特征的提取,这就是第一层的作用。

按照上面所说,此时我们我们描述两类图像中的信息的方式是相同的了,此时我们只需要以相同的方式提取两类图像中的特征即可,通过提取的特征就可以知道两模态图像之间特征的差别(这就是为什么要共享权重),并可以把互相缺乏的特征补上去。而如何找到缺乏的信息就是CMDAF的工作了。那么什么是CMDAF,接下来我们一起来看看。

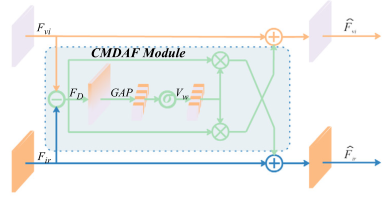

CMDAF

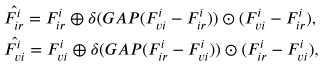

CMDAF的结构如上图所示,其中Fvi和Fir分别代表每一阶段提取的可视特征和红外特征,输入到CMDAF之后就得到了互补的特征信息。公式如下

这里的GAP就是全局平均池化,即一个通道生成一个值。我们先来描述下公式中进行的操作。

首先求出两类特征的差别,然后对这个差别进行全局平均池化,将得到的权重乘以这个差别,然后再加到原特征上,这就是上面公式的整个过程。

通过上面的方式,两种特征就可以拥有对方的互补特征。

这个过程在第2,3和4层卷积之后才会进行。

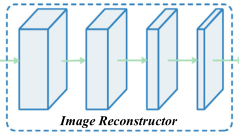

图像还原

图像还原这个部分就非常的友好了,就是简单的卷积层。

损失函数

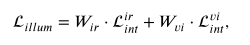

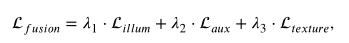

首先就是强度损失函数,作者使用前面我们提到的光照感知网络得到的权重来为红外强度损失和可视强度分配权重,强度损失函数如下

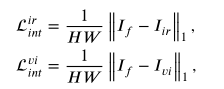

然后这样的强度损失还不足以生成最好的图像,因此作者又加入了一个辅助强度损失来使得图像可以生成更好的图像。

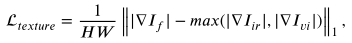

梯度这里还是我们熟悉的最大梯度

总损失如下图所示

总结

整篇文章让我最惊艳的就是在损失函数这里,不再简单的使用最大或则平均的方式,而是采用了根据照明情况来分配权重的方式,同样在特征提取部分也是十分精彩的,让我知道了特征提取还可以这样,总之,受益匪浅。

其他融合图像论文解读

==》读论文专栏,快来点我呀《==

【读论文】DIVFusion: Darkness-free infrared and visible image fusion

【读论文】RFN-Nest: An end-to-end residual fusion network for infrared and visible images

【读论文】Self-supervised feature adaption for infrared and visible image fusion

【读论文】FusionGAN: A generative adversarial network for infrared and visible image fusion

【读论文】DeepFuse: A Deep Unsupervised Approach for Exposure Fusion with Extreme Exposure Image Pairs

【读论文】DenseFuse: A Fusion Approach to Infrared and Visible Images

参考

[1] PIAFusion: A progressive infrared and visible image fusion network based on illumination aware