默认已安装CUDA、CUDNN、对应版本的pytorch等环境(注意版本对应就好)

重点说明用cmake去加载cuda和tensorRt库。

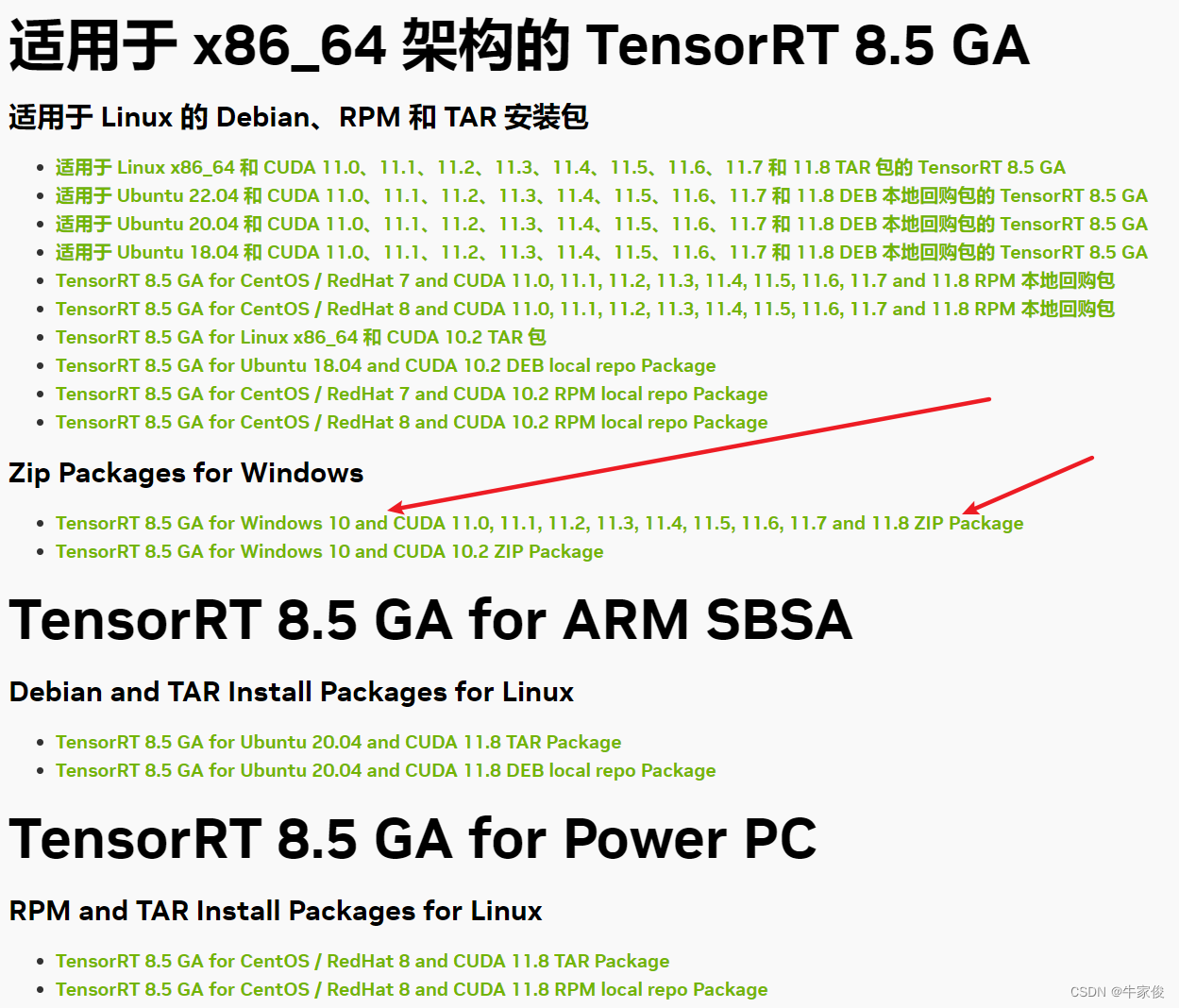

TensorRT下载官网:

https://developer.nvidia.com/nvidia-tensorrt-download

下载8 GA版本(稳定版本)即可。

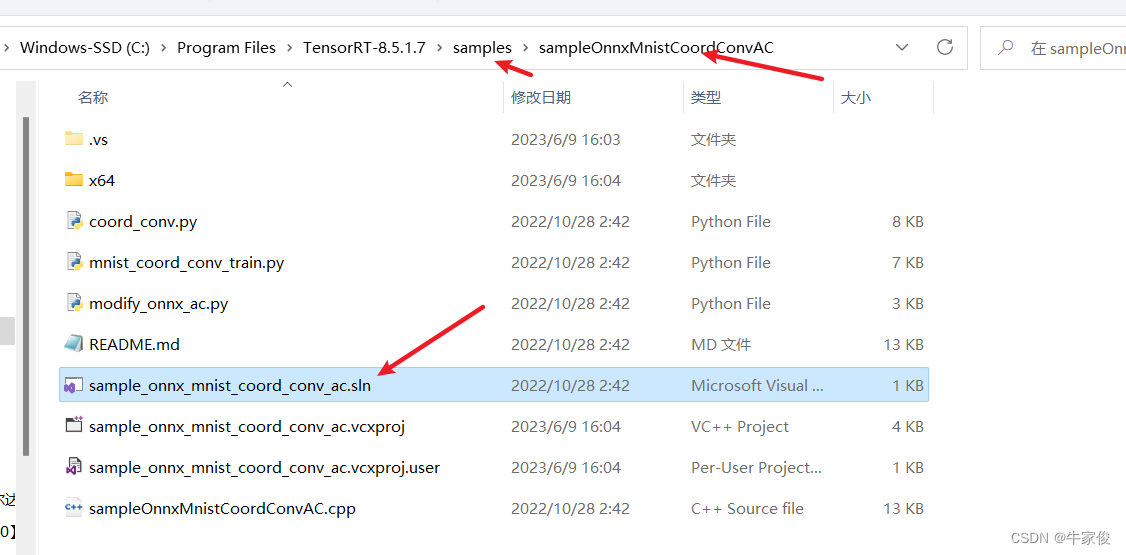

将下载的压缩包解压,然后放到自己合适的目录。如:C:\Program Files\TensorRT-8.5.1.7

将解压后目录中的lib绝对路径添加到环境变量。

将lib目录下的dll文件复制到CUDA目录:C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v11.1\bin。

- 如果是VS2019,就简单很多,直接选择导入项目,然后加载sln文件,run就好了。

- 如果是vscode或clion这种cmake来搭建环境的,照着下面的cmakelist写就好

cmake_minimum_required(VERSION 3.25)

project(tensorRtTest)

set(CMAKE_CXX_STANDARD 11)

set(TENSORRT_ROOT "C:/Program Files/TensorRT-8.5.1.7")

# 包含CUDA的头文件路径

find_package(CUDA REQUIRED)

include_directories(${CUDA_INCLUDE_DIRS})

# 包含TensorRT的头文件路径

include_directories(${TENSORRT_ROOT}/include)

# 添加可执行文件

add_executable(tensorRtTest main.cpp)

# 链接TensorRT的库文件

link_directories(${TENSORRT_ROOT}/lib)

target_link_libraries(tensorRtTest ${TENSORRT_LIBRARIES})

# 链接CUDA的库文件

target_link_libraries(tensorRtTest ${CUDA_LIBRARIES})

CUDA是可以通过find-package来直接找到的。

TensorRT是找不到的,需要set设置一下路径。

#include "NvInfer.h" 可以导入一下,看能不能跳转就好了。

- python 的话需要在tensorrt中选择对应的python编译器的版本,然后pip install wheel文件即可。