HBase 使用JDK21

启动zookeeper和hadoop

创建软件目录

mkdir -p /opt/soft

cd /opt/soft

下载软件

wget https://dlcdn.apache.org/hbase/2.5.6/hbase-2.5.6-hadoop3-bin.tar.gz

解压 hbase

tar -zxvf hbase-2.5.6-hadoop3-bin.tar.gz

修改 hbase 目录名称

mv hbase-2.5.6-hadoop3 hbase-2

配置环境变量

vim /etc/profile.d/my_env.sh

export HBASE_HOME=/opt/soft/hbase-2

export PATH=$PATH:$HBASE_HOME/bin

使环境变量生效

source /etc/profile

修改配置文件

cd /opt/soft/hbase-2/conf

hbase 环境变量

vim hbase-env.sh

export JAVA_HOME=/opt/soft/jdk-21

export HBASE_CLASSPATH=/opt/soft/hadoop-3/etc/hadoop

export HBASE_MANAGES_ZK=false

export HBASE_HEAPSIZE=1G

export HBASE_DISABLE_HADOOP_CLASSPATH_LOOKUP=true

export HBASE_JSHELL_ARGS="--startup DEFAULT --startup PRINTING --startup hbase_startup.jsh"

hbase 配置文件

vim hbase-site.xml

<?xml version="1.0"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<configuration>

<!-- mycluster是根据hdfs-site.xml的dfs.nameservices的value进行配置 -->

<property>

<name>hbase.rootdir</name>

<value>hdfs://lihaozhe/hbase</value>

</property>

<property>

<name>hbase.master</name>

<value>8020</value>

</property>

<!-- zookeeper集群 -->

<property>

<name>hbase.zookeeper.quorum</name>

<value>spark01:2181,spark02:2181,spark03:2181</value>

</property>

<property>

<name>hbase.cluster.distributed</name>

<value>true</value>

</property>

<property>

<name>hbase.unsafe.stream.capability.enforce</name>

<value>false</value>

</property>

</configuration>

regionservers

vim regionservers

spark01

spark02

spark03

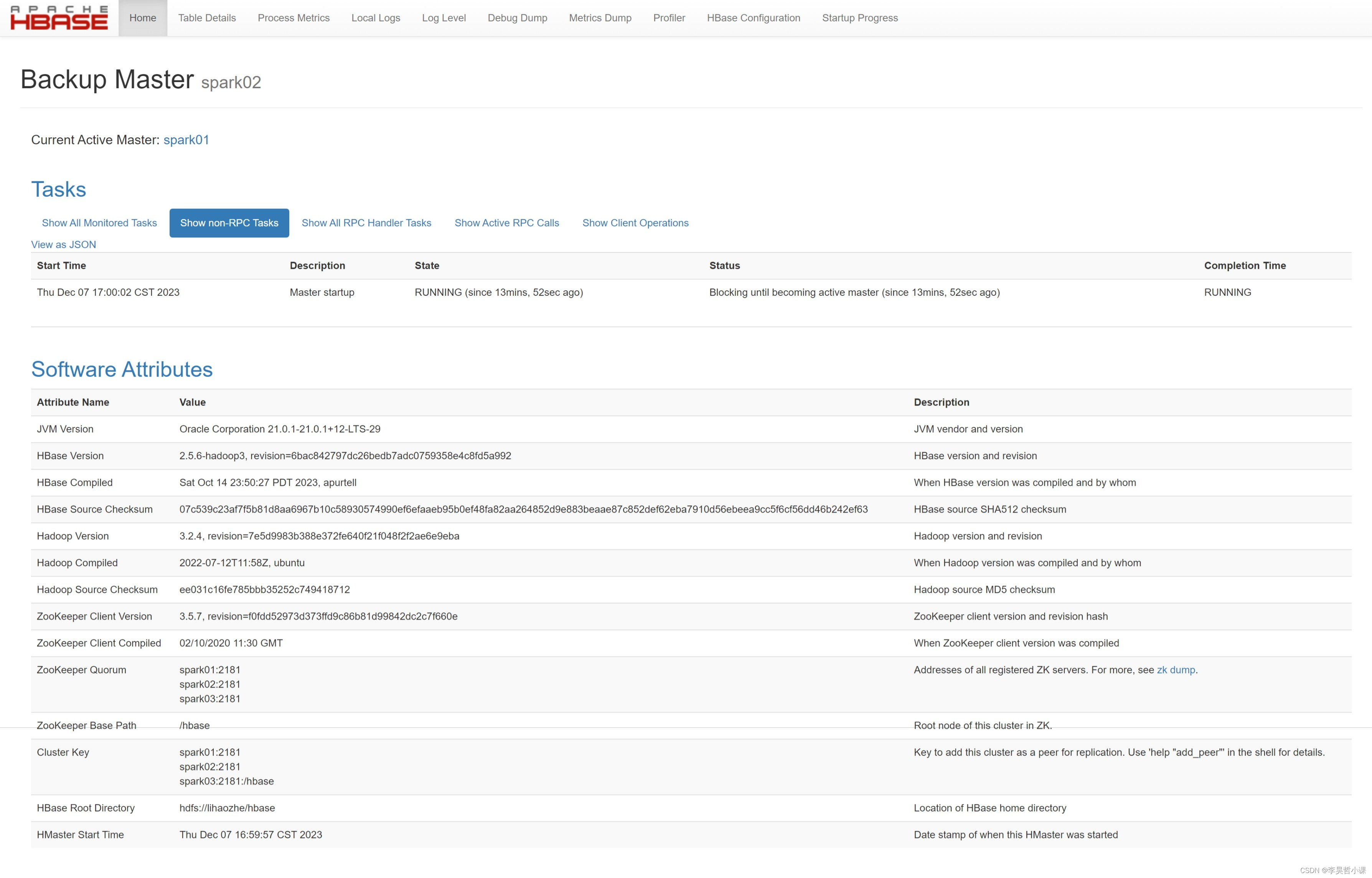

backup-masters

可以不配置

vim backup-masters

spark02

复制 hbase 到其他节点

scp -r /opt/soft/hbase-2 root@spark02:/opt/soft/

scp -r /opt/soft/hbase-2 root@spark03:/opt/soft/

复制环境变量到其他节点

scp /etc/profile.d/my_env.sh root@spark02:/etc/profile.d

scp /etc/profile.d/my_env.sh root@spark03:/etc/profile.d

# 在其他节点刷新环境变量

source /etc/profile

启动 hbase

start-hbase.sh

查看 Java 进程

jps

web ui

http://spark01:16010/

http://spark02:16010/