最近在看基于LSTM的的NER的任务,但是对padding有一些不解的地方

问题描述:

实体标签的数量:7,分别用数字1、2、3、4、5、6、7表示,因为在padding部分的标签补的是0,所以魏从0开始表示,那么padding之后标签的为0、1、2、3、4、5、6、7,变成8个了,一直很困惑第8类标签到底是什么?但在测试的语料中也未找到第8类标签,大胆的猜测是因为padding部分并未加入计算,具体是这个样子吗?

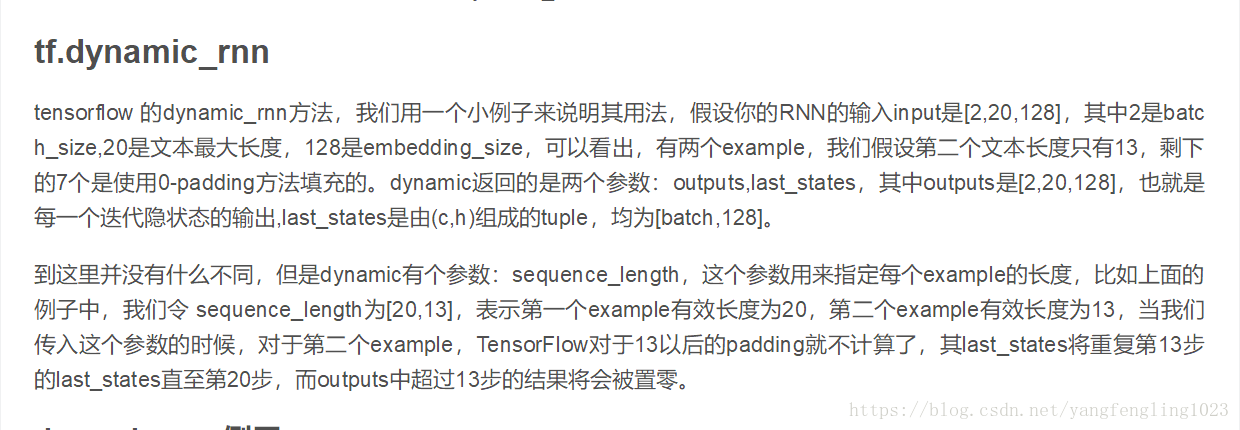

在网络这块用到的是tf.dynamic_rnn()

self.lstm:网络的状态

word_vectors:已经padding过后的输入

sequence_length:传入的是batch中每一个句子的实际长度(这个参数貌似在告诉我之前的猜测是对的)

查了一些资料,在https://blog.csdn.net/u010223750/article/details/71079036这篇博客中对tf.dynamic_rnn()有了比较详细且干货的讲解

虽然对输入的数据按照最长的句子进行了补0操作(padding),但是在真正的计算中会把补0的部分不加入计算行列,这样神经网络就不会学习到所谓的第8类标签

https://www.zhihu.com/question/52200883/answer/153694449 这个上面的Jarvis贾博士的回答也可以看一下