Spark具有从存储在HDFS或者HadAPI(Hive、HBase等)中的任何文件创造分布式弹性数据集的能力。

Spark的调度方式有:

yarn-cluster 适合生产场景

yarn-client 有互动需求

local 小规模本地运算

Spark+Hadoop 的结合能够提供内存级性能的企业级应用的威力。

安装前准备:

名称 版本

JDK 1.8.0

Hadoop 2.7.2

scala 2.11.6 http://www.scala-lang.org/download/2.11.6.html

spark 2.2.2 https://mirrors.cnnic.cn/apache/spark/spark-2.2.2/

spark 的运行要借助Scala JDK所以首先要配置Scala环境,并且 在yarn-cluster模式下,Spark是借助YARN做为其资源协商器,用来分配计算任务和使用各节点上的资源。

第一步:

将 spark-2.2.2-bin-hadoop2.7.tgz 上传到 /home 下

第二步:

解压 tar -xvf spark-2.2.2-bin-hadoop2.7.tgz

重命名: mv spark-2.2.2-bin-hadoop2.7.tgz spark

第三步:

配置环境变量 vim /etc/profile

export SPARK_HOME=/home/spark

export PATH=

SPARK_HOME/bin

执行变化:

source /etc/profile

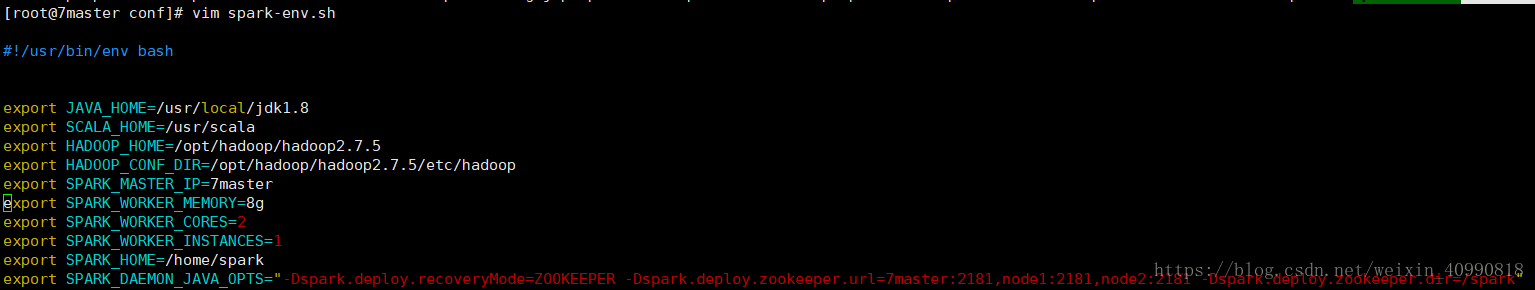

第四步:编辑 conf/spark-env.sh

export JAVA_HOME=/usr/local/jdk1.8

export SCALA_HOME=/usr/scala

export HADOOP_HOME=/opt/hadoop/hadoop2.7.5

export HADOOP_CONF_DIR=/opt/hadoop/hadoop2.7.5/etc/hadoop

export SPARK_MASTER_IP=7master

export SPARK_WORKER_MEMORY=8g

export SPARK_WORKER_CORES=2

export SPARK_WORKER_INSTANCES=1

export SPARK_HOME=/home/spark

export SPARK_DAEMON_JAVA_OPTS="-Dspark.deploy.recoveryMode=ZOOKEEPER -Dspark.deploy.zookeeper.url=7master:2181,node1:2181,node2:2181 -Dspark.deploy.zookeeper.dir=/spark"

第五步: 修改 slaves :

7master

node1

node2

第六步:将spark 分发到各节点相应位置:

scp -r spark root@node1:/home/

scp -r spark root@node2:/home/

第七步启动集群:

start-all.sh

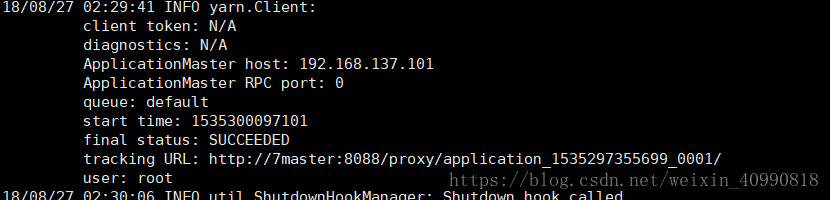

第八步 用测试集群

项目参考:https://blog.csdn.net/weixin_40990818/article/details/82026504

/bin spark-sumbit –master yarn-cluster com.csu.Credit Bank.jar