"Learning Efficient Convolutional Networks through Network Slimming"这篇文章提出了一种有效的结构性剪枝方法:在训练期间,通过对网络BN层的gamma系数施加L1正则约束,使得模型朝着结构性稀疏的方向调整参数。此时BN层的Gamma系数所起的作用,类似于信息流通道的开关系数,控制着信息流通道的闭合开关。完成稀疏训练之后,便可以按照既定的压缩比(或剪枝率)裁剪模型,能够生成低存储占用的精简模型、并提升一定的加速比。该方法与其他模型压缩方法(量化、低秩分解)结合使用,可以进一步提高压缩比;与其他优化加速方法(TensorRT等)结合使用,可以提高加速比;或者与知识蒸馏结合使用,可以进一步恢复损失的精度(尽可能逼近原复杂网络)。

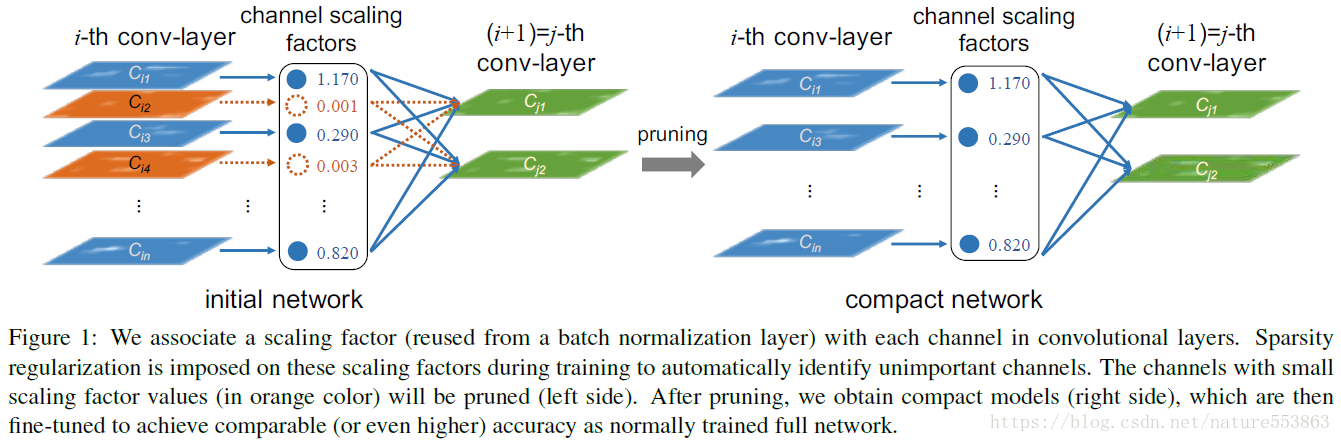

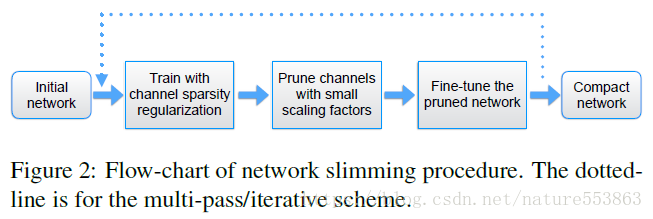

上图(图1、图2)显示了Network Slimming的基本流程,属于典型的迭代式过程(包含sparse-training、fine-tuning)。网络裁剪是在channel-level实施的规整操作,因此生成的精简模型能够直接运行在成熟框架(Pytorch、MXnet或TensorFlow等)或硬件平台上(GPU、FPGA等),无需特殊算法库的支持。Network Slimming的total loss设计如下:

在total loss中,除了基本的loss之外,引入了BN层Gamma系数的L1正则约束项,目的是为了诱导BN层的稀疏化。其中L1约束函数g( ) 仅施加于BN层的Gamma系数,因此在反向传播更新梯度时,Gamma系数的导数需要加上 [Gamma系数符号与惩罚系数的乘积项],Pytorch代码如下:

# additional subgradient descent on the sparsity-induced penalty term

def updateBN(model):

for n, m in model.named_modules():

if isinstance(m, nn.BatchNorm2d):

m.weight.grad.data.add_(args.s*torch.sign(m.weight.data)) # L1针对Resnet等包含BN层的CNN网络,Network Slimming方法在Cifar10、ImageNet2012等数据集上均获得了良好的压缩效果。但是冗余参数主要分布在网络的深层次,因此当压缩比为2倍时,实际加速比通常要小于2。当裁剪后精度损失严重时,该方法可以与知识蒸馏结合使用,通过原复杂模型的诱导训练能够恢复一定的精度。

论文地址:https://arxiv.org/abs/1708.06519

GitHub地址:https://github.com/foolwood/pytorch-slimming