l矩、中心矩、质心、patch方向

author@jason_ql

http://blog.csdn.net/lql0716

1、几何矩理论

1.1 矩与数学期望

- 数学期望

定义(一维离散):设

X∈[a,b] ,密度为f(x) ,数学期望为:

E(X)=∑i=1∞xiP(xi)

定义(一维连续):设

X 为连续型随机变量,其概率密度为f(x) ,则X的数学期望为:

E(X)=∫+∞−∞xf(x)dx 注:假定广义积分绝对收敛,即

∫+∞−∞|x|f(x)dx 存在

定义(二维离散):对于离散变量

(X,Y) 的P(xi,yi) ,PX(xi)=∑jP(xi,yj) 期望为:

E(X)=∑ixiPX(xi)=∑j∑ixiP(xi,yj)

E(Y)=∑jyjPY(yj)=∑j∑iyjP(xi,yj)

定义(二维连续):连续变量

(X,Y) 的f(x,y) :

扫描二维码关注公众号,回复: 3133410 查看本文章

fX(x)=∫+∞−∞f(x,y)dy

E(X)=∫+∞−∞xfX(x)dx=∫+∞−∞x(∫+∞−∞f(x,y)dy)dx=∫+∞−∞∫+∞−∞xf(x,y)dxdy

E(Y)=∫+∞−∞yfY(y)dy=∫+∞−∞∫+∞−∞yf(x,y)dxdy

- 原点矩

定义1:设

X 是随机变量,则称νk(X)=E(Xk) 为X 的k 阶原点矩。若

X 是离散型随机变量,则:νk(X)=∑ixkip(xi) 若

X 是连续型随机变量,则:νk(X)=∫+∞−∞xkf(x)dx

- 中心距

定义2:设

X 是随机变量,则称

为μk(X)=E(X−E(X))k X 的k 阶 中心距。若

X 是离散型随机变量,则:

μk(X)=∑i(xi−E(X))kp(xi) 若

X 是连续型随机变量,则:

μk(X)=∫+∞−∞(x−E(X))kf(x)dx

- 原点矩与中心距

当中心距中的

E(X) 为0时,此时为k 阶原点矩,即原点矩是中心距的特殊情况。一阶原点矩就是数学期望,二阶中心距就是方差,在实际中常用低阶矩,高于四阶矩极少使用。

原点矩与中心距的关系式:

以上可对

1.2 图像的矩

把图像的像素看做密度函数

一般来说,一阶矩和零阶矩可以计算某个形状的重心,二阶矩可以计算形状的方向。

图像的矩主要表征了图像区域的几何特征,又称几何矩,由于具有旋转、平移、尺度等不变的特兴奋,所以又称为不变矩。

利用不变矩可以计算出物体的圆形度(物体形状和园的接近程度)、物体的矩形度(物体形状和矩形的接近程度)、物体的水平和垂直对称性、物体的主轴方向、扁度等。

原点矩:

mpq=∑x−1M∑y−1Nxpyqf(x,y) 中心距:

μpq=∑x−1M∑y−1N(x−x0)p(y−y0)qf(x,y) 归一化中心距:

ηpq=μpqμr00

其中r=p+q+22,p+q=2,3,... 一阶矩:

见下面第2节.二阶矩:

物体形状的方向:

其中:

根据一阶矩的质心

2、质心原理

在图像处理中,一阶矩与形状有关,二阶矩显示曲线围绕直线平均值到扩展程度,三阶矩是关于平均值到对称性到测量.由二阶矩和三阶矩可以导出一组共7个不变矩.而不变矩是图像到统计特性,满足平移,伸缩,旋转均不变到不变性.

moments of a patch(矩):

mpq=∑x=−r,y=−rrxpyqI(x,y)(1) 角点为中心:

m00=∑x=−r,y=−rrx0y0I(x,y)=∑x=−r,y=−rrI(x,y)(1-1) 一阶矩

m01 :

m01=∑x=−r,y=−rrx0y1I(x,y)=∑x=−r,y=−rry∗I(x,y)(1-2) 一阶矩

m10 :

m10=∑x=−r,y=−rrx1y0I(x,y)=∑x=−r,y=−rrx∗I(x,y)(1-3) centroid(质心,亦可称为重心):

C=(m10m00,m01m00)(2)

计算质心的优势:对噪声不敏感。当有外部噪声干扰时,计算出的质心不会偏离太大。从数学的角度来看,这种方法是计算一个连通域的质心(或一个团块儿blob的质心)。构造一个向量

OC−→− ,从角点中心O 到质心C 。orientation of patch(方向):

θ=atan2(m01,m10)(3)

建立以角点为圆心的坐标系,如图

在图中,P 为角点,园内为取点区域,每个方格代表一个像素。

则质心Q 可根据式(2)求得。

3、中心距函数moments()

Calculates all of the moments up to the third order of a polygon or rasterized shape.

C++: Moments moments(InputArray array, bool binaryImage=false )

Python: cv2.moments(array[, binaryImage]) → retval

C: void cvMoments(const CvArr* arr, CvMoments* moments, int binary=0 )

Python: cv.Moments(arr, binary=0) → moments

Parameters:

array– Raster image (single-channel, 8-bit or floating-point 2D array) or an array ( 1 \times N or N \times 1 ) of 2D points (Point or Point2f ).

binaryImage– If it is true, all non-zero image pixels are treated as 1’s. The parameter is used for images only.

moments– Output moments.

- The function computes moments, up to the 3rd order, of a vector shape or a rasterized shape. The results are returned in the structure Moments defined as:

class Moments

{

public:

Moments();

Moments(double m00, double m10, double m01, double m20, double m11,

double m02, double m30, double m21, double m12, double m03 );

Moments( const CvMoments& moments );

operator CvMoments() const;

// spatial moments

double m00, m10, m01, m20, m11, m02, m30, m21, m12, m03;

// central moments

double mu20, mu11, mu02, mu30, mu21, mu12, mu03;

// central normalized moments

double nu20, nu11, nu02, nu30, nu21, nu12, nu03;

}4、中心矩示例代码

- opencv2.4.13

4.1 C++版代码

#include <QCoreApplication>

#include <opencv2/opencv.hpp>

// Qt Creator 4.2.0(Based on Qt 5.7.1)

// OpenCV 2.4.13

using namespace cv;

using namespace std;

#define name1 "原图"

#define name2 "效果图"

cv::Mat img, gray;

int nThresh = 100;

int nMaxThresh = 255;

cv::RNG rng(12345); //产生一个随机数

cv::Mat cannyImg;

std::vector<std::vector<cv::Point>> contours;

std::vector<cv::Vec4i> hierarchy;

//void on_ThreshChange( int, void* ){

// //canny边缘检测

// cv::Canny( gray, cannyImg, nThresh, nThresh*2, 3 );

// //找轮廓

// cv::findContours( cannyImg, contours, hierarchy, cv::RETR_TREE, cv::CHAIN_APPROX_SIMPLE, cv::Point( 0, 0 ) );

// //计算矩

// std::vector<cv::Moments> mu( contours.size() );

// for(unsigned int i = 0; i < contours.size(); i++){

// mu[i] = cv::moments( contours[i], false);

// }

// //计算中心矩

// std::vector<cv::Point2f> mc( contours.size() );

// for( unsigned int i = 0; i < contours.size(); i++ ){

// mc[i] = cv::Point2f( static_cast<float>(mu[i].m10 / mu[i].m00), static_cast<float>(mu[i].m01 / mu[i].m00));

// }

// //画轮廓

// cv::Mat drawing = cv::Mat::zeros( cannyImg.size(), CV_8UC3);

// for( unsigned int i = 0; i < contours.size(); i++ ){

// cv::Scalar color = cv::Scalar( rng.uniform(0, 255), rng.uniform(0, 255), rng.uniform(0, 255) );

// cv::drawContours( drawing, contours, i, color, 2, 8, hierarchy, 0, cv::Point() );

// cv::circle( drawing, mc[i], 4, color, -1, 8, 0 );

// }

// cv::namedWindow( name2, cv::WINDOW_NORMAL);

// cv::imshow( name2, drawing );

// std::cout << "输出内容: 面积和轮廓长度 \n" << std::endl;

// for(unsigned int i = 0; i < contours.size(); i++ ){

// std::cout << ">通过m00计算出轮廓[" << i << "]的面积:(M_00) =" << mu[i].m00 << "\n OpenCV 函数计算出的面积 = " << cv::contourArea(contours[i]) << "长度:" << cv::arcLength( contours[i], true) << "\n\n" << std::endl;

// cv::Scalar color = cv::Scalar( rng.uniform(0, 255), rng.uniform(0, 255), rng.uniform(0, 255) );

// cv::drawContours(drawing, contours, i, color, 2, 8, hierarchy, 0, cv::Point() );

// cv::circle( drawing, mc[i], 4, color, -1, 8, 0 );

// }

//}

int main(){

img = cv::imread( "/home/jason/jason2/photo/1.jpg" );

cv::cvtColor( img, gray, cv::COLOR_BGR2GRAY );

cv::blur( gray, gray, cv::Size(3, 3) );

cv::namedWindow( name1, cv::WINDOW_NORMAL );

cv::imshow( name1, img );

// cv::createTrackbar( "阈值", name1, &nThresh, nMaxThresh, on_ThreshChange );

// on_ThreshChange( 0, 0 );

//canny边缘检测

cv::Canny( gray, cannyImg, nThresh, nThresh*2, 3 );

//找轮廓

cv::findContours( cannyImg, contours, hierarchy, cv::RETR_TREE, cv::CHAIN_APPROX_SIMPLE, cv::Point( 0, 0 ) );

//计算矩

std::vector<cv::Moments> mu( contours.size() );

for(unsigned int i = 0; i < contours.size(); i++){

mu[i] = cv::moments( contours[i], false);

}

//计算中心矩

std::vector<cv::Point2f> mc( contours.size() );

for( unsigned int i = 0; i < contours.size(); i++ ){

mc[i] = cv::Point2f( static_cast<float>(mu[i].m10 / mu[i].m00), static_cast<float>(mu[i].m01 / mu[i].m00));

}

//画轮廓

cv::Mat drawing = cv::Mat::zeros( cannyImg.size(), CV_8UC3);

for( unsigned int i = 0; i < contours.size(); i++ ){

cv::Scalar color = cv::Scalar( rng.uniform(0, 255), rng.uniform(0, 255), rng.uniform(0, 255) );

cv::drawContours( drawing, contours, i, color, 2, 8, hierarchy, 0, cv::Point() );

cv::circle( drawing, mc[i], 4, color, -1, 8, 0 );

}

cv::namedWindow( name2, cv::WINDOW_NORMAL);

cv::imshow( name2, drawing );

std::cout << "输出内容: 面积和轮廓长度 \n" << std::endl;

for(unsigned int i = 0; i < contours.size(); i++ ){

std::cout << ">通过m00计算出轮廓[" << i << "]的面积:(M_00) =" << mu[i].m00 << "\n OpenCV 函数计算出的面积 = " << cv::contourArea(contours[i]) << "长度:" << cv::arcLength( contours[i], true) << "\n\n" << std::endl;

cv::Scalar color = cv::Scalar( rng.uniform(0, 255), rng.uniform(0, 255), rng.uniform(0, 255) );

cv::drawContours(drawing, contours, i, color, 2, 8, hierarchy, 0, cv::Point() );

cv::circle( drawing, mc[i], 4, color, -1, 8, 0 );

}

cv::waitKey(0);

return 0;

}

原图:

效果图:

部分打印结果:

4.2 Python版代码

# -*- coding: utf-8 -*-

"""

Created on Sun Mar 26 18:36:19 2017

@author: lql0716

"""

import cv2

import numpy as np

nThresh = 100

nMaxThresh = 255

img = cv2.imread('D:/photo/04.jpg')

gray = cv2.cvtColor(img, cv2.COLOR_RGB2GRAY)

gray = cv2.blur(gray, (3,3))

cv2.namedWindow('img', cv2.WINDOW_NORMAL)

cv2.imshow('img', img)

cannyImg = cv2.Canny(gray, nThresh, nThresh*2, 3)

contours, hierarchy = cv2.findContours(cannyImg, cv2.RETR_TREE, cv2.CHAIN_APPROX_SIMPLE)

mu = []

mc = []

retval = np.array([])

for i in range(0, np.array(contours).shape[0]):

retval = cv2.moments(contours[i], False)

mu.append(retval)

mu = np.array(mu)

#print mu[0]['m10']

thetas = []

for i in range(0, np.array(contours).shape[0]):

if mu[i]['m00'] == 0.0:

a=0

b=0

else:

a = mu[i]['m10'] / mu[i]['m00'] #质心x坐标

b = mu[i]['m01'] / mu[i]['m00'] #质心y坐标

#根据二阶矩计算物体形状的方向

r1 = mu[i]['m20'] / mu[i]['m00'] - a*a

r2 = 2.0*(mu[i]['m11'] / mu[i]['m00'] - a*b)

r3 = mu[i]['m02'] / mu[i]['m00'] - b*b

# print r1-r3

if r1-r3==0:

theta = np.pi / 2

else:

theta = np.arctan(r2/(r1-r3)) / 2

thetas.append(theta)

mc.append([a,b])

mc = np.array(mc)

drawing = np.zeros(img.shape, dtype = np.uint8)

for i in range(0, mc.shape[0]):

c1 = np.random.randint(0, 256)

c2 = np.random.randint(0, 256)

c3 = np.random.randint(0, 256)

cv2.drawContours(drawing, contours, i, (c1, c2, c3), 2, 8)

cv2.circle(drawing, (int(round(mc[i][0])), int(round(mc[i][1]))), 4, (c1, c2, c3), -1, 8, 0)

cv2.namedWindow('img2', cv2.WINDOW_NORMAL)

cv2.imshow('img2', drawing)

cv2.waitKey(0) 原图:

效果图:

5、Hu矩HuMoments()

原点矩:

中心距:

归一化中心距:

其中

当图像变化时,

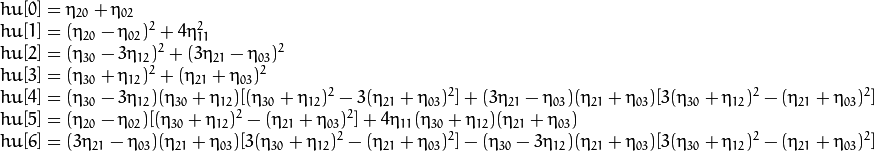

Hu矩利用二阶、三阶中心距构造了7个不变矩,它们在连续图像条件下可保持平移、旋转、伸缩不变,公式如下:

以下公式为官方文档的公式:

在对图片识别过程中,只有

Hu矩的优势:速度快

Hu矩的劣势:识别率低

Hu矩一般用来识别图像中大的物体,对物体的形状描述得比较好,图像的纹理特征不能太复杂,如识别水果形状或车牌字符的效果较好.

- 参考: