这篇内容为理论,具体的实现实战:

大数据(十一):https://blog.csdn.net/qq_34886352/article/details/82591296

一、MapReduce工作机制

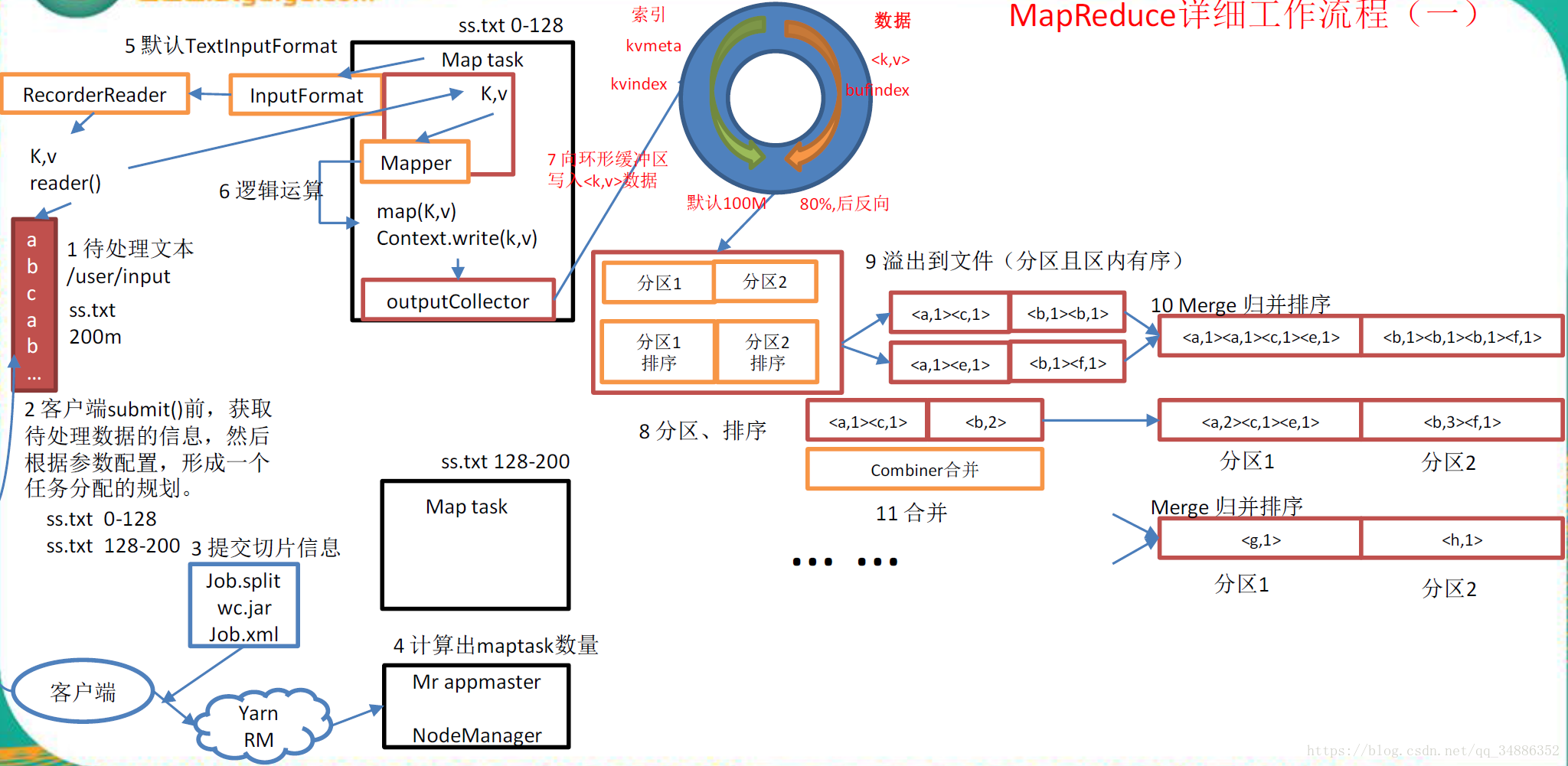

上面的流畅是整个MapReduce最全的工作流程,但是shuffle过程只是从第7步开始到第16结束,具体shuffle过程如下:

-

MapTask收集我们的map()方法输出的KV对,放到内存缓冲区中。

-

从内存缓冲区不断溢出本地磁盘文件,可能会溢出多个文件

-

多个溢出文件会被合并成大的溢出文件

-

在溢出过程中,及合并的过程,都要调用partitioner进行分区和针对key进行排序

-

reducetask根据自己的分区号,去各个maptask机器上获取相应的结果分区数据

-

reducetask会取到同一个分区的来自不同maptask的结果文件,reducetask会将这些文件再次进行合并(归并排序)

-

合并成大文件后,shuffle的过程也就结束了,后面进入reducetask的逻辑运算过程(从文件中取出一个一个的键值对group,调用用户自定义的reduce()方法)

注意点:

Shuffle中的缓冲区大小会影响到MapReduce程序的执行效率,原则上说,缓冲区越大,磁盘io的次数越小,执行速度就越快。

二、InputFormat数据输入

1.job提交流程分析

waitForCompletion()

submit()

1.建立连接

connect()

1.1创建提交job代理

new Cluster(getConfiguration)

1.1.1判断是本地yarn还是远程

initialize(jobTrackAddr,conf)

2.提交job

submitter.submitJobInternal(Job.this,cluster)

2.1创建给集群提交数据的stag路径

Path jobStagingArea = JobSubmissionFiles.getStagingDir(cluster,conf)

2.2.获取jobid,并创建job路径

jobID jobId = submitClient.getNewJobID();

2.3拷贝jar包到集群

copyAndConfigureFiles(job,submitJobDir);

rUploader.uploadFiles(job,jobSubmitDir);

2.4计算切片,生成切片规划文件

writeSplits(jbo,submitJobDir);

maps=writeNewSplits(job,jobSubmitDir);

input.getSplits(job);

2.5向stag路径写xml配置文件

writeConf(conf,submitJobFile);

conf.writeXml(out);

2.6提交job,返回提交状态

status = submitClient.submitJob(jobld,submitJobDir.toString(),job.getCredentials())2.FileInputFormat源码机制(input.getSplits(job))

-

找到数据存储的目录

-

开始遍历处理(规划切片)目录下的每一个文件

-

遍历第一个文件ss.txt

-

获取文件大小fs.sizeOf(ss.txt)

-

计算切片大小computeSliteSize(Math.max(minSize,Math.min(maxSize,blocksize)))=blocksize=128M

-

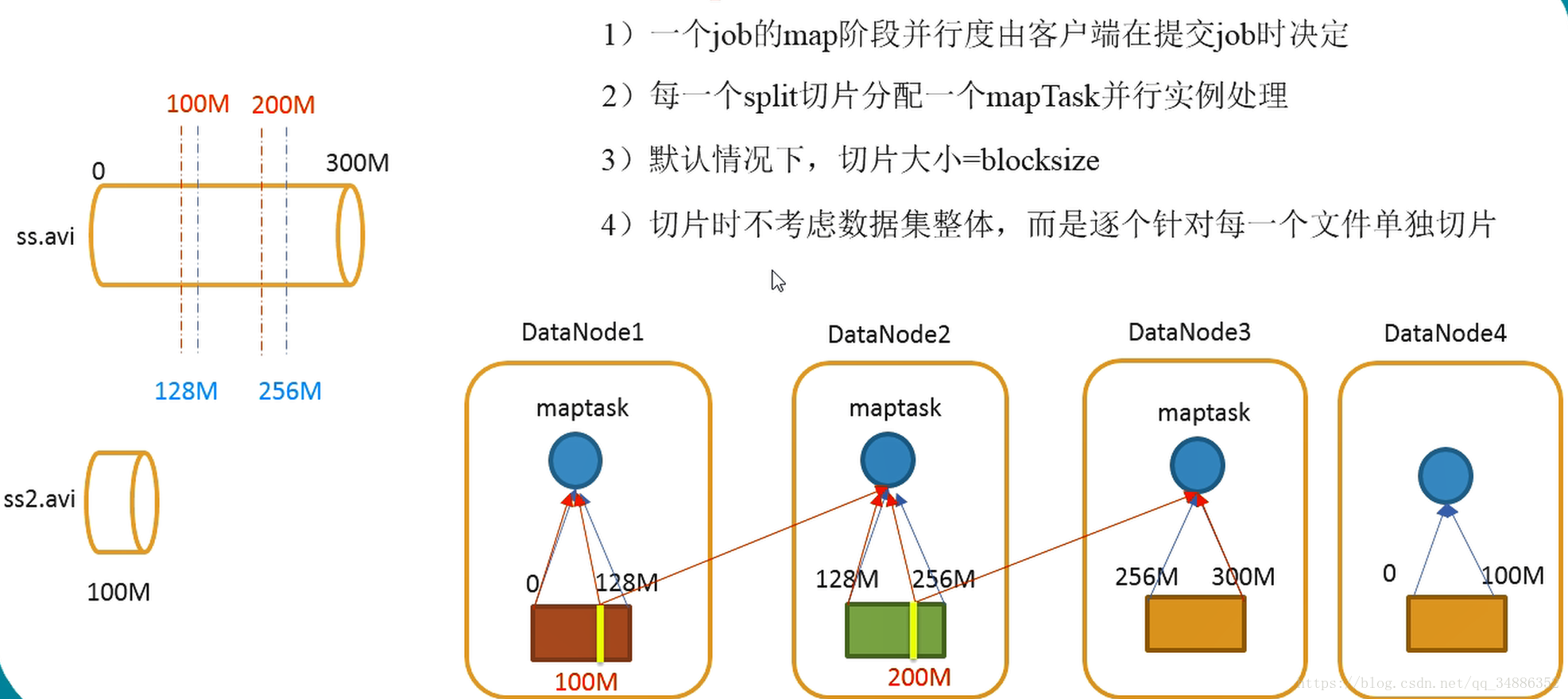

默认情况下,切片大小=blocksize

-

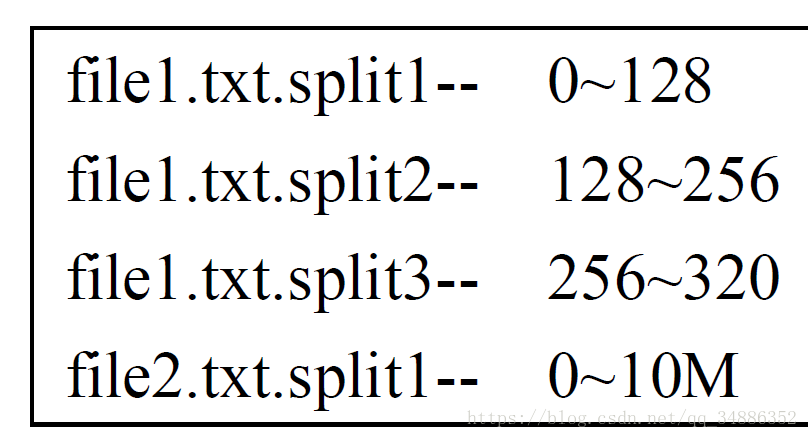

开始切片,形成第一个切片:ss.txt-0:128M 第二个切片ss.txt-128:256M 第3个切片ss.txt-256M:300M(每次切片时,都要判断切完剩下的部分是否大于块的1.1倍,不大于1.1倍就划分一块切片)

-

将切片信息写到一个切片规划文件中

-

整个切片的核心过程在getSplit()方法中完成。

-

数据切片只是在逻辑上对输入数据进行分片,并不会再磁盘上将其切分成分片进行存储。InputSplit只记录了分片的元数据信息,比如起始位置、长度以及所在的节点列表等。

-

注意:block是HDFS物理上存储的数据,切片时对数据逻辑上的划分。

-

-

提交切片规划文件到yarn上,yarn上的MrAppMaster就可以根据切片规划文件计算开启maptask个数

3.FileInputFormat切片机制

-

FileInputFormat中默认的切片机制:

-

简单地按照文件的内容长度进行切片

-

切片大小,默认等于block大小

-

切片时不考虑数据集整体,而是逐个针对每一个文件单独切片

-

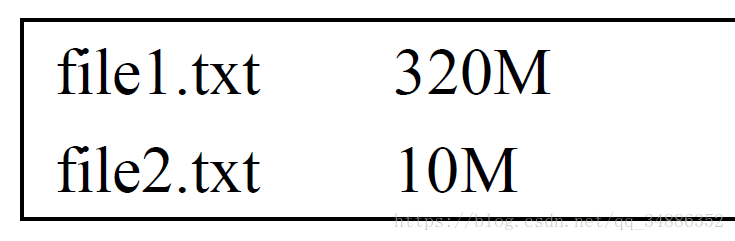

比如待处理数据有两个文件:

-

经过FileInputFormat的切片机制运算后,形成的切片信息如下:

-

-

-

FileInputFormat切片大小的参数配置

-

通过分析源码,在FileInputFormat中,计算切片大小的逻辑:Math.max(minSize,Math.min(maxSize,blockSize))

-

切片主要由这几个值来运算决定

-

mapreduce.input.fileinputformat.split.minsize=1 默认值为1

-

mapreduce.input.fileinputformat.split.maxsize=Long.MAXValue 默认值Long.MAXValue因此,默认情况下,切片大小=blocksize

-

maxsize(切片最大值):参数如果调到比blocksize小,则会让切片变小,而且就等于配置的这个参数的值。

-

minsize(切片最小值):参数调的比blockSize大,则可以让切片变得比blocksize还大。

-

-

获取切片信息Api

-

// 根据文件类型获取切片信息

FileSplit inputSplit = (FileSplit)Context.getInputSplit();

//获取切片的文件名称

String name = inputSplit.getPath().getName();3.CombineTextInputFormat切片机制(关于大量小文件的优化策略)

-

默认情况下TextInputFormat对任务的切片机制是按文件规划切片,不管文件多小,都会是一个单独的切片,都会交给一个maptask,这样如果有大量小文件,就会产生大量的maptask,处理效率及其地下。

-

优化策略

-

最好的办法,在数据处理系统的最前端(预处理/采集),将小文件先合并成大文件,再上传到HDFS做后续分析。

-

补救措施:如果已经是大量小文件在HDFS中了,可以使用另一种InputFormat来做切片(CombineTextInputFormat),它的切片逻辑跟TextFileInputFormat不同:他可以将多个小文件从逻辑上规划到一个切片中,这样,多个小文件就可以交给一个maptask。

-

优先满足最小切片大小,不超过最大切片大小

-

CombineTextInputFormat.setMaxInputSplitSize(job,4194304) ;//4m

-

CombineTextInputFormat.setMixInputSplitSize(job,2097152) ;//2m

-

-

-

具体实现步骤

//如果不设置InputFormat,它默认用的是TextInputFormat.class

job.setInputFormatClass(CombineTextInputFormat.class)

CombineTextInputFormat.setMaxInputSplitSize(job,4194304);//4m

CombineTextInputFormat.setMixInputSplitSize(job,2097152);//2m4.InputFormat接口实现类

MapReduce任务的输入文件一般是存储在HDFS里面。输入的文件格式包括:基于行的日志文件、二进制文件格式文件等。这些文件一般会很大,达到数十GB,甚至更大。

InputFormat常见的接口实现类包括:TextInputFormat、KeyValueTextInputFormat、NLineInputFormat、CombineTextInputFormat和自定义InputFormat等。

1.TextInputFormat

TextInputFormat是默认的InputFormat。每条记录是一行输入。键是LongWritable类型,存储该行在整个文件中的字节偏移量。值是这行的内容,不包括任何行终止符(换行符和回车符)

以下是一个实例,比如,一个分片包含了如下4条文本记录。

Rich learning form

Intelligent learning engine

Learning more convenient

From the real demand for more close to the enterprise每条记录表示为以下键/值对:

0:Rich learning form

19:Intelligent learning engine

47:Learning more convenient

72:From the real demand for more close to the enterprise很明显,键并不是行号。一般情况下,很难取得行号,因为文件按字节而不是按行切分为分片。

2.KeyValueTextInputFormat

每一行均为一条记录,被分隔符分割为key,value。可以通过在驱动类中设置conf.set(KeyValueLineRecordReader.KEY_VALUE_SEPERATOR,"");来设定分隔符。默认分隔符是tab(\t)

以下是一个实例,输入是一个包含4条记录的分片。其中->表示一个(水平方向的)制表符。

line1 ->Rich learning form

line2 ->Intelligent learning engine

line3 ->Learning more convenient

line4 ->From the real demand for more close to the enterprise每条记录表示为以下键/值对:

line1:Rich learning form

line2:Intelligent learning engine

line3:Learning more convenient

line4:From the real demand for more close to the enterprise此时的键是每行排在制表符之前的Text序列。

3.NLineInputFormat

如果使用NlineInputFormat,代表每个map进程处理的InputSplit不再按block块去划分,而是按NlineInputFormat指定的行数N来划分。即输入文件的总行数/N=切片数,如果不整除,切片数=商+1。

以下是一个实例,仍然以上面的4行输入为例。

line1 ->Rich learning form

line2 ->Intelligent learning engine

line3 ->Learning more convenient

line4 ->From the real demand for more close to the enterprise例如,如果N是2,则每个输入分片包含两行。开启2个maptask

0:Rich learning form

19:Intelligent learning engine另一个mapper则收到后两行

47:Learning more convenient

72:From the real demand for more close to the enterprise这里的键和值与TextInputFormat生成的一样。

5.自定义InputFormat

概述

1.自定义一个类继续FileInputFormat

2.改写RecordReader,实现一次读取一个完整文件封装为KV。

3.在输出时使用SequenceFileOutPutFormat输出合并文件。