格式化命令:

1.关于hdfs的格式化

首次启动需要进行格式化

格式化本质是进行文件系统的初始化操作 创建一些自己所需要的文件

格式化之后 集群启动成功 后续再也不要进行格式化

格式化的操作在hdfs集群的主角色(namenode)所在机器上操作

命令如下:

hdfs namenode–format

hadoop namenode –format2.格式化涉及到的配置文件

关于hadoop的配置文件:

**-site.xml 这里面配置了用户需要自定义的配置选项.

如不配置,就按官网的默认配置进行初始化

在官网可以查看默认配置的信息:

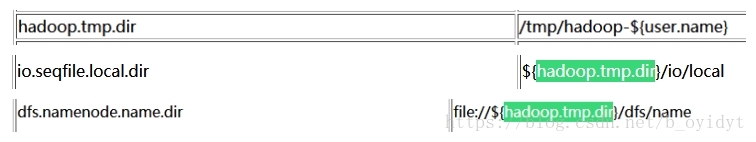

浏览默认配置可见,大所述路径都是在hadoop.tmp.dir的子路径下,故本人的路径只更改了hadoop.tmp.dir一个.core-site.xml内容如下:

<?xml version="1.0" encoding="UTF-8"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://data01:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/export/data/hddata</value>

</property>

</configuration>site中配置选项优先级>Default中的,如果有配置的话 就会覆盖默认的配置选项

3.使用一段时间后的hadoop格式化

我遇到的问题:

hadoop 启动后进到安全模式了

然后单节点启动时,1虚拟机是好的,2.3虚拟机上的datanode启动后有进程,但是不加blocks。

无法解决所以就决定格式化。

(1) 找到data和name配置的dir路径,找到 core-site.xml 找到dir路径

(2) 再到dir路径下删除Hadoop的临时文件路径

(3) 清空hadoop路径下的logs文件夹

(4) 重新执行命令:hadoop namenode -format

参考文章:https://my.oschina.net/HIJAY/blog/220816

注: 由于格式化会清空数据 , 在启动HIVE仓库前 ,需将之前mysql中的元数据库hive删除