版权声明:有问题的请留言 喜欢的请给个赞 --------------------------------不定时会更新,因为学习,所以快乐,因为分享,所以便捷!转载请标注出处,哈哈! https://blog.csdn.net/Appleyk/article/details/81871303

Linux查看端口占用情况

netstat -tunlp |grep 8000

Hadoop环境启动顺序:

注:上来一定要关闭防火墙:

service iptables stop

1、启动Hadoop(HDFS、ResourceManager、Yarn、MapReduce...)

start-all.sh

验证HDFS是否启动成功(打开地址,访问正常即可):http://192.168.142.144:50070

2、启动Zookeeper集群

三台机子均启动: zkServer.sh start

3、验证Zookeeper集群是否启动成功

zkServer.sh status

4、启动HBase集群(HBase的服务需要ZooKeeper来发现,因此必须先启动ZooKeeper集群)

start-hbase.sh

如果启动失败(HBase各个服务均启动,看似没问题,但是无法执行shell 命令),查看日志

[m1:16000.activeMasterManager] util.FSUtils: Waiting for dfs to exit safe mode...

如果出现上述异常,则强制关闭Hadoop HDFS的安全模式

(Hadoop在刚启动的时候,是处在安全模式造成的,如果一直都是出于安全模式,则可以手动进行关闭)

Hadoop退出安全模式(启动hdfs的时候会进入安全模式,检查各个datanode的情况,这个时候,任何文件操作都不被允许)

hadoop dfsadmin -safemode leave

然后关闭hbase

stop-hbase.sh

关闭成功后,重新启动即可

start-hbase.sh

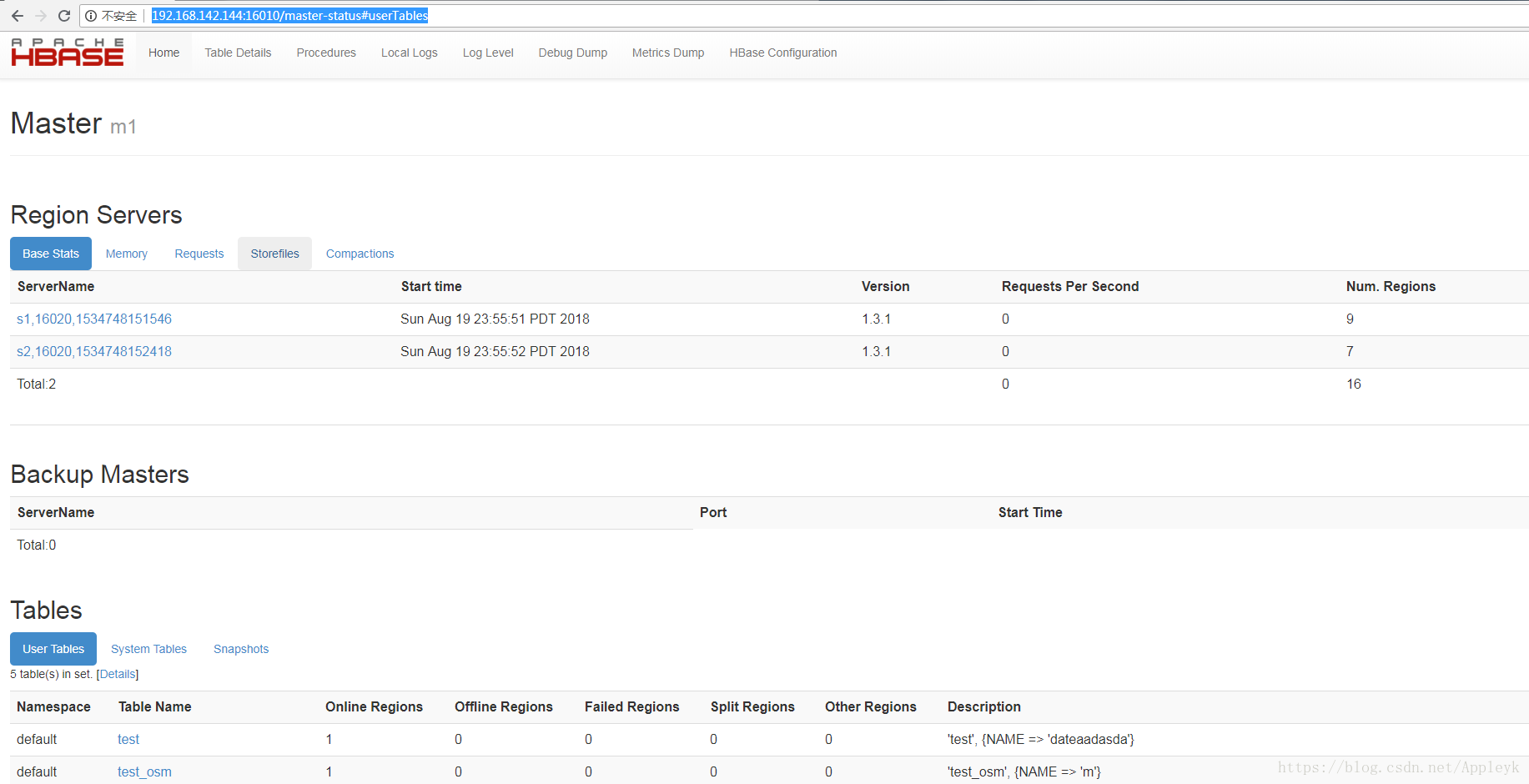

5、hbase验证

A:浏览器访问端口16010

B:shell方式连接hbase