参考知乎:https://www.zhihu.com/question/52398145

基本概念:

损失函数:计算的是一个样本的误差

代价函数:是整个训练集上所有样本误差的平均

目标函数:代价函数 + 正则化项

原理:

首先给出结论:损失函数和代价函数是同一个东西,目标函数是一个与他们相关但更广的概念,对于目标函数来说在有约束条件下的最小化就是损失函数(loss function)。

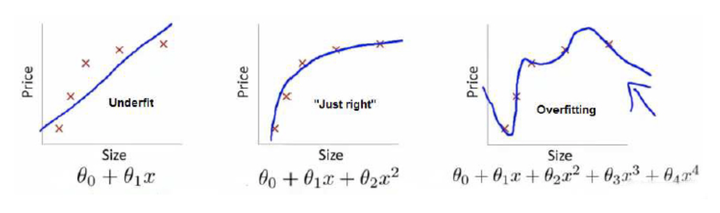

举个例子解释一下:(图片来自Andrew Ng Machine Learning公开课视频)

上面三个图的函数依次为 ,

,

。我们是想用这三个函数分别来拟合Price,Price的真实值记为

。

我们给定 ,这三个函数都会输出一个

,这个输出的

与真实值

可能是相同的,也可能是不同的,为了表示我们拟合的好坏,我们就用一个函数来度量拟合的程度,比如:

,这个函数就称为损失函数(loss function),或者叫代价函数(cost function)。损失函数越小,就代表模型拟合的越好。

那是不是我们的目标就只是让loss function越小越好呢?还不是。

这个时候还有一个概念叫风险函数(risk function)。风险函数是损失函数的期望,这是由于我们输入输出的 遵循一个联合分布,但是这个联合分布是未知的,所以无法计算。但是我们是有历史数据的,就是我们的训练集,

关于训练集的平均损失称作经验风险(empirical risk),即

,所以我们的目标就是最小化

,称为经验风险最小化。

到这里完了吗?还没有。

如果到这一步就完了的话,那我们看上面的图,那肯定是最右面的 的经验风险函数最小了,因为它对历史的数据拟合的最好嘛。但是我们从图上来看

肯定不是最好的,因为它过度学习历史数据,导致它在真正预测时效果会很不好,这种情况称为过拟合(over-fitting)。

为什么会造成这种结果?大白话说就是它的函数太复杂了,都有四次方了,这就引出了下面的概念,我们不仅要让经验风险最小化,还要让结构风险最小化。这个时候就定义了一个函数 ,这个函数专门用来度量模型的复杂度,在机器学习中也叫正则化(regularization)。常用的有

,

范数。

到这一步我们就可以说我们最终的优化函数是: ,即最优化经验风险和结构风险,而这个函数就被称为目标函数。

结合上面的例子来分析:最左面的 结构风险最小(模型结构最简单),但是经验风险最大(对历史数据拟合的最差);最右面的

经验风险最小(对历史数据拟合的最好),但是结构风险最大(模型结构最复杂);而

达到了二者的良好平衡,最适合用来预测未知数据集。

以上的理解基于Coursera上Andrew Ng的公开课和李航的《统计学习方法》,如有理解错误,欢迎大家指正。

- 前言

- 交叉熵损失函数

- 交叉熵损失函数的求导

前言

说明:本文只讨论Logistic回归的交叉熵,对Softmax回归的交叉熵类似。

首先,我们二话不说,先放出交叉熵的公式:

以及 J(θ)对J(θ)对 参数 θθ 的偏导数(用于诸如梯度下降法等优化算法的参数更新),如下:

但是在大多论文或数教程中,也就是直接给出了上面两个公式,而未给出推导过程,而且这一过程并不是一两步就可以得到的,这就给初学者造成了一定的困惑,所以我特意在此详细介绍了它的推导过程,跟大家分享。因水平有限,如有错误,欢迎指正。

交叉熵损失函数

我们一共有m组已知样本,(x(i),y(i))(x(i),y(i))表示第 ii 组数据及其对应的类别标记。其中x(i)=(1,x(i)1,x(i)2,...,x(i)p)Tx(i)=(1,x1(i),x2(i),...,xp(i))T为p+1维向量(考虑偏置项),y(i)y(i)则为表示类别的一个数:

- logistic回归(是非问题)中,y(i)y(i)取0或者1;

- softmax回归(多分类问题)中,y(i)y(i)取1,2…k中的一个表示类别标号的一个数(假设共有k类)。

这里,只讨论logistic回归,输入样本数据x(i)=(1,x(i)1,x(i)2,...,x(i)p)Tx(i)=(1,x1(i),x2(i),...,xp(i))T,模型的参数为θ=(θ0,θ1,θ2,...,θp)Tθ=(θ0,θ1,θ2,...,θp)T,因此有

假设函数(hypothesis function)定义为:

因为Logistic回归问题就是0/1的二分类问题,可以有

现在,我们不考虑“熵”的概念,根据下面的说明,从简单直观角度理解,就可以得到我们想要的损失函数:我们将概率取对数,其单调性不变,有

那么对于第 ii 组样本,假设函数表征正确的组合对数概率为:

其中, I{y(i)=1}I{y(i)=1} 和 I{y(i)=0}I{y(i)=0} 为示性函数(indicative function),简单理解为{ }内条件成立时,取1,否则取0,这里不赘言。

那么对于一共 mm 组样本,我们就可以得到模型对于整体训练样本的表现能力:

由以上表征正确的概率含义可知,我们希望其值越大,模型对数据的表达能力越好。而我们在参数更新或衡量模型优劣时是需要一个能充分反映模型表现误差的损失函数(Loss function)或者代价函数(Cost function)的,而且我们希望损失函数越小越好。由这两个矛盾,那么我们不妨领代价函数为上述组合对数概率的相反数:

上式即为大名鼎鼎的交叉熵损失函数。(说明:如果熟悉“ 信息熵 “的概念 E[−logpi]=−∑mi=1pilogpiE[−logpi]=−∑i=1mpilogpi ,那么可以有助理解叉熵损失函数)

交叉熵损失函数的求导

这步需要用到一些简单的对数运算公式,这里先以编号形式给出,下面推导过程中使用特意说明时都会在该步骤下脚标标出相应的公式编号,以保证推导的连贯性。

① logab=loga−logb logab=loga−logb

② loga+logb=log(ab) loga+logb=log(ab)

③ a=logea a=logea

另外,值得一提的是在这里涉及的求导均为矩阵、向量的导数(矩阵微商),这里有一篇教程总结得精简又全面,非常棒,推荐给需要的同学。

下面开始推导:

交叉熵损失函数为:

其中,

由此,得到

这次再计算 J(θ)J(θ) 对第 jj 个参数分量 θjθj 求偏导:

这就是交叉熵对参数的导数:

转载请注明出处:http://blog.csdn.net/jasonzzj/article/details/52017438