作者:翁松秀

用Eclipse创建一个spark程序三步曲(Java版)

在动手写第一个spark程序之前,得具备以下条件

前提条件:

1. 已经安装有Maven插件的Eclipse,最新版的Eclipse Photon自带Maven插件。

2. 已经安装Maven项目管理工具,要安装的猛戳【Windows搭建Maven环境】

3. 已经搭建spark的开发环境,要搭建的猛戳【Windows搭建spark开发环境】

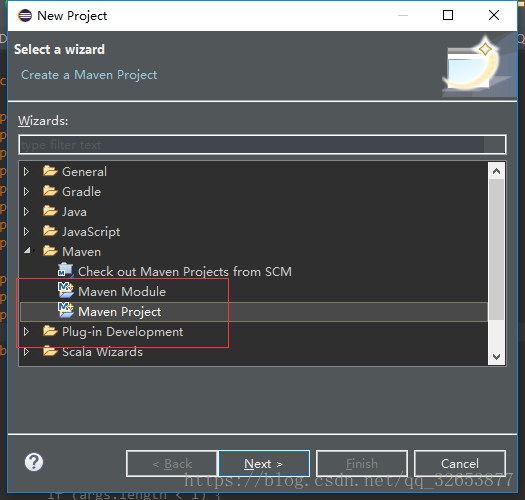

Step1:创建Maven工程

【File】→【new】→【project…】,找到Maven节点,选择Maven Project

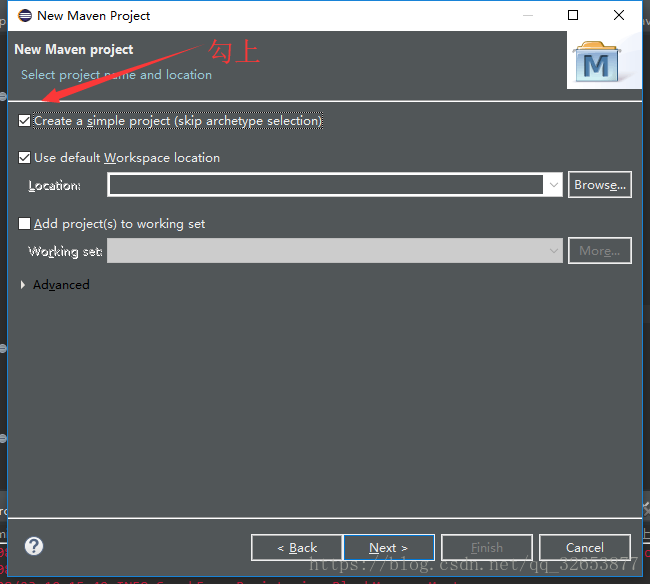

Next之后把”Create a simple project(skip archetype selection)“勾上,先创建一个简单的工程,不用管那些花里胡哨的,跑起来再说。

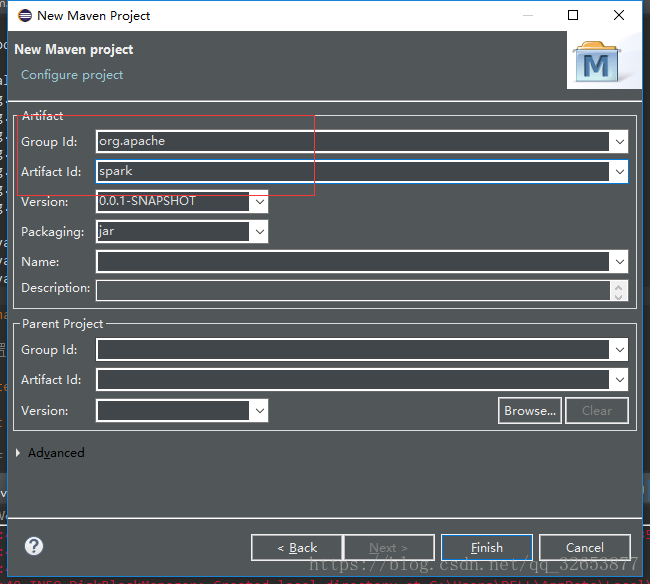

勾上之后Next,这里需要填两个Id,Group Id和Artifact Id,Group Id就是(域+公司),比如说Apache的Spark,Group Id是org.apache,Artifact Id是spark,这个是为了在maven中唯一标识一个Artifact采用的命名,不过你大可随便填,我这里Group Id就填org.apache,Artifact Id填spark。

Step2:添加maven依赖

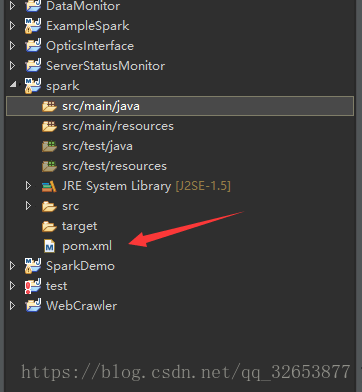

Finish之后我们的Maven工程就建好了,打开工程目录下的pom.xml配置文件,加载spark程序所需要的一些依赖。

你的pom.xml文件应该是这样的,可能版本和Group Id和Artifact Id不同。

<project xmlns="http://maven.apache.org/POM/4.0.0" xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance" xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<modelVersion>4.0.0</modelVersion>

<groupId>org.apache</groupId>

<artifactId>spark</artifactId>

<version>0.0.1-SNAPSHOT</version>

</projec>从下面的配置文件中复制< version > < /version >以下的部分放到你的pom.xml< version > < /version >下面,或者复制整个文件,到时候自己改一下

< modelVersion >,< groupId >,< artifactId >,< version >

<?xml version="1.0" encoding="UTF-8"?>

<project xmlns="http://maven.apache.org/POM/4.0.0"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<modelVersion>4.0.0</modelVersion>

<groupId>org.apache</groupId>

<artifactId>spark</artifactId>

<version>1.0-SNAPSHOT</version>

<!-- <localRepository>E:/mavenRepo</localRepository> -->

<repositories>

<repository>

<id>central</id>

<name>Central Repository</name>

<url>http://maven.aliyun.com/nexus/content/repositories/central</url>

<layout>default</layout>

<snapshots>

<enabled>false</enabled>

</snapshots>

</repository>

</repositories>

<build>

<plugins>

<plugin>

<artifactId>maven-assembly-plugin</artifactId>

<version>2.2</version>

<configuration>

<archive>

<manifest>

<!-- 我运行这个jar所运行的主类 -->

<mainClass>code.demo.spark.JavaWordCount</mainClass>

</manifest>

</archive>

<descriptorRefs>

<descriptorRef>

<!-- 必须是这样写 -->

jar-with-dependencies

</descriptorRef>

</descriptorRefs>

</configuration>

</plugin>

</plugins>

</build>

<properties>

<project.build.sourceEncoding>UTF-8</project.build.sourceEncoding>

<spark.version>1.6.0</spark.version>

<scala.version>2.10</scala.version>

<hadoop.version>2.6.0</hadoop.version>

</properties>

<dependencies>

<dependency>

<groupId>org.apache.spark</groupId>

<artifactId>spark-core_${scala.version}</artifactId>

<version>${spark.version}</version>

</dependency>

<dependency>

<groupId>org.apache.spark</groupId>

<artifactId>spark-sql_${scala.version}</artifactId>

<version>${spark.version}</version>

</dependency>

<dependency>

<groupId>org.apache.spark</groupId>

<artifactId>spark-hive_${scala.version}</artifactId>

<version>${spark.version}</version>

</dependency>

<dependency>

<groupId>org.apache.spark</groupId>

<artifactId>spark-streaming_${scala.version}</artifactId>

<version>${spark.version}</version>

</dependency>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-client</artifactId>

<version>2.7.0</version>

</dependency>

<dependency>

<groupId>junit</groupId>

<artifactId>junit</artifactId>

<version>4.12</version>

</dependency>

<dependency>

<groupId>org.slf4j</groupId>

<artifactId>slf4j-api</artifactId>

<version>1.6.6</version>

</dependency>

<dependency>

<groupId>org.slf4j</groupId>

<artifactId>slf4j-log4j12</artifactId>

<version>1.6.6</version>

</dependency>

<dependency>

<groupId>log4j</groupId>

<artifactId>log4j</artifactId>

<version>1.2.16</version>

</dependency>

<dependency>

<groupId>dom4j</groupId>

<artifactId>dom4j</artifactId>

<version>1.6.1</version>

</dependency>

<dependency>

<groupId>jaxen</groupId>

<artifactId>jaxen</artifactId>

<version>1.1.6</version>

</dependency>

<dependency>

<groupId>args4j</groupId>

<artifactId>args4j</artifactId>

<version>2.33</version>

</dependency>

<dependency>

<groupId>jline</groupId>

<artifactId>jline</artifactId>

<version>2.14.5</version>

</dependency>

</dependencies>

<artifactId>ExampleSpark</artifactId>

</project>编辑完成之后保存,eclipse会自动加载所需要的依赖,时间可能有点久,取决于你的网速和maven的镜像,如果maven是国内的阿里云可能会比较快,maven搭建阿里云镜像猛戳【Maven搭建阿里云镜像】

Step3:编写程序

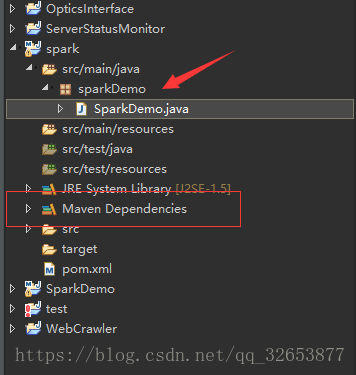

加载完之后会在工程目录下看到一个依赖Maven Dependencies

在src/main/java下创建sparkDemo包和SparkDemo.java,复制粘贴下面的代码,这是官网计算π的example,为了简单起见我把迭代参数去掉了,默认迭代10次。程序里也设置运行的master为local,所以直接在本地的eclipse上运行即可。

package sparkDemo;

import org.apache.spark.SparkConf;

import org.apache.spark.api.java.JavaRDD;

import org.apache.spark.api.java.JavaSparkContext;

import org.apache.spark.api.java.function.Function;

import org.apache.spark.api.java.function.Function2;

import java.util.ArrayList;

import java.util.List;

public final class SparkDemo {

public static void main(String[] args) throws Exception {

SparkConf sparkConf = new SparkConf().setAppName("JavaSparkPi").setMaster("local");

JavaSparkContext jsc = new JavaSparkContext(sparkConf);

long start = System.currentTimeMillis();

int slices = 10;

int n = 100000 * slices;

List<Integer> l = new ArrayList<Integer>(n);

for (int i = 0; i < n; i++) {

l.add(i);

}

/*

JavaSparkContext的parallelize:将一个集合变成一个RDD

- 第一个参数一是一个 Seq集合

- 第二个参数是分区数

- 返回的是RDD[T]

*/

JavaRDD<Integer> dataSet = jsc.parallelize(l, slices);

int count = dataSet.map(new Function<Integer, Integer>() {

private static final long serialVersionUID = 1L;

public Integer call(Integer integer) {

double x = Math.random() * 2 - 1;

double y = Math.random() * 2 - 1;

return (x * x + y * y < 1) ? 1 : 0;

}

}).reduce(new Function2<Integer, Integer, Integer>() {

private static final long serialVersionUID = 1L;

public Integer call(Integer integer, Integer integer2) {

return integer + integer2;

}

});

long end = System.currentTimeMillis();

System.out.println("Pi is roughly " + 4.0 * count / n+",use : "+(end-start)+"ms");

jsc.stop();

jsc.close();

}

}

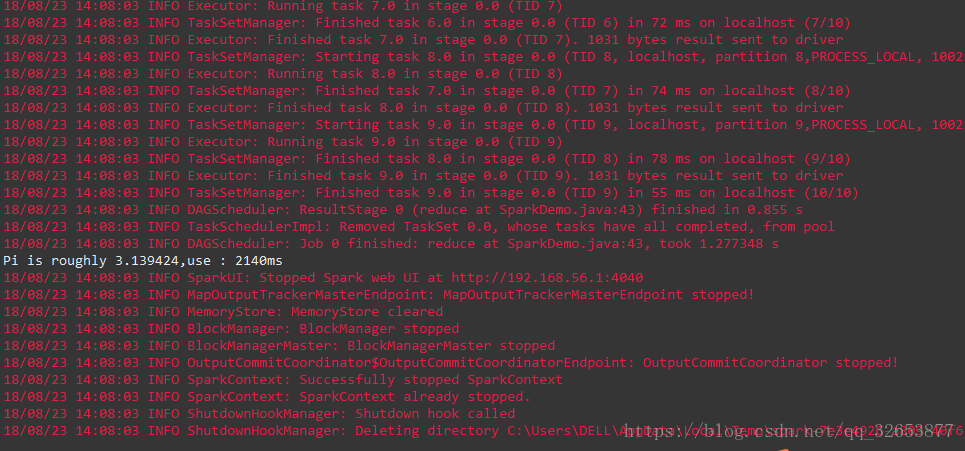

运行结果:

Welcome to Spark!