1.安装JAVA

安装java就不详细说了,直接下载jdk,安装。现在mac新版本好像都不用专门给java和python配置环境变量就直接能用。

终端输入

java -version

如果显示出java版本号就ok了。如果没有,使用命令vim ~/.bash_profile 修改一下环境变量。

2.下载Hadoop

网址:https://hadoop.apache.org/releases.html

根据想下载的版本,选一个,下载解压。

3.下载的同时,修改mac的配置。

系统偏好设置-->选择共享 -->打开远程登录勾选上

-->打开远程登录勾选上

4.配置Hadoop环境变量

Hadoop的环境变量还是要自己配置的。

使用命令vim ~/.bash_profile

修改环境变量:

# 要填自己下载的Hadoop的解压位置的地址

export HADOOP_PATH=/Users/***/Documents/tools/hadoop-2.9.2

# 在PATH后面追加hadoop环境变量

export PATH=$PATH:${HADOOP_PATH}/bin修改保存完成后,使用命令:source ~/.bash_profile 让环境变量立刻生效。

执行命令hadoop version 可以查看到hadoop的版本信息,则说明Hadoop路径配置好了

5.修改Hadoop的配置文件

进入Haddop的安装目录下,cd到它下两个层级/etc/hadoop下。

我的路径是: /Users/kimtian/Documents/tools/hadoop-2.9.2/etc/hadoop 可以参考一下。

(1)修改hadoop-env.sh文件

找到原有的 export JAVA_HOME位置,可以直接搜索。将其修改,并在下面增加 HADOOP 配置。

我的配置如下,要修改成自己的java路径和hadoop路径:

export JAVA_HOME=/Library/Java/JavaVirtualMachines/jdk1.8.0_161.jdk/Contents/Home

export HADOOP_CONF_DIR=/Users/kimtian/Documents/tools/hadoop-2.9.2/etc/hadoop(2)修改core-site.xml文件

在<configuration></configuration>中间加入如下代码块(第一个property必须加,第二个可加可不加):

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

<!--这段可以不加,加的话要把value改成自己本地一个文件夹,指定Hadoop文件存放的地址-->

<property>

<name>hadoop.tmp.dir</name>

<value>/Users/kimtian/Documents/hadoopWorkspace</value>

</property>(3)修改mapred-site.xml文件

这个可以看到有文件夹下只有文件 mapred-site.xml.template

使用命令 mv mapred-site.xml.template mapred-site.xml 将其名称修改成mapred-site.xml文件后。

在<configuration></configuration>中间加入如下代码块:

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>(4)修改 yarn-site.xml 文件

在<configuration></configuration>中间加入如下代码块:

注意yarn.resourcemanager.webapp.address配置的端口号是8088,否则后面输入http://localhost:8088/无法访问此网站就是问题出现在这。

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.resourcemanager.address</name>

<value>localhost:8032</value>

</property>

<property>

<name>yarn.resourcemanager.scheduler.address</name>

<value>localhost:8030</value>

</property>

<property>

<name>yarn.resourcemanager.resource-tracker.address</name>

<value>localhost:8031</value>

</property>

<property>

<name>yarn.resourcemanager.admin.address</name>

<value>localhost:8033</value>

</property>

<property>

<name>yarn.resourcemanager.webapp.address</name>

<value>localhost:8088</value>

</property>(5)修改 hdfs-site.xml 文件

在<configuration></configuration>中间加入如下代码块:

就加这些就行了,如果加错了其他配置在接下来安装HDFS的时候报错。

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.permissions</name>

<value>false</value>

</property>6.安装HDFS

使用命令:/Users/kimtian/Documents/tools/hadoop-2.9.2/bin/hadoop namenode -format

(前面部分为安装hadoop的位置/bin/hadoop)

我在最开始尝试的时候报错: java.io.IOException: Cannot create directory /home/hadoop/cdh4/hadoop/dfs/name/current

解决办法一:使用命令sudo chmod 777 /home/ 修改这个路径的权限,没能解决问题

![]()

解决办法二:hdfs-site.xml 配置文件有问题,不要加多余的指定配置,上面有提到,成功解决。

如下图所示,没有报错,则为安装成功:

7.启动HDFS

进入到hadoop的sbin目录下,使用命令./start-dfs.sh执行可执行文件启动HDFS。

整个过程,输入了三次mac的密码,还输入了一次yes。

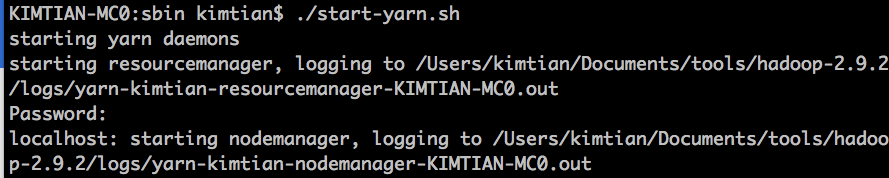

8.启动yarn

同样进入到hadoop的sbin目录下,使用命令./start-yarn.sh执行可执行文件启动yarn。

整个过程输入了一次密码。

9. 确认Hadoop成功启动

(1)在终端输入jps命令,显示如下则为成功。

(2)在浏览器输入网址http://localhost:50070

显示页面:

(3)在浏览器输入网址:http://localhost:8088/

显示页面:

10.停止Hadoop命令

同启动Hadoop一样进入到hadoop的sbin目录下(例子:我的路径是/Users/kimtian/Documents/tools/hadoop-2.9.2/sbin)。

执行下面两条命令:

./stop-yarn.sh

./stop-dfs.sh