一.开源数据库中间件MyCat

1.简介:

如今随着互联网的发展,数据的量级也是成指数的增长,从 GB 到 TB 到 PB。对数据的各种操作也是愈加的困难,传统的关系性数据库已经无法满足快速查询与插入数据的需求。这个时候 NoSQL 的出现暂时解决了这一危机。它通过降低数据的安全性,减少对事务的支持,减少对复杂查询的支持,来获取性能上的提升。

但是,在有些场合 NoSQL 一些折衷是无法满足使用场景的,就比如有些使用场景是绝对要有事务与安全指标的。这个时候 NoSQL 肯定是无法满足的,所以还是需要使用关系性数据库。如果使用关系型数据库解决海量存储的问题呢?此时就需要做数据库集群,为了提高查询性能将一个数据库的数据分散到不同的数据库中存储。

2.背景

Mycat 背后是阿里曾经开源的知名产品——Cobar。Cobar 的核心功能和优势是 MySQL数据库分片,此产品曾经广为流传,据说最早的发起者对 Mysql 很精通,后来从阿里跳槽了,阿里随后开源的 Cobar,并维持到 2013 年年初,然后,就没有然后了。Cobar 的思路和实现路径的确不错。基于 Java 开发的,实现了 MySQL 公开的二进制传输协议,巧妙地将自己伪装成一个 MySQL Server,目前市面上绝大多数 MySQL 客户端工具和应用都能兼容。比自己实现一个新的数据库协议要明智的多,因为生态环境在哪里摆着。Mycat 是基于 cobar 演变而来,对 cobar 的代码进行了彻底的重构,使用 NIO 重构了网络模块,并且优化了 Buffer 内核,增强了聚合,Join 等基本特性,同时兼容绝大多数数据库成为通用的数据库中间件。简单的说,MyCAT 就是:一个新颖的数据库中间件产品支持 mysql 集群,或者mariadb cluster,提供高可用性数据分片集群。你可以像使用 mysql 一样使用 mycat。对于开发人员来说根本感觉不到 mycat 的存在。

二.myCat安装与配置

注意:我们如果用contos系统,则在7的系统上使用,jdk 1.7以上 mysql 5.5以上版本

(1)将 MySQL 的服务端和客户端安装包(RPM)上传到服务器

(2)查询之前是否安装过 MySQL

rpm -qa|grep -i mysql

(3)卸载旧版本 MySQL

rpm -e --nodeps 软件名称

(4)安装服务端

rpm -ivh MySQL-server-5.5.49-1.linux2.6.i386.rpm

(5)安装客户端

rpm -ivh MySQL-client-5.5.49-1.linux2.6.i386.rpm

(6)启动 MySQL 服务

service mysql start

(7)登录 MySQL

mysql -u root

(8)设置远程登录权限

GRANT ALL PRIVILEGES ON *.* TO 'root'@'%'IDENTIFIED BY '123456' WITH GRANT OPTION;

在本地 SQLyog 连接远程 MySQL 进行测试,ip是我们linux的地址

安装:

-

我们找到要上传到linux中的有mycat安装包。将该安装包上传到Linux服务器

-

解压mycat,命令:tar -zxvf Mycat-server-1.4-release-20151019230038-linux.tar.gz,并放在/usr/local目录中 命令:mv mycat/ /usr/local/

-

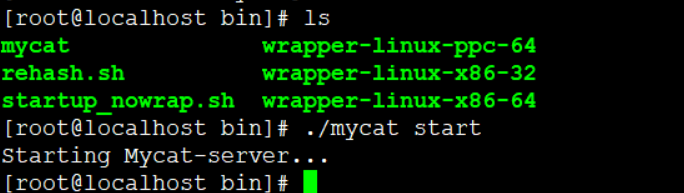

进入mycat 目录的bin 目录,启动mycat 命令:./mycat start

-

mycat 支持的命令{ console | start | stop | restart | status | dump }

Mycat 的默认端口号为:8066

三.MyCat 分片-海量数据存储解决方案

1.什么是分片

简单来说,就是指通过某种特定的条件,将我们存放在同一个数据库中的数据分散存放到多个数据库(主机)上面,以达到分散单台设备负载的效果。

可以分为两种切分模式:

(1)一种是按照不同的表(或者 Schema)来切分到不同的数据库(主机)之上,这种

切分可以称之为数据的垂直(纵向)切分

(2)另外一种则是根据表中的数据的逻辑关系,将同一个表中的数据按照某种条件拆分到多台数据库(主机)上面,这种切分称之为数据的水平(横向)切分。

mycat的分片策略:

分片相关的概念

逻辑库(schema) :

前面一节讲了数据库中间件,通常对实际应用来说,并不需要知道中间件的存在,业务开发人员只需要知道数据库的概念,所以数据库中间件可以被看做是一个或多个数据库集群构成的逻辑库。

逻辑表(table ):

既然有逻辑库,那么就会有逻辑表,分布式数据库中,对应用来说,读写数据的表就是逻辑表。逻辑表,可以是数据切分后,分布在一个或多个分片库中,也可以不做数据切分,不分片,只有一个表构成。

分片表:是指那些原有的很大数据的表,需要切分到多个数据库的表,这样,每个分片都有一部分数据,所有分片构成了完整的数据。 总而言之就是需要进行分片的表。

非分片表:一个数据库中并不是所有的表都很大,某些表是可以不用进行切分的,非分片是相对分片表来说的,就是那些不需要进行数据切分的表。

分片节点(dataNode)数据切分后,一个大表被分到不同的分片数据库上面,每个表分片所在的数据库就是分片(dataNode)。

节点主机(dataHost)数据切分后,每个分片节点(dataNode)不一定都会独占一台机器,同一机器上面可以有多

个分片数据库,这样一个或多个分片节点(dataNode)所在的机器就是节点主机(dataHost),为了规避单节点主机并发数限制,尽量将读写压力高的分片节点(dataNode)均衡的放在不同的节点主机(dataHost)。

分片规则(rule)前面讲了数据切分,一个大表被分成若干个分片表,就需要一定的规则,这样按照某种业务规则把数据分到某个分片的规则就是分片规则,数据切分选择合适的分片规则非常重要,将极大的避免后续数据处理的难度。

mycat的核心配置文件:(非常重要)

首先为了,便于我们配置文件,我们将,通过editplus远程连接linux来进行编辑:

点击确定后,我们选择sftp 模式 还有填写22端口号

逻辑库的配置:

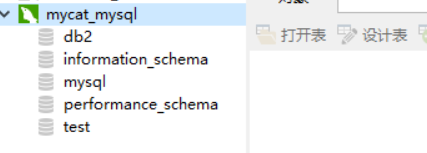

同时在我们刚刚连接的数据库上,创建三个数据库,db1 db2 db3

注意:还有个心跳的配置,我们目的是,检测主机是否正常运行,如果正常可以让,从机休息

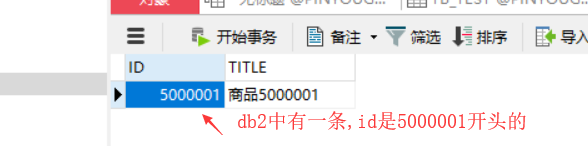

Table 标签定义了 MyCat 中的逻辑表 rule 用于指定分片规则,auto-sharding-long 的分片规

则是按 ID 值的范围进行分片 1-5000000 为第 1 片 5000001-10000000 为第 2 片

dataNode 标签定义了 MyCat 中的数据节点,也就是我们通常说所的数据分片。

dataHost标签在mycat逻辑库中也是作为最底层的标签存在,直接定义了具体的数据库实例、

读写分离配置和心跳语句。

在服务器上创建 3 个数据库,分别是 db1 db2 db3

配置service.xml:

server.xml 几乎保存了所有 mycat 需要的系统配置信息。最常用的是在此配置用户名、密码

及权限。在 system 中添加 UTF-8 字符集设置,否则存储中文会出现问号

![]()

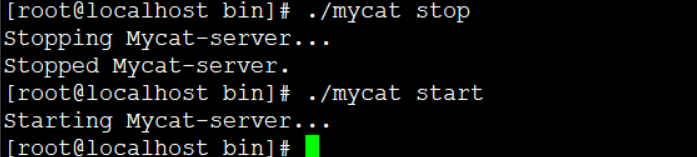

然后从新启动mycat

我们进行测试:

-

基于mysql客户端连接工具连接mycat。注意:连接端口默认是8066,而不是3306

-

在mycat中执行如下建表语句 现象:mycat中建表后,与之对应的mysql数据库db1、db2、db3自动也建表

在mycat中插入三条测试语句:必须指定列名,不能缺省

CREATE TABLE tb_test (

id BIGINT(20) NOT NULL,

title VARCHAR(100) NOT NULL ,

PRIMARY KEY (id)

) ENGINE=INNODB DEFAULT CHARSET=utf8INSERT INTO TB_TEST(ID,TITLE) VALUES(1,'商品1');

INSERT INTO TB_TEST(ID,TITLE) VALUES(2,'商品2');

INSERT INTO TB_TEST(ID,TITLE) VALUES(3,'商品3');

INSERT INTO TB_TEST(ID,TITLE) VALUES(5000001,'商品5000001');

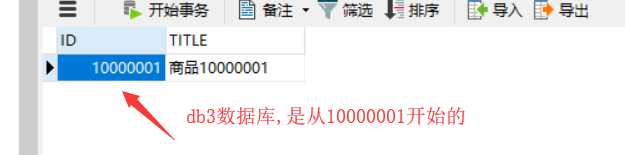

INSERT INTO TB_TEST(ID,TITLE) VALUES(10000001,'商品10000001');我们先插入前三条:

我们发现数据库中只有db1中有,其他两个没有

我们插入后面两条数据

那么我就可以知道,这个是通过分片规则进行分片的,

第一种:auto-shading-long为主键分片规则

适用场景:id值从小开始增加,主键自增

第二种分片规则:一致性哈希

当我们需要将数据平均分在几个分区中,需要使用一致性 hash 规则我们找到 function 的 name 为 murmur 的定义,将 count 属性改为 3,因为我要将数据分成3 片

首先我们配置一个分片规则,指定为id为order_id,我们根据我们order表进行测试,分片的效果

rule.xml:

<function name="murmur"

class="org.opencloudb.route.function.PartitionByMurmurHash">

<property name="seed">0</property><!-- 默认是 0 -->

<property name="count">3</property><!-- 要分片的数据库节点数量,必须指定,否则没法分片

-->

<property name="virtualBucketTimes">160</property><!-- 一个实际的数据库节点被映射为这么

多虚拟节点,默认是 160 倍,也就是虚拟节点数是物理节点数的 160 倍 -->

<!-- <property name="weightMapFile">weightMapFile</property> 节点的权重,没有指定权重的节

点默认是 1。以 properties 文件的格式填写,以从 0 开始到 count-1 的整数值也就是节点索引为 key,以节

点权重值为值。所有权重值必须是正整数,否则以 1 代替 -->

<!-- <property name="bucketMapPath">/etc/mycat/bucketMapPath</property>

用于测试时观察各物理节点与虚拟节点的分布情况,如果指定了这个属性,会把虚拟节点

的 murmur hash 值与物理节点的映射按行输出到这个文件,没有默认值,如果不指定,就不会输出任何东

西 -->

</function>在schema.xml:中我们配置一致性哈希的分片规则:

我重新创建一个tb_order表进行测试一致性哈希的分片规则

CREATE TABLE tb_order (

order_id BIGINT(20) NOT NULL,

title VARCHAR(100) NOT NULL ,

PRIMARY KEY (order_id)

) ENGINE=INNODB DEFAULT CHARSET=utf8 插入数据:

INSERT INTO TB_ORDER(order_id,TITLE) VALUES(1,'商品1');

INSERT INTO TB_ORDER(order_id,TITLE) VALUES(2,'商品2');

INSERT INTO TB_ORDER(order_id,TITLE) VALUES(3,'商品3');

INSERT INTO TB_ORDER(order_id,TITLE) VALUES(4,'商品4');

INSERT INTO TB_ORDER(order_id,TITLE) VALUES(5,'商品5');

INSERT INTO TB_ORDER(order_id,TITLE) VALUES(6,'商品6');

INSERT INTO TB_ORDER(order_id,TITLE) VALUES(7,'商品7');

INSERT INTO TB_ORDER(order_id,TITLE) VALUES(8,'商品8');

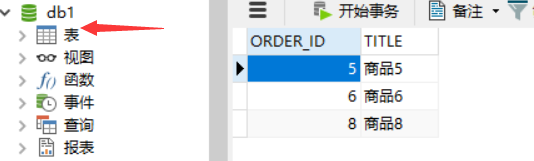

INSERT INTO TB_ORDER(order_id,TITLE) VALUES(9,'商品9');我们查看数据库,发现,三个表的数据几乎一致的分配到每个数据库中,根据order_id在配置文件关联一致性哈希的配置

下一章我们继续mycat的读写分离的原理以及详细配置