我们生活在一个数据爆炸的时代,数据的作用被无限放大。美国管理学家、统计学家爱德华·戴明有一句名言:除了上帝,任何人都必须用数据说话。然而,这也带来了一个问题:数据也许是客观的、科学的,但是分析和处理数据的方法,却被描述成了耸人听闻、华而不实、迷惑不清且过分简单的东西。

在报道社会和经济趋势、进行科学研究时,要用到大量数据,此时方法和术语就不可或缺,但是如果作者不能诚实地报道,甚至根本没有理解这些研究方法,读者也就无法明白作者所说的内容,那么这些分析结果就只能是无稽之谈。

在这里相信有许多想要学习大数据的同学,大家可以+下大数据学习裙:957205962,即可免费领取套系统的大数据学习教程

除此以外,同一现象,分析方法不同,导致结论不同的情况也较为常见。因此,关于数据会不会说谎的争论一直未曾停歇,如果在百度搜索“数据会说谎”或“数据不会说谎”,都可以轻易获得数十万条检索记录。然而,谈论到数据产生误导的原因,有研究者认为至少有三种类型:一是读数据的人缺乏专业知识;二是分析数据的人采用了不合理的方法;三是数据不说谎,做数据的人也不想说谎,但是读数据的人只想读到自己想读到的数据。

数据量的影响

统计量

随着社会生活方式的巨大转变,目前研究者面对的问题已经从数据匮乏走向了另一个极端——数据量过大。在统计调查中,随着样本量的扩张,有时我们获得的结论可能仅具备统计学意义,却缺乏现实意义。下面我们以研究者基于样本均值来检验关于位置总体的假设统计,以t统计量为例(该问题也存在于其他统计量中,如z),t统计量的公式为 。从公式中可以看出,其他因素不变,n越大,t越大,随着样本量变大,将会影响t检验的统计学意义。

。从公式中可以看出,其他因素不变,n越大,t越大,随着样本量变大,将会影响t检验的统计学意义。

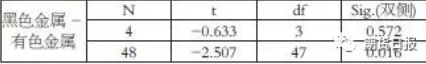

表为黑色金属和有色金属价格变化幅度独立样本t检验

表中选择了对黑色金属和有色金属的价格变化幅度进行t检验,仅仅是数据的多次重复就可以使得p值(Sig)在样本量扩大(4扩大到48)之后降低至0.05以下,达到了统计学上的显著性。如果只留存第二行数据,以此来说明问题,则会对结果产生一定程度的误导。

效果量

一般的统计检验方法是基于虚无假设的显著性检验进行的,但是这种方法只能告诉我们在假定某虚无假设为真的情况下,研究者所观察到的数据的概率大小,即p值,然后在p值基础上做出接受或拒绝虚无假设的二分决定。

基于上文的例子,p值也受到样本量的影响,可能导致统计检验结果没有意义。为了弥补不足,统计学中引入了效果量,效果量的优点在于没有单位,可以跨研究比较,效果量克服了非黑即白(接受或拒绝)二元选项的机械性,告诉我们两者之间的差异。不过,效果量本身的数值如果不从逻辑角度考虑,这个数字也许并没有意义,例如,量表的效度数值很高,但是测出的其实并不是研究者想要测量的变量,代表的是其他变量,那么这个“高效度”对于这个逻辑框架就是虚假的、无意义的。

另外,有的效果量指标也并不能完全克服样本量的影响,例如,η2(eta-squared)在方差分析中用于估计样本独立变量的效应大小,根据公式η2= SSeffect/SStotal,SStotal=∑X2-(∑X)2/N,可以看出,η2会随着自变量的变多而变小,无法准确体现一个自变量的效应。因此,SPSS数据分析中目前只给出ηp2,ηp2=SSeffect/(SSeffect+SSerror),不会随着自变量的变多而变小,但无论是η2还是ηp2,都是对效应量总体参数的有偏估计,高估了自变量的效应,而ω2是对作为总体参数的效应量的无偏点估计(ω2比η2和ηp2小)。此外,部分研究者在使用效果量标注时不严谨,容易出现计算、正文、图表中ηp2和η2混淆的情况。

表为ERP相关电位激活程度数据分析

上表中使用的是ηp2,如果使用η2,在Emotion×Electrode and Reward×Emotion×Electrode的情况下,N=532,将影响SStotal,进而使效应量进一步高估。

趋势的测量

在统计学中,测量集中趋势通常采用平均值、中数和众数,其中利用平均值测试集中趋势是最常见的。

表为平均值测量集中趋势带来的问题示例

如表所示,在实验3的外显任务中,平均值为0.7,似乎指标偏移不明显(靠近零),但是请注意括号中标注了所有分类(all categorization),再看右栏,将目标分类(target categorization)单独拎出来之后,指标偏移度是-15.8(中位数也存在类似问题)。这是研究中非常容易遇到的数据分析误区,有时分析结果看似不显著甚至无意义,但这不是实验设置的问题,也不是原始数据的问题,而是我们在分析的时候将全部数据放在一起平均,内在的趋势被相互抵消了。若止步于此,则无异于宝山空回。

另外,平均数会受到极值的影响,在此种情况下,平均数失去了代表性,实质是一种“被平均”,此时可能采用中位数较为客观,但是平均数和中位数都不能用来描述称名数据。从这个意义上看,众数可能是集中趋势描述的最佳代表,但是可能需要面对多峰问题,原因在于实验室研究的数据量较少,而现实层面的数据则是实验室数据的几何倍级,甚至可能没有穷尽,出现多峰的可能性较大。总之,在做数据分析的过程中,我们需要关注数据量、统计口径、分层,尽可能从多角度来思考,因为看似无趋势的指标,内在可能是暗流涌动,没有代表性的趋势测量不再具有指导意义,反而可能给决策者带来误导。

缺失的数据

在实验室的研究中,常常会出现未能取得所要收集的研究数据,这是由一个或多个被试在一个或多个研究变量上未出现反应所引起的。一般而言,缺失数据产生的原因主要有两种:一是测验设计,由于时间有限,导致被试没有机会作答完所有的项目;二是被试能力不足或缺乏动机,从而放弃对一些项目的作答。

传统的处理方法是列表删除(listwise delete)或对位删除(pairwise delete),这两种做法都有明显的缺陷,样本量会减少,还可能产生非正定的协方差矩阵。虽然数据归并(data imputation)采用均值或回归插补的方法,但是能适应缺失机制为完全随机缺失数据(missing completely at random,MCAR)的情况。此外,采用参数极大似然估计方法插补,可以进一步适应随机缺失数据(missing at random,MAR)缺失机制,特别是当插补方法为不确定性插补时(例如,贝叶斯回归插补),可以使得插补带有一定的随机性,从而使合并后的结果更精确。然而,上述所有的方法都不能适用于非随机缺失数据(missing not at random,MNAR)缺失。

研究者在收集数据的过程中,很可能因为某些原因产生数据的非随机缺失问题,从而使研究结果产生“幸存者偏差”。有时候,这种缺失的发生非常隐蔽。例如,第41次中国互联网络发展状况统计报告显示,2017年中国网民规模达到7.72亿人,而按照当年总人口数计算,中国互联网普及率只有55.8%,但是从年龄结构来看,2017年中国网民群体以40岁以下的人口为主,40岁以上的网民只占总网民数的23.6%,不到1.82亿人,而同年龄段的实际人口占总人口数的比例却接近五成。

除了年龄因素,收入、受教育程度、地域也对数据覆盖面有重要影响,特别是那些年龄较大、收入较低、学历不高、居住在农村等本已处于社会弱势方的群体,他们的意见没有被录入数据库,自然也无法参与后面的分析环节。因此,虽然这些互联网数据从数量上评价是当之无愧的“大”数据,但是借此做研究必然会带来不可忽视的“数字鸿沟”问题,意味着部分社会成员作为数据生产主体的缺场,其态度和行为信息无法在网络中获取。这种数据分析的结果,不仅是代表性低、准确性低的问题,而且可能造成社会公平的缺失,这值得我们每一个人深思。

数据的来源

在实证研究领域,数据的来源问题更加严重,因为很多数据来源受现实因素的制约,本身就是有偏的,容易产生“幸存者偏差”。举例来说,国家语言资源监测与研究中心发布了一组“2018年度中国媒体十大新词语”,其中“消费降级”登榜。在搜索引擎里输入查询,相关的内容高达9720000条,自媒体产出的相关文章也有近3979条,关于“升级”还是“降级”的问题争论不休。数据口径一般来源于国家统计局、科研单位调研、各大网络购物平台。下面我们以网络购物平台为例,说明数据来源问题。

首先,虚假数据问题,网络平台通过雇用“水军”等方式,人为篡改销售数量和好评度,甚至出现了许多专业“刷单”公司和“水军”公司,普通消费者也可能因为返利、优惠等原因加入其中,造成数据来源中存在大量虚假数据;其次,数据算法使得数据在生成过程中已经受到影响,从而对数据分析结果产生间接操纵,有学者指出,那些看似自然的互联网大数据,其实在生成过程中就已经掺杂进了大量的人为设计;最后,在“注意力经济”的环境下,大众媒介和部分精英群体(网红群体)同样也能够通过议程设置和框架建构,对受众的注意力分配施加明显的引导,从而产生数据引导,这些数据的取得本来就缺失了客观性。即便上述问题都解决,平台数据本身也是有偏的,因为使用不同的平台,受众本身不一定是同质的。

指标的选择

各学科的迅猛发展,为我们提供了很多可供选择的指标类型,有些指标是非常相似的,所以指标意义也很相近。如果在进行数据解读的时候,不注意指标的内涵外延则会使数据分析失效,而指标选择问题在财经领域非常突出,也给投资人造成很大的误导。

首先,做数据分析需要明确指标口径,例如,环比指标与定基指标,因为比值口径不同,所以同是衡量增长率,却可能获得不同的趋势结论;其次,要确定不同指标的适用范围,例如,库存周转率和仓库面积利用率都是衡量仓储管理效率的指标,但是如果在生产时才确认库存,则会极大拉低库存,提升库存周转率,仓库面积利用率则不会有很大改变,事实上仓储效率也并没有得到提高。在此种情况下,应该多分析同类别指标及其他相关指标,因为指标之间具有逻辑链条,整个系统很难做到完美平衡。

在数据分析时,应特别留意原材料、存货、应收应付款、资金往来指标,因为这些部分查验难度较大(特别是在大型集团公司、工业企业),即便专业的审计人员也无法做到完全核实,存在监管漏洞。在数据分析中,应当尽可能查证研究目标与社会常模的差异性,尽可能计算或核查逻辑链条上的各类指标,如有错漏,很难达到整个链条的平衡完美,将重点指标作为切入点,配合其他途径进行辅助分析,也许能够帮助我们掌握较为客观真实的情况。

其他的问题

在学习和工作过程中,我们还经常会遇到数据分析的其他问题,其中比较突出的是,人们似乎对公式指标繁多的处理方法存在畏难心理,有时可能看到过程和数字结果就感性地认为这是一个客观权威的结论,基本的查询验证意识尚且缺乏,更不用说做到对合理性的深入思考分析。培养严谨科学的分析态度,这个问题不仅局限于普通受众,连专业研究人员有时也会忽视。

另外,随着统计理论的发展和分析软件的进步,各类分析方法模型也有了长足发展,部分以前适用的方法已经不能够复算出后期数据分析类文章的结果。以温忠麟等人的中介效应检验程序为例,2014年的数据分析结果已经较2004年的数据分析结果取得了较大发展,此时如果仅仅关注过去模型,无疑是难以获得理想结论的,甚至有的学者将整个理论推翻重新建立,这也造成了有些既有的数据分析结果在新方法下无法重复,或者新的结论在使用旧方法推导中产生差异。因此,这就要求我们保持学习的热情和动力,时时更新已有知识储备。

图为2004年中介效应检验流程

图为2014年中介效应检验流程

总结与思考

数据已经渗透当今社会的每个行业和领域,甚至每个人的生活中,无论如何,数字时代已经来临,如果说20世纪最重要的资源是石油,那么在数字时代,数据就是21世纪的“石油”。本文讨论了工作和学习中遇到的一些具有代表性的数据分析问题,仅包含了实际问题中的极小部分,我们深知反映真实世界的数据也许只能从一定程度上反映其真实面貌的程度,有些偏差可能是无可避免的。

整体而言,数据是一种资源,也是一把双刃剑,使用得当,可以帮助我们更好地展开研究,了解世界;使用不当,也可能带来信息泄露、安全问题及公平问题。然而,如果每一个数据分析人员能够保持客观、严谨的态度,每一个读数据的人能够培养深入思考的能力,那么将极大地提高数据分析的准确性,减少分析结果的误导弊端,进而有效提升研究结果的客观性和指导性,这种改变将具有深远的意义。