监督学习中,如果预测的变量是离散的,我们称其为分类(svm等,得出的是类,并不是连续的数,所以是离散的),如果预测的变量是连续的,我们称其为回归。在回归分析中,

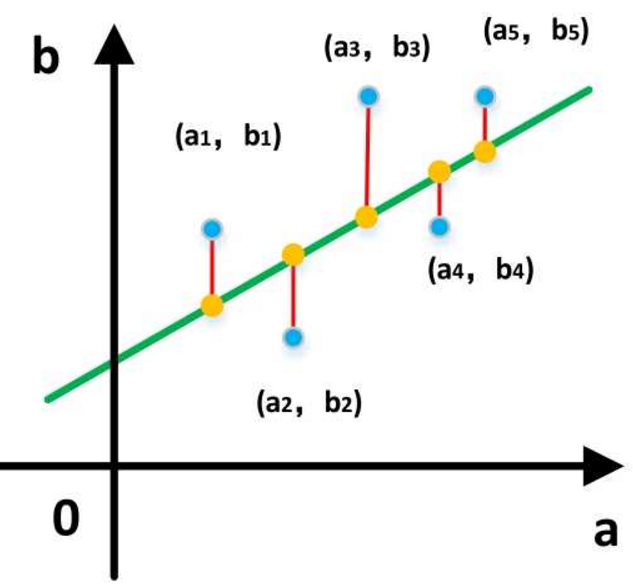

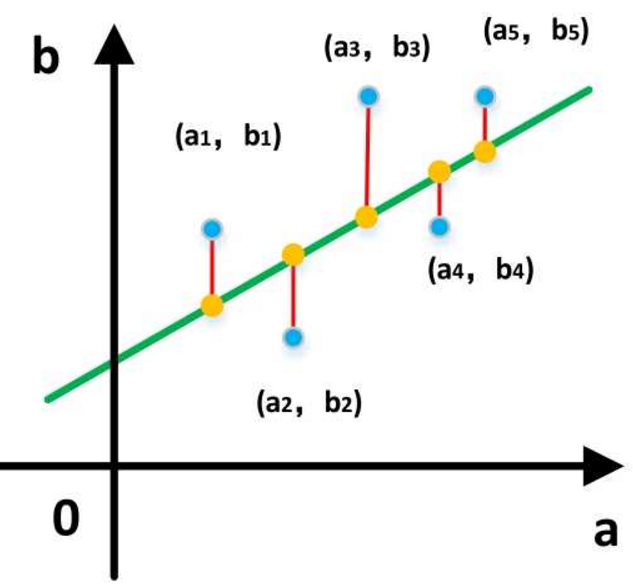

对于一元线性回归模型, 假设从总体中获取了n组观察值(X1,Y1),(X2,Y2), …,(Xn,Yn)。对于平面中的这n个点,可以使用无数条曲线来拟合。要求样本回归函数尽可能好地拟合这组值。综合起来看,这条直线处于样本数据的中心位置最合理。 选择最佳拟合曲线的标准可以确定为:使总的拟合误差(即总残差)达到最小。有以下三个标准可以选择:

[4]

(1)用“残差和最小”确定直线位置是一个途径。但很快发现计算“残差和”存在相互抵消的问题。

(数据在线的左右符号相反)

(2)用“残差绝对值和最小”确定直线位置也是一个途径。但绝对值的计算比较麻烦。

最常用的是普通最小二乘法( Ordinary Least Square,OLS):所选择的回归模型应该使所有观察值的残差平方和达到最小。

在图中就是让每个红线的平方的和最小,即最小二乘法。