https://www.jianshu.com/p/fb97b21aeb1d

什么是决策树

答:决策树的本质是从训练数据中找到一组分类的规则,使得这个规则在尽量拟合训练数据的同时又有比较好的泛化能力。

也可以说是基于训练数据估计条件概率模型。

决策树回归树建树规则与损失函数

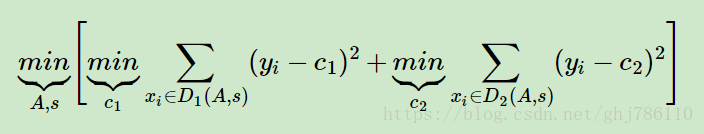

对于连续值的处理,我们知道CART分类树采用的是用基尼系数的大小来度量特征的各个划分点的优劣情况。这比较适合分类模型,但是对于回归模型,我们使用了常见的和方差的度量方式,CART回归树的度量目标是,对于任意划分特征A,对应的任意划分点s两边划分成的数据集D1和D2,求出使D1和D2各自集合的均方差最小,同时D1和D2的均方差之和最小所对应的特征和特征值划分点。表达式为:

假设已经将输入空间划分为M个单元 ,并且在每个单元 上有一个固定的输出值 ,于是回归树模型可以表示为

当输入空间划分确定时,可以用平方误差

来表示回归树对于训练数据的预测误差,用平方误差最小化的准则求解每个单元上的最优输出值.

决策树的损失函数是正则化的极大似然函数

分类树决策树损失函数解释:

https://blog.csdn.net/wjc1182511338/article/details/76793598

讲得有道理