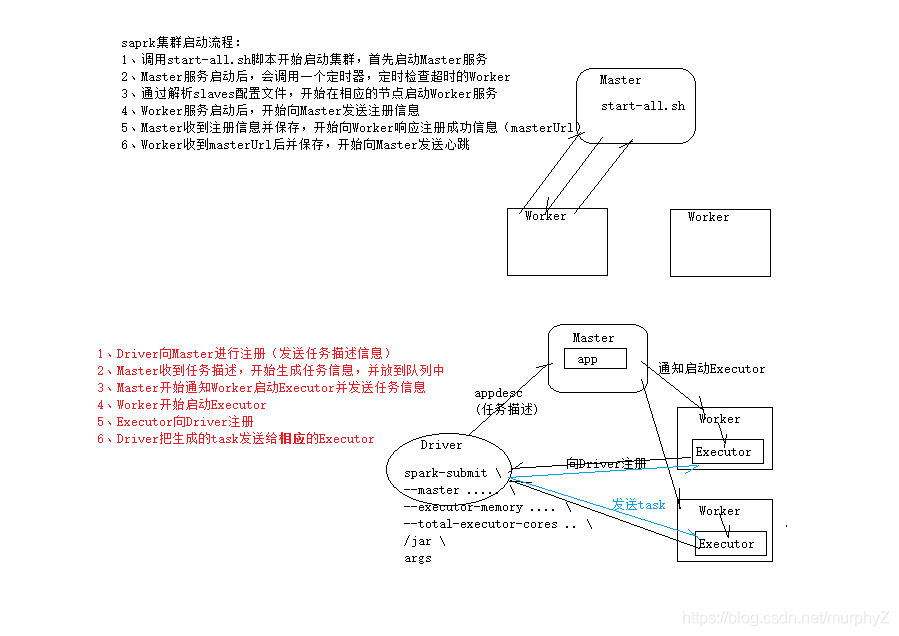

1、集群启动流程和任务提交流程概述

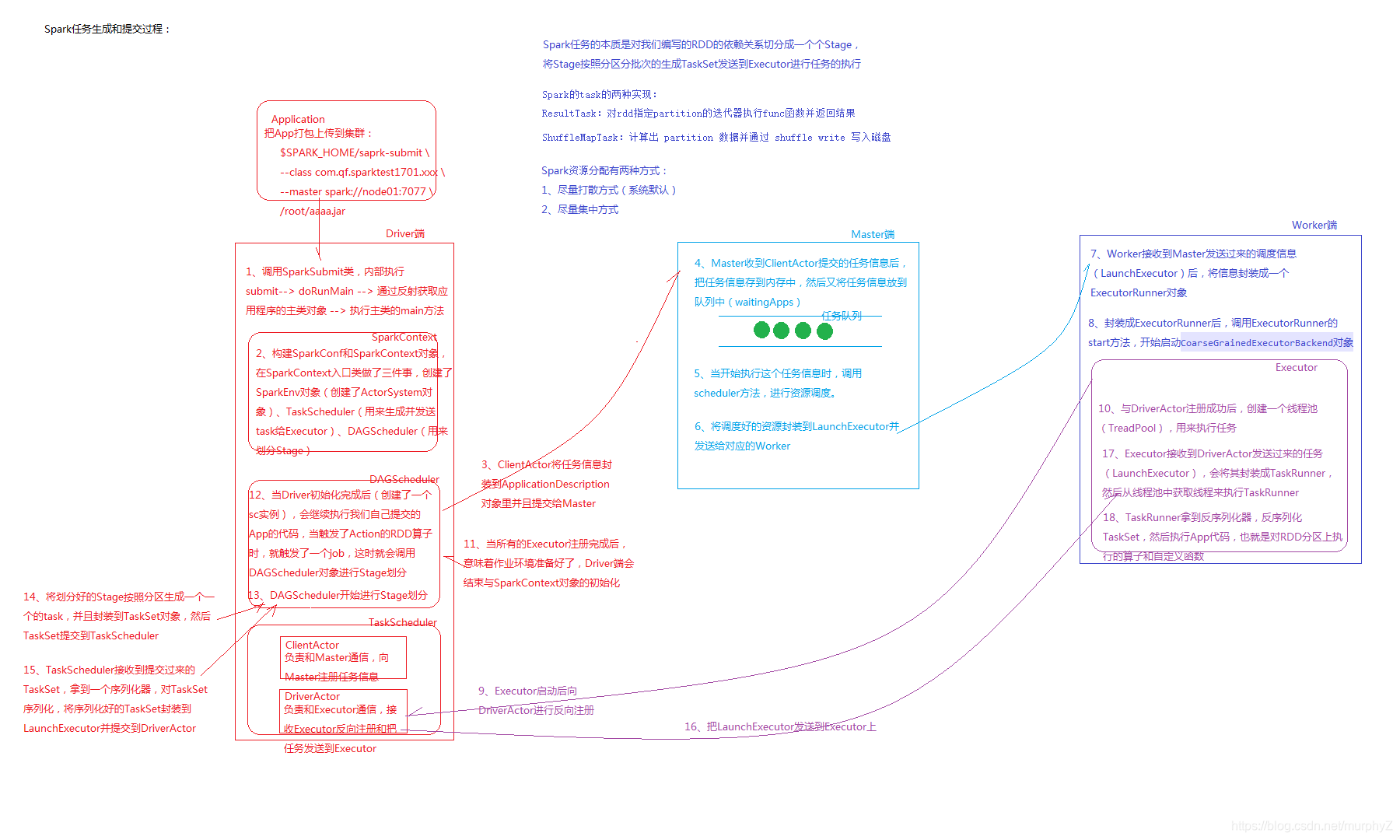

spark任务生成和提交过程(详细:降龙十八掌)

2、checkpoint检查点

2.1)、checkpoint的应用场景:

在应用程序的执行过程中,有时候某些RDD的数据需要在其它地方多次用到(包括其它job中用到),

为了使得整个依赖链条,不至于很长导致执行缓慢,可以用checkpoint来缩短依赖链条.

最好把数据checkpoint到HDFS,保证了数据的安全性,便于在用数据的时候进行拉取.

执行过程:

在代码层面是这样执行的,如果用到某个RDD的数据的时候,首先会检查是否做了缓存,如果做了缓存,

会直接从缓存里面取数据,如果没有做缓存,则判断是否做了checkpoint,如国做了checkpoint,则从

checkpoint的指定路径下获取数据,如果没有checkpoint,只能重新计算得到数据.

2.2)、checkpoint的具体实现步骤:

1.设置一个checkpoint的目录

setCheckPointDir(“hdfs://node1:8020/cp-2019-01-05-1”)

2.把要checkpoint的RDD的数据进行cache

rdd.persist

3.checkpoint

rdd.checkpoint