机器学习算法特点:迭代运算

损失函数最小化训练过程中,在巨大参数空间中迭代寻找最优解

比如:主题模型、回归、矩阵分解、SVM、深度学习

分布式机器学习的挑战:

- 网络通信效率

- 不同节点执行速度不同:加快慢任务

- 容错性

机器学习简介:

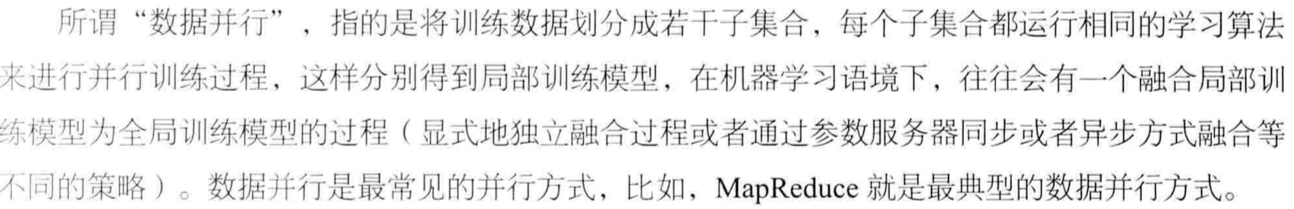

数据并行vs模型并行:

数据并行

模型并行

分布式机器学习范型:

其他情形

MPI:容错性差、集群规模小、扩展性低

GPU:目前处理规模中等(6-10GB)

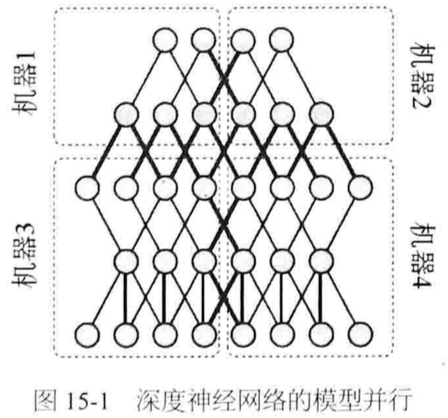

1. 同步范型(严格情形每轮迭代进行数据同步)

快等慢,计算资源浪费;网络通信多

eg:MapReduce迭代计算、BSP模型属于严格同步范型

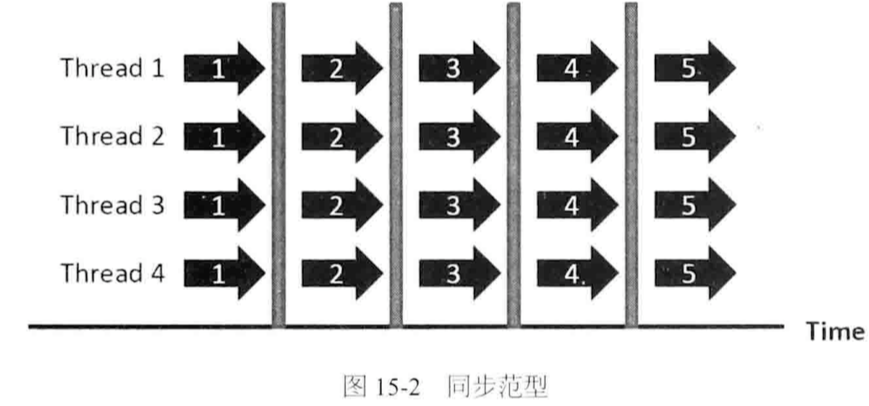

2. 异步范型(任意时刻读取更新全局参数)

若部分任务迭代严重落后会拉低效果

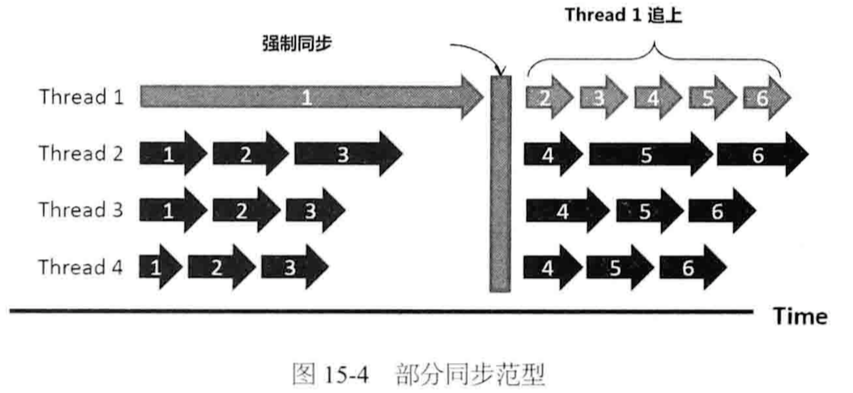

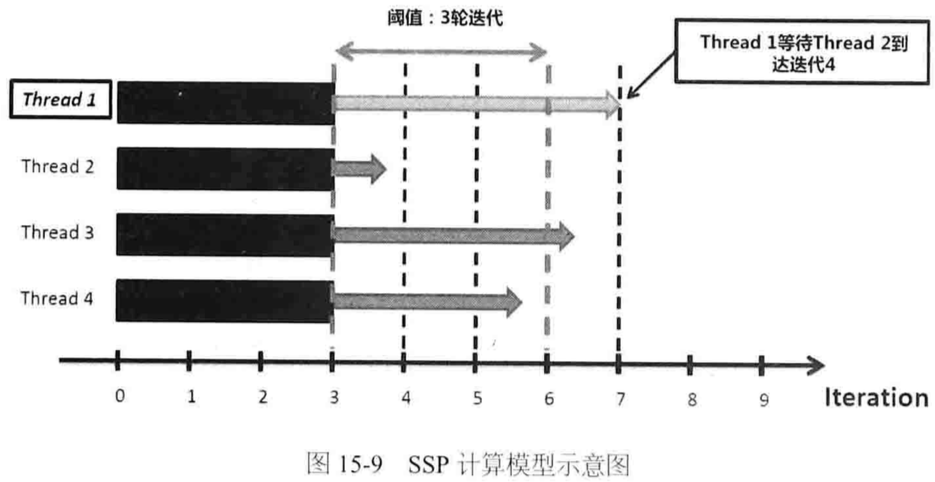

3. 部分同步范型(主要研究方向)

eg:SSP模型

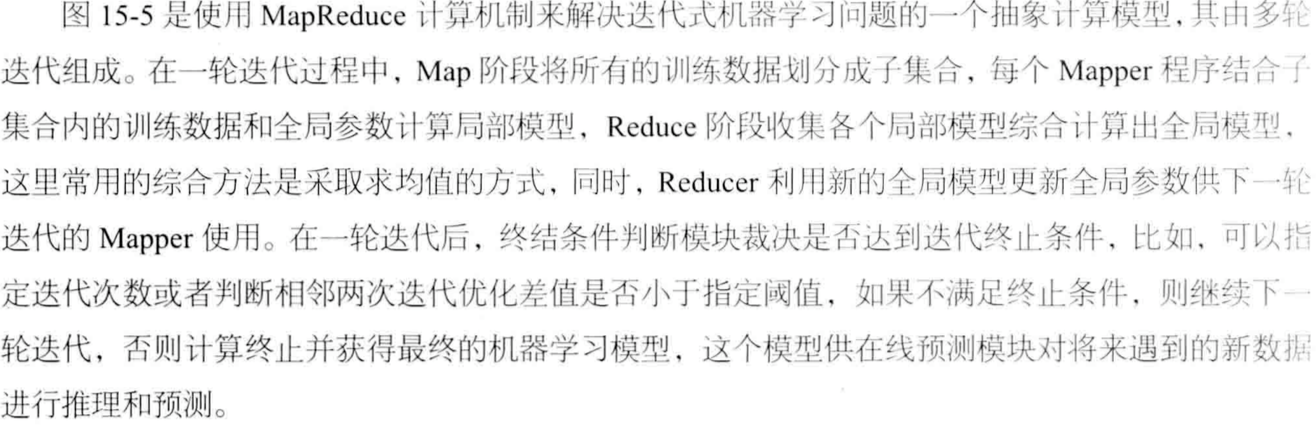

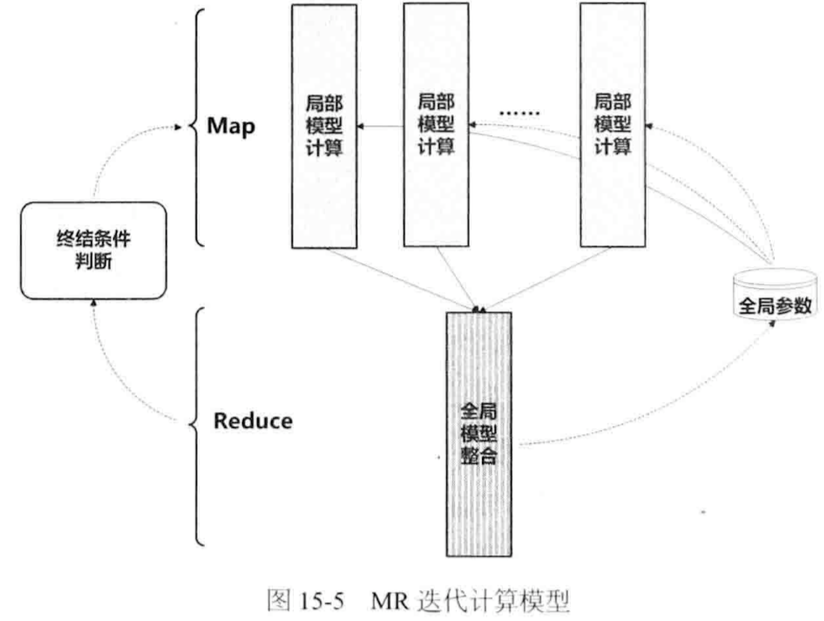

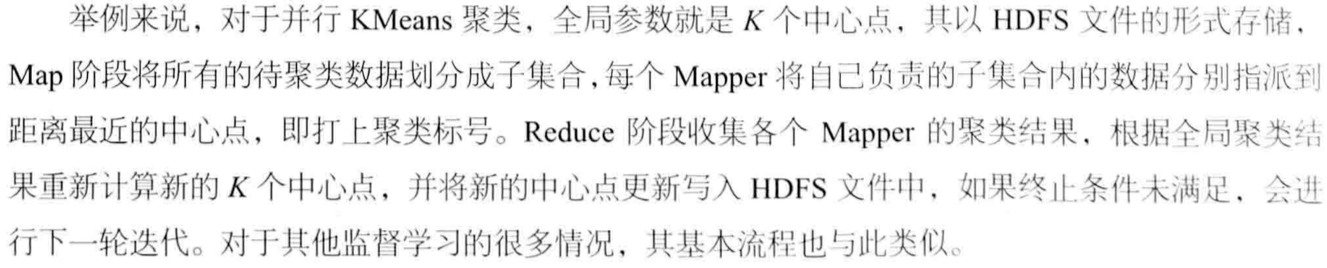

MapReduce迭代计算模型

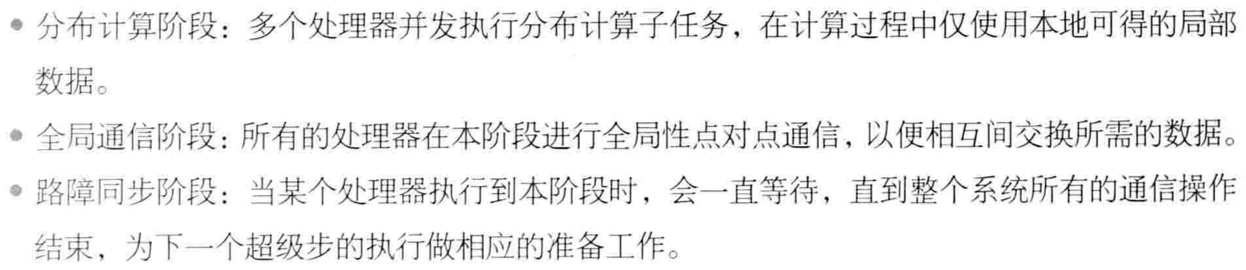

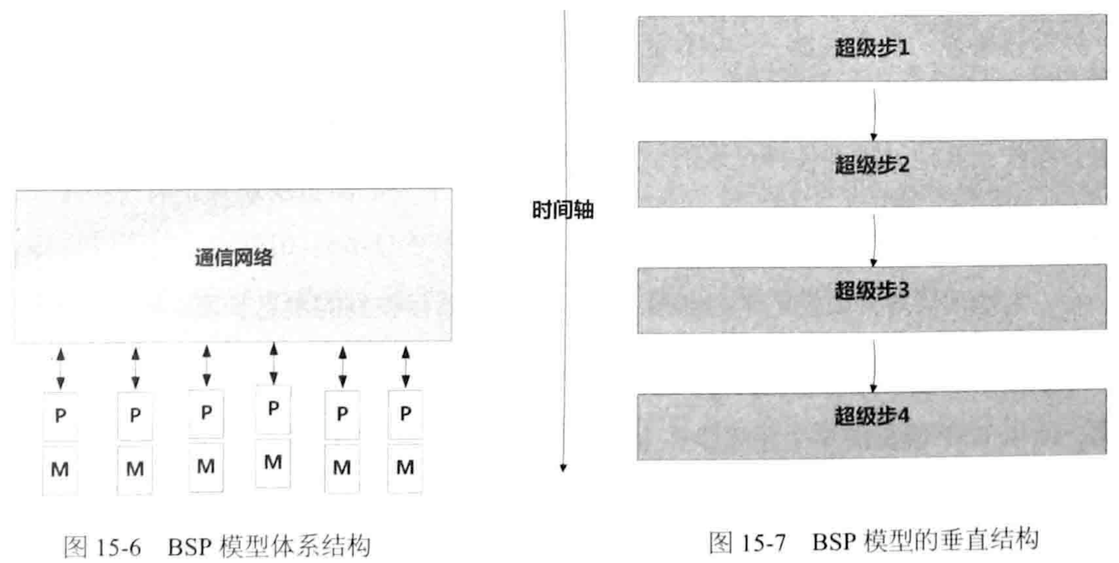

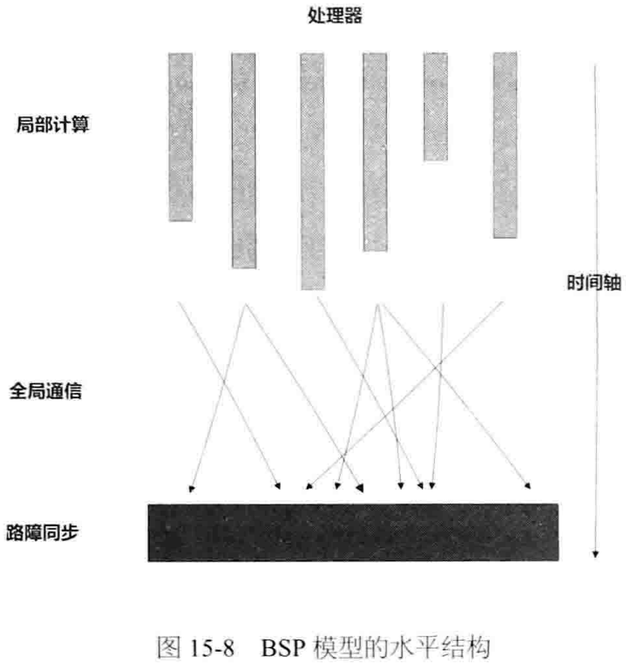

BSP(Bulk Synchronous Parallel)计算模型

“桥接模型”:介于纯硬件、纯编程模式之间的模型

许多相关工作已验证BSP模型的健壮性、性能可预测性和可扩展性

优点:

缺点:

资源利用率低、网络通信多、计算效率低

图计算框架也用BSP:比如Pregel、Giraph

SSP(Stale Synchronous Parallel)计算模型

阈值s=0时,SSP退化为BSP同步模型;s=+inf时,SSP演化为完全异步模型

分布式机器学习架构:

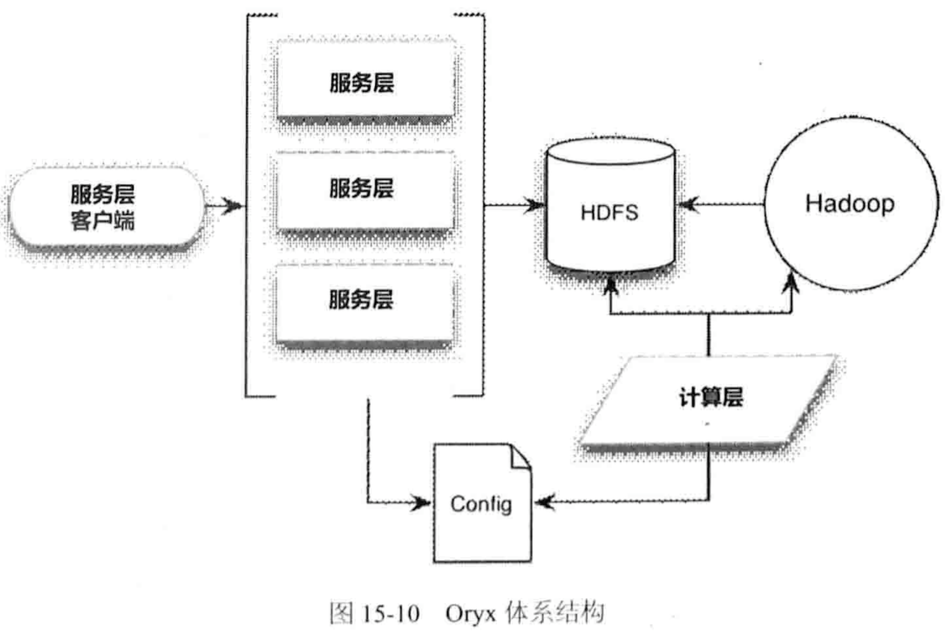

MapReduce系列架构:

Cloudera Oryx、Apache Mahout,两者类似。

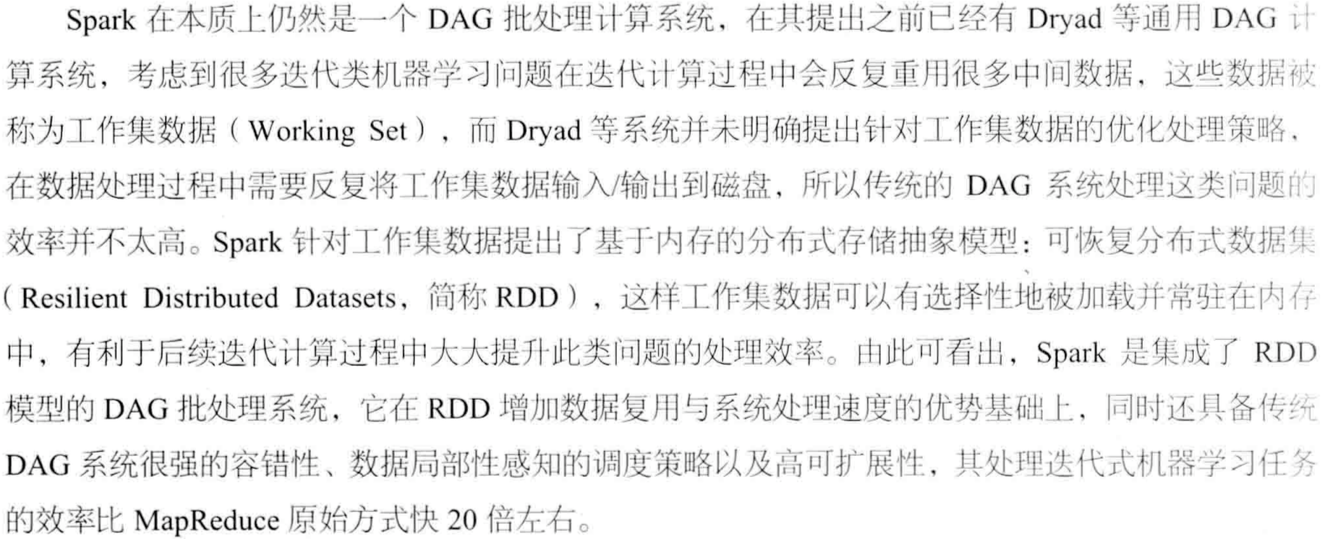

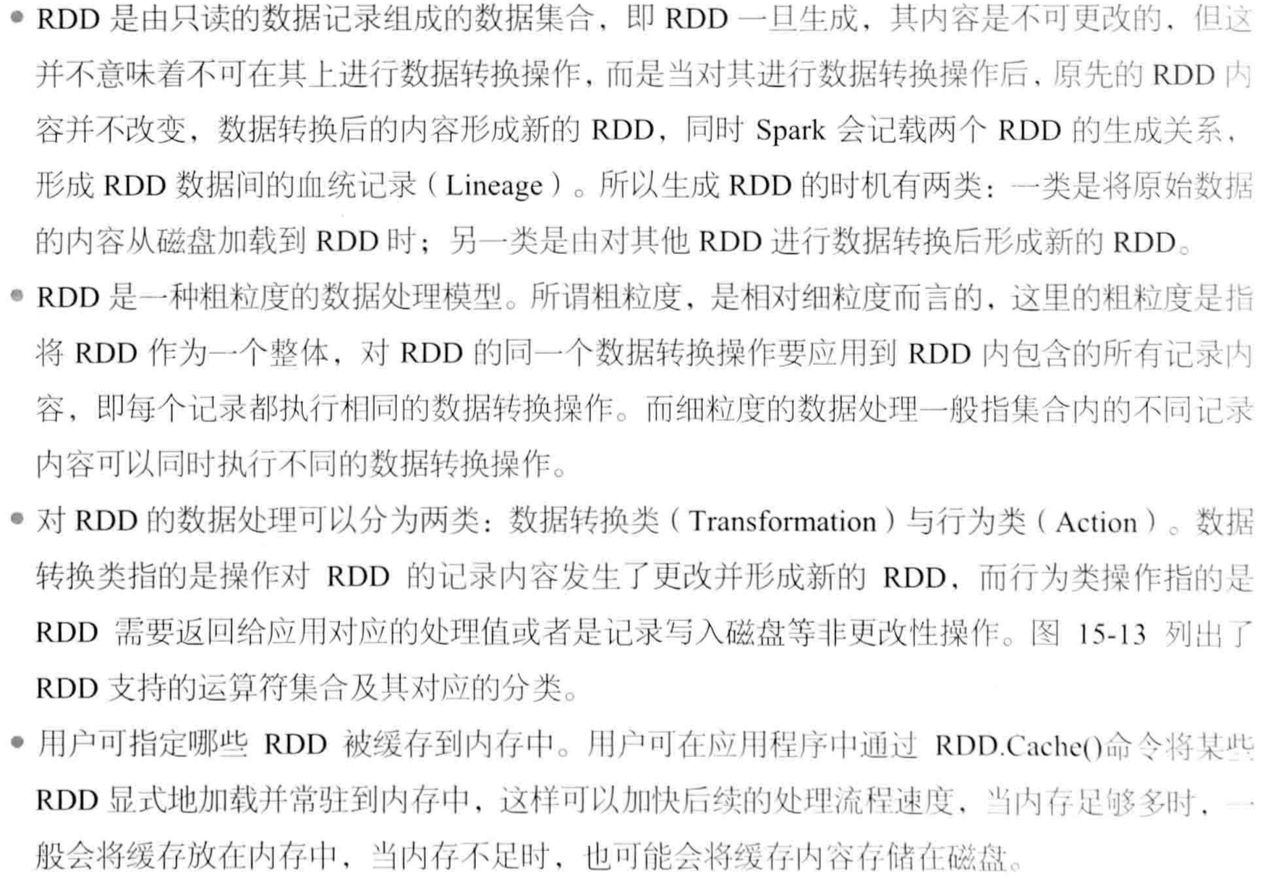

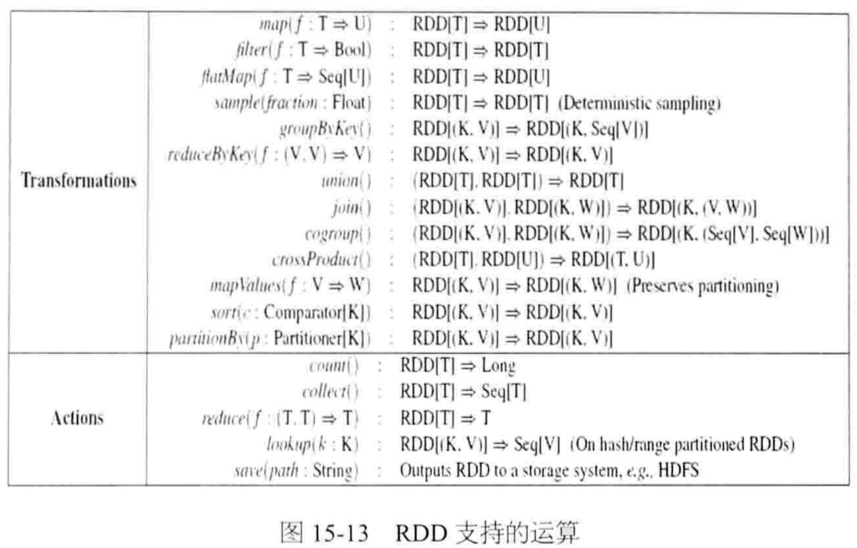

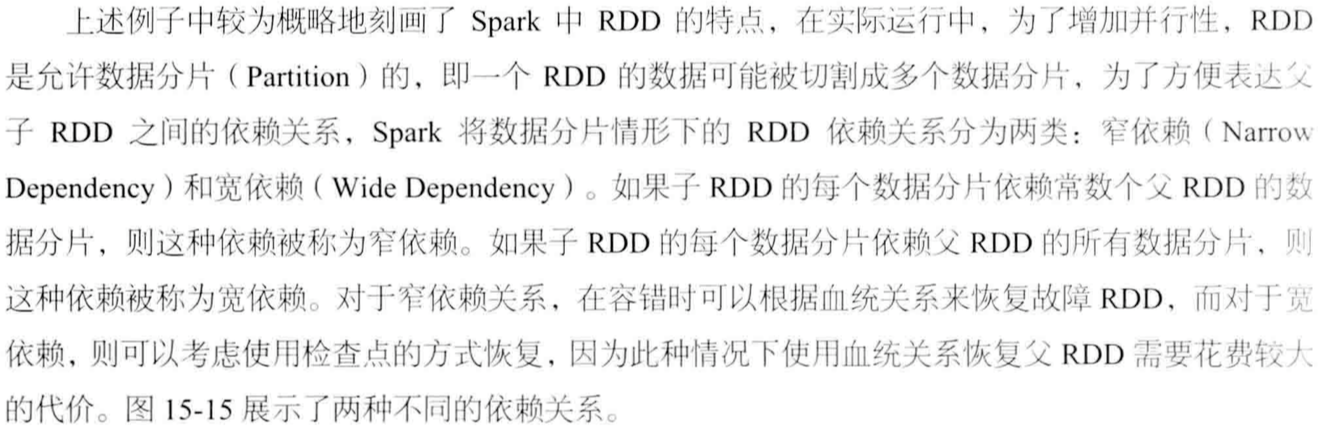

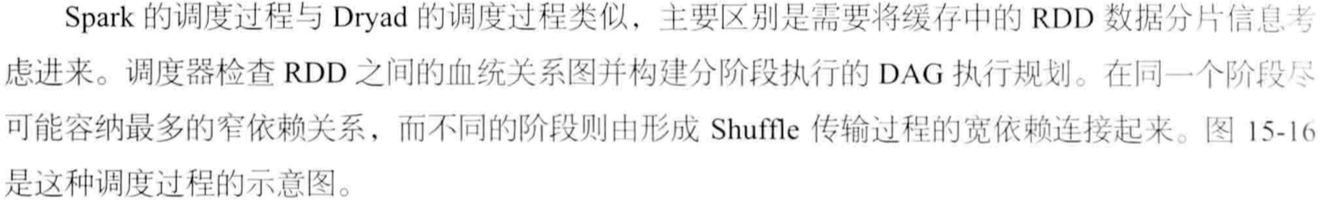

Spark及MLBase:

Spark

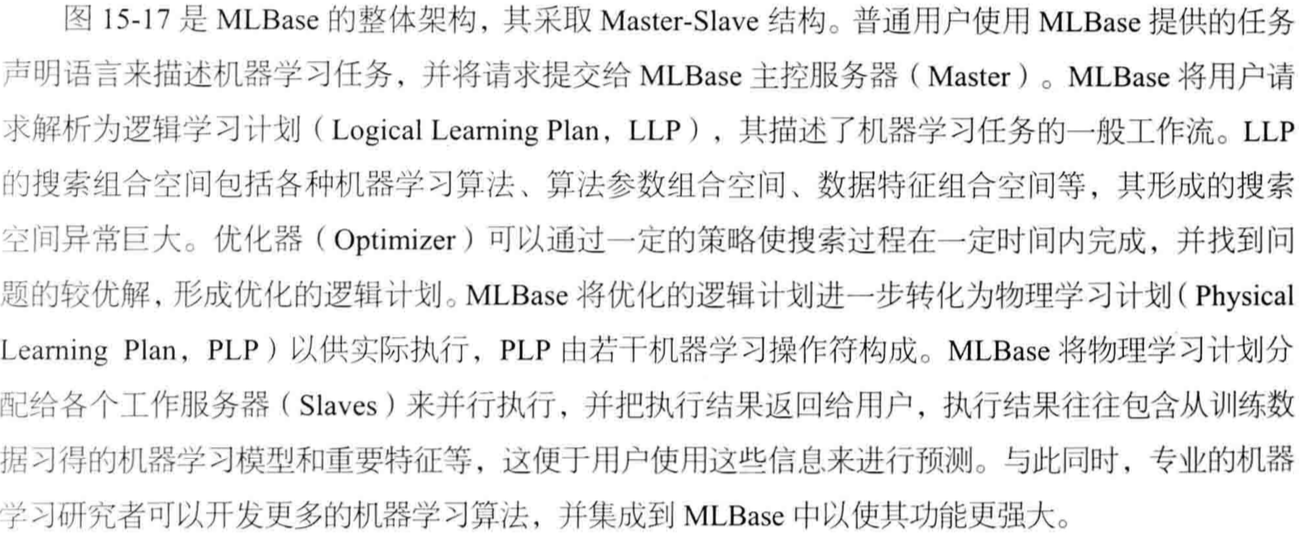

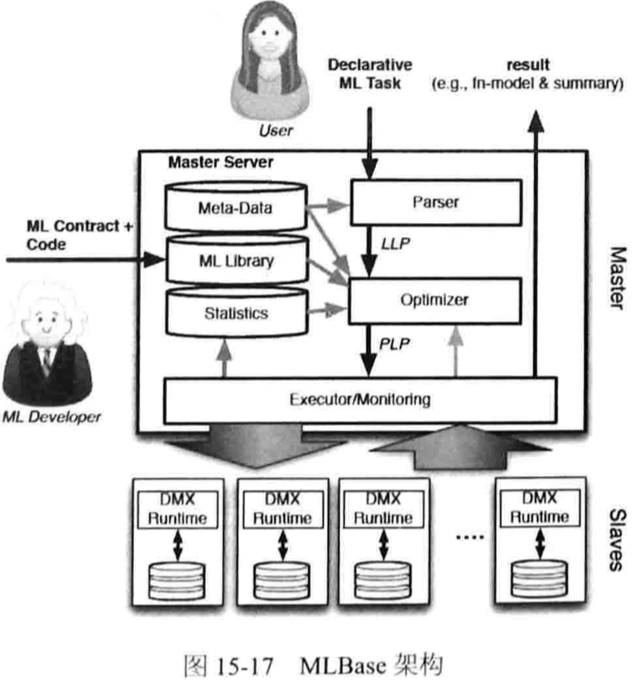

2. MLBase

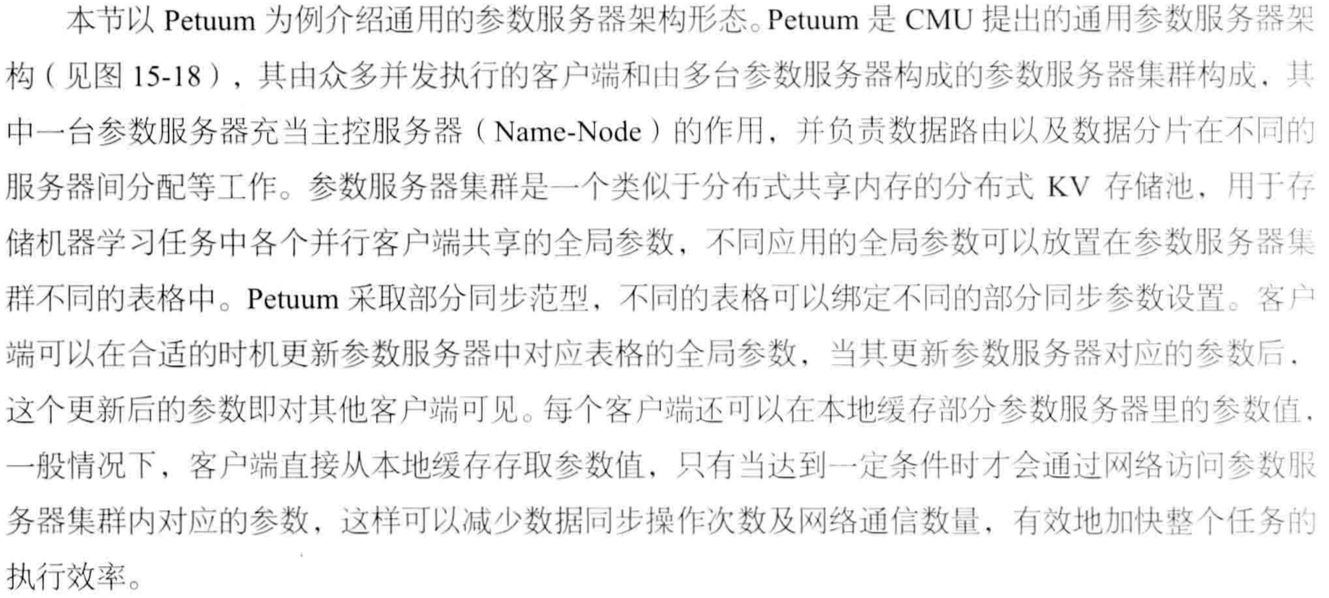

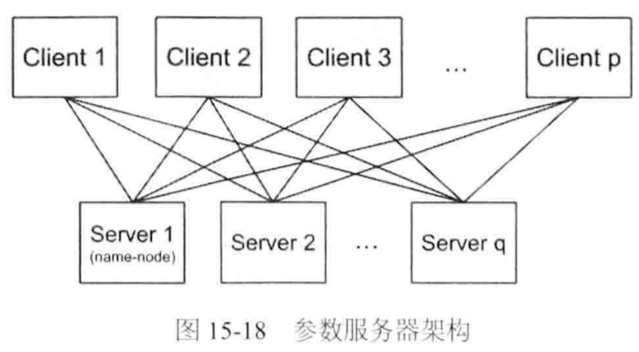

参数服务器(Parameter Server):

比如:Google能处理百亿参数的深度机器学习框架DistBelief

1. 架构

2. 一致性模型

需要设计新型的参数副本一致性均衡正确性和并发度。往往通过受限的异步并行方式(类似于部分同步并行)

1)时钟界异步并行(Clock-bounded Asynchronous Parallel,CAP)

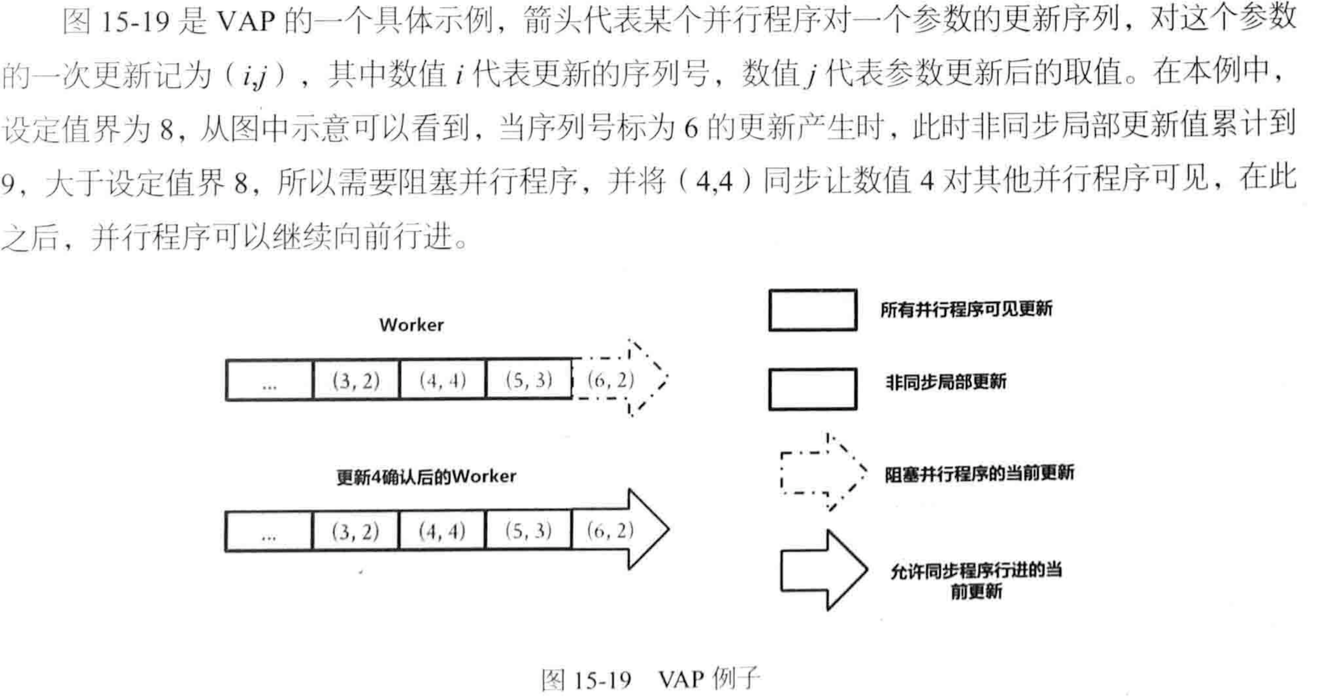

2)值界异步并行(Value-bounded Asynchronous Parallel,VAP)

不考虑时钟值而是参数的更新积累数值。

也可以集成CAP和VAP。有理论可以证明:对于随机梯度下降等常见机器学习算法,VAP可以保证算法收敛性。

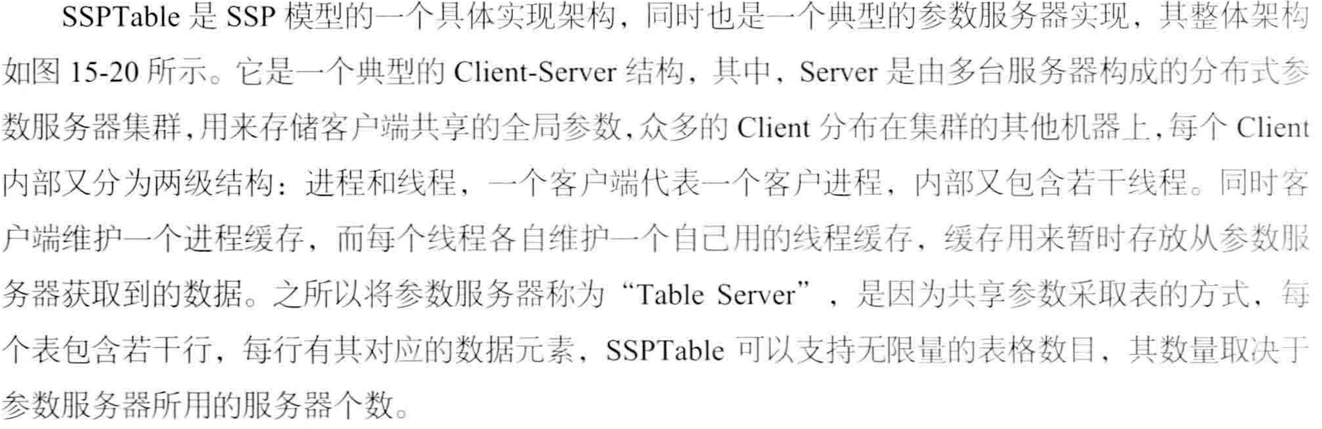

3. SSPTable