1.分配更多内存

有的机器学习工具/库有默认内存设置,比如Weka。这便是个限制因素。

你需要检查下:是否能重新设置该工具/库,分配更多内存。

对于Weka,你可以在打开应用时,把内存当作个参数进行调整。

2.用更小的样本

你真的需要用到全部数据吗?

可以采集个数据的随机样本,比如前1,000或100,000行。在全部数据上训练较终模型之前(使用渐进式的数据加载技巧),先试着用这个小样本解决问题。

总的来说,对算法做快速地抽查、看到结果在前后的变化,在机器学习领域是个很好的习惯。

你还可以考虑:相对于模型技巧,做个数据大小的敏感性分析。或许,对于你的随机小样本,有个天然的边际效应递减分水岭。越过这个关口,继续增加的数据规模带来的好处微乎其微。

3.更多内存

你必须要用PC吗?

你可以考虑内存、性能高个量的计算设备。比如,租用AWS这样的云服务。租用云端有数十GB内存的机器,较低价格每小时不到美元。我个人觉得这是非常实际的选择。

4.转换数据格式

你是否把数据存为原始的ASCII文本,比如CSV文件?

或许,使用其它格式能加速数据载入并且降低内存占用。好的选择包括像GRIB、NetCDF、HDF这样的二进制格式。

有很多命令行工具能帮你转换数据格式,而且不需要把整个数据集载入内存里。

换种格式,可能帮助你以更紧凑的形式存储数据,节省内存空间;比如2-byte整数,或者4-byte浮点。

5.流式处理数据,或渐进式的数据加载

你的所有数据,需要同时出现在内存里吗?

或许,你可以用代码或库,随时把需要的数据做流式处理或渐进式加载,导入内存里训练模型。

这可能需要算法使用优化技术迭代学习,比如使用随机梯度下降。那些需要内存里有所有数据、以进行矩阵运算的算法,比如某些对线性回归和逻辑回归的实现,就不适用了。

比如,Keras深度学习API就提供了渐进式加载图像文件的功能,名为flow_from_directory

另个例子式Pandas库,可批量载入大型CSV文件。

6.使用关系数据库(Relationaldatabase)

关系数据库为存储、访问大型数据集提供了标准化的方法。

在内部,数据存在硬盘中,能渐进式地inbatch批量加载,并使用标准检索语言SQL检索。

像MySQL、Postgres这样的开源数据库工具,支持绝大多数的(全部?)编程语言。许多机器学习工具,都能直接与关系数据库连通。你也可以用SQLite这样更轻量的方法。

我发现,这种方法对大型表格式数据集非常有效率。

雷锋网提醒,你需要用能迭代学习的算法。

7.使用大数据平台

有的情况下,你可能必须要使用大数据平台,即为处理超大型数据集而开发的平台。它们能让你进行数据转换,并在其上开发机器学习算法。

两个很好的例子是hadoop与机器学习库Mahout,以及Spark与MLLib库。

我认为,这是用尽上述办法仍无法解决的情况下,才需要采用的较后手段。单纯是这为你的机器学习项目所带来的额外硬件、软件复杂情况,就会消耗许多精力。

即便如此,有的任务确实数据太过庞大,前面的选项都无法奏效。

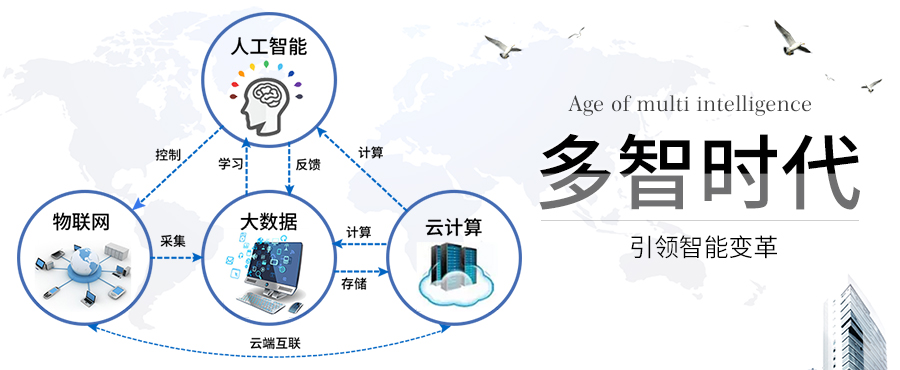

人工智能、大数据、云计算和物联网的未来发展值得重视,均为前沿产业,多智时代专注于人工智能和大数据的入门和科谱,在此为你推荐几篇优质好文:

企业如何实现对大数据的处理与分析?

http://www.duozhishidai.com/article-5030-1.html

浅析PB级分布式大数据的处理和分析应用

http://www.duozhishidai.com/article-4368-1.html

大数据时代,最适合大数据处理的编程语言有哪些?

http://www.duozhishidai.com/article-1823-1.html