LVS简介:LVS(Linux Virtual Server)由中国的章文嵩博士开发,他就职于阿里巴巴集团。

1、抗负载能力强。抗负载能力强、性能高,能达到F5硬件的60%;对内存和cpu资源消耗比较低

2、工作在网络4层(传输层),通过vrrp协议转发(仅作分发之用),具体的流量由linux内核处理,因此没有流量的产生。

3、稳定性、可靠性好,自身有完美的热备方案;(如:LVS+Keepalived)

4、应用范围比较广,可以对所有应用做负载均衡;因为他是通过修改网络数据包中的端口号、IP地址来实现负载均衡的,跟上层应用无直接关系。

5、不支持正则处理,不能做动静分离。(只有应用层(即七层)的负载均衡才支持正则处理)

6、支持负载均衡算法:rr(轮循、轮询)、wrr(带权轮循)、lc(最小连接)、wlc(权重最小连接)

7、配置复杂,对网络依赖比较大,稳定性很高。(这里说的配置复杂是跟nginx的负载均衡来做对比)

8、LVS是通过修改数据包中的端口号、IP地址、MAC地址来实现负载均衡。

LVS的相关术语:

LVS的管理工具和内核模块 ipvsadm/ipvs

ipvsadm:用户空间的命令行工具,用于管理集群服务及集群服务上的RS等

ipvs:工作于内核上的netfilter INPUT钩子之上的程序,可根据用户定义的集群实现请求转发

DS:调度服务器,指的是前端负载均衡器节点(Directo Server)

RS:后端真实服务器(Real server)

CIP:客户端的IP地址(client IP)

VIP:虚拟IP即用户请求的目标IP地址(Virtual IP)

RIP:后端真实服务器IP地址(Real server IP)

DIP:调度服务器IP地址,即内网IP(Directo server IP)

IPVS:IP虚拟服务(IP Virtual service)

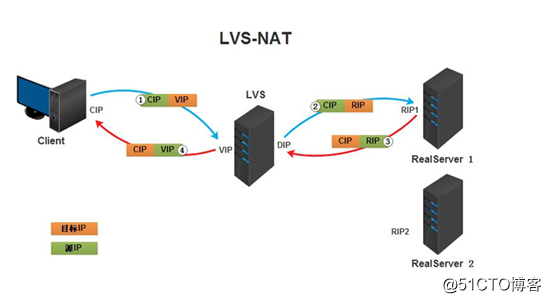

LVS-NAT的工作过程:

client(客户机) --> DS(调度服务器) --> 内核空间(首先是preruoting链收到数据,对比IP后) --> input链(核对由IP虚拟服务定义的集群信息,如果是则将目标IP改成后端服务器的IP) --> postrouting链(由IP寻址路由选择根据RIP) --> RS(后端服务器)

解释:

1. 当用户向负载均衡调度器发起请求,调度器将请求发往至linux的内核(kernel)空间。

2. PREROUTING链首先会接收到用户请求,判断目标IP确定是本机IP,将数据包发往INPUT链。

3. IPVS(ip virtual service)是工作在INPUT链上的,当用户请求到达INPUT时,IPVS会将用户请求和自己已定义好的集群服务(即LVS上用ipvsadm命令定义的负载均衡列表)进行比对,如果用户请求的就是定义的集群服务,那么此时IPVS会强行修改数据包里的目标IP地址及端口,并将新的数据包发往POSTROUTING链(路由后)。

4. POSTROUTING链接收数据包后发现目标IP地址刚好是自己的后端服务器,那么此时通过选路(即路由选择),将数据包最终发送给后端的真实服务器。

实战一:LVS/NAT 实现四层负载均衡

实验环境:

将VMware调成NAT模式,准备三台服务器,一台做LVS的负载均衡器(因为LVS-server上需要设置DIP和VIP,所以需要两块网卡),另外两台为web服务器。

192.168.11.132 LVS

192.168.11.133 web1

192.168.11.134 web2

清空防火墙策略,关闭selinux

iptables -F (或者systemctl stop firewalld.service) && setenforce 0

1.更改主机名和/etc/hosts文件(选做):

hostnamectl --static set-hostname LVS

hostnamectl --static set-hostname web1

hostnamectl --static set-hostname web2

bash

cat /etc/hosts

192.168.11.132 LVS-server.com LVS

192.168.11.133 web1.tianbin.com web1

192.168.11.134 web2.tianbin.com web2

1.在两台web服务器上安装httpd,并且写入不同的页面,然后启动httpd并设置开机自启,测试。

web1、2:yum -y install httpd

web1:echo node1.com > /var/www/html/index.html

web2:echo node2.com > /var/www/html/index.html

web1、2:systemctl enable httpd --now

curl 192.168.11.133/134

2.在LVS上开启路由转发功能,并且做VIP的新网卡:

echo "net.ipv4.ip_forward = 1" >> /etc/sysctl.conf

sysctl -p

#在虚拟机上添加一块新网卡,使用NAT模式。

yum -y install net-tools NetworkManager > /dev/null && systemctl start NetworkManager-dispatcher.service

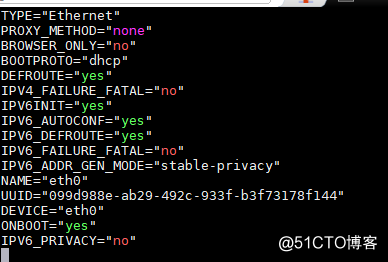

nmcli connection #查看UUID,以下是查询结果。

NAME UUID TYPE DEVICE

eth0 099d988e-ab29-492c-933f-b3f73178f144 ethernet eth0

eth1 ae146a73-de8b-47b6-8950-0dad86471114 ethernet eth1

route -n #查看路由信息,主要看网关信息。以下是查询结果

Kernel IP routing table

Destination Gateway Genmask Flags Metric Ref Use Iface

0.0.0.0 192.168.11.2 0.0.0.0 UG 100 0 0 eth0

0.0.0.0 172.16.0.2 0.0.0.0 UG 101 0 0 eth1

172.16.0.0 0.0.0.0 255.255.0.0 U 101 0 0 eth1

192.168.11.0 0.0.0.0 255.255.255.0 U 100 0 0 eth0

route del default gw 192.168.11.2 #临时删除网关或者更改网卡的配置文件来删除网关。推荐改配置文件,改前先备份。

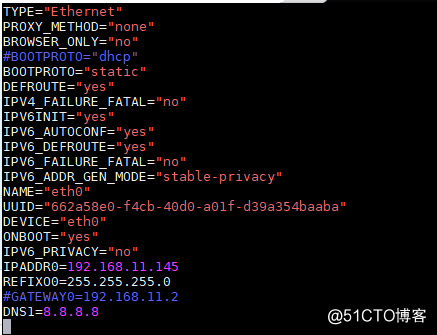

cd /etc/sysconfig/network-scripts #备份并修改网卡配置文件,如图:

cp -av ifcfg-eth0{,.bak}

============>

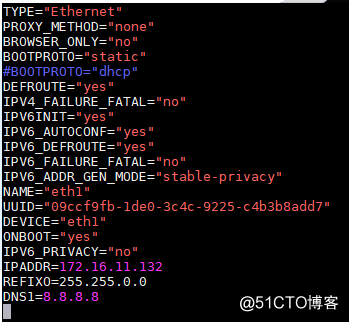

============>

cp -av ifcfg-eth0 ifcfg-eth1 #生成新网卡的配置文件,将网卡模式改为NAT模式,并且进行的修改如下:

#如上图对web1,2的网卡信息进行修改,再将的网关改为192.168.11.132。

3.在LVS上安装LVS管理软件,并且定义LVS的分发策略(轮询调度rr):

yum -y install ipvsadm #对于ipvsadm命令怎么使用,在下面有详细解释。

ipvsadm -A -t 172.16.11.132:80 -s rr

ipvsadm -a -t 172.16.11.132:80 -r 192.168.11.133 -m

ipvsadm -a -t 172.16.11.132:80 -r 192.168.11.134 -m

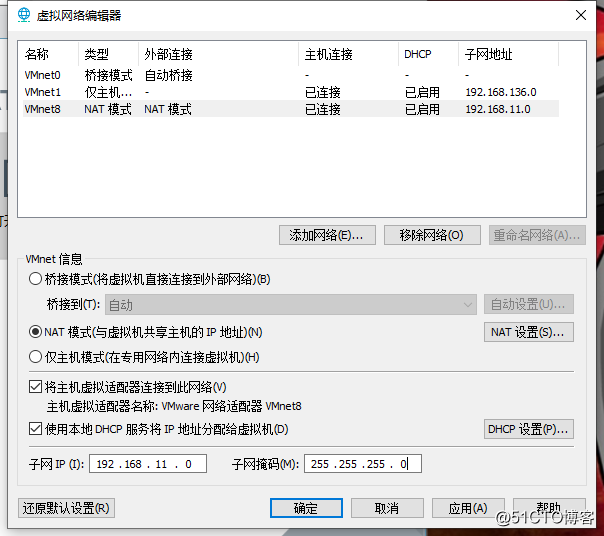

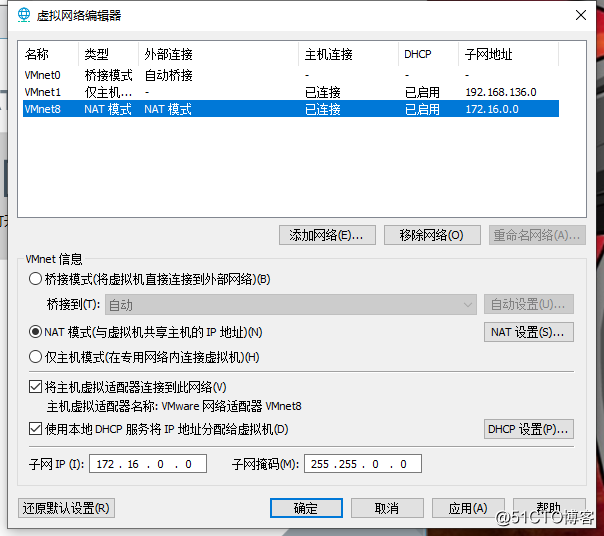

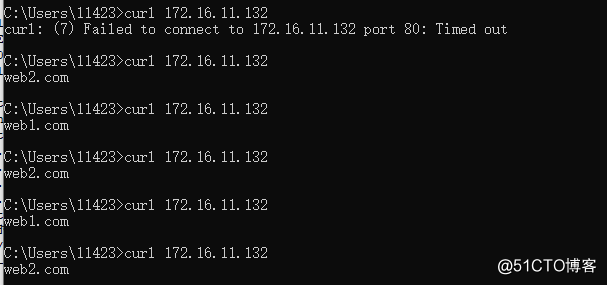

4.访问测试,在虚拟机外边,也就是自己电脑系统的命令提示符界面进行测试,此时需要更改虚拟网络编辑器的NAT模式的网段,否则测试不成功。

----------->

----------->

如上图,结果表示测试成功,这只是进行LVS的轮询调度,也就是调度器通过“轮询”调度算法将外部请求按顺序轮流分配到集群中的真实服务器上,它均等地对待每一台服务器,而不管服务器上实际的连接数和系统负载。也就是说两台相同硬件配置的服务器轮流提供服务,降低负载。

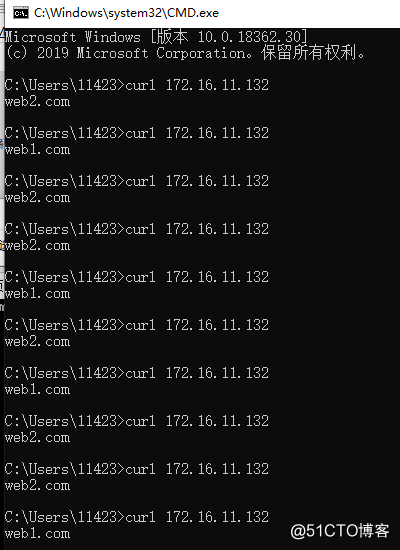

附加:关于LVS的加权算法(wrr):

ipvsadm -C

ipvsadm -A -t 172.16.11.132:80 -s wrr

ipvsadm -a -t 172.16.11.132:80 -r 192.168.11.133 -m -w 2

ipvsadm -a -t 172.16.11.132:80 -r 192.168.11.134 -m -w 3

测试如下:web1和web2的访问次数因为设置了权重值,所以访问次数比为2:3,这里访问了10次进行测试:

这里介绍一下LVS的调度算法:

LVS的调度算法分为静态与动态两类。

1、静态算法(4种),只根据算法进行调度 而不考虑后端服务器的实际连接情况和负载情况

① RR:轮询调度(Round Robin)

调度器通过”轮询”调度算法将外部请求按顺序轮流分配到集群中的真实服务器上,它均等地对待每一台服务器,而不管服务器上实际的连接数和系统负载。

② WRR:加权轮叫(Weight RR) 调度器通过“加权轮叫”调度算法根据真实服务器的不同处理能力来调度访问请求。这样可以保证处理能力强的服务器处理更多的访问流量。调度器可以自动问询真实服务器的负载情况,并动态地调整其权值。

③ DH:目标地址散列调度(Destination Hash )

根据请求的目标IP地址,作为散列键(HashKey)从静态分配的散列表找出对应的服务器,若该服务器是可用的且未超载,将请求发送到该服务器,否则返回空。

④ SH:源地址 hash(Source Hash)

源地址散列”调度算法根据请求的源IP地址,作为散列键(HashKey)从静态分配的散列表找出对应的服务器,若该服务器是可用的且未超载,将请求发送到该服务器,否则返回空。

2、动态算法(6种)前端的调度器会根据后端真实服务器的实际连接情况来分配请求

① LC:最少链接(Least Connections)

调度器通过”最少连接”调度算法动态地将网络请求调度到已建立的链接数最少的服务器上。如果集群系统的真实服务器具有相近的系统性能,采用”最小连接”调度算法可以较好地均衡负载。

② WLC:加权最少连接(默认采用的就是这种)(Weighted Least Connections)

在集群系统中的服务器性能差异较大的情况下,调度器采用“加权最少链接”调度算法优化负载均衡性能,具有较高权值的服务器将承受较大比例的活动连接负载。调度器可以自动问询真实服务器的负载情况,并动态地调整其权值。

③ SED:最短期望延迟调度(Shortest Expected Delay )

在WLC基础上改进,Overhead = (ACTIVE+1)256/加权,不再考虑非活动状态,把当前处于活动状态的数目+1来实现,数目最小的,接受下次请求,+1的目的是为了考虑加权的时候,非活动连接过多缺陷:当权限过大的时候,会倒置空闲服务器一直处于无连接状态。

④ NQ:永不排队/最少队列调度(Never Queue Scheduling NQ)

无需队列。如果有台 realserver的连接数=0就直接分配过去,不需要再进行sed运算,保证不会有一个主机很空间。在SED基础上无论+几,第二次一定给下一个,保证不会有一个主机不会很空闲着,不考虑非活动连接,才用NQ,SED要考虑活动状态连接,对于DNS的UDP不需要考虑非活动连接,而httpd的处于保持状态的服务就需要考虑非活动连接给服务器的压力。

⑤ LBLC:基于局部性的最少链接(locality-Based Least Connections) 基于局部性的最少链接”调度算法是针对目标IP地址的负载均衡,目前主要用于Cache集群系统。该算法根据请求的目标IP地址找出该目标IP地址最近使用的服务器,若该服务器是可用的且没有超载,将请求发送到该服务器;若服务器不存在,或者该服务器超载且有服务器处于一半的工作负载,则用“最少链接”的原则选出一个可用的服务器,将请求发送到该服务器。

⑥ LBLCR:带复制的基于局部性最少连接(Locality-Based Least Connections with Replication) 带复制的基于局部性最少链接”调度算法也是针对目标IP地址的负载均衡,目前主要用于Cache集群系统。它与LBLC算法的不同之处是它要维护从一个目标IP地址到一组服务器的映射,而LBLC算法维护从一个目标IP地址到一台服务器的映射。该算法根据请求的目标IP地址找出该目标IP地址对应的服务器组,按”最小连接”原则从服务器组中选出一台服务器,若服务器没有超载,将请求发送到该服务器;若服务器超载,则按“最小连接”原则从这个集群中选出一台服务器,将该服务器加入到服务器组中,将请求发送到该服务器。同时,当该服务器组有一段时间没有被修改,将最忙的服务器从服务器组中删除,以降低复制的程度。

这里有关于ipvsadm命令的选项解释:

-A --add-service 在内核的虚拟服务器表中添加一条新的虚拟服务器记录。也就是增加一台新的虚拟服务器(VIP)。

-E --edit-service 编辑内核虚拟服务器表中的一条虚拟服务器记录。

-D --delete-service 删除内核虚拟服务器表中的一条虚拟服务器记录。

-C --clear 清除内核虚拟服务器表中的所有记录。

-R --restore 恢复虚拟服务器规则

-S --save 保存虚拟服务器规则,备份输出为-R 选项可读的格式

-a --add-server 在内核虚拟服务器表的一条记录里添加一条新的真实服务器记录(RIP)。也就是在一个虚拟服务器中增加一台新的真实服务器

-e --edit-server 编辑一条虚拟服务器记录中的某条真实服务器记录

-d --delete-server 删除一条虚拟服务器记录中的某条真实服务器记录

-L|-l --list 显示内核虚拟服务器表

-Z --zero 虚拟服务表计数器清零(清空当前的连接数量等)

--set tcp tcpfin udp 设置连接超时值

--start-daemon 启动同步守护进程。他后面可以是master 或backup,用来说明LVS Router 是master 或是backup。在这个功能上也可以采用keepalived 的VRRP 功能。

--stop-daemon 停止同步守护进程

-h --help 显示帮助信息

-p --persistent [timeout] 持久稳固的服务(持久性连接)。这个选项的意思是来自同一个客户的多次请求,将被同一台真实的服务器处理。timeout 的默认值为360 秒。

-t --tcp-service service-address 说明虚拟服务器提供的是tcp 的服务[vip:port] or [real-server-ip:port]

-f --fwmark-service fwmark 说明是经过iptables 标记过的服务类型。

-u --udp-service service-address 说明虚拟服务器提供的是udp 的服务[vip:port] or [real-server-ip:port]

-s --scheduler scheduler 使用的调度算法,有这样几个选项 rr|wrr|lc|wlc|lblc|lblcr|dh|sh|sed|nq,默认的调度算法是: wlc.

-M --netmask netmask persistent granularity mask

-r --real-server server-address 真实的服务器[Real-Server:port]

-g --gatewaying 指定LVS 的工作模式为DR直接路由模式(也是LVS 默认的模式)

-i --ipip 指定LVS 的工作模式为隧道模式

-m --masquerading 指定LVS 的工作模式为NAT 模式

-w --weight weight 真实服务器的权值

--mcast-interface interface 指定组播的同步接口

-c --connection 显示LVS 目前的连接 如:ipvsadm -L -c

--timeout 显示tcp tcpfin udp 的timeout 值 如:ipvsadm -L --timeout

--daemon 显示同步守护进程状态

--stats 显示统计信息

--rate 显示速率信息

--sort 对虚拟服务器和真实服务器排序输出

-n --numeric 输出IP地址和端口的数字形式