版权声明:本文为博主原创文章,未经博主允许不得转载。 https://blog.csdn.net/selfimpro_001/article/details/91128662

中文分词-即将中文汉字序列切分成一个一个单独的词语,中文分词是NLP的第一步。源自-《NLP汉语自然语言处理原理与实践》

一. pyltp

- 安装pyltp:

pip3 install -i https://pypi.tuna.tsinghua.edu.cn/simple pyltp

- 部署语言模型库:

具体部署方法参考:哈工大语言云(LTP)本地安装使用及Python调用

模型:链接: https://pan.baidu.com/s/1tmPUMMFPBgzXbm8JbMIyYg 提取码: uy11

二. jieba

这个是本人最常用的分词方法

三. StanfordfordNLP

四. HanLP

五. 分词标准

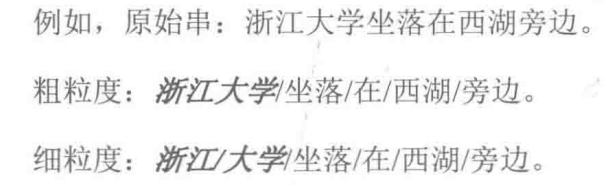

- 粗粒度分词:将词作为语言处理的最小的基本单位进行切分,主要用于NLP中的各种应用中;

- 细粒度分词: 不仅对词汇进行切分,也对词汇内部的语素进行切分。一般细粒度切分的对象为专有名词,因为专有名词常表现为几个一般名词的合成。常用于搜索引擎领域中。

- 一般在索引的时候使用细粒度的分词保证召回率,在查询的时候使用粗粒度分词保证精度。

- 举例:

六. 歧义切分

- 针对上面的问题出现的早起的机械分词系统:该方法是基于最大匹配方法作为最基本的分词算法,也称为MM(The Maximum Matching Method)。基本思想:

举例如下:

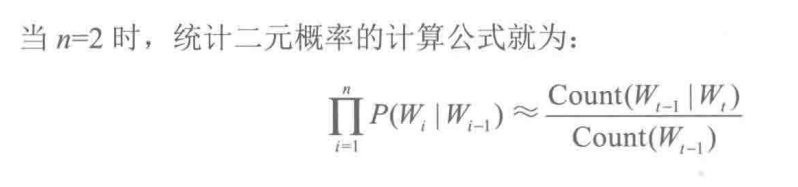

- 上下文相关性:文本中第n个词的出现与其前后第n-m到n+m个词有高度的相关性,而与这个范围之外的其他词的相关性较低,把[-m, m]范围也称为窗口范围。

七. 未登录词识别