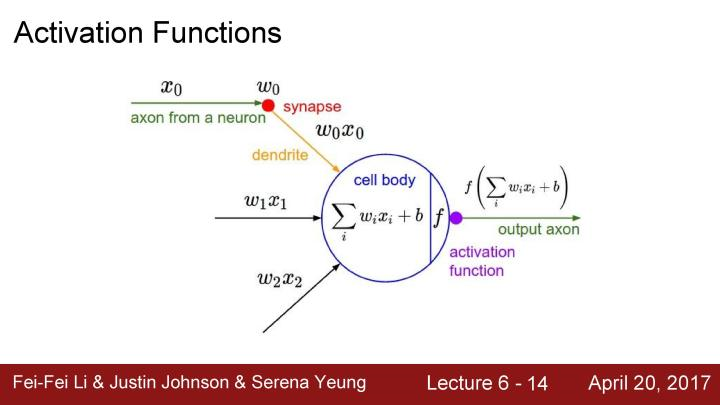

在上一个lecture中,我们看到了任意特定层是如何生成输出的,输入数据在全连接层或者卷积层,将输入乘以权重值,之后将结果放入一个激活函数(非线性单元)

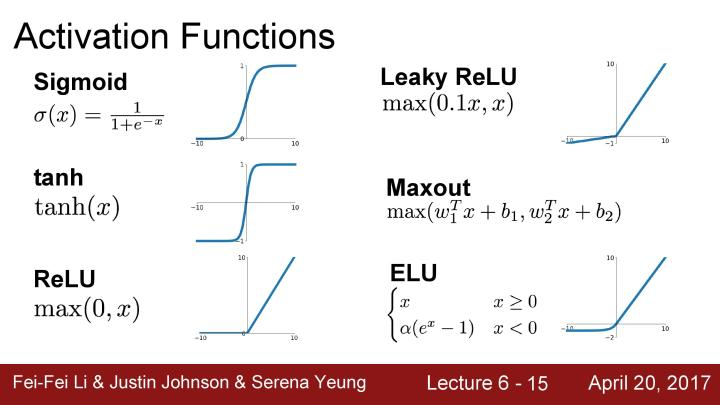

下面是一些激活函数的例子,有在之前使用过的sigmoid函数,之前提及到的ReLU函数。这里会提及更多的激活函数,并在它们之间进行权衡。

先是之前见过的sigmoid函数,每一个元素输入到sigmoid非线性函数中,并被压缩到0-1范围内。如果有一个非常大的输入值,那么输出结果将会非常接近1;如果有一个非常小的负值,那么输出结果将会非常接近于0。在横坐标接近于0的区域中,可以将这部分看成是线性区域,因为这有点线性函数。sigmoid函数曾经非常流行,因为它在某种意义上可以被看成是一种神经元的饱和“firing rate(放电率)"。当更为深入研究这个非线性函数,实际上它存在着几个问题。首先是饱和的神经元将会使得梯度消失。

未完。。