MLP-多层感知器即反向传播算法

1. Introduction

MLP 是多层感知器组织起来的, 克服了单层感知器的缺点,可以学习非线性映射,包括大量非线性决策平面,但是要引入非线性激活函数不然多层还是线性的(只是多个单层的级联).

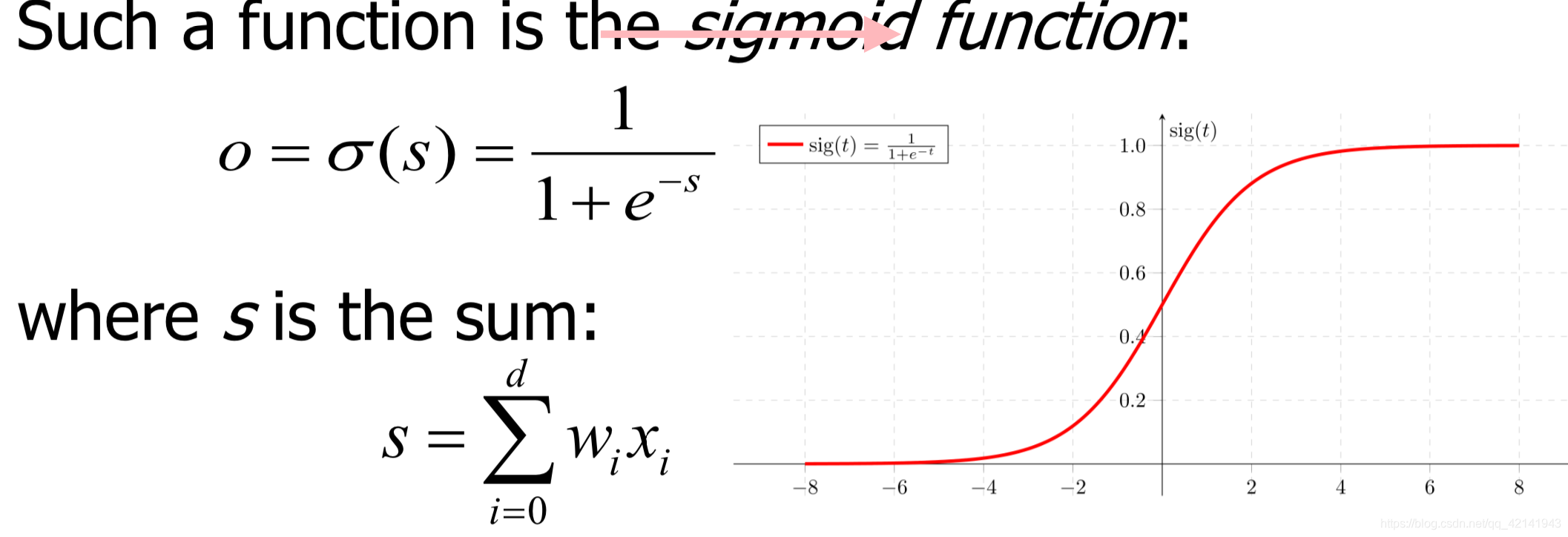

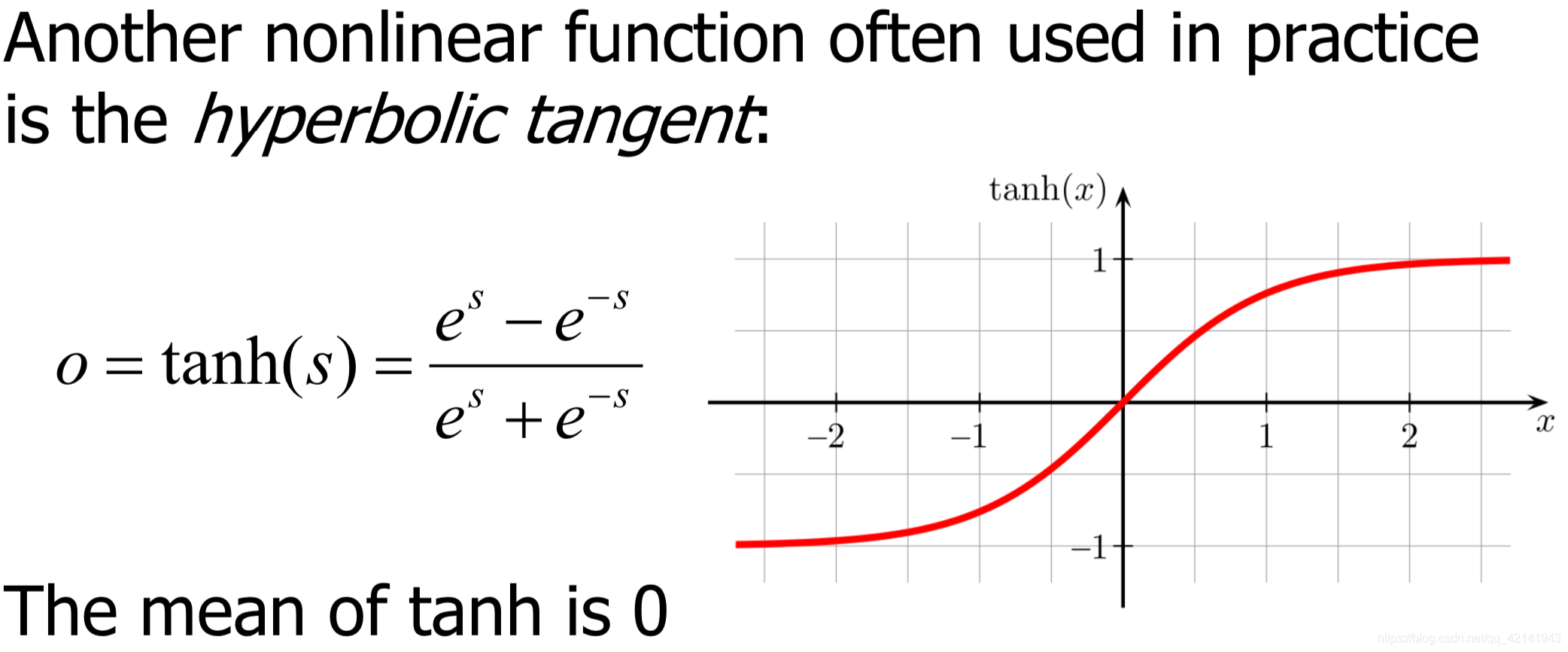

2. 激活函数

多层感知器用的梯度下降而不是感知器学习法则,因此激活函数一定要是可微的. 综合来说激活函数要是***连续可微的非线性方程***

2.1 Sigmoid Function

2.2 Hyperbolic Tangent:

两者的区别在于sigmoid无负输出,tanh有负输出

从这里可以看出如果在这里用sigmoid和Hebb’s algorithm 则权重会无止境的增加

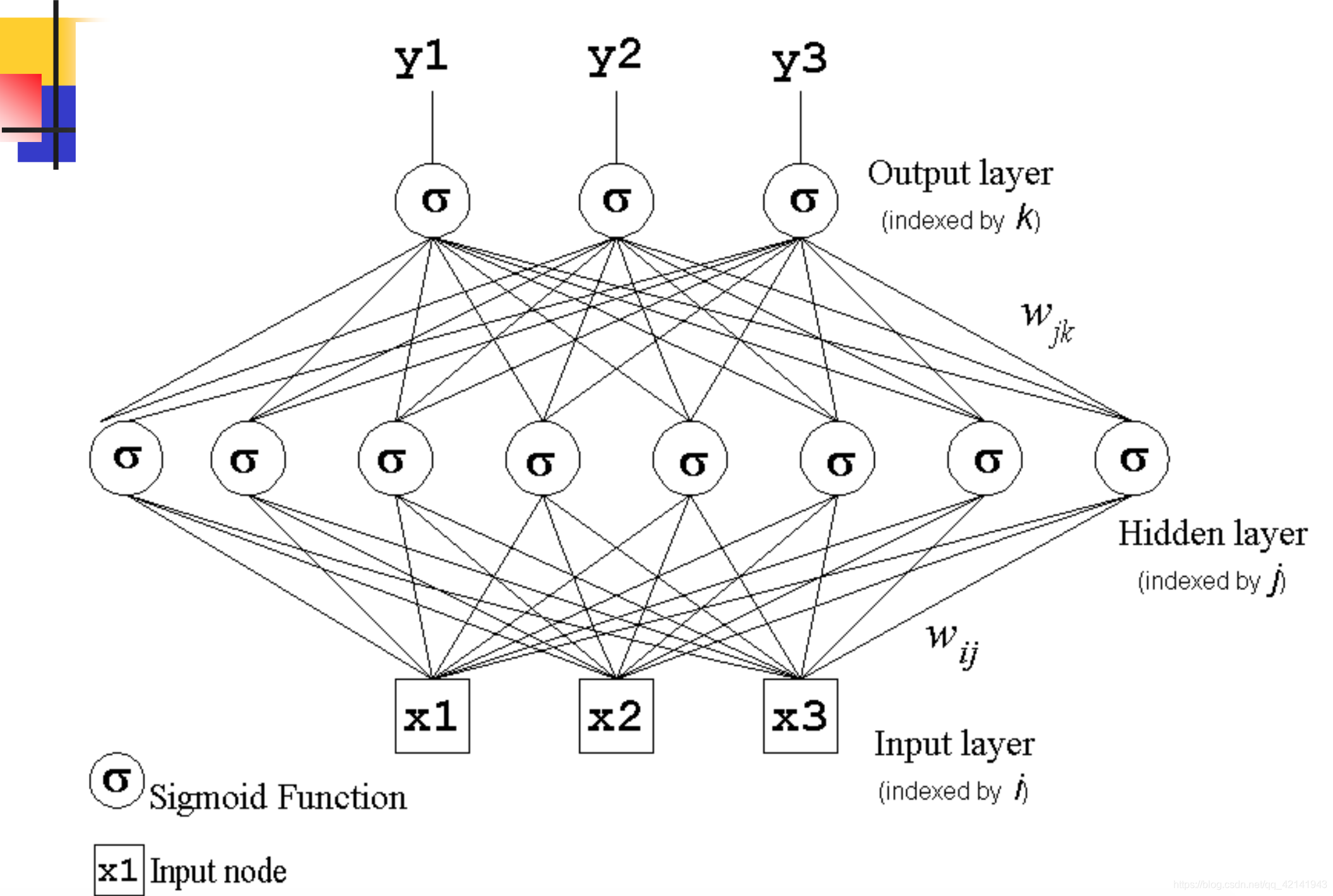

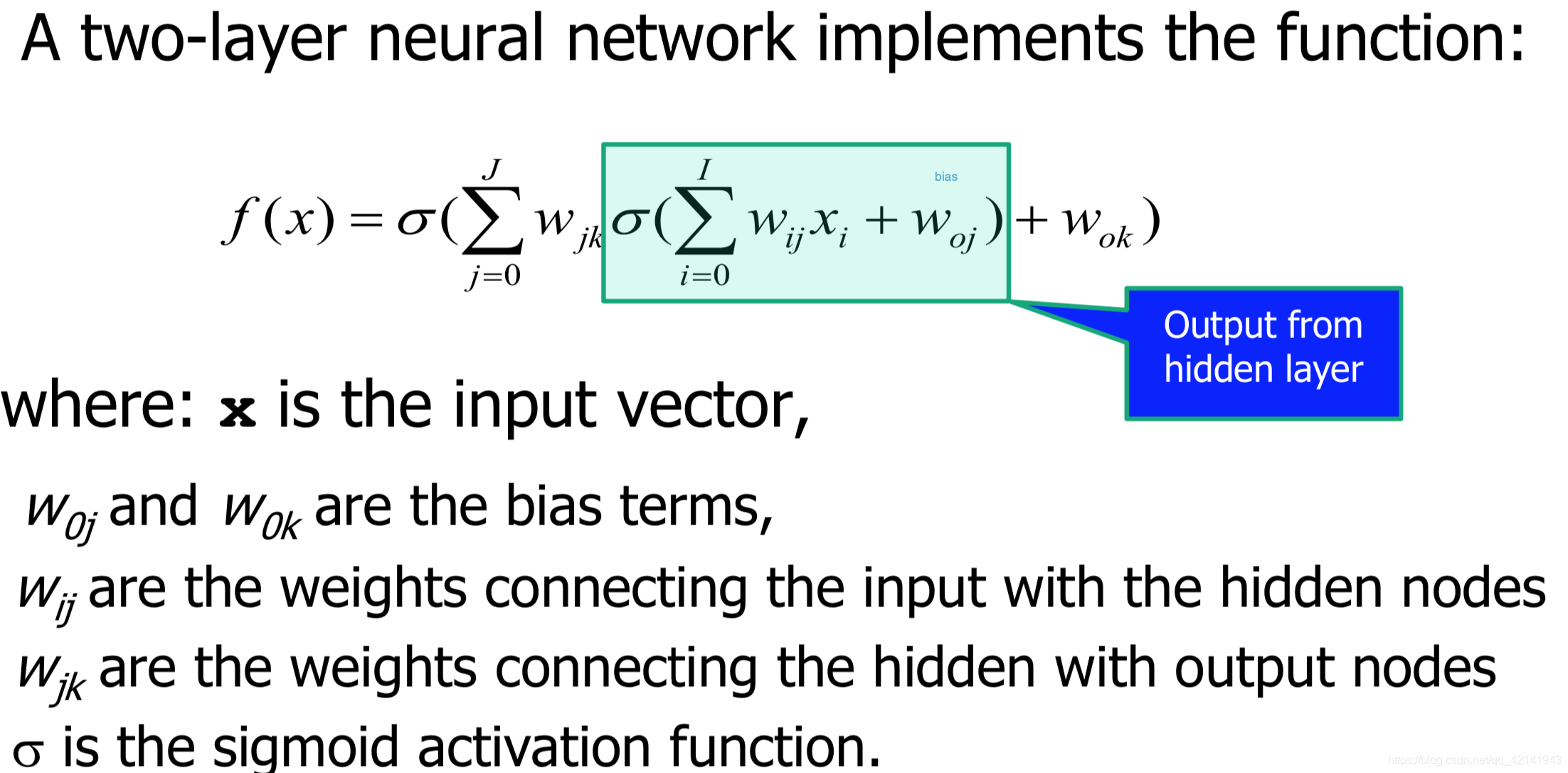

2.3 Muti-Layer Perceptrons 的网络架构及输出

MLP 架构的特点:

- The hidden units enable the multilayer network to learn complex tasks by extracting progressively more meaningful information from the input examples

隐藏单元允许输出渐进的从输入提取有用的信息 - MLP 高度拓扑关系因为隐藏单元也是全连接的

- 输入信号沿着网络向前一层一层的传递因此也叫做

The hidden units enable the multilayer network to learn complex tasks by extracting progressively more meaningful information from the input examples

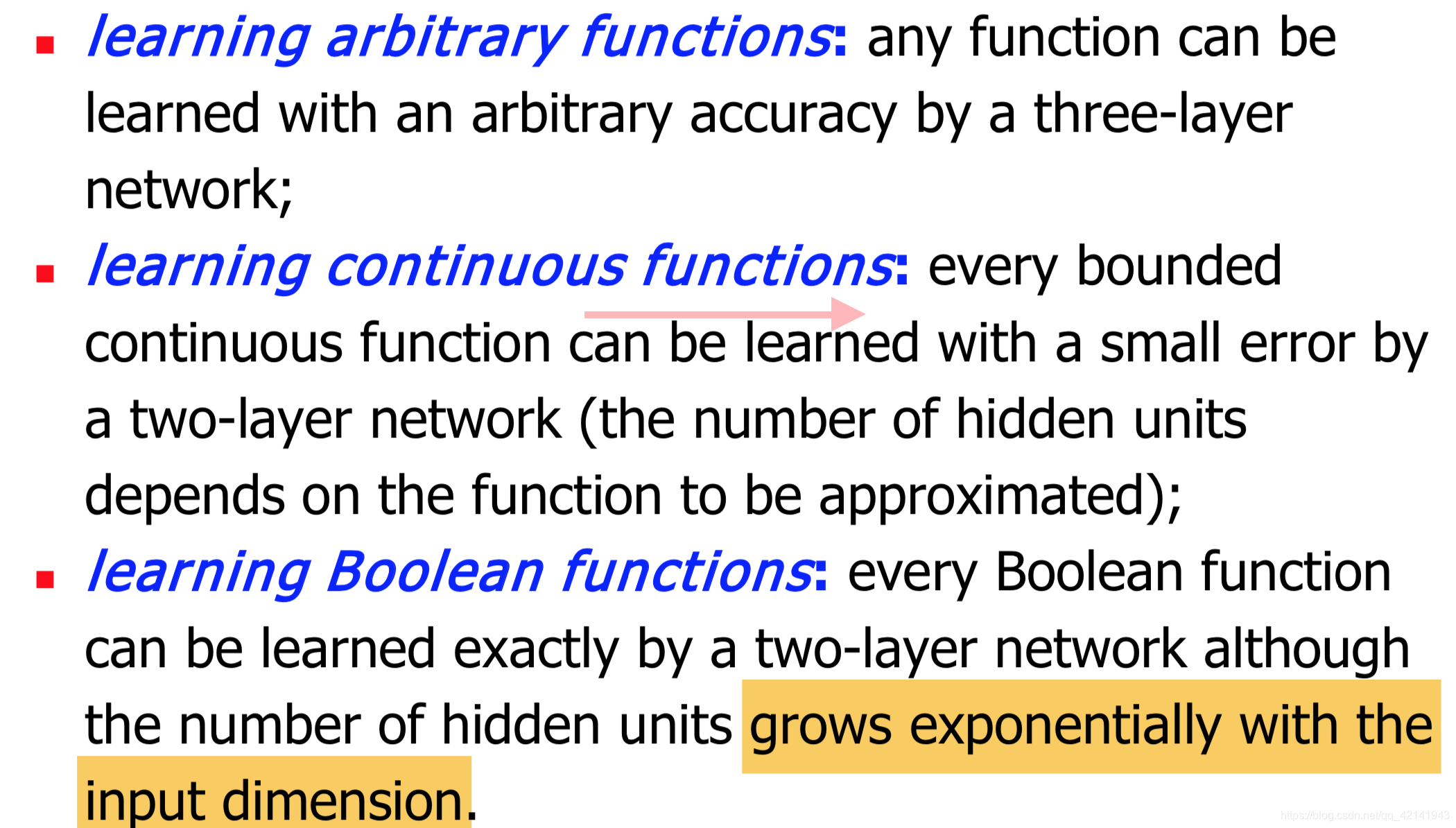

2.4 MLP 网络的功能(Representive Power)

2. Back propagation

2.1 Introduction

与之前的梯度下降来说,梯度下降仍然是基础但是由于网络变成了多层算法也变了

MLP 变得可应用在发现了监督学习算法之后- error backpropagation learning algorithm

Error backpropagation learning algorithm 有两部

- Fowared pass

- Backward pass

2.2 Algorithm

-

Initialization:

-

Foward:

-

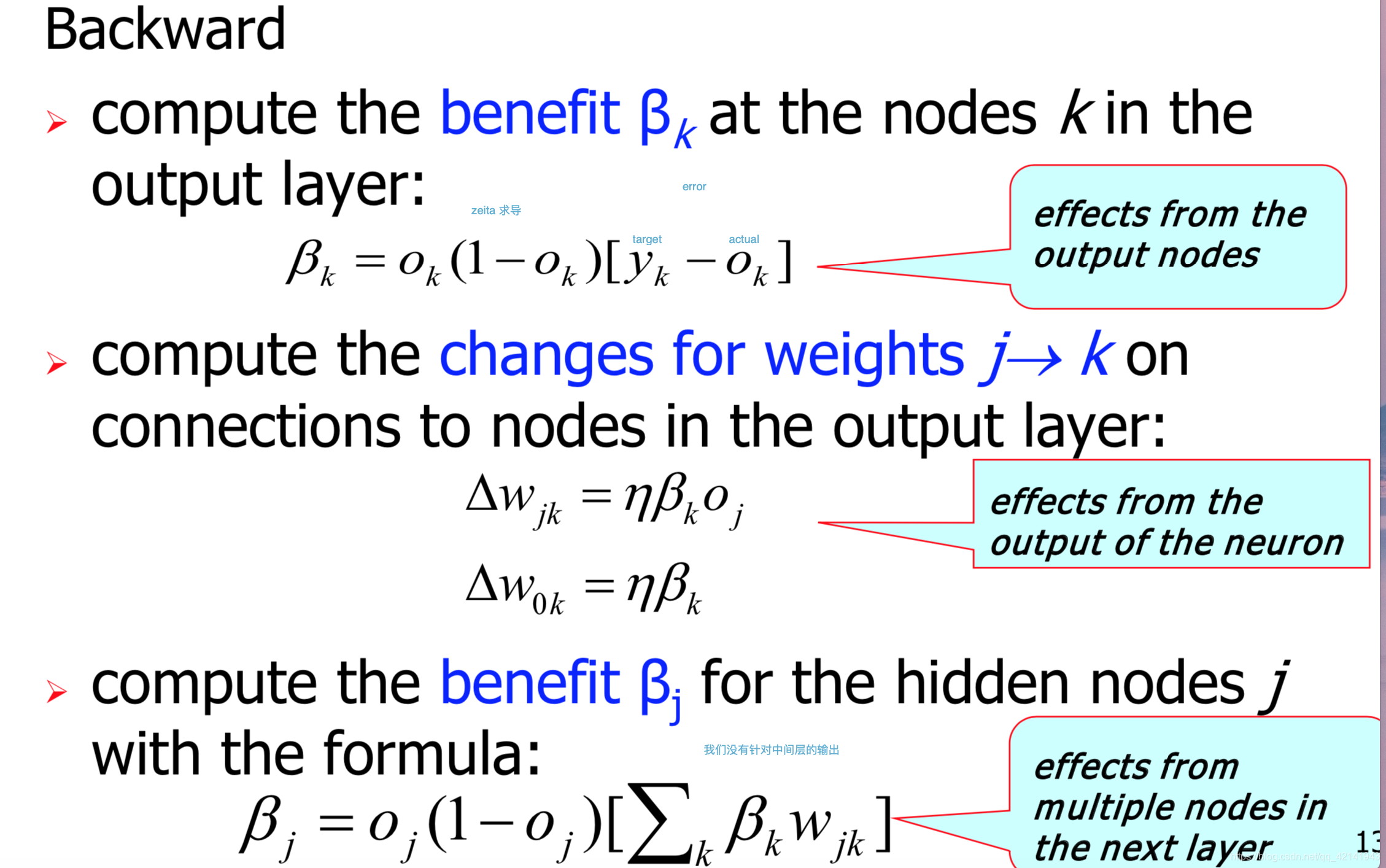

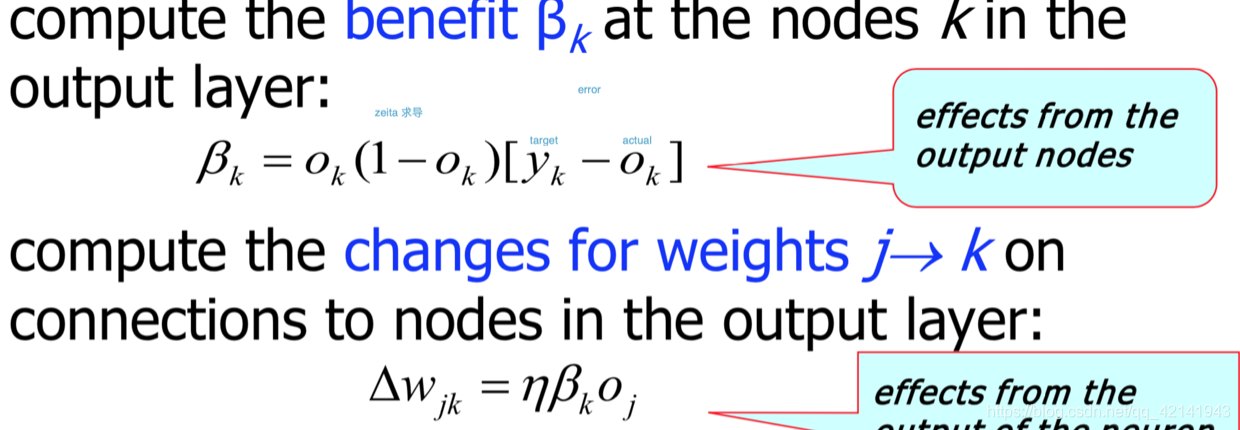

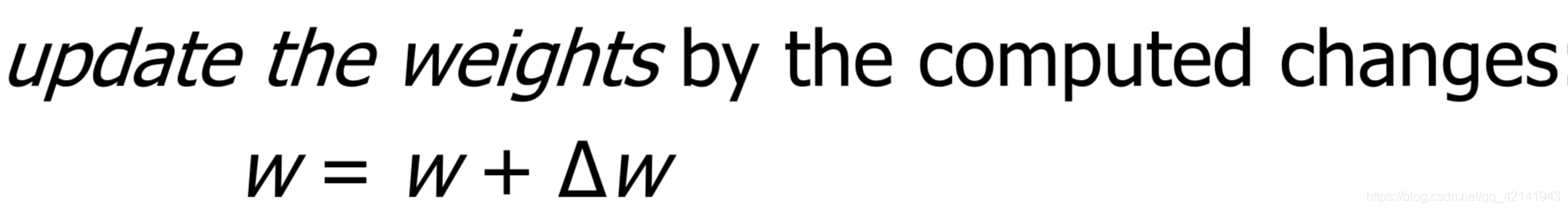

Backward:

-

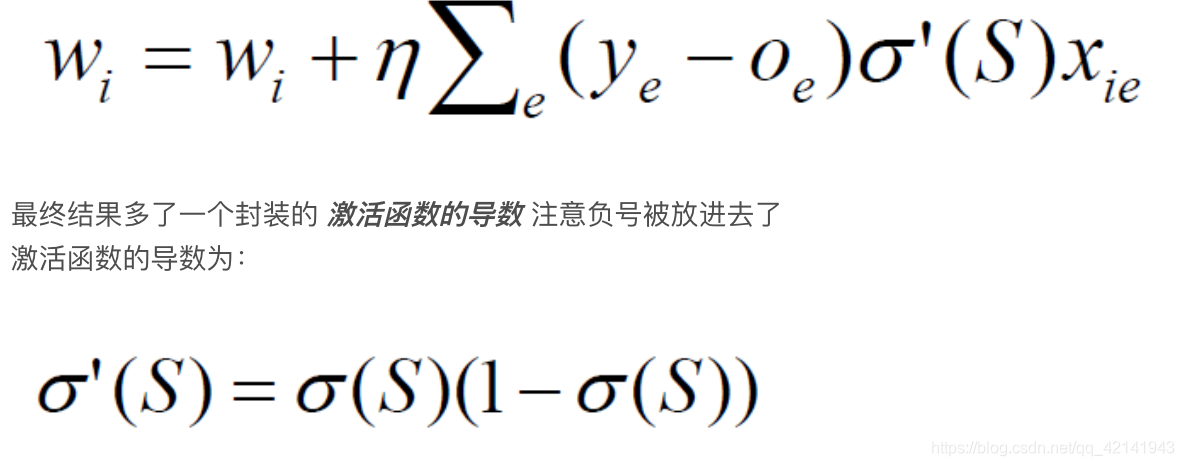

注意输出层Bk这一步和梯度递减完全一样

-

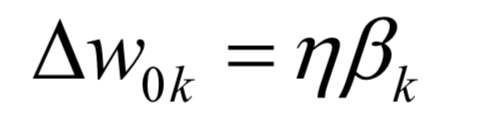

输出层Bias的更新

因为输入为1 -

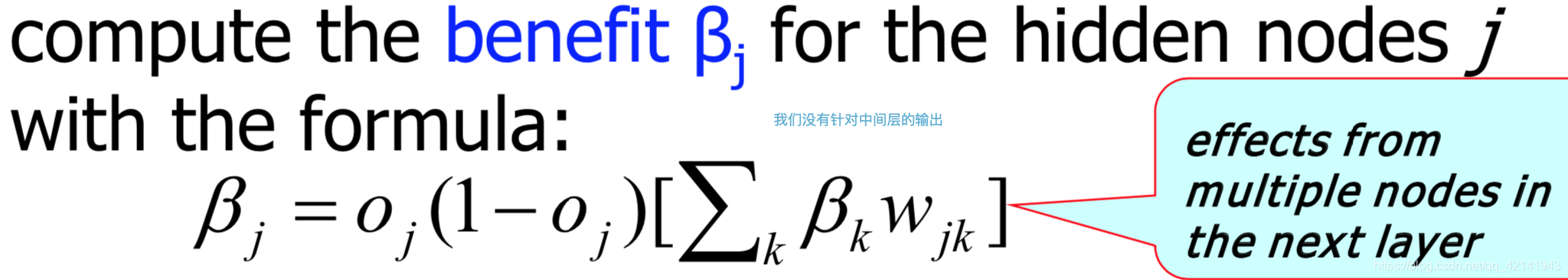

隐藏层Bj的计算与之前不同了因为这一层没有(yj-oj)中的yj即标准输出

用每一个和这个隐层层单元相连的输出层的B以及相连的权重的乘积的和作为(yj-oj)

-

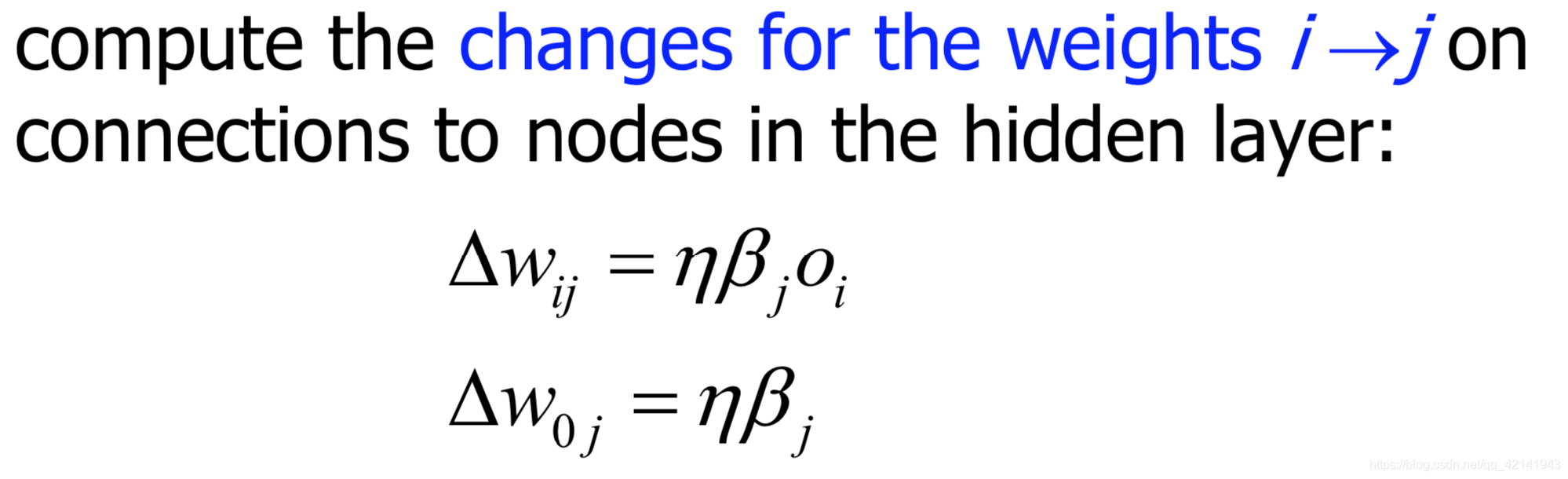

其它的和之前的完全相同

-

Termination:

2.3 Revision of Epoch/ Batch Learning

From mathematical point of view the error derivatives should be computed after each epoch, i.e., after all examples in the training set have been processed.

Batch Learning 用更好的理论依据 theoterical motivation

Incremental Learning 可能获得更好的结果并且更常用

在这里Batch 等于 Epoch的话Batch size=all data size, iteration=epoch.