spark提交脚本

-

如何阅读

首先,从官网下载spark源代码(也许是github),导入idea。我下载的是2.4.6的,据说3.0改成gradle了,反正我是没看3.0。

一般看源码从demo开始缕,看了下bin目录,的确有run-example,可惜我不想看。。。。。。

从使用上说一般都是spark-shell或者spark-submit,所以消停的看spark-submit吧! -

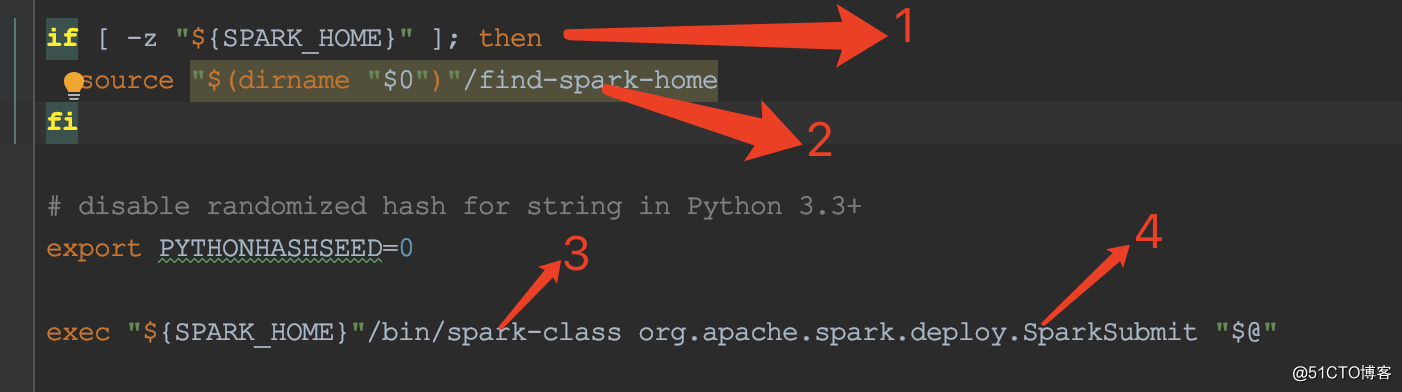

spark-submit脚本

- 验证SPARK_HOME是否存在

- 如果不存在,查找当前目录下的find-spark-home脚本,设置SPARK_HOME环境变量

- 运行spark-class脚本

- 在原有参数之前添加org.apache.spark.deploy.SparkSubmit参数

-

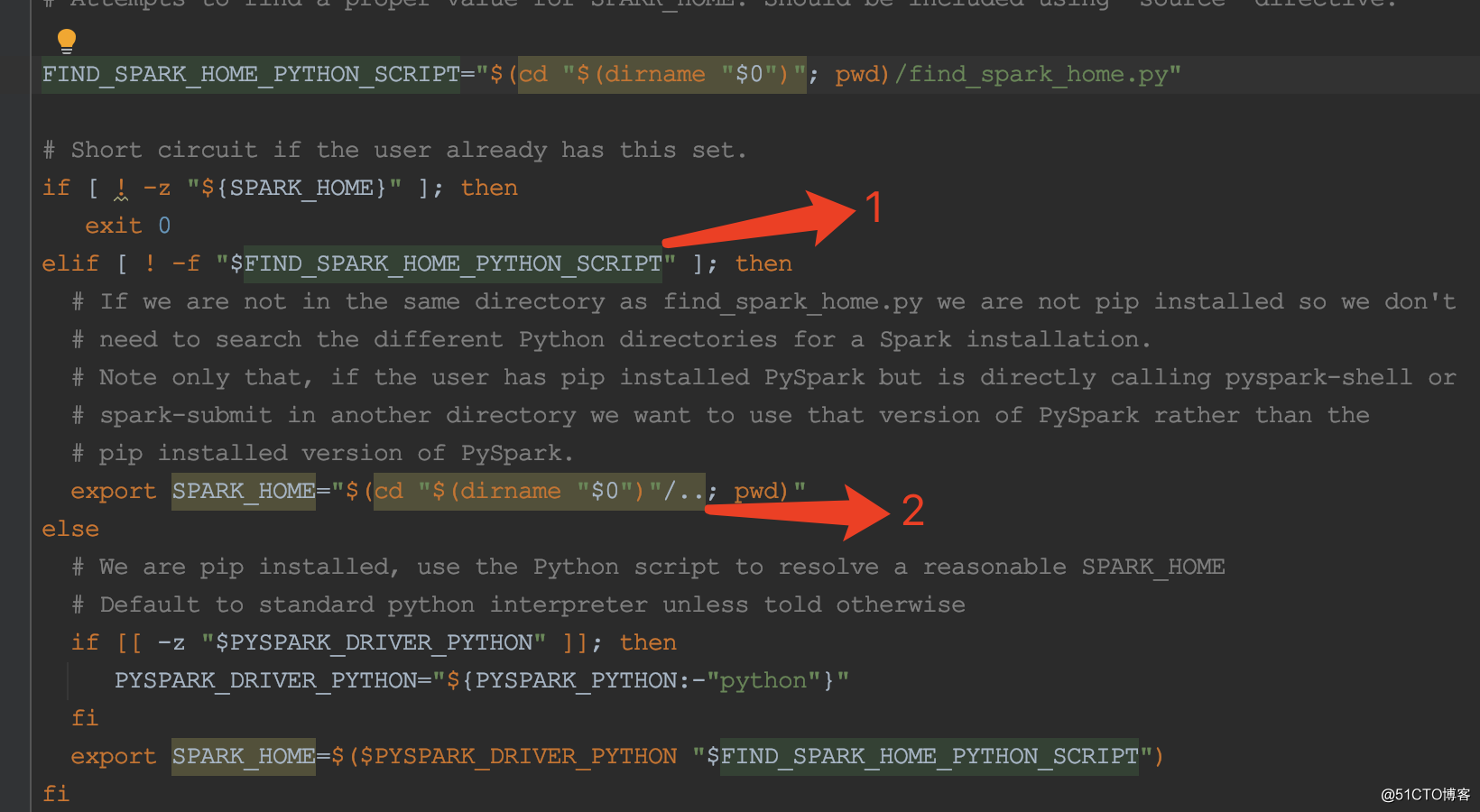

find-spark-home脚本

- 验证find_spark_home.py是否存在,下方的英文描述写的很明白了,不通过pip install pyspark安装,不会有这个目录,所以默认没有。

- 设置SPARK_HOME为bin目录的上级目录

-

spark-class脚本

太长了,且听下回!!!