声明:语音合成论文优选系列主要分享论文,分享论文不做直接翻译,所写的内容主要是我对论文内容的概括和个人看法。如有转载,请标注来源。

欢迎关注微信公众号:低调奋进

Towards Universal Text-to-Speech

本文是中国微软在interspeech 2020发表的关于通用语音合成系统的文章,可以灵巧的扩展新的speaker和language,具体文章链接

https://www.isca-speech.org/archive/Interspeech_2020/pdfs/1590.pdf

1 研究背景

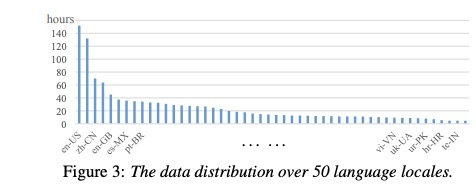

这篇文章主要研究通用性tts,即多语言和多说话人共用一个模型(本文实验1250小时数据,50种语言)。为了解决语言之间和说话人之间的数据不平衡问题,本文采用数据采样策略来优化数据较少的语言数据或者说话人数据。另外本系统可以更灵活的扩展新的语言和说话人。

2 详细设计

本文的系统结构如下图1所示,其中主要包括encoder-decoder模块,speaker network和language netowrk, neural vocoder。其中语言的音素集合是相互独立,即每种语言一个单独的音素表。图2展示,即使不同语言的音素不放在一起,但发音相似的音素会聚在一起。另外本文的重点是解决数据的不平衡,如公式1所示,对每个batch数据进行抽样,其概率需要添加参数α 控制,其中α ∈ [0, 1].(本文取值0.2)

3 实验

实验数据为1250小时50种语言的数据,每种语言多少如图3分布。table1展示了通用tts的mos值,在多数据情况稍微差单语言模型,但少数据的话由于单语言模型。table2和table3展示跨语言合成,图表展示自然度和相似度的测试结果。table4和table5展示添加新的说话者的实验。table6和table7显示添加新的语言的效果,使用本文的策略比使用单然较好。

4 总结

其实本文主要使用采样策略解决数据不平衡的问题,对于少数据量的语言和说话人tts是好处。(对于具有充足数据的单人tts,我个人感觉使用通用tts会造成音质下降,本文的实验也给出了验证,因此想在生产环境使用通用性tts不现实)