介绍

数值积分(Numerical integration)是科学计算的一项基础技术,是许多计算机视觉应用的核心。在这些应用中,隐式神经体积渲染(implicit neural volume rendering)最近被提出作为一种新的视图合成范式,以实现逼真的图像质量。然而,使这些方法实用的一个根本障碍是极端的计算(computational)和内存(memory)需求,这是由于在训练和推理过程中沿着渲染光线所需要的体积积分所引起的。需要数以百万计的射线,每条射线都需要通过神经网络的数百次前向传播,才能用蒙特卡罗采样来近似这些积分。

在这里,我们提出自动积分(automatic integration),这是一个新的框架,使用隐式神经表示网络,学习高效的,闭式解求积分。对于训练,我们实例化与隐式神经表示的导数相对应的计算图。将图形拟合到信号上进行积分。优化后,我们将图重新组合,得到一个表示不定积分的网络。根据微积分基本定理,这使得计算任意定积分在两次计算网络时都是可行的。使用这种方法,我们证明了在计算需求上超过10倍的改进,实现了快速的神经体积渲染。

网络结构设计

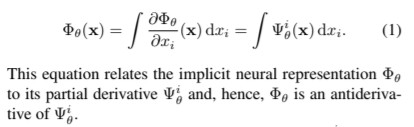

本文的变量 Φ \Phi Φ和 Ψ \Psi Ψ的关系定义如下:

隐式神经表示通常基于多层感知器(MLP),或全连接的架构。 文中把和 Φ \Phi Φ相关的网络称为积分网络(integral network),把和 Ψ \Psi Ψ相关的网络称为梯度网络(grad network)。

首先选择积分网络的MLP结构的细节(层数、特征数、非线性类型),根据积分网络可以得到梯度网络。本文开发了一个自定义的AutoDiff框架,跟踪整体网络,并显式实例化相应的grad网络,同时维护共享参数。一旦实例化,grad网络的参数将使用传统的自动比较和优化工具来优化以适应感兴趣的信号。Loss函数和定积分计算公式如下:

结果

压缩感知计算机断层扫描的AutoInt示例。左:参数化的说明。中心:用不同非线性激活函数的积分网络计算的重线图。(GT) sinogram 4×(上)、8×(中)和16×(下)的角度下采样。优化后的网络被用来插值缺失的测量值。使用Swish激活在这些实验中表现最好。右:sinogram中心的一维扫描线显示了每种方法在每个子抽样水平下的插值行为。

体积渲染的视频结果见http://www.computationalimaging.org/publications/automatic-integration/