一、ELK与EFK架构

日志主要包括系统日志、应用程序日志和安全日志。系统运维和开发人员可以通过日志了解服务器软硬件信息、检查配置过程中的错误及错误发生的原因。经常分析日志可以了解服务器的负荷,性能安全性,从而及时采取措施纠正错误。

通常,日志被分散的储存不同的设备上。如果你管理数十上百台服务器,你还在使用依次登录每台机器的传统方法查阅日志。这样是不是感觉很繁琐和效率低下。当务之急我们使用集中化的日志管理,例如:开源的syslog,将所有服务器上的日志收集汇总。

集中化管理日志后,日志的统计和检索又成为一件比较麻烦的事情,一般我们使用grep、awk和wc等Linux命令能实现检索和统计,但是对于要求更高的查询、排序和统计等要求和庞大的机器数量再去使用这些方法就比较的麻烦了。

那你们想过这种方式的问题吗?

1. 日志量太大如何归档、文本搜索太慢怎么办、如何多维度查询。

2. 应用太多,面临数十上百台应用时你该怎么办。

3. 随意登录服务器查询log对系统的稳定性及安全性肯定有影响。

4. 如果使用人员对Linux不太熟练那面对庞大的日志简直要命。

开源实时日志分析ELK平台能够完美的解决我们上述的问题。

ELK又能给我们解决哪些问题呢?

1. 日志统一收集,管理,访问。查找问题方便安全。

2. 使用简单,可以大大提高定位问题的效率。

3. 可以对收集起来的log进行分析。

4. 能够提供错误报告,监控机制。

1、核心组成

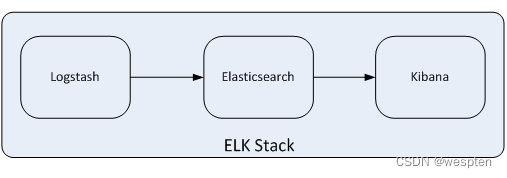

ELK是一个应用套件,由Elasticsearch、Logstash和Kibana三部分组件组成,简称ELK;它是一套开源免费、功能强大的日志分析管理系统。ELK可以将我们的系统日志、网站日志、应用系统日志等各种日志进行收集、过滤、清洗,然后进行集中存放并可用于实时检索、分析。

这三款软件都是开源软件,通常是配合使用,而且又先后归于Elastic.co公司名下,故又被简称为ELK Stack。

下图是ELK Stack的基础组成:

2、ElasticSearch简介

ElasticSearch是一个实时的分布式搜索和分析引擎,它可以用于全文搜索,结构化搜索以及分析,有点像hdfs。采用Java语言编写,可以实现数据内容存储、检索、排序、查询、报表统计、生成等功能,日志的分析以及存储全部由ElasticSearch完成。

目前,最新的版本是Elasticsearch 6.3.2,它的主要特点如下:

1)实时搜索,实时分析;

2)分布式架构、实时文件存储,并将每一个字段都编入索引;

3) 文档导向,所有的对象全部是文档;

4) 高可用性,易扩展,支持集群(Cluster)、分片和复制(Shards和Replicas);

5) 接口友好,支持JSON;

高扩展性体现在拓展非常简单,新的节点,基本无需做复杂配置自动发现节点。高可用性呢,因为这个社区是分布式的,而且是一个实时搜索平台,支持PB级的大数据搜索能力。从一个文档到这个文档被搜索到呢,只有略微的延迟,所以说他的实时性非常高。

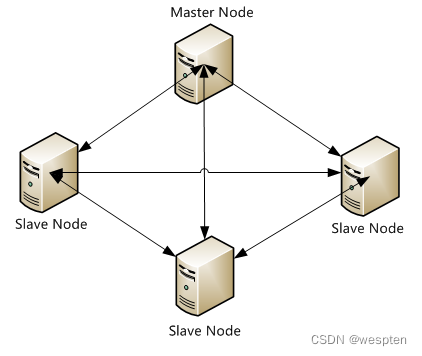

Elasticsearch支持集群架构,典型的集群架构如下图所示:

从图中可以看出,Elasticsearch集群中有Master Node和Slave Node两种角色,其实还有一种角色Client Node。

3、Logstash简介

Logstash是一款轻量级的、开源的日志收集处理框架,它可以方便的把分散的、多样化的日志搜集起来,日志内容包括内核日志、系统日志、安全日志、应用程序(Apache、Nginx、MYSQL、Redis、Tomcat)日志等,并进行自定义过滤分析处理,然后传输到指定的位置,比如某个服务器、文件,或者通过内置的ElasticSearch插件解析后输出到ES服务器中。

Logstash采用JRuby语言编写,目前最新的版本是Logstash 6.3.2,它的主要特点如下:

Logstash的理念很简单,从功能上来讲,它只做三件事情:

1)input:数据收集;

2)filter:数据加工,如过滤,改写等;

3)output:数据输出;

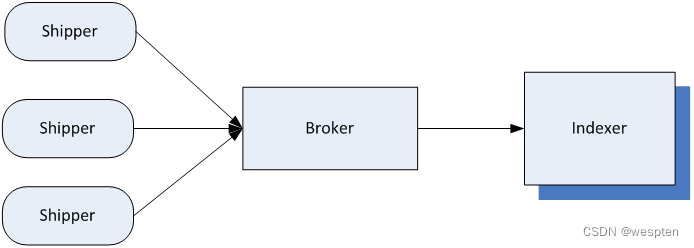

别看它只做三件事,但通过组合输入和输出,可以变幻出多种架构实现多种需求。Logstash内部运行逻辑如下图所示:

其中,每个部分含义如下:

1)Shipper:主要用来收集日志数据,负责监控本地日志文件的变化,及时把日志文件的最新内容收集起来,然后经过加工、过滤,输出到Broker。

2)Broker:相当于日志Hub,用来连接多个Shipper和多个Indexer。

3)Indexer:从Broker读取文本,经过加工、过滤,输出到指定的介质(可以是文件、网络、elasticsearch等)中。

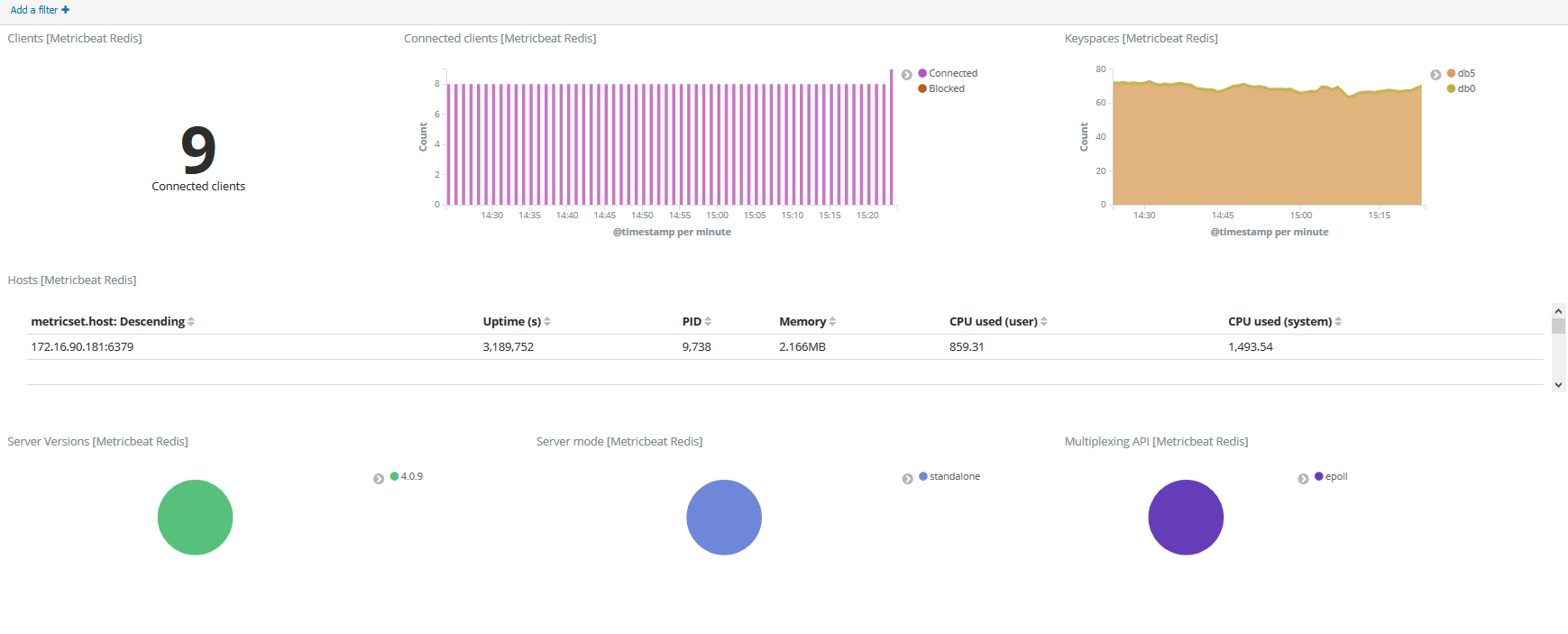

Redis服务器是logstash官方推荐的broker,这个broker起数据缓存的作用,通过这个缓存器可以提高Logstash shipper发送日志到Logstash indexer的速度,同时避免由于突然断电等导致的数据丢失。可以实现broker功能的还有很多软件,例如kafka等。

这里需要说明的是,在实际应用中,LogStash自身并没有什么角色,只是根据不同的功能、不同的配置给出不同的称呼而已,无论是Shipper还是Indexer,始终只做前面提到的三件事。

这里需要重点掌握的是logstash中Shipper和Indexer的作用,因为这两个部分是logstash功能的核心。

4、Kibana简介

Kibana是一个开源的数据分析可视化平台,这也解决了用mysql存储带来了难以可视化的问题。主使用Kibana可以为Logstash和ElasticSearch提供的日志数据进行高效的搜索、可视化汇总和多维度分析,还可以与Elasticsearch搜索引擎之中的数据进行交互。

它提供一套WEB UI界面,可以快速创建动态仪表板,实时监控ElasticSearch的数据状态与更改,方便用户和管理人员对ES的数据进行可视化操作、配置、数据分析、统计(如果没有WEB界面,只能靠命令行操作)。

5、ELK使用场景

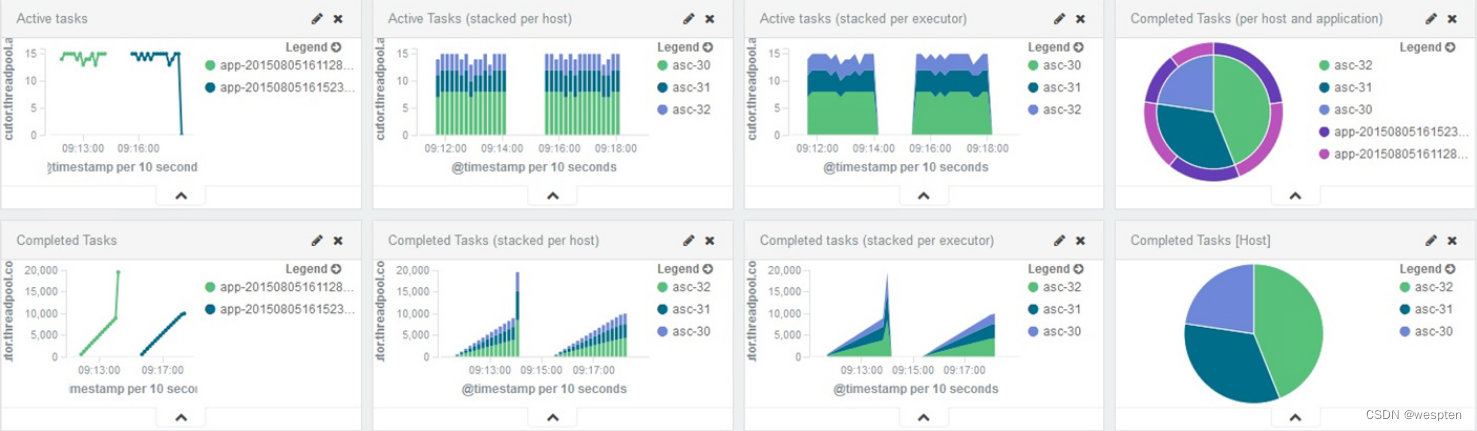

通过ELK组件可以对Spark作业运行状态监控,搜集Spark环境下运行的日志。经过筛选、过滤并存储可用信息,从而完成对Spark作业运行和完成状态进行监控,实时掌握集群状态,了解作业完成情况,并生成报表,方便运维人员监控和查看。

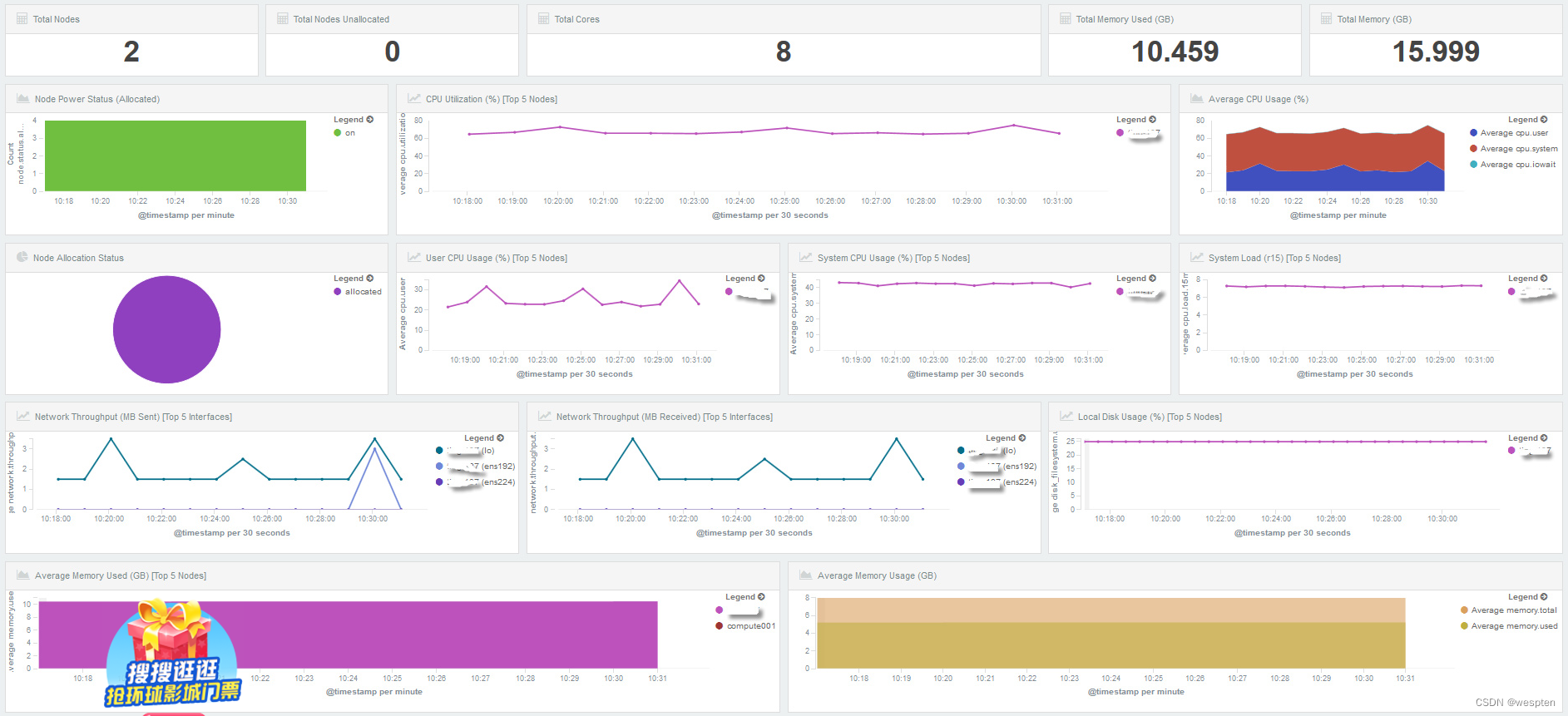

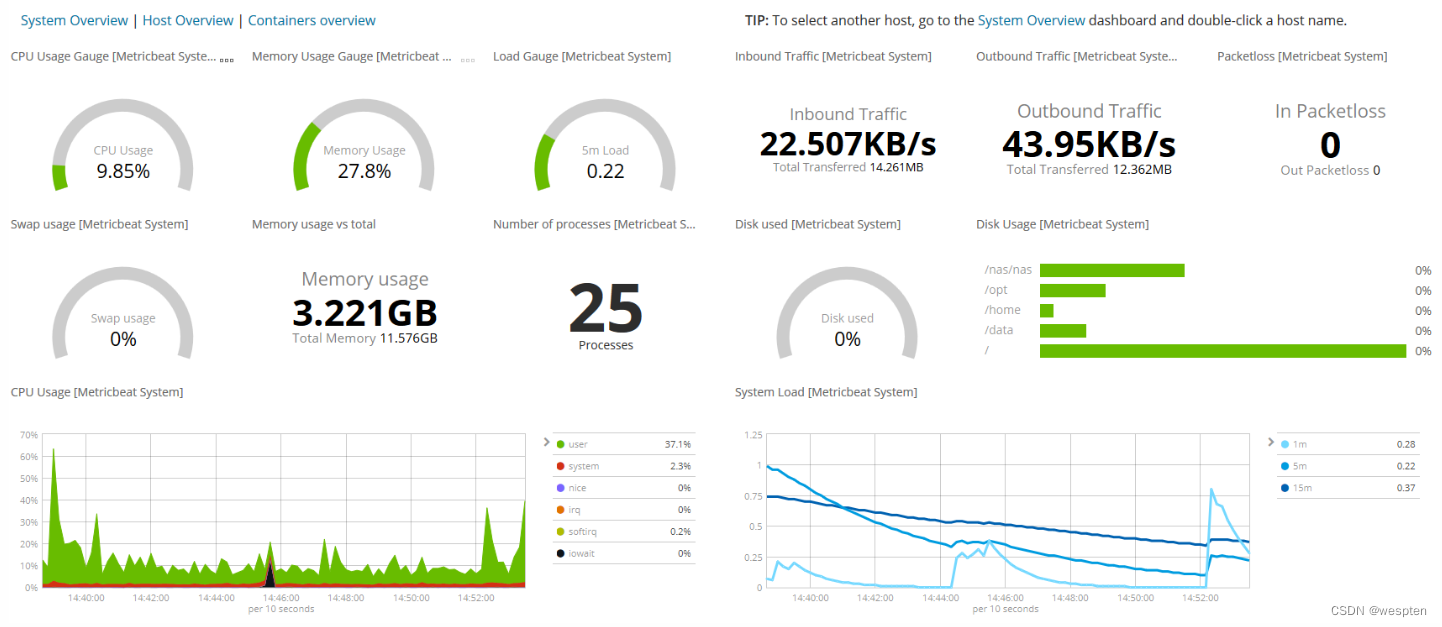

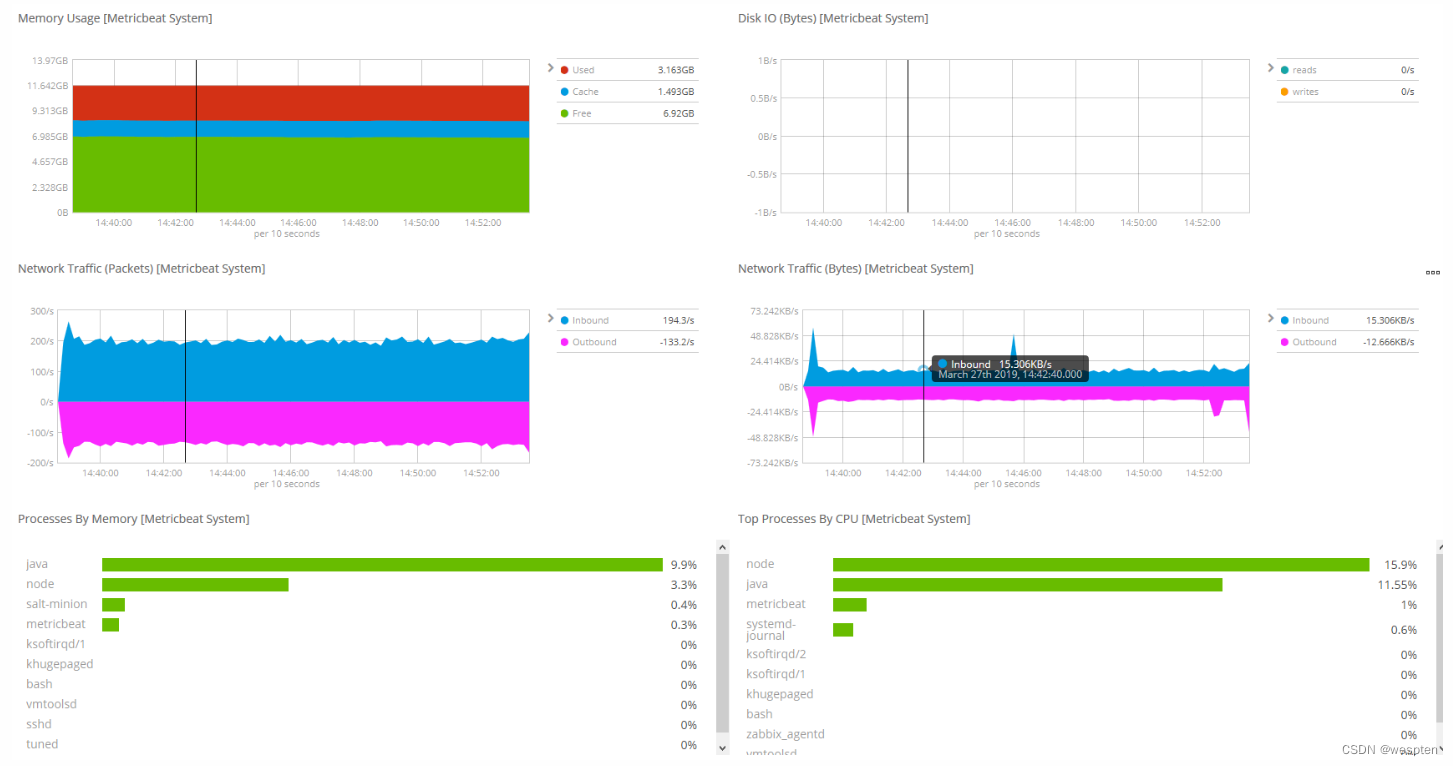

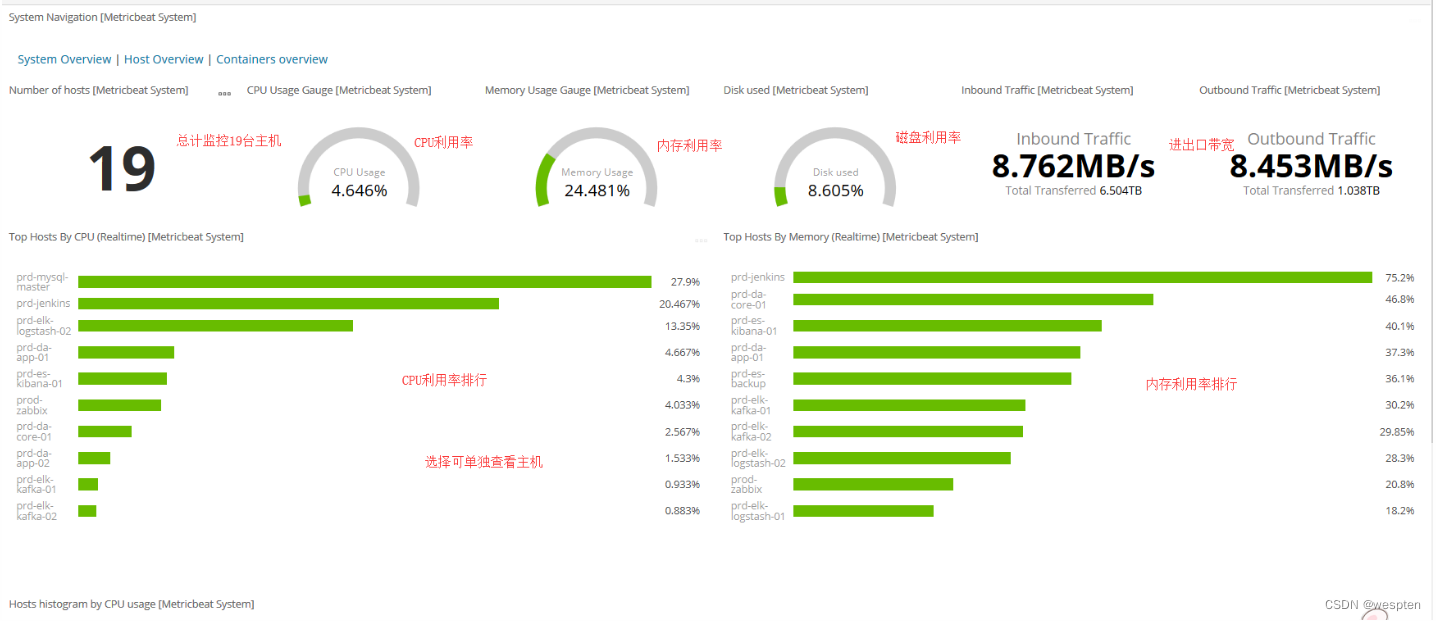

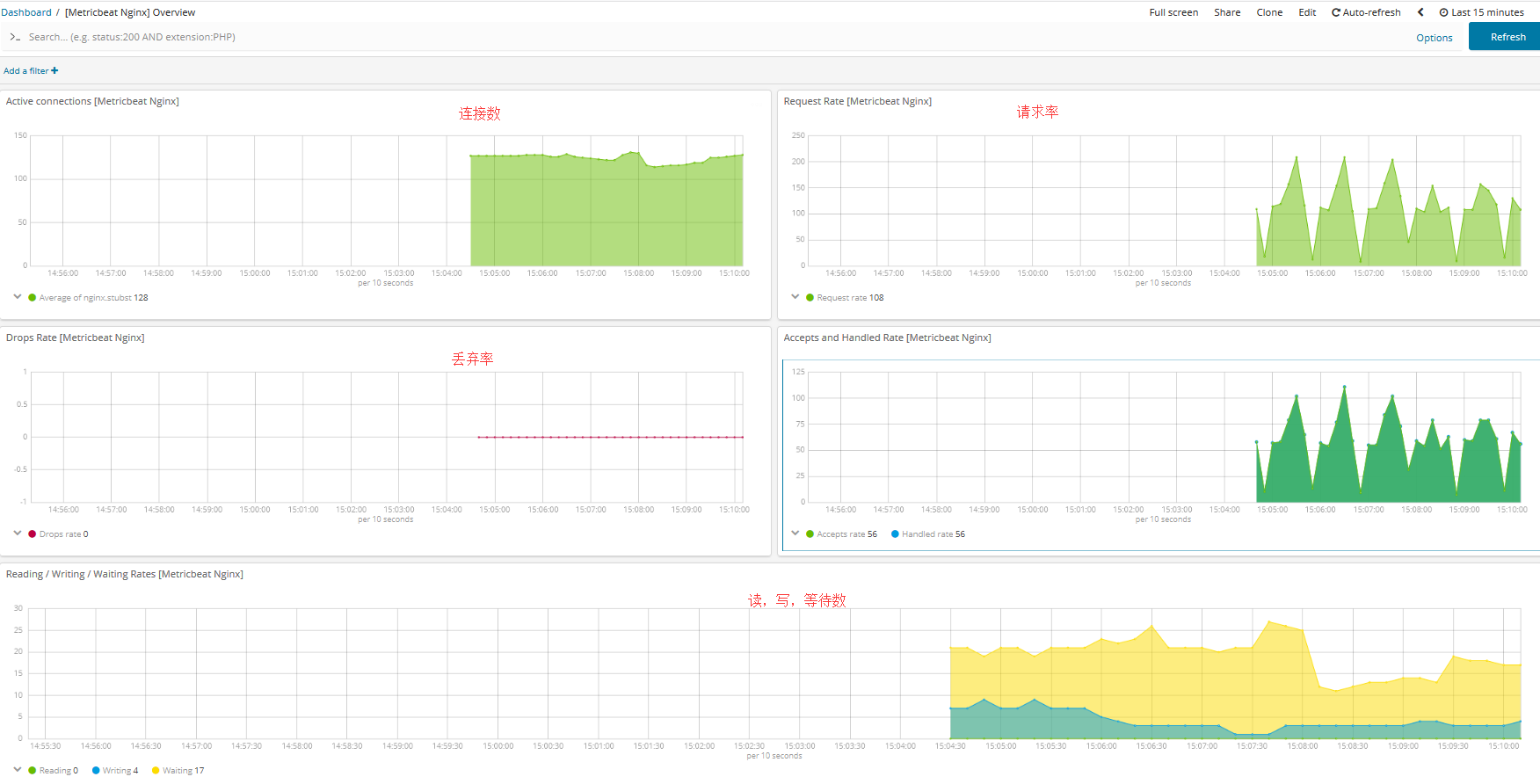

也可以通过ELK组件对系统资源状态监控,通过各类日志搜集,分析,过滤,存储并通过Kibana展现给用户,供用户实时监控系统资源、节点状态、磁盘、CPU、MEM,以及错误、警告信息等。

也通过ELK组件对系统负载状态监控:

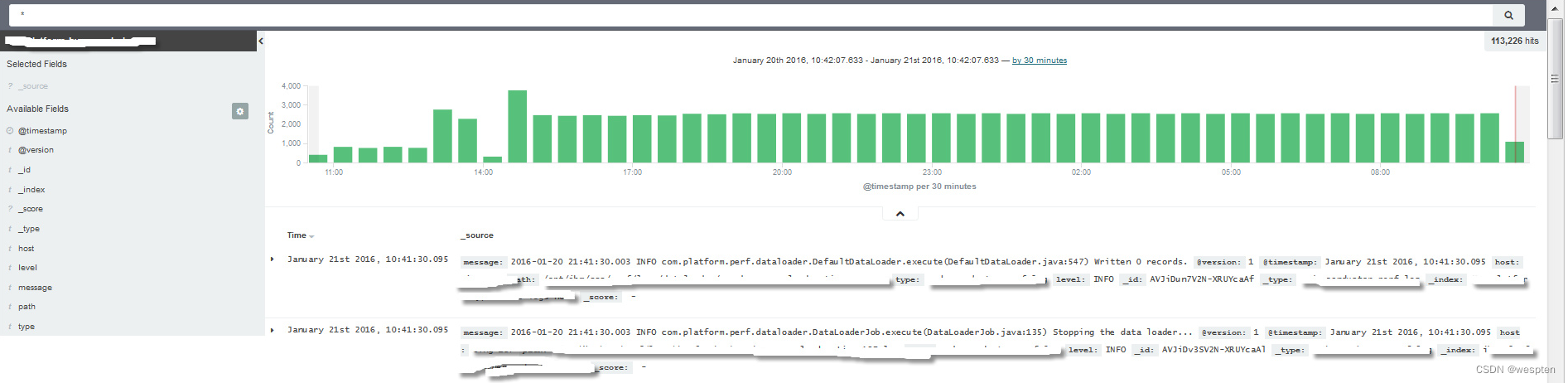

还可以通过ELK组件对系统日志管理和故障排查。用户可根据故障发生时间段集中查询相关日志,可通过搜索、筛选、过滤等功能,快速定位问题,从而排查故障。另外,通过对各个应用组件的日志过滤,可快速列举出各个应用对应节点上的Error或Warning日志,从而对故障排查或者对发现产品bug提供快捷途径。

6、ELK工作流程

数据来源可以是各式各样的日志,Logstash配置文件有三个主要模块:input()输入或者说收集数据,定义数据来源;filter()对数据进行过滤,分析等操作;output()输出。

数据源搜集到后,然后通过filter过滤形成固定的数据格式。目前支持过滤的类JSON、grep、grok、geoip等,最后output到数据库,比如Redis、Kafka或者直接传送给Elasticsearch,当数据被存储于Elasticsearch之后,用户可以使用Elasticsearch所提供API来检索信息数据了.

如果通过REST API执行CURL GET请求搜索指定数据。用户也可以使用Kibana进行可视化的数据浏览。另外Kibana有时间过滤功能,运维人员可对某一时间段内数据查询并查看报表,方便快捷。

ELK工作流程图:

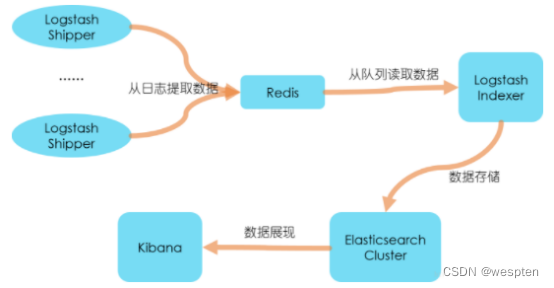

一般都是在需要收集日志的所有服务上部署logstash,作为logstash shipper用于监控并收集、过滤日志,接着,将过滤后的日志发送给Broker,然后,Logstash Indexer将存放在Broker中的数据再写入Elasticsearch,Elasticsearch对这些数据创建索引,最后由Kibana对其进行各种分析并以图表的形式展示。

有些时候,如果收集的日志量较大,为了保证日志收集的性能和数据的完整性,logstash shipper和logstash indexer之间的缓冲器(Broker)也经常采用kafka来实现。

在这个图中,要重点掌握的是ELK架构的数据流向,以及logstash、Elasticsearch和Kibana组合实现的功能细节。

ELK有两种安装方式:

(1) 集成环境:Logstash有一个集成包,里面包括了其全套的三个组件;也就是安装一个集成包。

(2) 独立环境:三个组件分别单独安装、运行、各司其职。(比较常用)

7、简单的ELK应用架构

此架构主要是将Logstash部署在各个节点上搜集相关日志、数据,并经过分析、过滤后发送给远端服务器上的Elasticsearch进行存储。Elasticsearch再将数据以分片的形式压缩存储,并提供多种API供用户查询、操作。用户可以通过Kibana Web直观的对日志进行查询,并根据需求生成数据报表。

此架构的优点是搭建简单,易于上手。缺点是Logstash消耗系统资源比较大,运行时占用CPU和内存资源较高。另外,由于没有消息队列缓存,可能存在数据丢失的风险。此架构建议供初学者或数据量小的环境使用。

8、典型ELK架构

引入Kafka消息队列:

引入Redis消息队列:

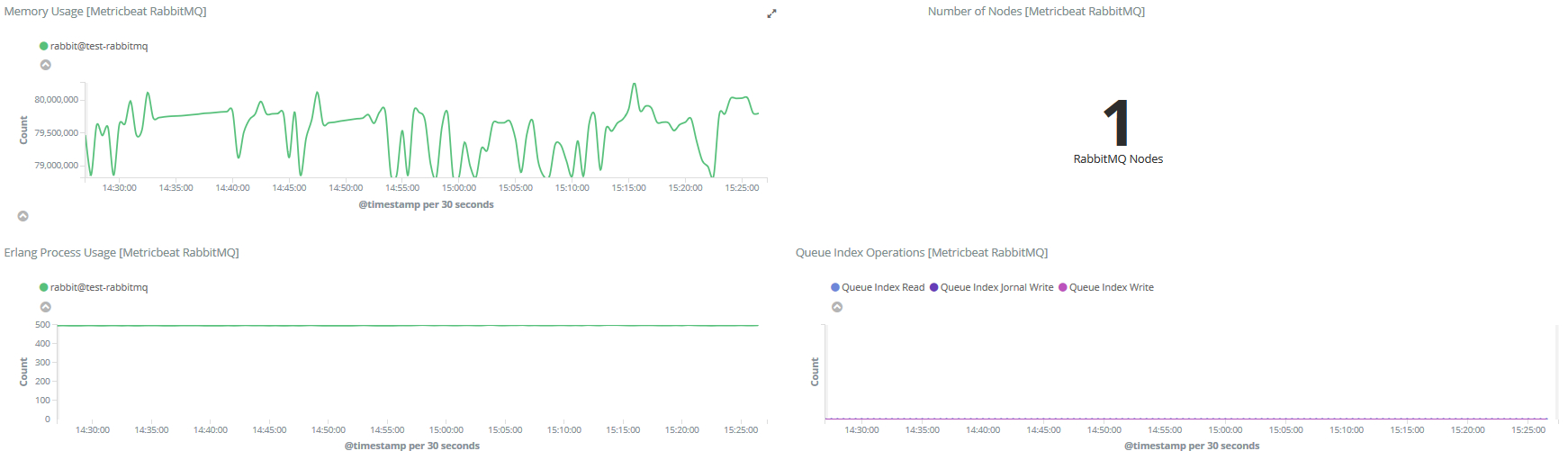

此架构主要特点是引入了消息队列机制,位于各个节点上的Logstash Agent(一级Logstash,主要用来传输数据)先将数据传递给消息队列(常见的有Kafka、Redis等),接着,Logstash server(二级Logstash,主要用来拉取消息队列数据,过滤并分析数据)将格式化的数据传递给Elasticsearch进行存储。最后,由Kibana将日志和数据呈现给用户。由于引入了Kafka(或者Redis)缓存机制,即使远端Logstash server因故障停止运行,数据也不会丢失,因为数据已经被存储下来了。

这种架构适合于较大集群、数据量一般的应用环境,但由于二级Logstash要分析处理大量数据,同时Elasticsearch也要存储和索引大量数据,因此它们的负荷会比较重,解决的方法是将它们配置为集群模式,以分担负载。

此架构的优点在于引入了消息队列机制,均衡了网络传输,从而降低了网络闭塞尤其是丢失数据的可能性,但依然存在Logstash占用系统资源过多的问题,在海量数据应用场景下,可能会出现性能瓶颈。

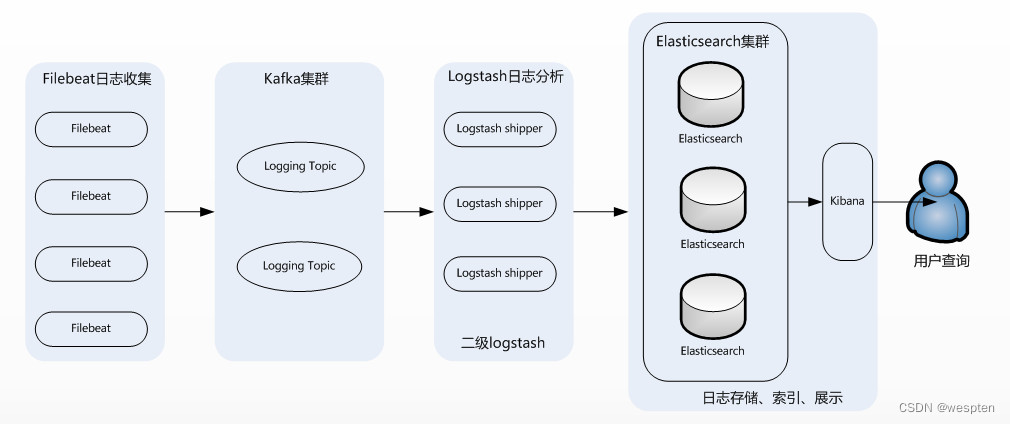

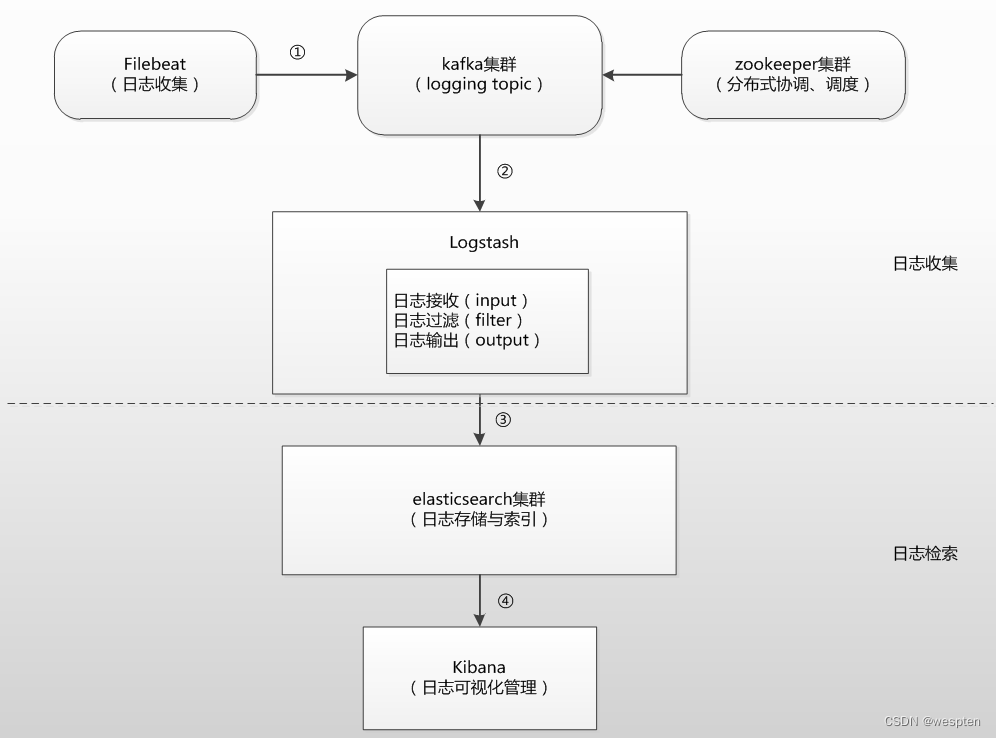

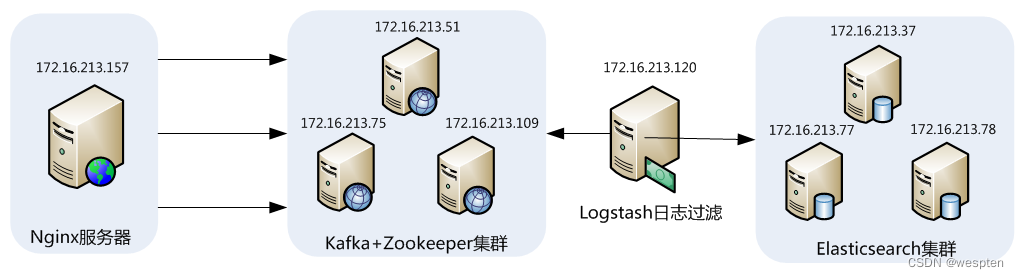

9、EFK集群架构

这个架构是在上面第二个架构基础上改进而来的,主要是将前端收集数据的Logstash Agent换成了filebeat,消息队列使用了kafka集群,然后将Logstash和Elasticsearch都通过集群模式进行构建,此架构适合大型集群、海量数据的业务场景,它通过将前端Logstash Agent替换成filebeat,有效降低了收集日志对业务系统资源的消耗。

经测试得出,相比Logstash,Logstash-forwarder所占用系统CPU和MEM几乎可以忽略不计。另外,Logstash-forwarder和Logstash间的通信是通过SSL加密传输,起到了安全保障。如果是较大集群,用户亦可以如结构三那样配置logstash集群和Elasticsearch集群,引入High Available机制,提高数据传输和存储安全。更主要的配置多个Elasticsearch服务,有助于搜索和数据存储效率。

同时,消息队列使用kafka集群架构,有效保障了收集数据的安全性和稳定性,而后端Logstash和Elasticsearch均采用集群模式搭建,从整体上提高了ELK系统的高效性、扩展性和吞吐量。

但在此种架构下发现Logstash-forwarder和Logstash间通信必须由SSL加密传输,这样便有了一定的限制性。

10、Beat+ELK架构

第四种架构将Logstash-forwarder替换为Beats。经测试,Beats满负荷状态所耗系统资源和Logstash-forwarder相当,但其扩展性和灵活性有很大提高。

Beats platform目前包含有Packagebeat、Topbeat和Filebeat、Metricbeat等产品,均为Apache 2.0 License,用户可根据需要进行二次开发。

这种架构原理基于第三种架构,但是更灵活,扩展性更强。同时可配置Logstash 和Elasticsearch 集群用于支持大集群系统的运维日志数据监控和查询。

不管采用上面哪种ELK架构,都包含了其核心组件,即:Logstash、Elasticsearch 和Kibana。当然这三个组件并非不能被替换,只是就性能和功能性而言,这三个组件已经配合的很完美,是密不可分的。各系统运维中究竟该采用哪种架构,可根据现实情况和架构优劣而定。

11、ELK在大数据运维系统中的应用

在海量日志系统的运维中,以下几个方面是必不可少的:

-

分布式日志数据集中式查询和管理

-

系统监控,包含系统硬件和应用各个组件的监控

-

故障排查

-

安全信息和事件管理

-

报表功能

ELK组件各个功能模块如下图所示,它运行于分布式系统之上,通过搜集、过滤、传输、储存,对海量系统和组件日志进行集中管理和准实时搜索、分析,使用搜索、监控、事件消息和报表等简单易用的功能,帮助运维人员进行线上业务的准实时监控、业务异常时及时定位原因、排除故障、程序研发时跟踪分析Bug、业务趋势分析、安全与合规审计,深度挖掘日志的大数据价值。同时Elasticsearch提供多种API(REST JAVA PYTHON等API)供用户扩展开发,以满足其不同需求。

汇总ELK组件在大数据运维系统中,主要可解决的问题如下:

-

日志查询,问题排查,上线检查

-

服务器监控,应用监控,错误报警,Bug管理

-

性能分析,用户行为分析,安全漏洞分析,时间管理

综上,ELK组件在大数据运维中的应用是一套必不可少的且方便、易用的开源解决方案。

二、Zookeeper架构

1、ZooKeeper简介

在介绍ZooKeeper之前,先来介绍一下分布式协调技术,所谓分布式协调技术主要是用来解决分布式环境当中多个进程之间的同步控制,让他们有序的去访问某种共享资源,防止造成资源竞争(脑裂)的后果。

这里首先介绍下什么是分布式系统,所谓分布式系统就是在不同地域分布的多个服务器,共同组成的一个应用系统来为用户提供服务,在分布式系统中最重要的是进程的调度,这里假设有一个分布在三个地域的服务器组成的一个应用系统,在第一台机器上挂载了一个资源,然后这三个地域分布的应用进程都要竞争这个资源,但我们又不希望多个进程同时进行访问,这个时候就需要一个协调器,来让它们有序的来访问这个资源。

这个协调器就是分布式系统中经常提到的那个“锁”。

例如"进程1"在使用该资源的时候,会先去获得这把锁,"进程1"获得锁以后会对该资源保持独占,此时其它进程就无法访问该资源,"进程1"在用完该资源以后会将该锁释放掉,以便让其它进程来获得锁。由此可见,通过这个“锁”机制,就可以保证分布式系统中多个进程能够有序的访问该共享资源。这里把这个分布式环境下的这个“锁”叫作分布式锁。这个分布式锁就是分布式协调技术实现的核心内容。

综上所述,ZooKeeper是一种为分布式应用所设计的高可用、高性能的开源协调服务,它提供了一项基本服务:分布式锁服务,同时,也提供了数据的维护和管理机制,如:统一命名服务、状态同步服务、集群管理、分布式消息队列、分布式应用配置项的管理等等。

2、ZooKeeper应用举例

这里以ZooKeeper提供的基本服务分布式锁为例进行介绍。在分布式锁服务中,有一种最典型应用场景,就是通过对集群进行Master角色的选举,来解决分布式系统中的单点故障问题。所谓单点故障,就是在一个主从的分布式系统中,主节点负责任务调度分发,从节点负责任务的处理,而当主节点发生故障时,整个应用系统也就瘫痪了,那么这种故障就称为单点故障。

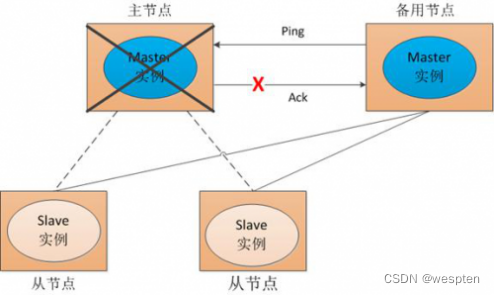

解决单点故障,传统的方式是采用一个备用节点,这个备用节点定期向主节点发送ping包,主节点收到ping包以后向备用节点发送回复Ack信息,当备用节点收到回复的时候就会认为当前主节点运行正常,让它继续提供服务。而当主节点故障时,备用节点就无法收到回复信息了,此时,备用节点就认为主节点宕机,然后接替它成为新的主节点继续提供服务。

这种传统解决单点故障的方法,虽然在一定程度上解决了问题,但是有一个隐患,就是网络问题,可能会存在这样一种情况:主节点并没有出现故障,只是在回复ack响应的时候网络发生了故障,这样备用节点就无法收到回复,那么它就会认为主节点出现了故障。

接着,备用节点将接管主节点的服务,并成为新的主节点,此时,分布式系统中就出现了两个主节点(双Master节点)的情况,双Master节点的出现,会导致分布式系统的服务发生混乱。这样的话,整个分布式系统将变得不可用。为了防止出现这种情况,就需要引入ZooKeeper来解决这种问题。

3、ZooKeeper工作原理

下面通过三种情形,介绍下Zookeeper是如何进行工作的。

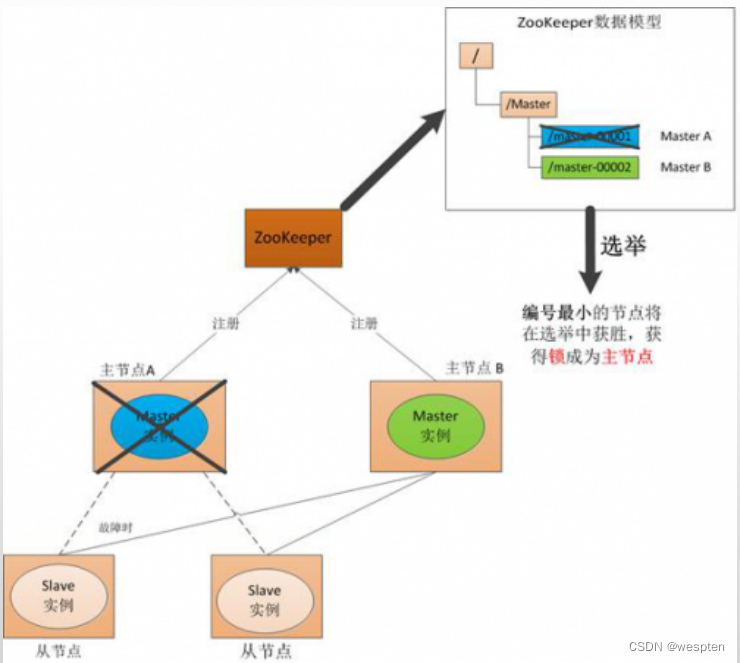

1) Master启动

在分布式系统中引入Zookeeper以后,就可以配置多个主节点,这里以配置两个主节点为例,假定它们是"主节点A"和"主节点B",当两个主节点都启动后,它们都会向ZooKeeper中注册节点信息。

我们假设"主节点A"锁注册的节点信息是"master00001","主节点B"注册的节点信息是"master00002",注册完以后会进行选举,选举有多种算法,这里以编号最小作为选举算法,那么编号最小的节点将在选举中获胜并获得锁成为主节点,也就是"主节点A"将会获得锁成为主节点,然后"主节点B"将被阻塞成为一个备用节点。这样,通过这种方式Zookeeper就完成了对两个Master进程的调度。完成了主、备节点的分配和协作。

2) Master故障

如果"主节点A"发生了故障,这时候它在ZooKeeper所注册的节点信息会被自动删除,而ZooKeeper会自动感知节点的变化,发现"主节点A"故障后,会再次发出选举,这时候"主节点B"将在选举中获胜,替代"主节点A"成为新的主节点,这样就完成了主、被节点的重新选举。

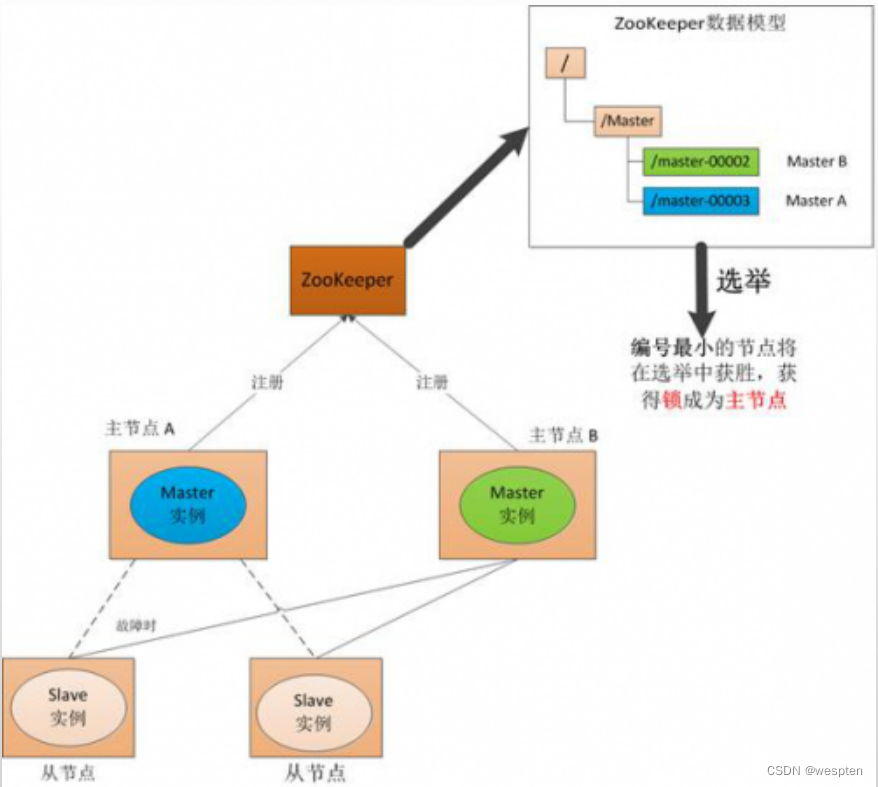

3)Master恢复

如果主节点恢复了,它会再次向ZooKeeper注册自身的节点信息,只不过这时候它注册的节点信息将会变成"master00003",而不是原来的信息。ZooKeeper会感知节点的变化再次发动选举,这时候"主节点B"在选举中会再次获胜继续担任"主节点","主节点A"会担任备用节点。

Zookeeper就是通过这样的协调、调度机制如此反复的对集群进行管理和状态同步的。

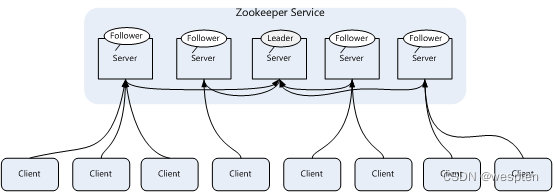

4、Zookeeper集群架构

Zookeeper一般是通过集群架构来提供服务的,下图是Zookeeper的基本架构图:

Zookeeper集群主要角色有Server和client,其中,Server又分为Leader、Follower和Observer三个角色,每个角色的含义如下:

1. Leader:领导者角色,主要负责投票的发起和决议,以及更新系统状态。

2. Follower:跟随者角色,用于接收客户端的请求并返回结果给客户端,在选举过程中参与投票。

3. Observer:观察者角色,用户接收客户端的请求,并将写请求转发给leader,同时同步leader状态,但不参与投票。 Observer目的是扩展系统,提高伸缩性。

4. Client:客户端角色,用于向Zookeeper发起请求。

Zookeeper集群中每个Server在内存中存储了一份数据,在Zookeeper启动时,将从实例中选举一个Server作为leader,Leader负责处理数据更新等操作,当且仅当大多数Server在内存中成功修改数据,才认为数据修改成功。

Zookeeper写的流程为:客户端Client首先和一个Server或者Observe通信,发起写请求,然后Server将写请求转发给Leader,Leader再将写请求转发给其它Server,其它Server在接收到写请求后写入数据并响应Leader,Leader在接收到大多数写成功回应后,认为数据写成功,最后响应Client,完成一次写操作过程。

三、Kafka架构

1、kafka基本概念

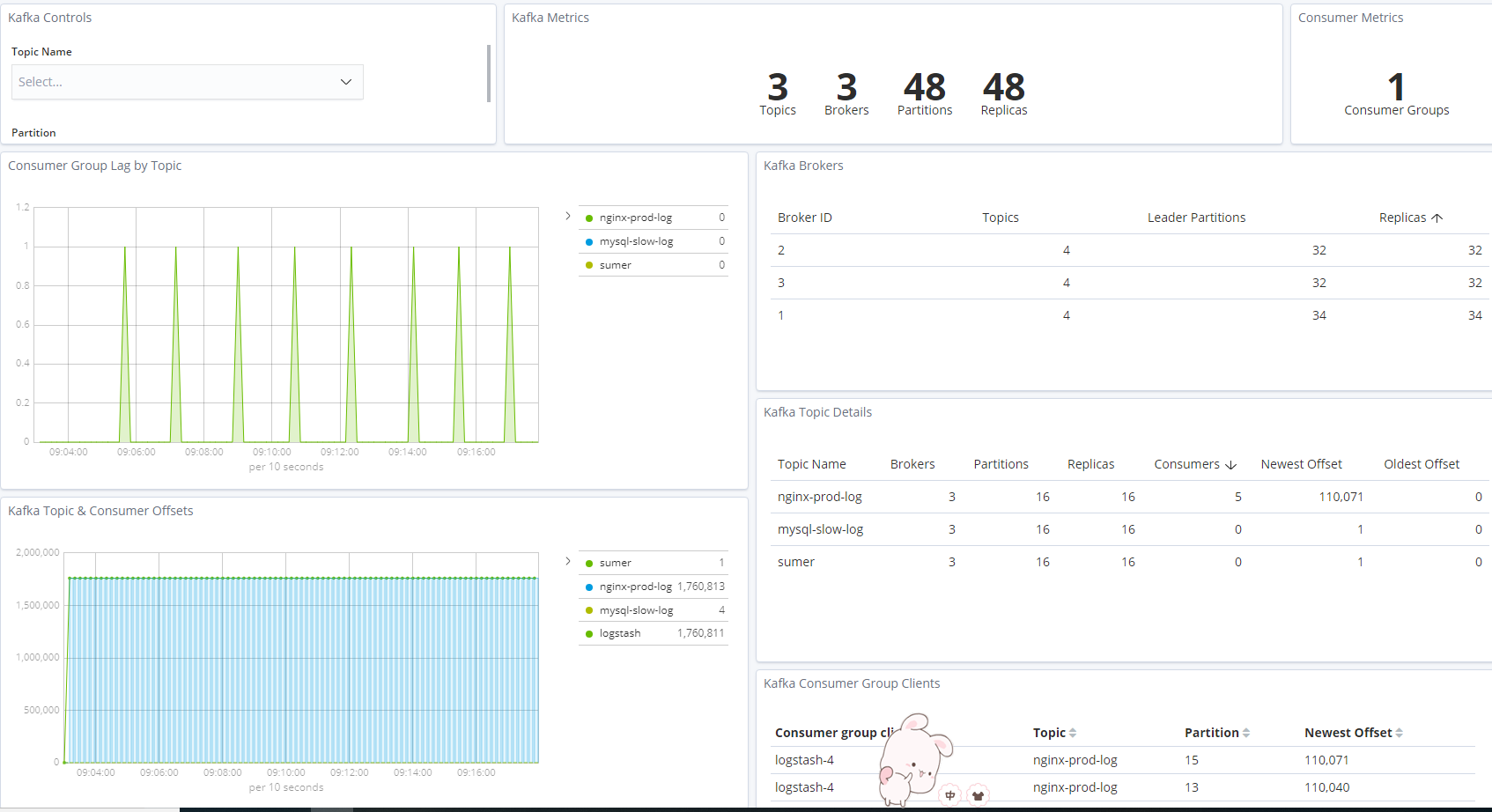

Kafka是一种高吞吐量的分布式发布/订阅消息系统,这是官方对kafka的定义,kafka是Apache组织下的一个开源系统,它的最大的特性就是可以实时的处理大量数据以满足各种需求场景:比如基于hadoop平台的数据分析、低时延的实时系统、storm/spark流式处理引擎等。kafka现在它已被多家大型公司作为多种类型的数据管道和消息系统使用。

2、kafka角色术语

在介绍架构之前,先了解下kafka中一些核心概念和各种角色。

Broker:Kafka集群包含一个或多个服务器,每个服务器被称为broker。

Topic:每条发布到Kafka集群的消息都有一个分类,这个类别被称为Topic(主题)。

Producer:指消息的生产者,负责发布消息到Kafka broker。

Consumer :指消息的消费者,从Kafka broker拉取数据,并消费这些已发布的消息。

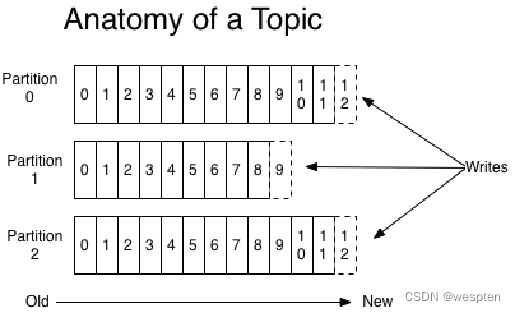

Partition:Parition是物理上的概念,每个Topic包含一个或多个Partition,每个partition都是一个有序的队列。partition 中的每条消息都会被分配一个有序的id(称为offset)。

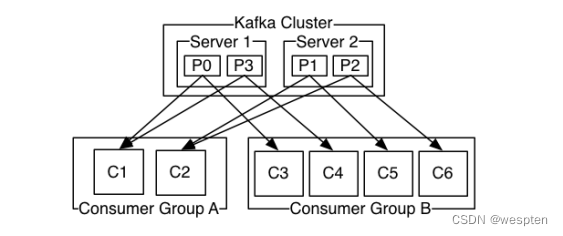

Consumer Group:消费者组,可以给每个Consumer指定消费者组,若不指定消费者组,则属于默认的group。

Message:消息,通信的基本单位,每个producer可以向一个topic发布一些消息。

3、Kafka拓扑架构

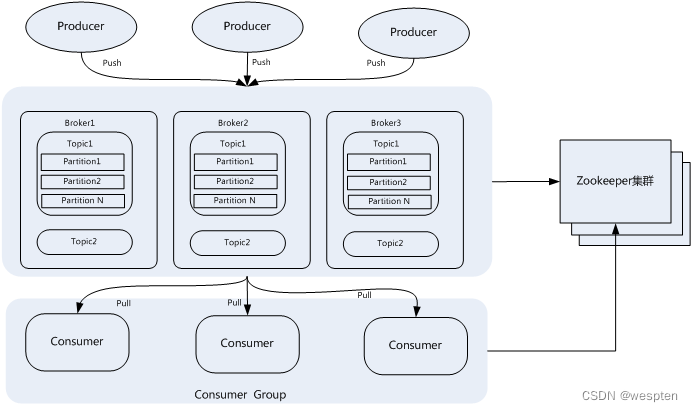

一个典型的Kafka集群包含若干Producer,若干broker、若干Consumer Group,以及一个Zookeeper集群。Kafka通过Zookeeper管理集群配置,选举leader,以及在Consumer Group发生变化时进行rebalance。Producer使用push模式将消息发布到broker,Consumer使用pull模式从broker订阅并消费消息。

4、Topic与Partition

Kafka中的topic是以partition的形式存放的,每一个topic都可以设置它的partition数量,Partition的数量决定了组成topic的log的数量。推荐partition的数量一定要大于同时运行的consumer的数量。另外,建议partition的数量大于集群broker的数量,这样消息数据就可以均匀的分布在各个broker中。

那么,Topic为什么要设置多个Partition呢,这是因为kafka是基于文件存储的,通过配置多个partition可以将消息内容分散存储到多个broker上,这样可以避免文件尺寸达到单机磁盘的上限。

同时,将一个topic切分成任意多个partitions,可以保证消息存储、消息消费的效率,因为越多的partitions可以容纳更多的consumer,可有效提升Kafka的吞吐率。因此,将Topic切分成多个partitions的好处是可以将大量的消息分成多批数据同时写到不同节点上,将写请求分担负载到各个集群节点。

5、Kafka消息发送的机制

每当用户往某个Topic发送数据时,数据会被hash到不同的partition,这些partition位于不同的集群节点上,所以每个消息都会被记录一个offset消息号,就是offset号。消费者通过这个offset号去查询读取这个消息。

发送消息流程为:

首先获取topic的所有Patition,如果客户端不指定Patition,也没有指定Key的话,使用自增长的数字取余数的方式实现指定的Partition。这样Kafka将平均的向Partition中生产数据。如果想要控制发送的partition,则有两种方式,一种是指定partition,另一种就是根据Key自己写算法。实现其partition方法。

每一条消息被发送到broker时,会根据paritition规则选择被存储到哪一个partition。如果partition规则设置的合理,所有消息可以均匀分布到不同的partition里,这样就实现了水平扩展。同时,每条消息被append到partition中时,是顺序写入磁盘的,因此效率非常高,经验证,顺序写磁盘效率比随机写内存还要高,这是Kafka高吞吐率的一个很重要的保证。

6、Kafka消息消费机制

Kafka中的Producer和consumer采用的是push(推送)、pull(拉取)的模式,即Producer只是向broker push消息,consumer只是从broker pull消息,push和pull对于消息的生产和消费是异步进行的。pull模式的一个好处是Consumer可自主控制消费消息的速率,同时Consumer还可以自己控制消费消息的方式是批量的从broker拉取数据还是逐条消费数据。

当生产者将数据发布到topic时,消费者通过pull的方式,定期从服务器拉取数据,当然在pull数据的时候,服务器会告诉consumer可消费的消息offset。

消费规则:

1. 不同 Consumer Group下的消费者可以消费partition中相同的消息,相同的Consumer Group下的消费者只能消费partition中不同的数据。

2. topic的partition的个数和同一个消费组的消费者个数最好一致,如果消费者个数多于partition个数,则会存在有的消费者消费不到数据。

3. 服务器会记录每个consumer的在每个topic的每个partition下的消费的offset,然后每次去消费去拉取数据时,都会从上次记录的位置开始拉取数据。

7、Kafka消息存储机制

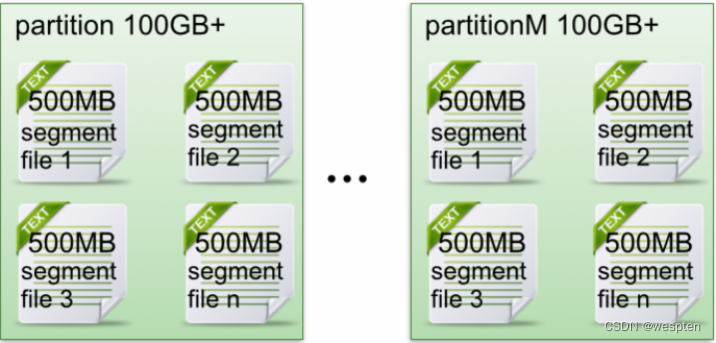

在存储结构上,每个partition在物理上对应一个文件夹,该文件夹下存储这个partition的所有消息和索引文件,每个partion(目录)相当于一个巨型文件被平均分配到多个大小相等segment(段)数据文件中。

partiton命名规则为topic名称+序号,第一个partiton序号从0开始,序号最大值为partitions数量减1。

在每个partition (文件夹)中有多个大小相等的segment(段)数据文件,每个segment的大小是相同的,但是每条消息的大小可能不相同,因此segment 数据文件中消息数量不一定相等。

segment数据文件有两个部分组成,分别为index file和data file,此两个文件是一一对应,成对出现,后缀".index"和“.log”分别表示为segment索引文件和数据文件。

其实Kafka最核心的思想是使用磁盘,而不是使用内存,使用磁盘操作有以下几个好处:

1. 磁盘缓存由Linux系统维护,减少了程序员的不少工作。

2. 磁盘顺序读写速度超过内存随机读写。

3. JVM的GC效率低,内存占用大。使用磁盘可以避免这一问题。

4. 系统冷启动后,磁盘缓存依然可用。

四、Elasticsearch架构

Elasticsearch是个开源分布式搜索引擎,它的特点有:分布式,零配置,自动发现,索引自动分片,索引副本机制,restful风格接口,多数据源,自动搜索负载等。

1、ElasticSearch 概念及特点

ElasticSearch是可伸缩的,一个采用RESTFUL api 标准的高扩展性和高可用性的实时数据分析的全文搜索工具。

ElasticSearch相关概念:

-

Node(节点):单个的装有Elasticsearch服务并且提供故障转移和扩展的服务器。

-

Cluster(集群)∶一个集群就是由一个或多个node组织在一起,共同工作,·共同分享整个数据具有负载均衡功能的集群。

-

Document(文档)∶一个文档是一个可被索引的基础信息单元。

-

Index(索引)∶索引就是一个拥有几分相似特征的文档的集合。

-

Type(类型)∶一个索引中,你可以定义一种或多种类型。

-

Field(列)∶Field是Elasticsearch的最小单位,相当于数据的某一列。·

-

Shards(分片)∶Elasticsearch将索引分成若干份,每个部分就是一个shard。·

-

Replicas(复制)∶Replicas是索引一份或多份拷贝。·

RESTFul 解释:

· API∶Application Programming Interface的缩写,中文意思就是应用程序接口

· XML∶可扩展标记语言,是一种程序与程序之间传输数据的标记语言·

· JSON∶英文javascript object notation的缩写,它是一种新型的轻量级数据交换格式

做运维的可能不太了解rustful,但是做开发可能会了解的多一些,从这里就可以看出来,学一门语言是不是重要的。

有了API就可以更好的调用和使用。XML为什么会被丢弃,因为XML文件格式比较庞大,而且不容易解析,不同浏览器之间解析XML又不一样,而且现在微博,等web端的应用,XML越来越跟不上时代的发展,所以现在开始用轻量级的JSON。

RESTFul 风格:

REST(Representational State Transfer,表述性状态转移)是一组架构约束条件和原则,而满足这些约束条件和原则的应用程序或设计就是 RESTful,其本质就是一种定义接口的规范。

-

基于 HTTP 。

-

使用 XML 或 JSON 的格式定义。

-

每一个 URI 代表一种资源。

-

客户端使用 GET、POST、PUT、DELETE 这 4 种表示操作方式的动词对服务端资源进行操作:

- GET:获取资源

- POST:新建资源(也可以更新资源)

- PUT:更新资源

- DELETE:删除资源

高扩展性体现在拓展非常简单,新的节点,基本无需做复杂配置自动发现节点。

高可用性因为是分布式的,而且是一个实时搜索平台,支持PB级的大数据搜索能力。

实时性则是从一个文档到这个文档被搜索,只有略微的延迟,所以说他的实时性非常高。

你可以把elasticearch当做一个数据库,来对比下与其他数据库的不同,elasticseach是非关系型数据库。

2、ElasticSearch 架构

架构说明:

gateway:elasticsearch支持的索引数据的存储格式,当这个elasticsearch关闭再启动的时候,他就会从gateway里面读取索引数据。本地的,分布式,亚马逊的S3

第二行是lucene的框架

第三行:对数据的加工处理方式,创建index模块,搜索模块,mapping,river

第四行:

左边第一块是elasticsearch自动发现节点的机制。

zen 用来实现节点自动发现的,加入master发生故障,其他的节点就会自动选举,来确定一个master。

中间,方便对查询出来的数据进行数据处理。

最右边:插件识别,中文分词插件,断点监控插件。

倒数第二层,是交互方式,默认是用httpd协议来传输的。

最顶层右边是说可以使用java语言,本身就是用java开发的。

3、ElasticSearch 安装

解压即可运行:

[root@localhost ~]# tar zxf elasticsearch-5.0.0.tar.gz

[root@localhost ~]# cd elasticsearch-5.0.0

[root@localhost elasticsearch-5.0.0]# ls

bin config lib LICENSE.txt modules NOTICE.txt README.textile

[root@localhost elasticsearch-5.0.0]#

[root@localhost elasticsearch-5.0.0]# ./bin/elasticsearch -d-d 表示让服务在后台运行。

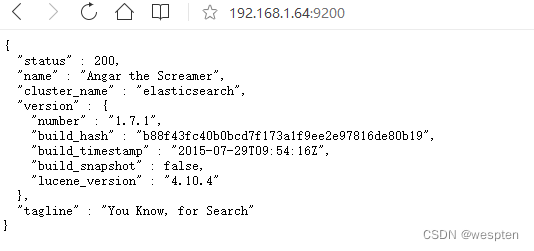

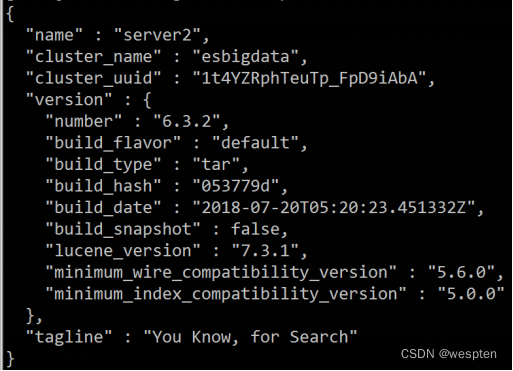

怎么确认elasticsearch 是否启动成功呢?

我们来访问下web服务地址就可以确认了。

web服务地址:

这是一个json的格式,把数据返回回来了,200说明成功了。

name:节点的名称,这个名称是美国漫威漫画角色的名字,他会随机分配一个。

只要java配对了,基本上都可以启动成功,如果启动不成功可以去log日志里面查看。

Elasticsearch启动注意:

- 如果启动在127.0.0.1的话,可以启动成功。

- 如果要跨机器通讯,需要监听在真实网卡时(自建机房的话,建议监听在内网网卡,监听在公网会被入侵)。

- 如果是云服务器的话,一定把9200和9300公网入口在安全组限制一下。

4、ElasticSearch 目录结构

接下来我们看下目录结构:

[root@localhost bin]# ls

elasticsearch elasticsearch.in.bat elasticsearch-service-mgr.exe elasticsearch-service-x86.exe plugin.bat

elasticsearch.bat elasticsearch.in.sh(做优化的时候可以用到) elasticsearch-service-x64.exe plugin service.bat

最重要的是data文件。

5、ElasticSearch 基本操作

1)Elasticsearch的概念

- ->类似于Mysql中的数据库

- ->类似于Mysql中的数据表

- ->存储数据

2)Elasticsearch的数据类型

简单数据类型:

-

字符串- text:会分词,不支持聚合(相当于 mysql 中的 sum)

- keyword:不会分词,将全部内容作为一个词条,支持聚合

-

数值

-

布尔值(boolean) -

二进制(binary) -

范围(range)- integer_range

- float_range

- long_range

- double_range

- date_range

-

日期(date)

复杂数据类型:

-

数组 [ ]:数组类型的 JSON 对象(for arrays of JSON objects) -

对象 { }:单个 JSON 对象(for single JSON objects)

3)Elasticsearch的数据操作类型

- curl操作Elasticsearch会比较难

- Kibana来操作Elasticsearch

① 操作索引

使用 Kibana:

# 添加索引

PUT 索引名称 # 或 PUT /索引名称

# 查询索引

# 查询单个索引信息

GET 索引名称

# 查询多个索引信息

GET 索引名称1,索引名称2,...

# 查询所有索引信息

GET _all # 注意:下划线开头的指令是ES内置的

# 删除索引

DELETE 索引名称

# 关闭索引

POST 索引名称/_close

# 打开索引

POST 索引名称/_open使用 RESTful 接口:

# 添加索引

PUT http://ip:端口/索引名称

# 查询索引

# 查询单个索引信息

GET http://ip:端口/索引名称

# 查询多个索引信息

GET http://ip:端口/索引名称1,索引名称2,...

# 查询所有索引信息

GET http://ip:端口/_all

# 删除索引

DELETE http://ip:端口/索引名称

# 关闭索引

POST http://ip:端口/索引名称/_close

# 打开索引

POST http://ip:端口/索引名称/_openElasticsearch增删改查案例:

创建索引: PUT /yyds

删除索引: DELETE /yyds

获取所有索引: GET /_cat/indices?v

ES插入数据:

PUT /yyds/users/1

{

"name":"xiaoming",

"age": 30

}

ES查询数据

GET /yyds/users/1

GET /yyds/_search?q=*

修改数据、覆盖

PUT /yyds/users/1

{

"name": "justdoit",

"age": 45

}

ES删除数据

DELETE /yyds/users/1

修改某个字段、不覆盖

POST /yyds/users/2/_update

{

"doc": {

"age": 29

}

}

修改所有的数据

POST /yyds/_update_by_query

{

"script": {

"source": "ctx._source['age']=30"

},

"query": {

"match_all": {}

}

}

增加一个字段

POST /yyds/_update_by_query

{

"script":{

"source": "ctx._source['city']='hangzhou'"

},

"query":{

"match_all": {}

}

}② 操作映射

对已有索引添加映射:

# 添加索引

PUT person

# 添加映射

PUT /person/_mapping

{

"properties":{ # properties 为固定开头

"name":{ # 字段名称

"type":"text" # type表示字段类型

},

"age":{

"type":"integer"

}

}

}同时创建索引和映射:

# 创建索引和映射

PUT /person1

{

"mappings": { # 注意 mappings 开头

"properties": {

"name": {

"type": "text"

},

"age": {

"type": "integer"

}

}

}

}

# 查询映射

GET person1/_mapping添加字段:

# 与添加映射的方式相同

PUT /person1/_mapping

{

"properties": {

"address": {

"type": "text"

}

}

}③ 操作文档

注意:在仅有索引的情况下也可以添加文档,且在有映射的情况下也可以新增字段。

- 添加文档(指定 id):

# 添加文档:指定 id 为 2

POST /person1/_doc/2

{

"name":"张三",

"age":18,

"address":"北京"

}

# 查询文档

GET /person1/_doc/2- 添加文档(不指定 id):

# 添加文档:不指定id

POST /person1/_doc/

{

"name":"张三",

"age":18,

"address":"北京"

}

# 使用返回的随机数id来查询文档

GET /person1/_doc/随机数id- 查询所有文档:

GET person1/_search- 删除指定 id 的文档:

DELETE /person1/_doc/2④ bulk 批量操作

# 测试数据

POST /person1/_doc/5

{

"name":"张三5号",

"age":18,

"address":"北京海淀区"

}

# bulk 批量操作(注意以下指令不可换行)

# 删除5号

# 新增8号

# 更新2号的name为2号

POST _bulk

{"delete":{"_index":"person1","_id":"5"}}

{"create":{"_index":"person1","_id":"8"}}

{"name":"八号","age":18,"address":"北京"}

{"update":{"_index":"person1","_id":"2"}}

{"doc":{"name":"2号"}}6、ElasticSearch 相关插件

ElasticSearch相关的插件(插件很多,可以在官网搜)。

1. head插件。

2. bigdesk插件。

3. Mavel插件 (收费的)但是用的还比较多。

4. head插件是一个集群管理工具,是由html5写的。

GitHub 网址获取相关信息:https://github.com/mobz/elasticsearch-head

1)head插件

进入elasticsearch bin目录下运行./plugin -install mobz/elasticsearch-head命令:

[root@localhost bin]# pwd

/root/elasticsearch-1.7.1/bin这里面的plugin就是用来装插件用的。

运行命令:

[root@localhost bin]# ./plugin -install mobz/elasticsearch-head

-> Installing mobz/elasticsearch-head...

Trying https://github.com/mobz/elasticsearch-head/archive/master.zip...

Downloading .........................................................................................................................................................................................................................................................................................................................................................................................................................................................................................................................................................................................................................................................................................DONE

Installed mobz/elasticsearch-head into /root/elasticsearch-1.7.1/plugins/head使用方法:

登陆网址测试:http://192.168.1.64:9200/_plugin/head/:

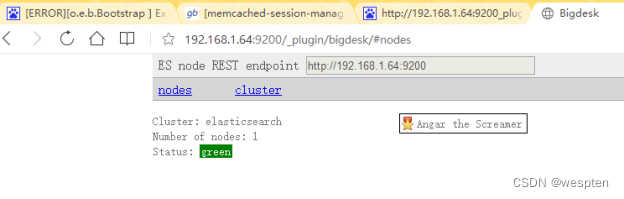

2)Bigdesk插件

Bigdesk插件是elasticsearch的一个集群监控工具,可以通过它来查看集群的各种状态,如∶cpu、内存使用情况,索引数据、搜索情况,http连接数等。

Github:GitHub - lukas-vlcek/bigdesk: Live charts and statistics for Elasticsearch cluster.

安装:

sudo elasticsearch/bin/plugin -install lukas-vlcek/bigdesk/2.5.0访问:

http://localhost:9200/_plugin/bigdesk/[root@localhost bin]# ./plugin -install lukas-vlcek/bigdesk/2.5.0

-> Installing lukas-vlcek/bigdesk/2.5.0...

Trying http://download.elasticsearch.org/lukas-vlcek/bigdesk/bigdesk-2.5.0.zip...

Trying http://search.maven.org/remotecontent?filepath=lukas-vlcek/bigdesk/2.5.0/bigdesk-2.5.0.zip...

Trying https://oss.sonatype.org/service/local/repositories/releases/content/lukas-vlcek/bigdesk/2.5.0/bigdesk-2.5.0.zip...

Trying https://github.com/lukas-vlcek/bigdesk/archive/2.5.0.zip...

Trying https://github.com/lukas-vlcek/bigdesk/archive/master.zip...

Downloading ........................................................................................................................................................................................................................................................DONE

Installed lukas-vlcek/bigdesk/2.5.0 into /root/elasticsearch-1.7.1/plugins/bigdesk

Identified as a _site plugin, moving to _site structure ...

[root@xuegod64 bin]#通过网页访问验证:

http://192.168.1.63:9200/_plugin/bigdesk/#nodes

点击nodes 会有很多图标,都是html5的。

主要功能有系统监控,cpu使用率,内存使用率,http的交互情况 ,io吞吐量。

3)Mavel插件

Marvel也是elasticsearch的一个管理监控工具,集head和bigdesk优点为一身。但是Marvel插件不是免费的。

官方介绍∶Monitoring:Elasticsearch 的监测与管理 | Elastic

安装∶

sudo elasticsearch/bin/plugin -install elasticsearch/marvel/latest访问∶

http://localhost:9200/_plugin/marvel/[root@localhostbin]# ./plugin -install elasticsearch/marvel/latest

-> Installing elasticsearch/marvel/latest...

Trying http://download.elasticsearch.org/elasticsearch/marvel/marvel-latest.zip...

Downloading ........................................................................................................................................................................................................................................................................................................................................................................................................................................................................................................................................................................................................DONE

Installed elasticsearch/marvel/latest into /root/elasticsearch-1.7.1/plugins/marvel

[root@localhostbin]#五、Logstash架构

Logstash是一个开源的数据收集引擎,它具有备实时数据传输能力。 它可以统一过滤来自不同源的数据,并按照开发者制定的规 范输出到目的地, 支持正则表达式。

由于日志文件来源多(如:系统日志、服务器日志、tomcat 日志、nginx日志等), 且内容杂乱,不便于人类进行观察。 因此,我们可以使用 Logstash 对日志文件进行收集和统一 过滤,变成可读性高的内容。

1、Logstash安装和部署

tar zxvf logstash-7.8.0.tar.gz

ln -s logstash-7.8.0 logstash

chown -R elk:elk logstash

chown -R elk:elk logstash-7.8.0Logstash的JVM配置文件更新/usr/local/logstash-6.6.0/config/jvm.options:

-Xms200M

-Xmx200M2、Logstash启动和测试

前台启动:

/usr/local/logstash-7.8.0/bin/logstash -f /usr/local/logstash-7.8.0/config/logstash.conf后台启动:

nohup /usr/local/logstash-7.8.0/bin/logstash -f /usr/local/logstash-7.8.0/config/logstash.conf >/tmp/logstash.log 2>/tmp/logstash.log &测试标准输入和输出:

简单的案例(从控制台输入 => 控制台输出)

# -e指定配置启动

bin/logstash -e 'input {stdin{}} output{stdout{}}'

# sdtin:hello stdout:

{

"host" => "elk",

"@timestamp" => 2021-02-22T23:29:21.562Z,

"@version" => "1",

"message" => "hello"

}使用配置文件启动:

cp logstash-sample.conf logstash.conf

bin/logstash -f config/logstash.conf

配置文件内容:

input {

# 从文件读取日志信息

file {

path => "/var/log/messages"

type => "system"

start_position => "beginning"

}

}

filter {

}

output {

# 标准输出

stdout {}

}

后台启动:

vi startup.sh

#! /bin/bash

nohup /usr/local/logstash/bin/logstash -f

/usr/local/logstash/config/logstash.conf >>

/usr/local/logstash/output.log 2>&1 &3、Logstash基本语法组成

logstash之所以功能强大和流行,还与其丰富的过滤器插件是分不开的,过滤器提供的并不单单是过滤的功能,还可以对进入过滤器的原始数据进行复杂的逻辑处理,甚至添加独特的事件到后续流程中。

Logstash配置文件有如下三部分组成,其中input、output部分是必须配置,filter部分是可选配置,而filter就是过滤器插件,可以在这部分实现各种日志过滤功能。

input {

#输入插件

}

filter {

#过滤匹配插件

}

output {

#输出插件

}4、Logstash输入插件(Input)

1)读取文件(File)

logstash使用一个名为filewatch的ruby gem库来监听文件变化,并通过一个叫.sincedb的数据库文件来记录被监听的日志文件的读取进度(时间戳),这个sincedb数据文件的默认路径在 <path.data>/plugins/inputs/file下面,文件名类似于.sincedb_452905a167cf4509fd08acb964fdb20c,而<path.data>表示logstash插件存储目录,默认是LOGSTASH_HOME/data。

看下面一个事件配置文件:

input {

file {

path => ["/var/log/messages"]

type => "system"

start_position => "beginning"

}

}

output {

stdout{

codec=>rubydebug

}

}这个配置是监听并接收本机的/var/log/messages文件内容,start_position表示按时间戳记录的地方开始读取,如果没有时间戳则从头开始读取,有点类似cat命令,默认情况下,logstash会从文件的结束位置开始读取数据,也就是说logstash进程会以类似tail -f命令的形式逐行获取数据。type用来标记事件类型,通常会在输入区域通过type标记事件类型。

2)标准输入(Stdin)

stdin是从标准输入获取信息,关于stdin的使用,前面已经做过了一些简单的介绍,这里再看一个稍微复杂一点的例子,下面是一个关于stdin的事件配置文件:

input{

stdin{

add_field=>{"key"=>"iivey"}

tags=>["add1"]

type=>"test1"

}

}

output {

stdout{

codec=>rubydebug

}

}3)读取 Syslog日志

如何将rsyslog收集到的日志信息发送到logstash中,这里以centos7.5为例,需要做如下两个步骤的操作:

首先,在需要收集日志的服务器上找到rsyslog的配置文件/etc/rsyslog.conf,添加如下内容:

*.* @@172.16.213.120:5514其中,172.16.213.120是logstash服务器的地址。5514是logstash启动的监听端口。

接着,重启rsyslog服务:

[root@kafkazk1 logstash]# systemctl restart rsyslog然后,在logstash服务器上创建一个事件配置文件,内容如下:

input {

syslog {

port => "5514"

}

}

output {

stdout{

codec=>rubydebug

}

}

4)读取TCP网络数据

下面的事件配置文件就是通过"LogStash::Inputs::TCP"和"LogStash::Filters::Grok"配合实现syslog功能的例子,这里使用了logstash的TCP/UDP插件读取网络数据:

input {

tcp {

port => "5514"

}

}

filter {

grok {

match => { "message" => "%{SYSLOGLINE}" }

}

}

output {

stdout{

codec=>rubydebug

}

}其中,5514端口是logstash启动的tcp监听端口。注意这里用到了日志过滤"LogStash::Filters::Grok"功能。

5、Logstash编码插件(Codec)

其实我们就已经用过编码插件codec了,也就是这个rubydebug,它就是一种codec,虽然它一般只会用在stdout插件中,作为配置测试或者调试的工具。

编码插件(Codec)可以在logstash输入或输出时处理不同类型的数据,因此,Logstash不只是一个input-->filter-->output的数据流,而是一个input-->decode-->filter-->encode-->output的数据流。

Codec支持的编码格式常见的有plain、json、json_lines等,下面依次介绍。

1)codec插件之plain

plain是一个空的解析器,它可以让用户自己指定格式,也就是说输入是什么格式,输出就是什么格式。下面是一个包含plain编码的事件配置文件:

input{

stdin{

}

}

output{

stdout{

codec => "plain"

}

}2)codec插件之json、json_lines

如果发送给logstash的数据内容为json格式,可以在input字段加入codec=>json来进行解析,这样就可以根据具体内容生成字段,方便分析和储存。如果想让logstash输出为json格式,可以在output字段加入codec=>json,下面是一个包含json编码的事件配置文件:

input {

stdin {

}

}

output {

stdout {

codec => json

}

}

这就是json格式的输出,可以看出,json每个字段是key:values格式,多个字段之间通过逗号分隔。有时候,如果json文件比较长,需要换行的话,那么就要用json_lines编码格式了。

6、Logstash过滤器插件(Filter)

1)Grok 正则捕获

grok是一个十分强大的logstash filter插件,他可以通过正则解析任意文本,将非结构化日志数据弄成结构化和方便查询的结构。他是目前logstash 中解析非结构化日志数据最好的方式。

Grok 的语法规则是:

%{语法: 语义}“语法”指的就是匹配的模式,例如使用NUMBER模式可以匹配出数字,IP模式则会匹配出127.0.0.1这样的IP地址:

例如输入的内容为:

172.16.213.132 [07/Feb/2018:16:24:19 +0800] "GET / HTTP/1.1" 403 5039那么,%{IP:clientip}匹配模式将获得的结果为:

clientip: 172.16.213.132%{HTTPDATE:timestamp}匹配模式将获得的结果为:

timestamp: 07/Feb/2018:16:24:19 +0800而%{QS:referrer}匹配模式将获得的结果为:

referrer: "GET / HTTP/1.1"

下面是一个组合匹配模式,它可以获取上面输入的所有内容:

%{IP:clientip}\ \[%{HTTPDATE:timestamp}\]\ %{QS:referrer}\ %{NUMBER:response}\ %{NUMBER:bytes} 通过上面这个组合匹配模式,我们将输入的内容分成了五个部分,即五个字段,将输入内容分割为不同的数据字段,这对于日后解析和查询日志数据非常有用,这正是使用grok的目的。

Logstash默认提供了近200个匹配模式(其实就是定义好的正则表达式)让我们来使用,可以在logstash安装目录下,例如这里是/usr/local/logstash/vendor/bundle/jruby/1.9/gems/logstash-patterns-core-4.1.2/patterns目录里面查看,基本定义在grok-patterns文件中。

从这些定义好的匹配模式中,可以查到上面使用的四个匹配模式对应的定义规则:

匹配模式 正则定义规则

NUMBER (?:%{BASE10NUM})

HTTPDATE %{MONTHDAY}/%{MONTH}/%{YEAR}:%{TIME} %{INT}

IP (?:%{IPV6}|%{IPV4})

QS %{QUOTEDSTRING}例子:

input{

stdin{}

}

filter{

grok{

match => ["message","%{IP:clientip}\ \[%{HTTPDATE:timestamp}\]\ %{QS:referrer}\ %{NUMBER:response}\ %{NUMBER:bytes}"]

}

}

output{

stdout{

codec => "rubydebug"

}

}输入内容:

172.16.213.132 [07/Feb/2018:16:24:19 +0800] "GET / HTTP/1.1" 403 50392)时间处理(Date)

date插件是对于排序事件和回填旧数据尤其重要,它可以用来转换日志记录中的时间字段,变成LogStash::Timestamp对象,然后转存到@timestamp字段里,这在之前已经做过简单的介绍。

下面是date插件的一个配置示例(这里仅仅列出filter部分):

filter {

grok {

match => ["message", "%{HTTPDATE:timestamp}"]

}

date {

match => ["timestamp", "dd/MMM/yyyy:HH:mm:ss Z"]

}

}| 时间字段 |

字母 |

表示含义 |

| 年 |

yyyy |

表示全年号码。 例如:2018 |

| yy |

表示两位数年份。 例如:2018年即为18 |

|

| 月 |

M |

表示1位数字月份,例如:1月份为数字1,12月份为数字12 |

| MM |

表示两位数月份,例如:1月份为数字01,12月份为数字12 |

|

| MMM |

表示缩短的月份文本,例如:1月份为Jan,12月份为Dec |

|

| MMMM |

表示全月文本,例如:1月份为January,12月份为December |

|

| 日 |

d |

表示1位数字的几号,例如8表示某月8号 |

| dd |

表示2位数字的几号,例如08表示某月8号 |

|

| 时 |

H |

表示1位数字的小时,例如1表示凌晨1点 |

| HH |

表示2位数字的小时,例如01表示凌晨1点 |

|

| 分 |

m |

表示1位数字的分钟,例如5表示某点5分 |

| mm |

表示2位数字的分钟,例如05表示某点5分 |

|

| 秒 |

s |

表示1位数字的秒,例如6表示某点某分6秒 |

| ss |

表示2位数字的秒,例如06表示某点某分6秒 |

|

| 时区 |

Z |

表示时区偏移,结构为HHmm,例如:+0800 |

| ZZ |

表示时区偏移,结构为HH:mm,例如:+08:00 |

|

| ZZZ |

表示时区身份,例如Asia/Shanghai |

3)数据修改(Mutate)

① 正则表达式替换匹配字段

gsub可以通过正则表达式替换字段中匹配到的值,只对字符串字段有效,下面是一个关于mutate插件中gsub的示例(仅列出filter部分):

filter {

mutate {

gsub => ["filed_name_1", "/" , "_"]

}

}这个示例表示将filed_name_1字段中所有"/"字符替换为"_"。

② 分隔符分割字符串为数组

split可以通过指定的分隔符分割字段中的字符串为数组,下面是一个关于mutate插件中split的示例(仅列出filter部分):

filter {

mutate {

split => ["filed_name_2", "|"]

}

}这个示例表示将filed_name_2字段以"|"为区间分隔为数组。

③ 重命名字段

rename可以实现重命名某个字段的功能,下面是一个关于mutate插件中rename的示例(仅列出filter部分):

filter {

mutate {

rename => { "old_field" => "new_field" }

}

}这个示例表示将字段old_field重命名为new_field。

④ 删除字段

remove_field可以实现删除某个字段的功能,下面是一个关于mutate插件中remove_field的示例(仅列出filter部分):

filter {

mutate {

remove_field => ["timestamp"]

}

}这个示例表示将字段timestamp删除。

综合例子:

input {

stdin {}

}

filter {

grok {

match => { "message" => "%{IP:clientip}\ \[%{HTTPDATE:timestamp}\]\ %{QS:referrer}\ %{NUMBER:response}\ %{NUMBER:bytes}" }

remove_field => [ "message" ]

}

date {

match => ["timestamp", "dd/MMM/yyyy:HH:mm:ss Z"]

}

mutate {

rename => { "response" => "response_new" }

convert => [ "response","float" ]

gsub => ["referrer","\"",""]

remove_field => ["timestamp"]

split => ["clientip", "."]

}

}

output {

stdout {

codec => "rubydebug"

}

}

4)GeoIP 地址查询归类

GeoIP是最常见的免费IP地址归类查询库,当然也有收费版可以使用。GeoIP库可以根据IP 地址提供对应的地域信息,包括国别,省市,经纬度等,此插件对于可视化地图和区域统计非常有用。

下面是一个关于GeoIP插件的简单示例(仅列出filter部分):

filter {

geoip {

source => "ip_field"

}

}其中,ip_field字段是输出IP地址的一个字段。

5)filter插件综合应用实例

下面给出一个业务系统输出的日志格式,由于业务系统输出的日志格式无法更改,因此就需要我们通过logstash的filter过滤功能以及grok插件来获取需要的数据格式,此业务系统输出的日志内容以及原始格式如下:

2018-02-09T10:57:42+08:00|~|123.87.240.97|~|Mozilla/5.0 (iPhone; CPU iPhone OS 11_2_2 like Mac OS X) AppleWebKit/604.4.7 Version/11.0 Mobile/15C202 Safari/604.1|~|http://m.sina.cn/cm/ads_ck_wap.html|~|1460709836200|~|DF0184266887D0E可以看出,这段日志都是以“|~|”为区间进行分隔的,那么刚好我们就以“|~|”为区间分隔符,将这段日志内容分割为6个字段。这里通过grok插件进行正则匹配组合就能完成这个功能。

完整的grok正则匹配组合语句如下:

%{TIMESTAMP_ISO8601:localtime}\|\~\|%{IPORHOST:clientip}\|\~\|(%{GREEDYDATA:http_user_agent})\|\~\|(%{DATA:http_referer})\|\~\|%{GREEDYDATA:mediaid}\|\~\|%{GREEDYDATA:osid}调试grok正则表达式工具:Grok Debugger

7、Logstash输出插件(output)

output是Logstash的最后阶段,一个事件可以经过多个输出,而一旦所有输出处理完成,整个事件就执行完成。

一些常用的输出包括:

file: 表示将日志数据写入磁盘上的文件。

elasticsearch:表示将日志数据发送给Elasticsearch。Elasticsearch可以高效方便和易于查询的保存数据。

graphite:表示将日志数据发送给graphite,graphite是一种流行的开源工具,用于存储和绘制数据指标。

此外,Logstash还支持输出到nagios、hdfs、email(发送邮件)和Exec(调用命令执行)。

1)输出到标准输出(stdout)

stdout与之前介绍过的stdin插件一样,它是最基础和简单的输出插件,下面是一个配置实例:

output {

stdout {

codec => rubydebug

}

}stdout插件,主要的功能和用途就是用于调试,这个插件,在前面已经多次使用过。这里不再过多介绍。

2)保存为文件(file)

file插件可以将输出保存到一个文件中,配置实例如下:

output {

file {

path => "/data/log3/%{+yyyy-MM-dd}/%{host}_%{+HH}.log"

}上面这个配置中,使用了变量匹配,用于自动匹配时间和主机名,这在实际使用中很有帮助。

3)输出到elasticsearch

Logstash将过滤、分析好的数据输出到elasticsearch中进行存储和查询,是最经常使用的方法。下面是一个配置实例:

output {

elasticsearch {

host => ["172.16.213.37:9200","172.16.213.77:9200","172.16.213.78:9200"]

index => "logstash-%{+YYYY.MM.dd}"

manage_template => false

template_name => "template-web_access_log"

}

}上面配置中每个配置项含义如下:

host:是一个数组类型的值,后面跟的值是elasticsearch节点的地址与端口,默认端口是9200。可添加多个地址。

index:写入elasticsearch的索引的名称,这里可以使用变量。Logstash提供了%{+YYYY.MM.dd}这种写法。在语法解析的时候,看到以+ 号开头的,就会自动认为后面是时间格式,尝试用时间格式来解析后续字符串。这种以天为单位分割的写法,可以很容易的删除老的数据或者搜索指定时间范围内的数据。此外,注意索引名中不能有大写字母。

manage_template:用来设置是否开启logstash自动管理模板功能,如果设置为false将关闭自动管理模板功能。如果我们自定义了模板,那么应该设置为false。

template_name:这个配置项用来设置在Elasticsearch中模板的名称。

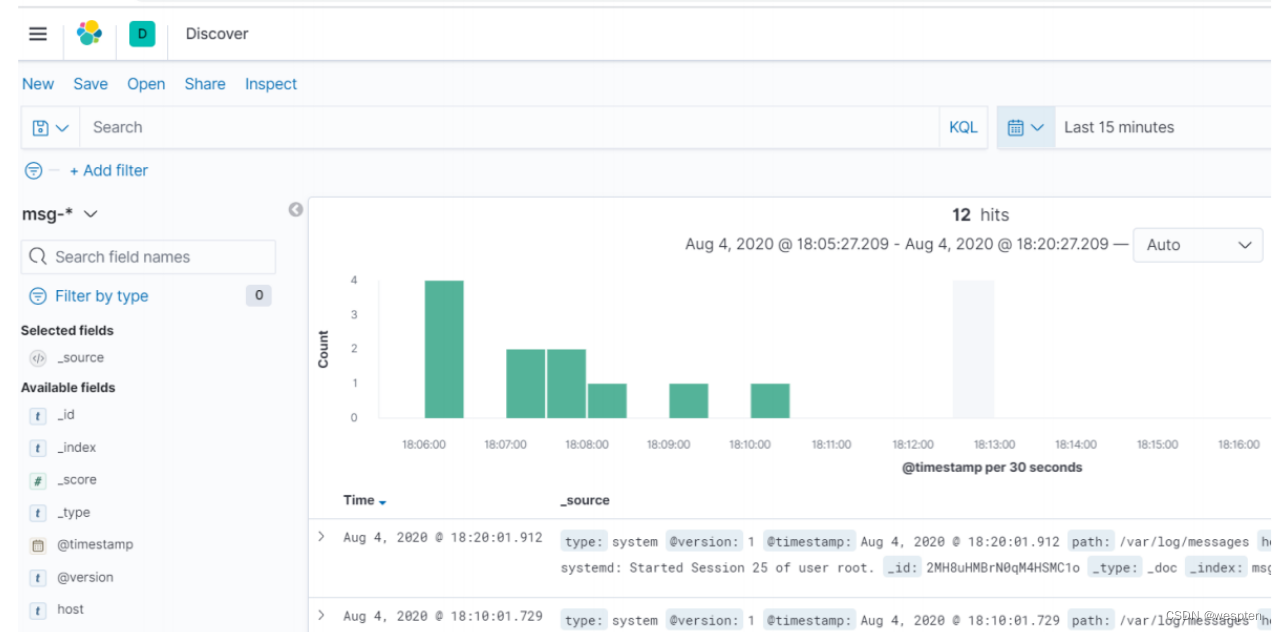

8、使用logstash收集日志信息并在kibana展示

输出到elasticsearch:

input {

# 从文件读取日志信息

file {

path => "/var/log/messages"

type => "system"

start_position => "beginning"

}

}

filter {

}

output {

elasticsearch {

hosts => ["127.0.0.1:9200"]

index => "msg-%{+YYYY.MM.dd}"

}

}

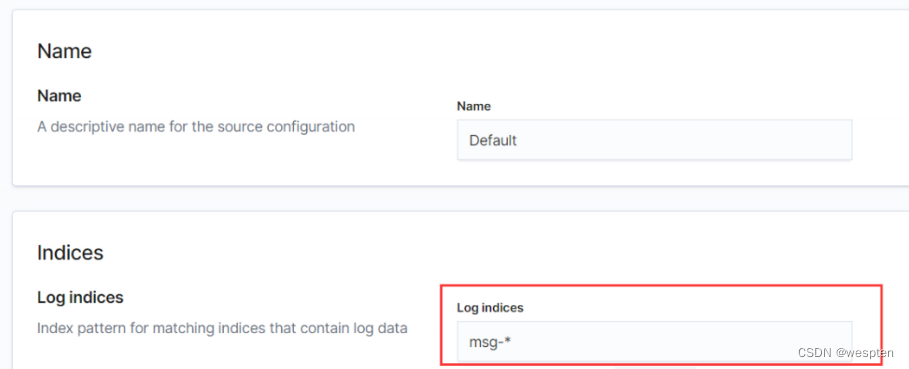

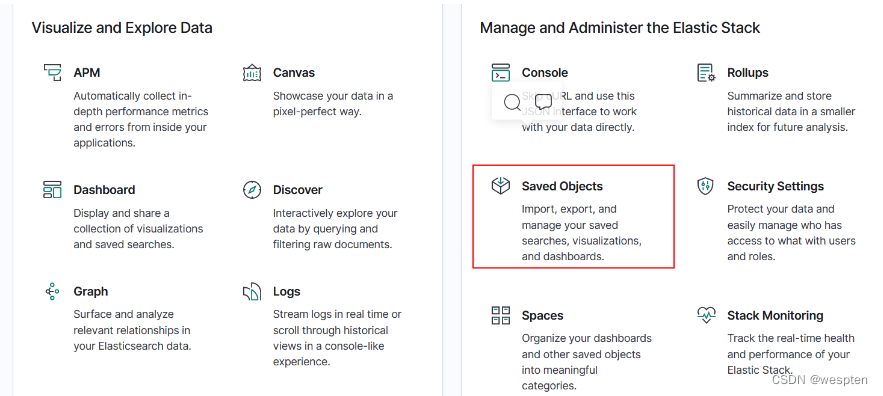

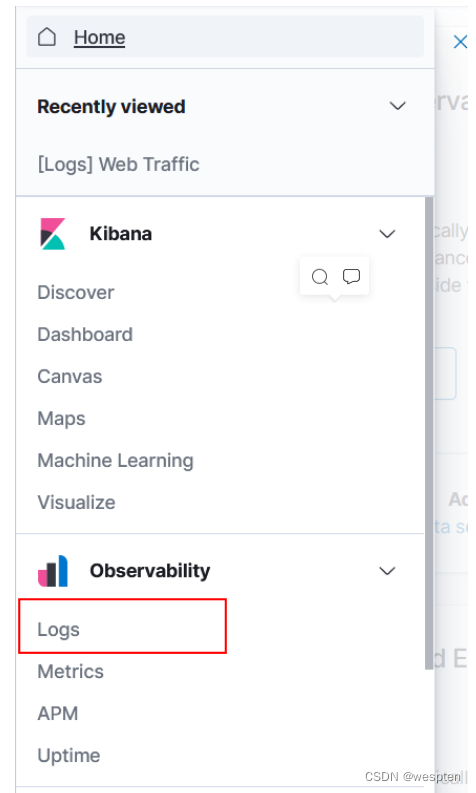

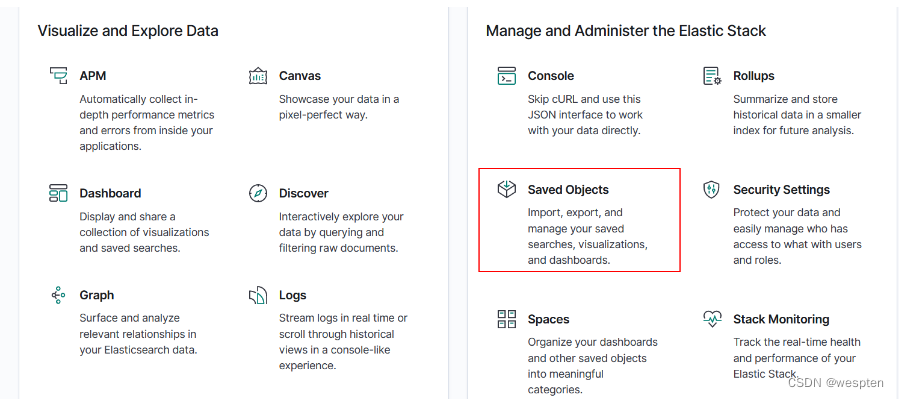

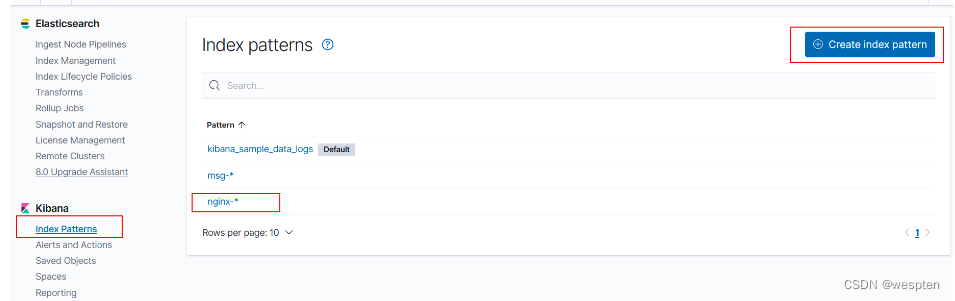

Logs:

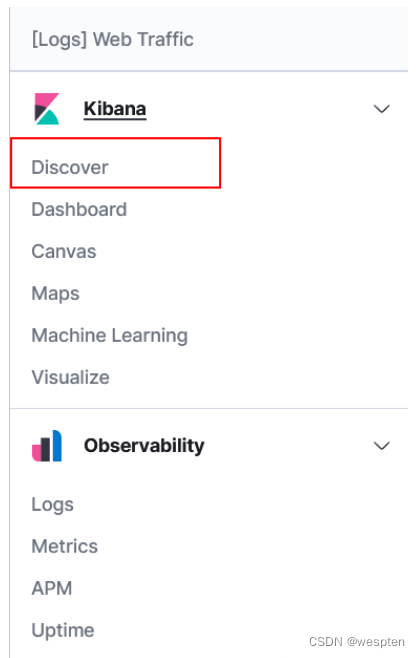

index pattern:

discover:

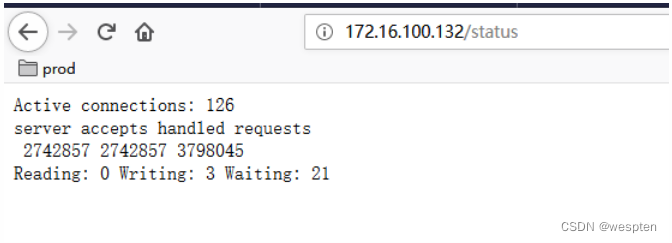

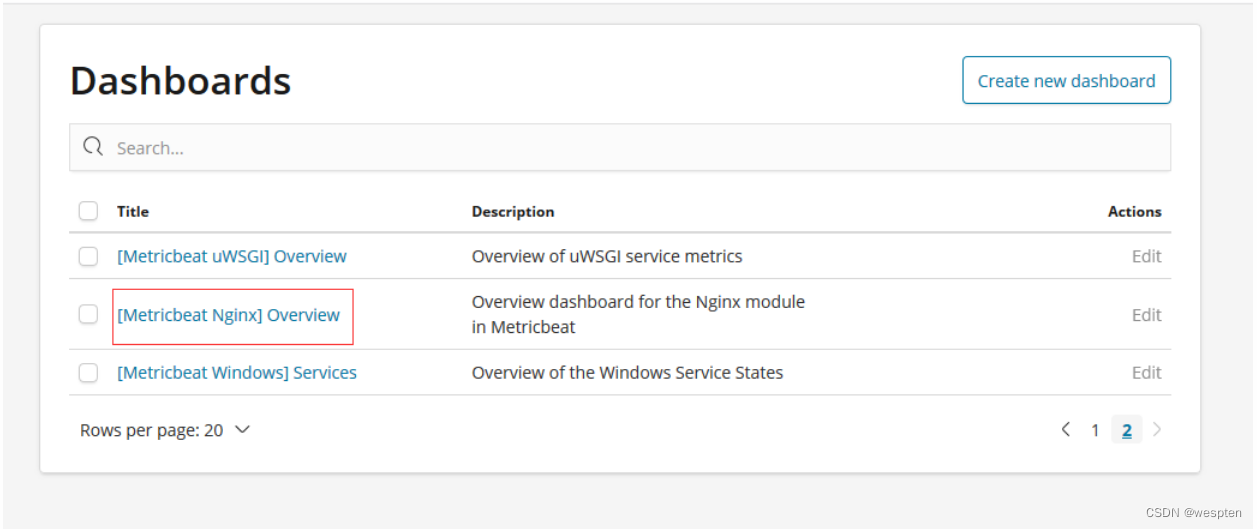

9、使用logstash收集nginx日志并在kibana展示

nginx安装:

cd /opt

tar zxvf nginx-1.18.0.tar.gz

ln -s nginx-1.18.0 nginx

chown -R elk:elk nginx

chown -R elk:elk nginx-1.18.0

cd /usr/local

wget http://jaist.dl.sourceforge.net/project/pcre/pcre/8.38/pcre-8.38.tar.gz

wget http://zlib.net/zlib-1.2.11.tar.gz

wget http://www.openssl.org/source/openssl-1.0.1j.tar.gz

tar zxvf pcre-8.38.tar.gz

ln -s pcre-8.38 pcre

tar zxvf zlib-1.2.11.tar.gz

ln -s zlib-1.2.11 zlib

tar zxvf openssl-1.0.1j.tar.gz

ln -s openssl-1.0.1j openssl

cd /opt/nginx

./configure --prefix=/usr/local/nginx --withpcre=/usr/local/pcre-8.38 --withzlib=/usr/local/zlib-1.2.11

./configure --prefix=/usr/local/nginx --with-pcre=/usr/local/pcre --with-zlib=/usr/local/zlib --with-openssl=/usr/local/openssl

--with-http_stub_status_module --with-http_gzip_static_module --with-http_realip_module --with-http_sub_module --with-http_ssl_module

make

make install启动nginx:

cd /usr/local/nginx

sbin/nginx -c conf/nginx.conf

ps -ef|grep nginx

配置logstash.conf:

input {

file {

path => "/usr/local/nginx/logs/access.log"

type => "nginxaccess"

start_position => "beginning"

}

}

filter {

grok {

match => { "message" => "%{HTTPD_COMBINEDLOG}" }

}

}

output {

elasticsearch {

hosts => ["127.0.0.1:9200"]

index => "nginx-%{+YYYY.MM.dd}"

}

}

使用内置正则表达式:

/usr/local/logstash/vendor/bundle/jruby/2.5.0/gems/logstashpatterns-core-4.1.2/patterns/httpd

HTTPD_COMBINEDLOG %{HTTPD_COMMONLOG} % {QS:referrer} %{QS:agent}

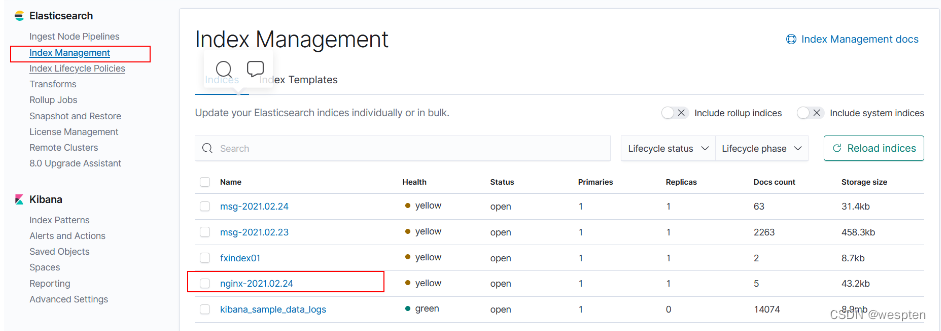

kibana展示:

索引展示:

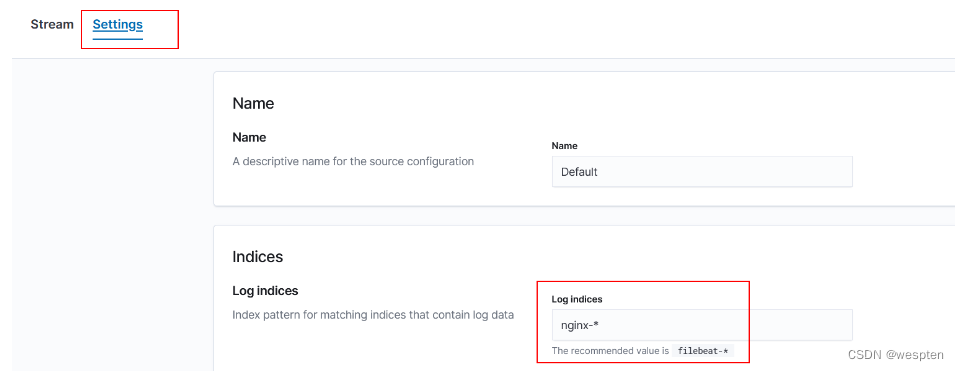

Logs展示:

Discover展示:

10、Logstash正则提取Nginx日志

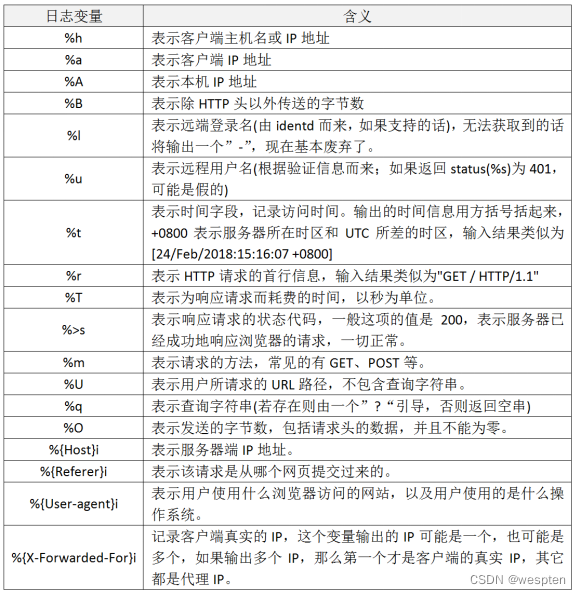

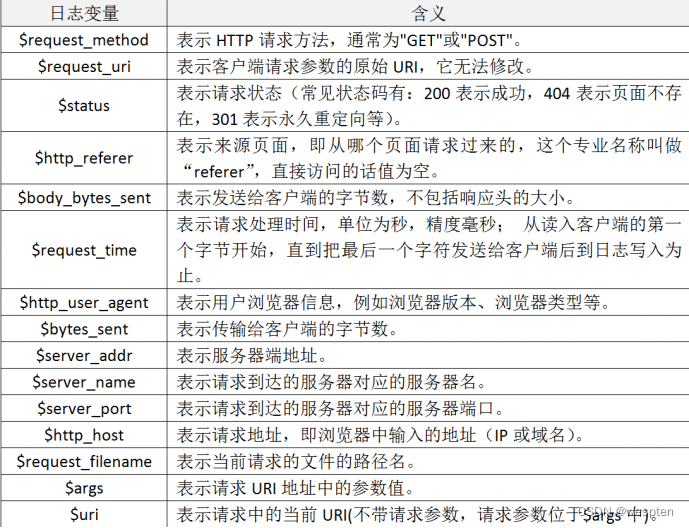

Nginx日志说明:

192.168.237.1 - - [24/Feb/2021:17:48:47 +0800] "GET /yyds HTTP/1.1" 404 571 "-" "Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/71.0.3578.98 Safari/537.36"- 访问IP地址

- 访问时间

- 请求方式(GET/POST)

- 请求URL

- 状态码

- 响应body大小

- Referer

- User Agent

Grok提取Nginx日志:

Logstash支持普通正则和扩展正则,利用Kibana的Grok学习Logstash正则提取日志。

Grok使用(?<xxx>提取内容)来提取xxx字段。

提取客户端IP:

(?<clientip>[0-9]{1,3}\.[0-9]{1,3}\.[0-9]{1,3}\.[0-9]{1,3})提取时间:

\[(?<requesttime>[^ ]+ \+[0-9]+)\]Grok提取Nginx日志:

(?<clientip>[0-9]{1,3}\.[0-9]{1,3}\.[0-9]{1,3}\.[0-9]{1,3}) - - \[(?<requesttime>[^ ]+ \+[0-9]+)\] "(?<requesttype>[A-Z]+) (?<requesturl>[^ ]+) HTTP/\d.\d" (?<status>[0-9]+) (?<bodysize>[0-9]+) "[^"]+" "(?<ua>[^"]+)"Tomcat等日志使用类似的方法。

Logstash正则提取Nginx日志:

input {

file {

path => "/usr/local/nginx/logs/access.log"

}

}

filter {

grok {

match => {

"message" => '(?<clientip>[0-9]{1,3}\.[0-9]{1,3}\.[0-9]{1,3}\.[0-9]{1,3}) - - \[(?<requesttime>[^ ]+ \+[0-9]+)\] "(?<requesttype>[A-Z]+) (?<requesturl>[^ ]+) HTTP/\d.\d" (?<status>[0-9]+) (?<bodysize>[0-9]+) "[^"]+" "(?<ua>[^"]+)"'

}

}

}

output {

elasticsearch {

hosts => ["http://192.168.237.50:9200"]

}

}注意正则提取失败的情况,Logstash正则提取出错就不输出到ES:

output{

if "_grokparsefailure" not in [tags] and "_dateparsefailure" not in [tags] {

elasticsearch {

hosts => ["http://192.168.237.50:9200"]

}

}

}Logstash配置去除不需要的字段:

去除字段可以减小ES数据库的大小,提升搜索效率。

注意,只能去除_source里的,非_source里的去除不了。

filter {

grok {

match => {

"message" => '(?<clientip>[0-9]{1,3}\.[0-9]{1,3}\.[0-9]{1,3}\.[0-9]{1,3}) - - \[(?<requesttime>[^ ]+ \+[0-9]+)\] "(?<requesttype>[A-Z]+) (?<requesturl>[^ ]+) HTTP/\d.\d" (?<status>[0-9]+) (?<bodysize>[0-9]+) "[^"]+" "(?<ua>[^"]+)"'

}

remove_field => ["message","@version","path"]

}

}11、kibana-Discover展示时timestamp时间格式处理

使用logstash-filter-date插件:

bin/logstash-plugin list|grep date配置logstash.conf:

input {

file {

path => "/usr/local/nginx/logs/access.log"

type => "nginxaccess"

start_position => "beginning"

}

}

filter {

grok {

match => { "message" => "%{HTTPD_COMBINEDLOG}" }

}

date {

match => ["timestamp","dd/MMM/yyyy:HH:mm:ss Z"]

target => "@timestamp"

}

}

output {

stdout {

}

}

删除上次logstash记录位置:

rm /usr/local/logstash/data/plugins/inputs/file/.sincedb_d2343edad78a7252d2ea9cba15bbff6d注意@timestamp字段,在Elasticsearch内部,对时间类型字段,统一采用UTC时间,存成 long长整型。

配置logstash.conf输出到elasticsearch:

input {

file {

path => "/usr/local/nginx/logs/access.log"

type => "nginxaccess"

start_position => "beginning"

}

}

filter {

grok {

match => { "message" => "%{HTTPD_COMBINEDLOG}" }

}

date {

match => ["timestamp","dd/MMM/yyyy:HH:mm:ss Z"]

target => "@timestamp"

}

}

output {

elasticsearch {

hosts => ["127.0.0.1:9200"]

index => "nginx-%{+YYYY.MM.dd}"

}

}

默认ELK时间轴,以发送日志的时间为准,而Nginx上本身记录着用户的访问时间。

分析Nginx上的日志以用户的访问时间为准,而不以发送日志的时间:

Logstash分析所有Nginx日志:

input {

file {

path => "/usr/local/nginx/logs/access.log"

start_position => "beginning"

sincedb_path => "/dev/null"

}

}Logstash的filter里面加入配置24/Feb/2021:21:08:34 +0800:

filter {

grok {

match => {

"message" => '(?<clientip>[0-9]{1,3}\.[0-9]{1,3}\.[0-9]{1,3}\.[0-9]{1,3}) - - \[(?<requesttime>[^ ]+ \+[0-9]+)\] "(?<requesttype>[A-Z]+) (?<requesturl>[^ ]+) HTTP/\d.\d" (?<status>[0-9]+) (?<bodysize>[0-9]+) "[^"]+" "(?<ua>[^"]+)"'

}

remove_field => ["message","@version","path"]

}

date {

match => ["requesttime", "dd/MMM/yyyy:HH:mm:ss Z"]

target => "@timestamp"

}

}统计Nginx的请求和网页显示进行对比:

cat /usr/local/nginx/logs/access.log |awk '{print $4}'|cut -b 1-19|sort |uniq -c注意,不同的时间格式,覆盖的时候格式要对应:

20/Feb/2021:14:50:06 -> dd/MMM/yyyy:HH:mm:ss

2021-08-24 18:05:39,830 -> yyyy-MM-dd HH:mm:ss,SSS六、Filebeat架构

1、什么是Filebeat

Filebeat是一个开源的文本日志收集器,它是elastic公司Beats数据采集产品的一个子产品,采用go语言开发,一般安装在业务服务器上作为代理来监测日志目录或特定的日志文件,并把它们发送到logstash、elasticsearch、redis或Kafka等。

官方地址:下载 Beats:Elasticsearch 的数据采集器 | Elastic

下载各个版本的Filebeat。

2、Filebeat架构与运行原理

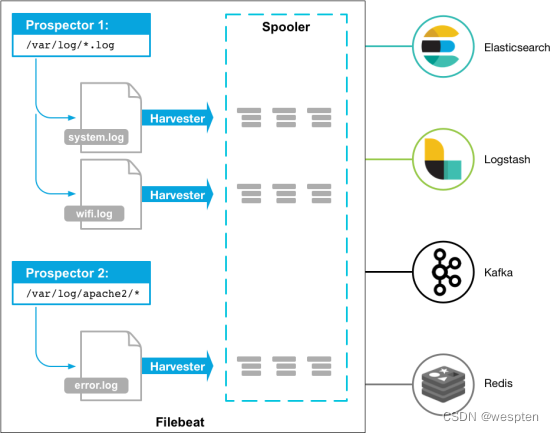

Filebeat是一个轻量级的日志监测、传输工具,它最大的特点是性能稳定、配置简单、占用系统资源很少。由于依赖于Java环境,用来收集日志比较重,占用较多内存和CPU,而Filebeat相对轻量,占用服务器资源小,这也是强烈推荐Filebeat的原因。

下图是官方给出的Filebeat架构图:

从图中可以看出,Filebeat主要由两个组件构成: prospector(探测器)和harvester(收集器)。这两类组件一起协作完成Filebeat的工作。

其中,Harvester负责进行单个文件的内容收集,在运行过程中,每一个Harvester会对一个文件逐行进行内容读取,并且把读写到的内容发送到配置的output中。当Harvester开始进行文件的读取后,将会负责这个文件的打开和关闭操作,因此,在Harvester运行过程中,文件都处于打开状态。如果在收集过程中,删除了这个文件或者是对文件进行了重命名,Filebeat依然会继续对这个文件进行读取,这时候将会一直占用着文件所对应的磁盘空间,直到Harvester关闭。

Prospector负责管理Harvster,它会找到所有需要进行读取的数据源。然后交给Harvster进行内容收集,如果input type配置的是log类型,Prospector将会去配置路径下查找所有能匹配上的文件,然后为每一个文件创建一个Harvster。

综上所述,filebeat的工作流程为:当开启filebeat程序的时候,它会启动一个或多个探测器(prospector)去检测指定的日志目录或文件,对于探测器找出的每一个日志文件,filebeat会启动收集进程(harvester),每一个收集进程读取一个日志文件的内容,然后将这些日志数据发送到后台处理程序(spooler),后台处理程序会集合这些事件,最后发送集合的数据到output指定的目的地。

3、Filebeat下载安装

源码编译安装:

cd /usr/local/src/

tar -zxf filebeat-7.4.0-linux-x86_64.tar.gz

mv filebeat-7.4.0-linux-x86_64 /usr/local/filebeat-7.4.0启动Filebeat:

前台启动:

/usr/local/filebeat-6.6.0/filebeat -e -c /usr/local/filebeat-6.6.0/filebeat.yml后台启动:

nohup /usr/local/filebeat-7.4.0/filebeat -e -c /usr/local/filebeat-7.4.0/filebeat.yml >/tmp/filebeat.log 2>&1 &RPM 安装:

[root@web01 ~]# rpm -ivh filebeat-7.4.0-x86_64.rpm启动:

systemctl enable filebeat

systemctl start filebeat4、Filebeat配置

将文件最新发生变化的内容,存入es:

cat /usr/local/filebeat-6.6.0/filebeat.yml

filebeat.inputs:

- type: log

tail_files: true

backoff: "1s"

paths:

- /usr/local/nginx/logs/access.log

enabled: true

output:

elasticsearch:

hosts: ["192.168.237.50:9200"]

setup.template.name: nginx

setup.template.pattern: nginx-*5、收集系统日志

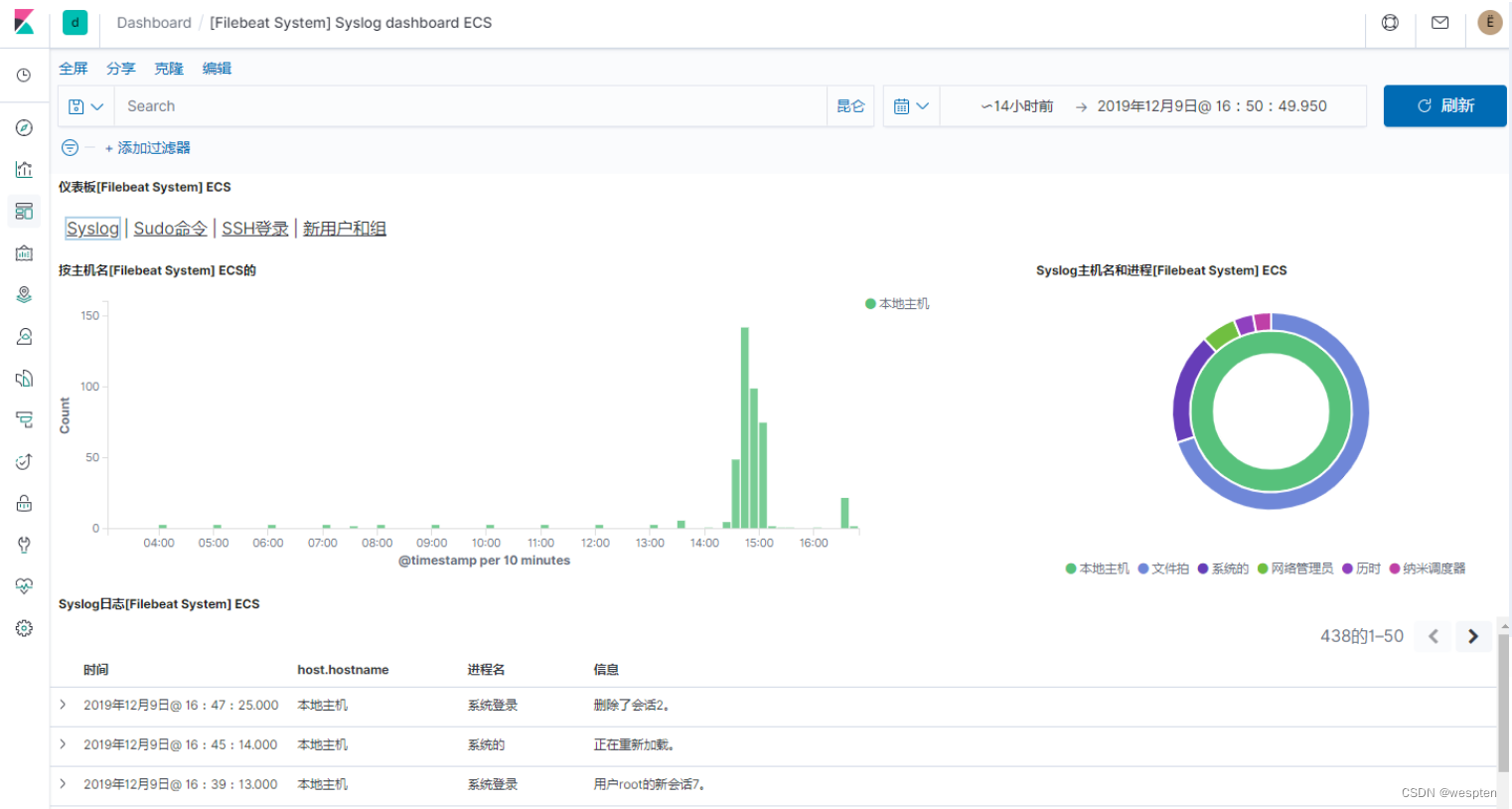

系统日志一般指的是messages,secure,cron,dmesg,boot,ssh等日志,需要对系统日志进行统一、集中的管理。

统一日志管理作用:

- 减少无用的数据

- 调整索引名称

- 测试调整模板,设定分片

通过rsyslog收集本地所有类型的日志,然后使用filebeat对该文件进行分收集即可。

安装rsyslog:

[root@web01 ~]# yum install rsyslog -y配置rsyslog:

[root@web01 ~]# vim /etc/rsyslog.conf

#配置日志收集的方式

...

*.* /var/log/oldxu.log #将本地所有日志保存至本地/var/log/oldxu.log

...重启rsyslog:

[root@web01 ~]# systemctl enable rsyslog

[root@web01 ~]# systemctl start rsyslog测试:

root@web01 ~]# cat /etc/filebeat/filebeat.yml

filebeat.inputs:

- type: log

enabled: true

paths:

- /var/log/oldxu.log

include_lines: ['^ERR', '^WARN', 'sshd'] #只看指定的日志

output.elasticsearch:

hosts: ["10.0.0.161:9200","10.0.0.162:9200","10.0.0.163:9200"]

index: "system-%{[agent.version]}-%{+yyyy.MM.dd}"

setup.ilm.enabled: false

setup.template.name: system #索引关联的模板名称

setup.template.pattern: system-*

方式一:

###设定system模板的分片数和副本数

#setup.template.settings: #定义索引分片数和副本

# index.number_of_shards: 3

# index.number_of_replicas: 1

方式二:

"number_of_routing_shards": "30",

"number_of_shards": "10",

"number_of_replicas": "1",

1.修改system模板 ---> 添加 shards 分片数数量,replicas的数量

2.删除模板关联的索引

3.删除filebeat自行指定的分片数和副本数

4.重启filebeat

5.产生新的日志6、收集nginx日志

编写配置文件:

[root@web01 nginx]# vim nginx.conf

...

log_format json '{ "time_local": "$time_local", '

'"remote_addr": "$remote_addr", '

'"referer": "$http_referer", '

'"request": "$request", '

'"status": $status, '

'"bytes": $body_bytes_sent, '

'"agent": "$http_user_agent", '

'"x_forwarded": "$http_x_forwarded_for", '

'"up_addr": "$upstream_addr",'

'"up_host": "$upstream_http_host",'

'"upstream_time": "$upstream_response_time",'

'"request_time": "$request_time"'

'}';

access_log /var/log/nginx/access.log json;

...配置nginx站点目录:

[root@web01 conf.d]# cat elk.oldxu.com.conf

server {

listen 80;

server_name elk.oldxu.com;

root /code/elk;

access_log /var/log/nginx/elk.oldxu.com.log json;

location / {

index index.html;

}

}

[root@web01 conf.d]# cat bk.oldxu.com.conf

server {

listen 80;

server_name bk.oldxu.com;

root /code/bk;

access_log /var/log/nginx/bk.oldxu.com.log json;

# error_log /var/log/nginx/blog_error.log;

location / {

index index.php index.html;

}

}

[root@web01 conf.d]# cat bs.oldxu.com.conf

server {

listen 80;

server_name bs.oldxu.com;

root /code/bs;

access_log /var/log/nginx/bs.oldxu.com.log json;

# error_log /var/log/nginx/blog_error.log;

location / {

index index.php index.html;

}

}测试,模拟产生日志:

[root@web01 conf.d]# curl -H Host:elk.oldxu.com http://10.0.0.7

elk.oldux.com

[root@web01 conf.d]# curl -H Host:bs.oldxu.com http://10.0.0.7

bs.oldux.com

[root@web01 conf.d]# curl -H Host:bk.oldxu.com http://10.0.0.7

bk.oldux.com配置filebeat:

[root@web01 filebeat]# cat filebeat.yml

filebeat.inputs:

- type: log

enabled: true

paths:

- /var/log/nginx/elk.oldxu.com.log

json.keys_under_root: true

json.overwrite_keys: true

tags: ["nginx-elk-host"]

- type: log

enabled: true

paths:

- /var/log/nginx/bs.oldxu.com.log

json.keys_under_root: true

json.overwrite_keys: true

tags: ["nginx-bs-host"]

- type: log

enabled: true

paths:

- /var/log/nginx/bk.oldxu.com.log

json.keys_under_root: true

json.overwrite_keys: true

tags: ["nginx-bk-host"]

- type: log

enabled: true

paths:

- /var/log/nginx/error.log

tags: ["nginx-error"]

output.elasticsearch:

hosts: ["10.0.0.161:9200","10.0.0.162:9200","10.0.0.163:9200"]

indices:

- index: "nginx-elk-access-%{[agent.version]}-%{+yyyy.MM.dd}"

when.contains:

tags: "nginx-elk-host"

- index: "nginx-bs-access-%{[agent.version]}-%{+yyyy.MM.dd}"

when.contains:

tags: "nginx-bs-host"

- index: "nginx-bk-access-%{[agent.version]}-%{+yyyy.MM.dd}"

when.contains:

tags: "nginx-bk-host"

- index: "nginx-error-%{[agent.version]}-%{+yyyy.MM.dd}"

when.contains:

tags: "nginx-error"

setup.ilm.enabled: false

setup.template.name: nginx #索引关联的模板名称

setup.template.pattern: nginx-*7、收集Tomcat日志

安装tomcat:

#上传apache-tomcat-9.0.27.tar.gz

#解压

mkdir /soft

tar xf apache-tomcat-9.0.27.tar.gz -C /soft

ln -s apache-tomcat-9.0.27 tomcat编辑tomcat配置文件:

vim /soft/tomcat/conf/server.xml

<Host name="tomcat.oldxu.com" appBase="/code/tomcat"

unpackWARs="true" autoDeploy="true">

<Valve className="org.apache.catalina.valves.AccessLogValve" directory="logs"

prefix="tomcat.oldxu.com.log" suffix=".txt"

pattern="{"clientip":"%h","ClientUser":"%l","authenticated":"%u","AccessTime":"%t","method":"%r","status":"%s","SendBytes":"%b","Query?string":"%q","partner":"%{Referer}i","AgentVersion":"%{User-Agent}i"}" />

</Host>配置filebeat:

[root@web02 filebeat]# vim filebeat.yml

filebeat.inputs:

- type: log

enabled: true

paths:

- /soft/tomcat/logs/tomcat.oldxu.com.log.*.txt

json.keys_under_root: true #默认Flase,还会将json解析的日志存储至messages字段

json.overwrite_keys: true #覆盖默认的key,使用自定义json格式的key

tags: ["tomcat-access"]

- type:

enabled: true

paths:

- /soft/tomcat/logs/catalina.out

multiline.pattern: '^\d{2}' #匹配以2数字开头的

multiline.negate: true

multiline.match: after

multiline.max_lines: 10000 #默认最大合并行为500,可根据实际情况调整

tags: ["tomcat-error"]

output.elasticsearch:

hosts: ["10.0.0.161:9200","10.0.0.162:9200"]

indices:

- index: "tomcat-access-%{[agent.version]}-%{+yyyy.MM.dd}"

when.contains:

tags: "tomcat-access"

- index: "tomcat-error-%{[agent.version]}-%{+yyyy.MM.dd}"

when.contains:

tags: "tomcat-error"

setup.ilm.enabled: false

setup.template.name: tomcat #索引关联的模板名称

setup.template.pattern: tomcat-*Kibana上查看日志数据:

创建索引观察:

GET /xxx/_search?q=*注意:Filebeat -> ES -> Kibana只是和查看日志,不适合具体日志分析。

8、Filebeat+Logstash新框架

Filebeat和Logstash对比

- Filebeat:轻量级,但不支持正则、不能移除字段等。

- Logstash:比较重,但支持正则、支持移除字段等。

新架构说明:

单体:

Logstash -> Elasticsearch -> Kibana

Filebeat -> Elasticsearch -> Kibana

Filebeat -> Logstash -> Elasticsearch -> Kibana

集群:

Filebeat(多台)

Filebeat(多台) -> Logstash(正则) -> Elasticsearch(入库) -> Kibana展现

Filebeat(多台) Filebeat批量部署比Logstash要方便得多,Logstash监听在内网,Filebeat发送给内网的Logstash。

Filebeat配置发往Logstash:

filebeat.inputs:

- type: log

tail_files: true

backoff: "1s"

paths:

- /usr/local/nginx/logs/access.log

output:

logstash:

hosts: ["192.168.237.51:5044"]Logstash配置监听在5044端口,接收Filebeat发送过来的日志:

input {

beats {

host => '0.0.0.0'

port => 5044

}

}Kibana上查看数据:

GET /xxx/_search?q=*创建索引查看数据。

Filebeat发过来的无用字段比较多,要在Logstash上移除不必要的字段:

remove_field => ["message","@version","path","beat","input","log","offset","prospector","source","tags"]9、Json格式日志采集

原生日志需要做正则匹配,比较麻烦,Json格式的日志不需要正则能直接分段采集。

Nginx使用Json格式日志:

log_format json '{"@timestamp":"$time_iso8601",'

'"clientip":"$remote_addr",'

'"status":$status,'

'"bodysize":$body_bytes_sent,'

'"referer":"$http_referer",'

'"ua":"$http_user_agent",'

'"handletime":$request_time,'

'"url":"$uri"}';

access_log logs/access.log;

access_log logs/access.json.log json;Filebeat采集Json格式的日志:

filebeat.inputs:

- type: log

tail_files: true

backoff: "1s"

paths:

- /usr/local/nginx/logs/access.json.log

output:

logstash:

hosts: ["192.168.237.51:5044"]Logstash正则提取的配置备份:

filter {

grok {

match => {

"message" => '(?<clientip>[0-9]{1,3}\.[0-9]{1,3}\.[0-9]{1,3}\.[0-9]{1,3}) - - \[(?<requesttime>[^ ]+ \+[0-9]+)\] "(?<requesttype>[A-Z]+) (?<requesturl>[^ ]+) HTTP/\d.\d" (?<status>[0-9]+) (?<bodysize>[0-9]+) "[^"]+" "(?<ua>[^"]+)"'

}

remove_field => ["message","@version","path","beat","input","log","offset","prospector","source","tags"]

}

date {

match => ["requesttime", "dd/MMM/yyyy:HH:mm:ss Z"]

target => "@timestamp"

}

}Logstash解析Json日志:

input {

beats {

host => '0.0.0.0'

port => 5044

}

}

filter {

json {

source => "message"

remove_field => ["message","@version","path","beat","input","log","offset","prospector","source","tags"]

}

}

output {

elasticsearch {

hosts => ["http://192.168.237.50:9200"]

}

}10、Filebeat采集多个日志配置

Filebeat默认收集单个Nginx日志,如何采集多个日志?

Filebeat采集多个日志配置:

filebeat.inputs:

- type: log

tail_files: true

backoff: "1s"

paths:

- /usr/local/nginx/logs/access.json.log

fields:

type: access

fields_under_root: true

- type: log

tail_files: true

backoff: "1s"

paths:

- /var/log/secure

fields:

type: secure

fields_under_root: true

output:

logstash:

hosts: ["192.168.237.51:5044"]Filebeat 加入一字段,Logstash使用区别字段来区分两字段:

Logstash通过type字段进行判断:

input {

beats {

host => '0.0.0.0'

port => 5044

}

}

filter {

if [type] == "access" {

json {

source => "message"

remove_field => ["message","@version","path","beat","input","log","offset","prospector","source","tags"]

}

}

}

output{

if [type] == "access" {

elasticsearch {

hosts => ["http://192.168.237.50:9200"]

index => "access-%{+YYYY.MM.dd}"

}

}

else if [type] == "secure" {

elasticsearch {

hosts => ["http://192.168.237.50:9200"]

index => "secure-%{+YYYY.MM.dd}"

}

}

}11、架构优化引入Redis

原先的架构Logstash性能不足的时候,扩容Logstash,Filebeat的配置可能会不一致。

优化架构为:

Filebeat(多台) Logstash

Filebeat(多台) -> Redis、Kafka -> Logstash(正则) -> Elasticsearch(入库) -> Kibana展现

Filebeat(多台) LogstashRedis编译安装:

yum install -y wget net-tools gcc gcc-c++ make tar openssl openssl-devel cmake

cd /usr/local/src

wget 'http://download.redis.io/releases/redis-4.0.9.tar.gz'

tar -zxf redis-4.0.9.tar.gz

cd redis-4.0.9

make

mkdir -pv /usr/local/redis/conf /usr/local/redis/bin

cp src/redis* /usr/local/redis/bin/

cp redis.conf /usr/local/redis/confRedis的启动命令:

/usr/local/redis/bin/redis-server /usr/local/redis/conf/redis.conf验证Redis服务器:

更改Redis配置(daemon、dir、requirepass),进行set、get操作:

/usr/local/redis/bin/redis-cli

auth 'yyds'

set name yyds

get nameFilebeat配置写入到Redis:

filebeat.inputs:

- type: log

tail_files: true

backoff: "1s"

paths:

- /usr/local/nginx/logs/access.json.log

fields:

type: access

fields_under_root: true

output:

redis:

hosts: ["192.168.237.51"]

port: 6379

password: 'yyds'

key: 'access'Logstash从Redis中读取数据:

input {

redis {

host => '192.168.237.51'

port => 6379

key => "access"

data_type => "list"

password => 'yyds'

}

}12、架构优化引入Kafka

kafka依赖于Zookeeper,两个都依赖于Java。

下载Zookeeper:Apache ZooKeeper

安装Zookeeper:

tar -zxf zookeeper-3.4.13.tar.gz

mv zookeeper-3.4.13 /usr/local/

cp /usr/local/zookeeper-3.4.13/conf/zoo_sample.cfg /usr/local/zookeeper-3.4.13/conf/zoo.cfg更改配置:

clientPortAddress=0.0.0.0启动Zookeeper:

/usr/local/zookeeper-3.4.13/bin/zkServer.sh start下载Kafka:Apache Kafka

安装Kafka:

cd /usr/local/src/

tar -zxf kafka_2.11-2.1.1.tgz

mv kafka_2.11-2.1.1 /usr/local/kafka_2.11Kafka的启动:

先修改kafka的配置,更改监听地址、更改连接zk的地址等。

前台启动:

/usr/local/kafka_2.11/bin/kafka-server-start.sh /usr/local/kafka_2.11/config/server.properties启动kafka:

nohup /usr/local/kafka_2.11/bin/kafka-server-start.sh /usr/local/kafka_2.11/config/server.properties >/tmp/kafka.log 2>&1 &

Filebeat日志发送到Kafka:

filebeat.inputs:

- type: log

tail_files: true

backoff: "1s"

paths:

- /usr/local/nginx/logs/access.json.log

fields:

type: access

fields_under_root: true

output:

kafka:

hosts: ["192.168.237.51:9092"]

topic: yydsLogstash读取Kafka:

input {

kafka {

bootstrap_servers => "192.168.237.51:9092"

topics => ["yyds"]

group_id => "yyds"

codec => "json"

}

}

filter {

if [type] == "access" {

json {

source => "message"

remove_field => ["message","@version","path","beat","input","log","offset","prospector","source","tags"]

}

}

}

output {

stdout {

codec=>rubydebug

}

}Kafka查看队列信息:

查看Group:

./kafka-consumer-groups.sh --bootstrap-server 192.168.237.51:9092 --list查看队列:

./kafka-consumer-groups.sh --bootstrap-server 192.168.237.51:9092 --group yyds --describe七、Kibana架构

1、Kibana下载安装

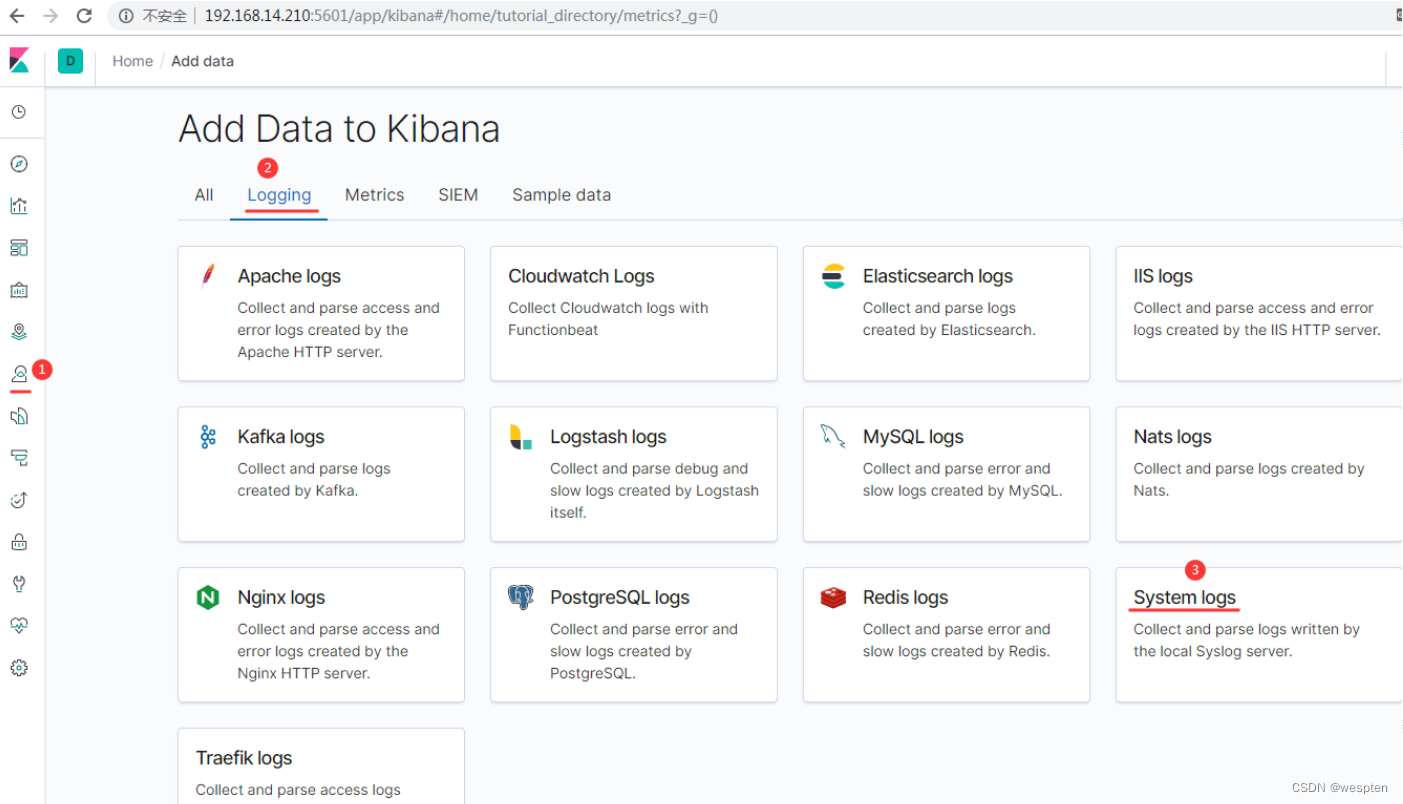

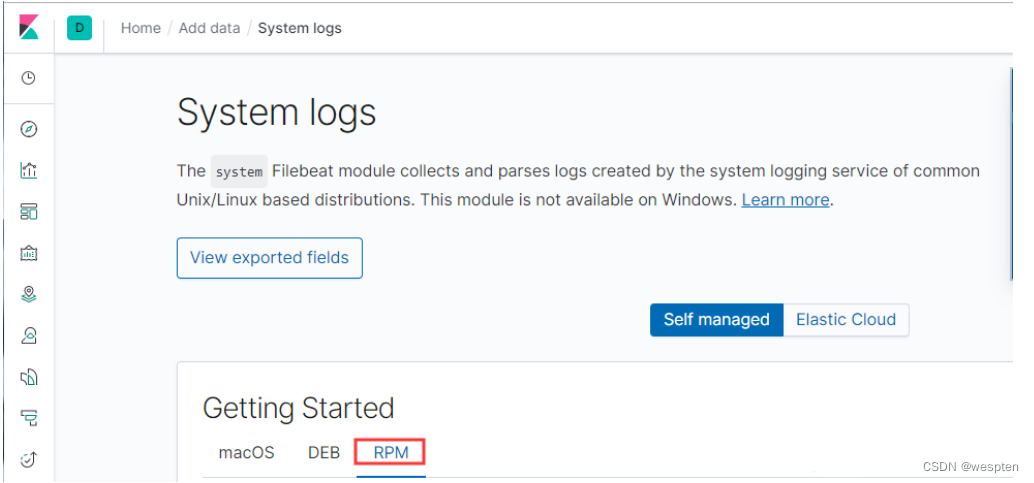

我们可以前往Elasticsearch的官网下载Kibana,下载地址为:Download Kibana Free | Get Started Now | Elastic,网页如下所示:

RPM安装包安装:

yum localinstall -y kibana-6.8.1-x86_64.rpm 源码编译安装:

cd /usr/local/src/

tar -zxf kibana-6.8.1-linux-x86_64.tar.gz

mv kibana-6.8.1-linux-x86_64 /usr/local/kibana-6.8.12、Kibana配置与启动

接下来,我们来配置以下Kibana,打开Kibana的配置文件kibana.yml,修改其中的server.port、server.host、elasticsearch.hosts以及i18n.locale,分别将其修改为5601端口、本地IP地址,Elasticsearch集群中任意一台设备的IP地址,以及zh-CN。

/usr/local/kibana-6.8.1/config/kibana.yml

server.port: 5601

server.host: "0.0.0.0"

#elasticsearch.url: "http://localhost:9200"

#elasticsearch.username: "user"

#elasticsearch.password: "pass"

i18n.locale:"zh-CN"注:rpm安装,配置文件在/etc/kibana/kibana.yml。

3、Kibana的启动和访问

rpm安装,启动方式:

systemctl start kibana源码编译安装:

前台启动:

/usr/local/kibana-6.8.1/bin/kibana后台启动Kibana:

nohup /usr/local/kibana-6.8.1/bin/kibana >/tmp/kibana.log 2>/tmp/kibana.log &需要开放5601端口:

访问Kibana,您可以通过localhost:5601/status来访问 Kibana 的服务器状态页,状态页展示了服务器资源使用情况和已安装插件列表。

4、Kibana的安全认证

在使用ELK进行日志统计的时候,由于Kibana自身并没有身份验证的功能,任何人只要知道链接地址就可以正常登录到Kibana控制界面。

由于日常的查询,添加日志和删除日志都是在同一个web 中进行,这样就有极高的安全隐患。任何人都有权限对其进行修改。

为了避免这一问题,可以使用Nginx的验证功能来代理Kibana。

如果使用云厂商,可以在安全组控制某个IP的访问。

1)Nginx编译安装

yum install -y lrzsz wget gcc gcc-c++ make pcre pcre-devel zlib zlib-devel

cd /usr/local/src

wget 'http://nginx.org/download/nginx-1.14.2.tar.gz'

tar -zxvf nginx-1.14.2.tar.gz

cd nginx-1.14.2

./configure --prefix=/usr/local/nginx && make && make installNginx环境变量设置:

export PATH=$PATH:/usr/local/nginx/sbin/2)编辑kibana的配置文件

对server.basePath进行定义,配置路径,然后重启kibana。

vim /etc/kibana/kibana.yml

修改参数如下:

server.basePath: "/kibana"

server.host: "10.0.101.100" #此配置下,如果要限制外部用户直接访问本机的5601端口,可以使用iptables进行限制(但因我的Nginx和Kibana不在同一台服务器,所以不进行限制,如果在同一台服务器上,则可以把属性值设为127.0.0.1,然后进行5601端口限制)注:如果 server.host: "127.0.0.1" ,则禁止了外部用户直接访问kibana页面。

3)Nginx两种限制

1. 限制源IP访问,比较安全,访问的IP得不变;

2. 使用用户名密码的方式,通用;

Nginx限制源IP访问:

cat /usr/local/nginx/conf/nginx.conf

log_format main '$remote_addr - $remote_user [$time_local] "$request" '

'$status $body_bytes_sent "$http_referer" '

'"$http_user_agent" "$http_x_forwarded_for"';

access_log logs/access.log main;

server {

listen 80;

server_name 172.24.115.4;

location /kibana/ {

proxy_pass http://10.0.101.100:5601/;

proxy_set_header Host $host:$server_port;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

rewrite ^/kibana/(.*)$ /$1 break;

}

}注:上面的kibana要和kibana.yml中的server.basePath属性值保持一样。

访问测试:

最终访问http://172.24.115.4/kibana/便可以访问到代理的Kibana。

观察访问日志:

/usr/local/nginx/logs/access.log

如果被拒绝了可以在日志里找到源IP。

Nginx配置使用用户名密码的方式:

准备密码文件:

// 安装工具包

yum install httpd-tools

// 生成密码,用户名 admin

htpasswd -c /usr/local/nginx/conf/kibanauser admin

# 提示输入2遍密码

New password:

Re-type new password:

Adding password for user adminhtpasswd命令参数如下:

-c 创建passwdfile.如果passwdfile 已经存在,那么它会重新写入并删去原有内容.

-n 不更新passwordfile,直接显示密码

-m 使用MD5加密(默认)

-d 使用CRYPT加密(默认)

-p 使用普通文本格式的密码

-s 使用SHA加密

-b 命令行中一并输入用户名和密码而不是根据提示输入密码,可以看见明文,不需要交互

-D 删除指定的用户修改Nginx配置文件,增加登陆认证配置,然后重启Nginx:

# cat /usr/local/nginx/conf/nginx.conf

server {

listen 80;

server_name 172.24.115.4;

location /kibana/ {

auth_basic "secret";

auth_basic_user_file /usr/local/nginx/conf/kibanauser;

proxy_pass http://10.0.101.100:5601/;

proxy_set_header Host $host:$server_port;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

rewrite ^/kibana/(.*)$ /$1 break;

}

}再次访问http://172.24.115.4/kibana/,会提示输入用户名和密码:

5、Kibana绘图展示

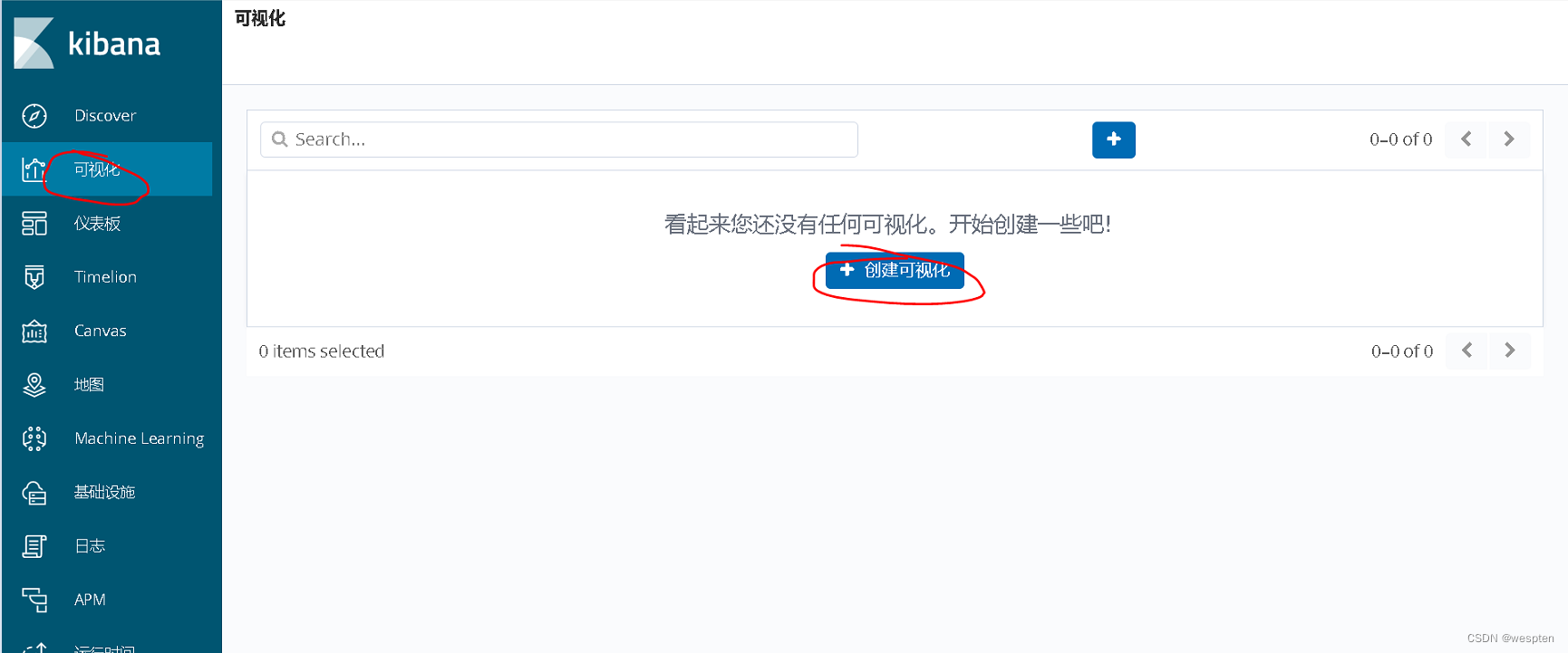

Kibana的真正作用是数据的可视化。

首先,我们来绘制一下标签云视图。

进入Kibana后,选择左边的“可视化”标签,然后点击中间的创建可视化,如下所示:

然后,我们创建可视化的类型,如下所示:

选择标签云图后,我们来选择索引,如下所示:

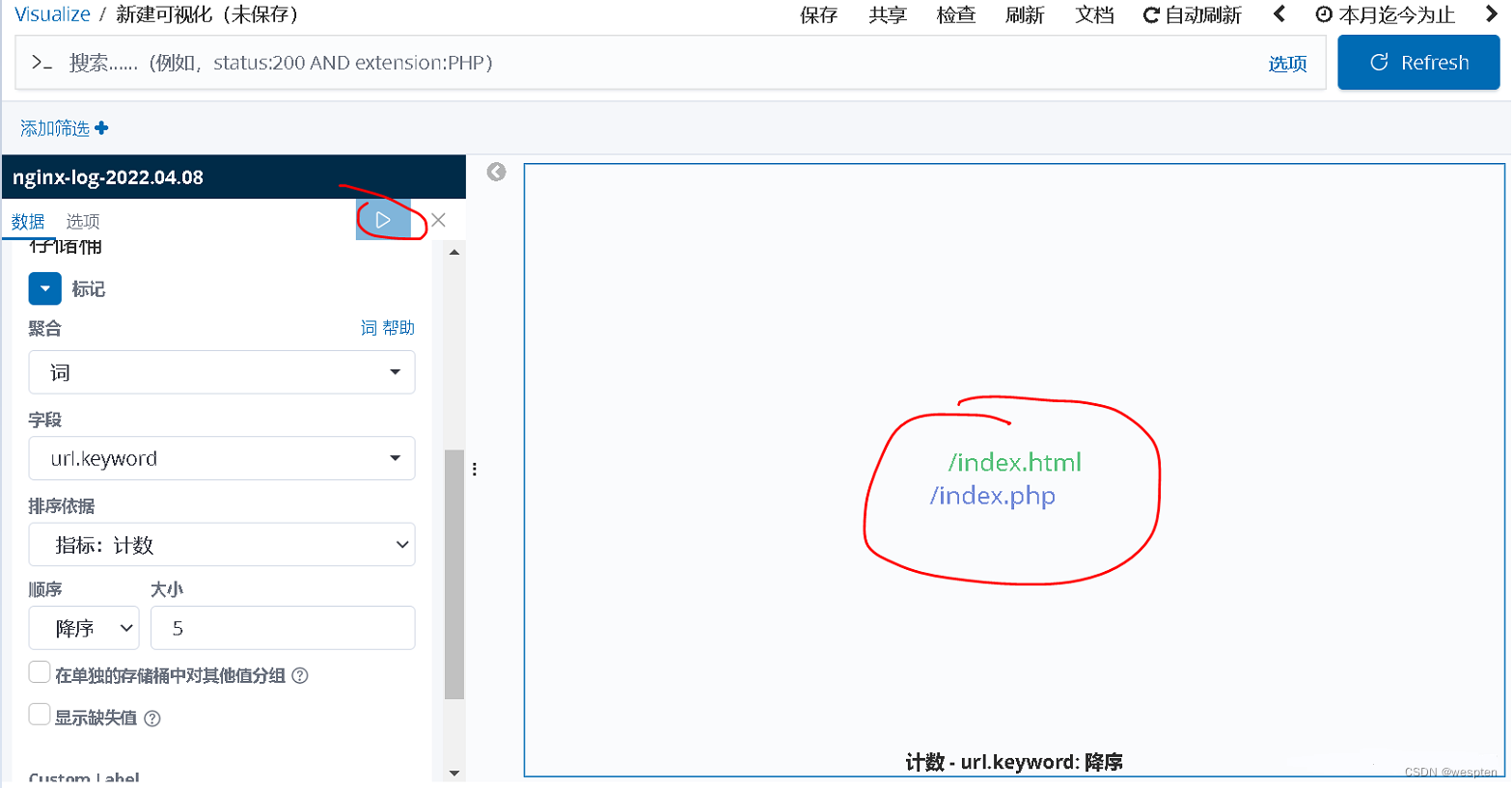

之后,我们来添加一些参数,指定绘图的一些根据,如下所示:

最后,我们点击右上角的蓝底白色三角符号,会生成视图的预览,如下所示:

我们觉得合适之后,点击上方的保存,即可保存我们创建的视图。

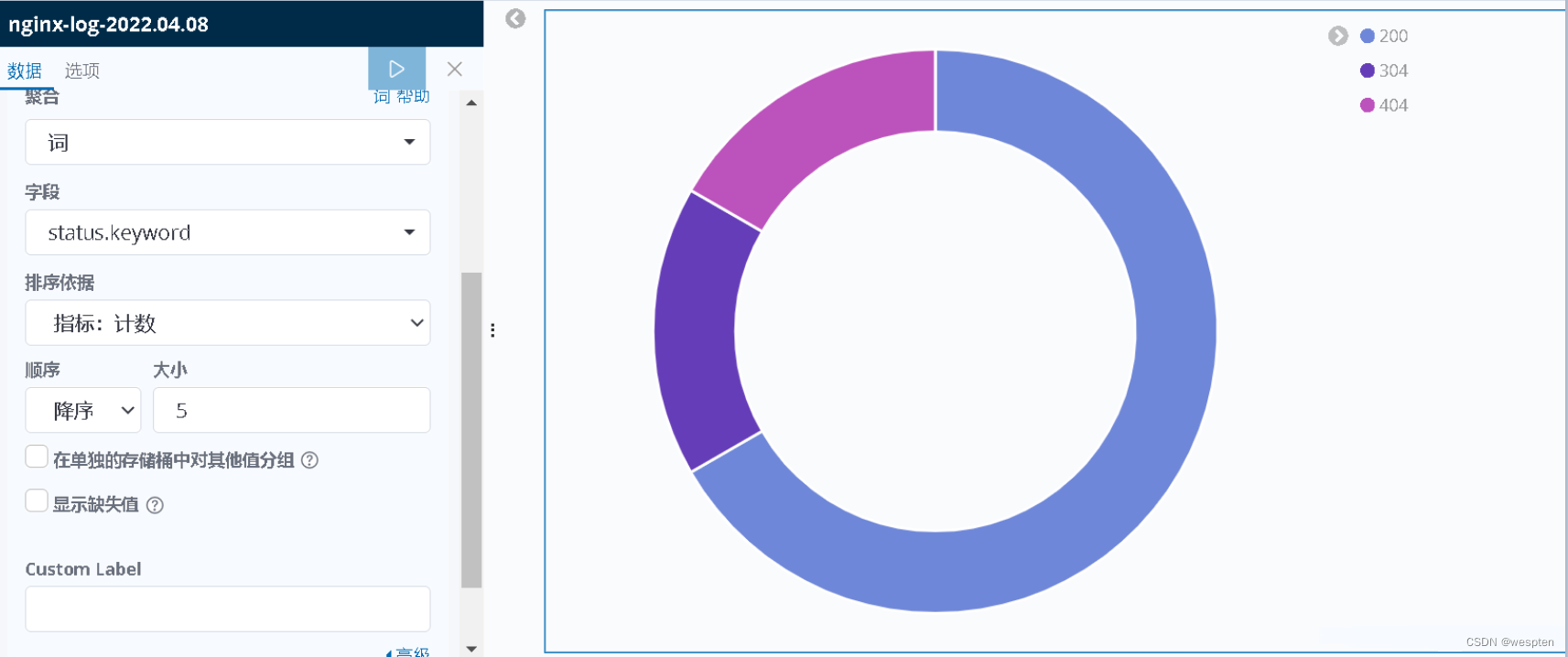

接下来,我们来绘制一下饼状图。

与标签云图的创建过程类似,我们选择好创建视图的类型和索引后,选择视图的参数,如下所示:

绘制处的饼状图如下所示:

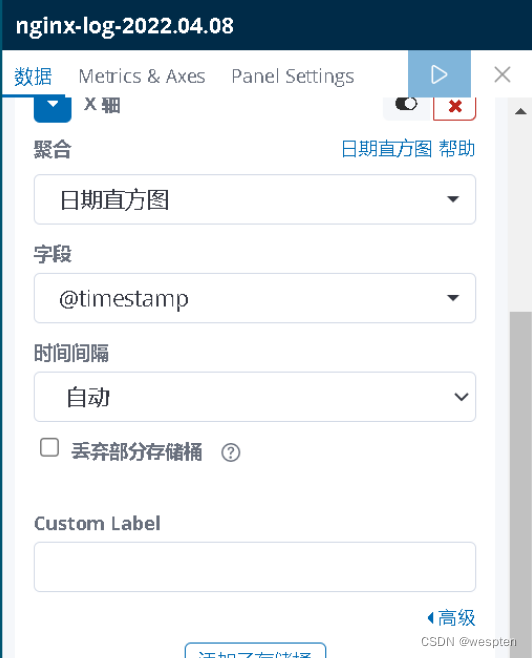

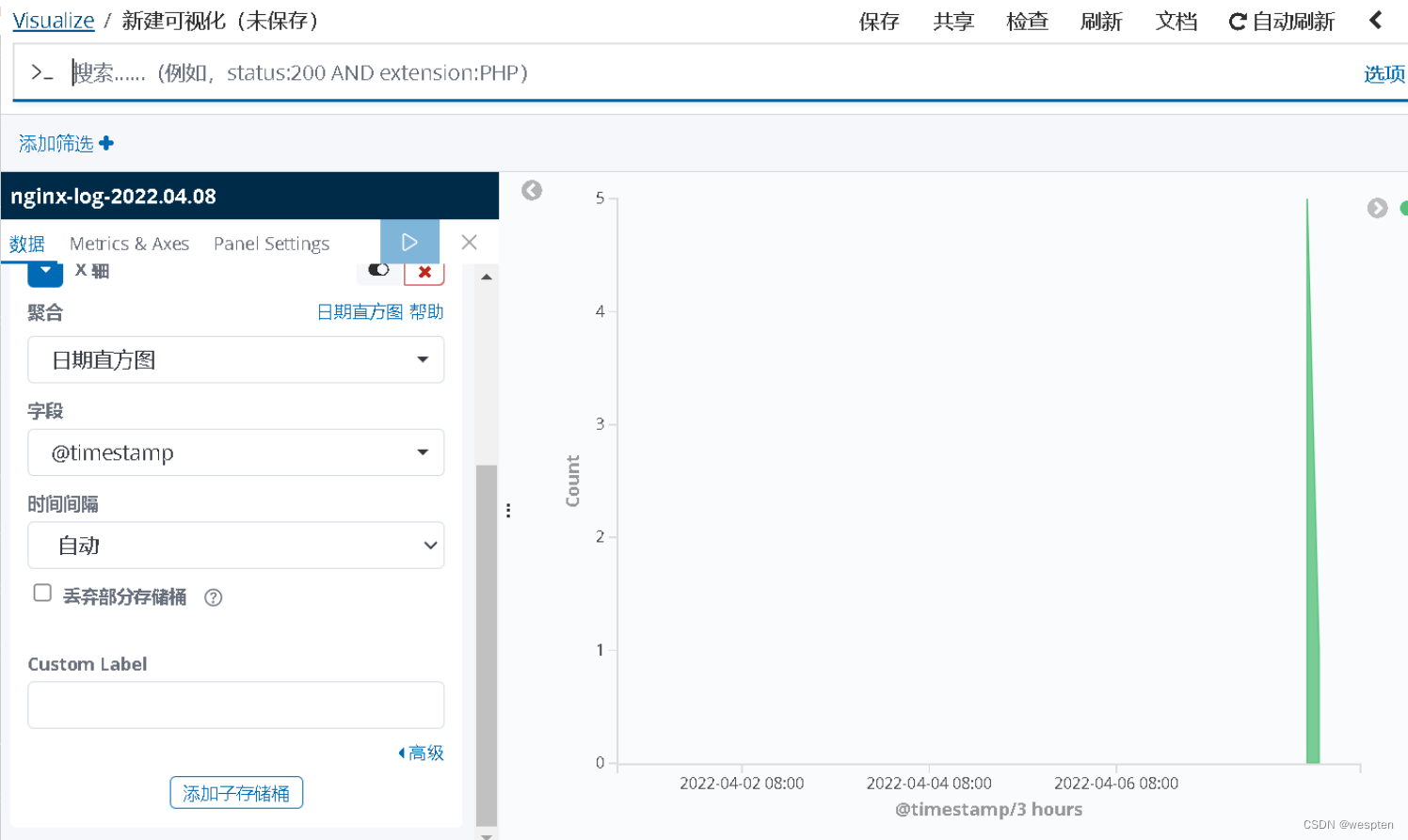

接下来,我们来绘制一下日志条数图。

在这里,我们选择列表的类型,添加参数如下:

绘图结果如下:

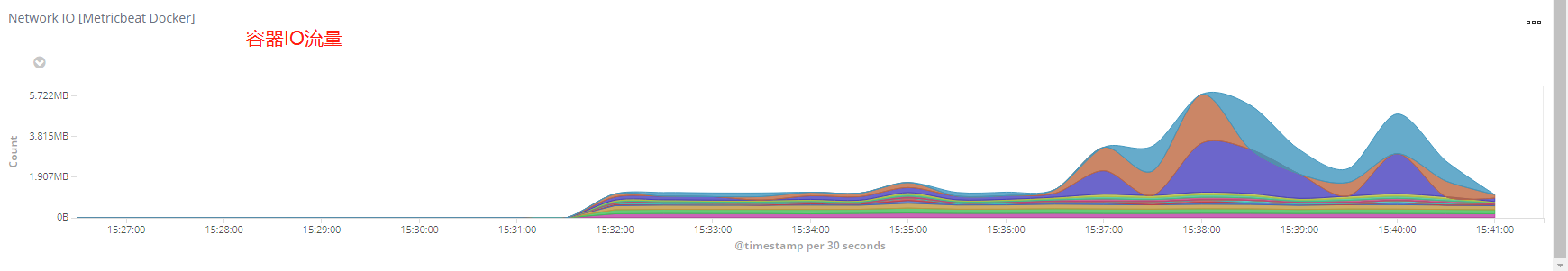

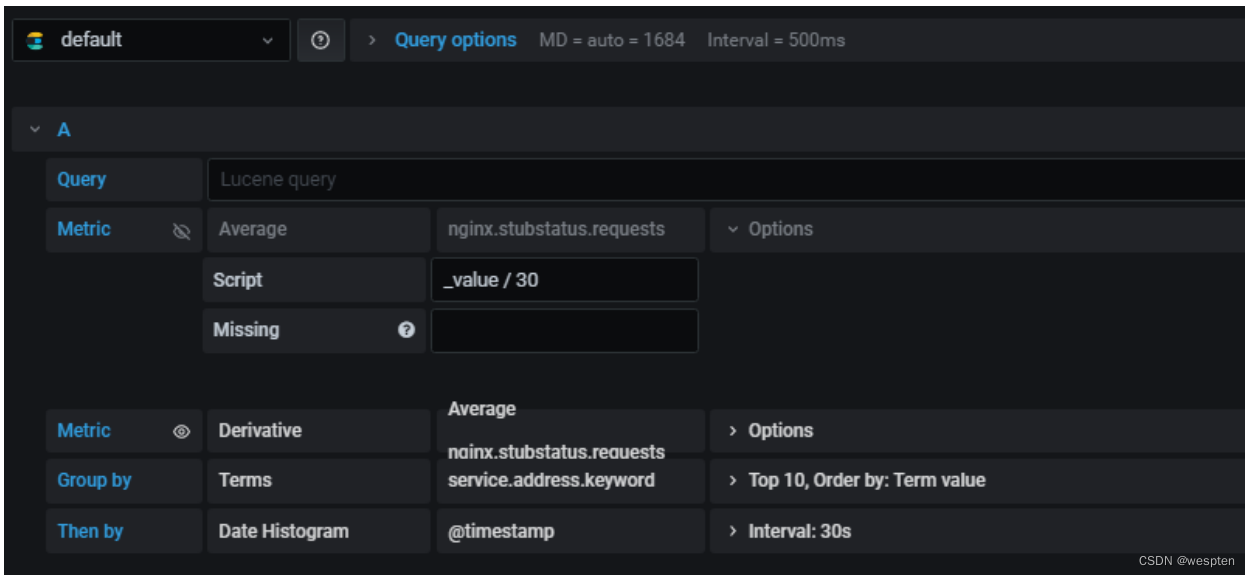

接下来,我们来绘制一下网络流量监控图。

该图的绘制与上类似,绘图参数如下:

绘图结果如下:

接下来,我们来绘制一下异常状态图。

绘图参数如下:

最后,我们把上述所有视图结合在一起进行展示。

点击Kibana右边的“仪表盘”页面,然后选择创建新的仪表盘,如下所示:

之后,我们选择“添加”,如下所示:

在弹出的窗口中,我们选择好要添加的视图,这些视图就是在上面我们创建的视图,如下所示:

添加完成后,最终仪表盘上出现了我们创建的视图,如下所示:

注意,由于我的日志数量比较少,因此呈现出来效果较差,一个生产环境中的Kibana仪表盘结果如下所示:

使用geoip画访问地域热图:

kibana支持绘制热点地图,所谓热点地图,即根据访问日志的客户端IP地址信息,在一张地图上画出访问客户端的来源,并根据不同的来源密度给予不同的颜色。这样,就可以直观的体现我们服务的客户端地域来源。

要实现这个功能,我们就必须能够根据IP地址来得到该IP地址的地理位置。geoip就是这样一个信息库,我们可以借助geoip来实现热点地图的绘制。

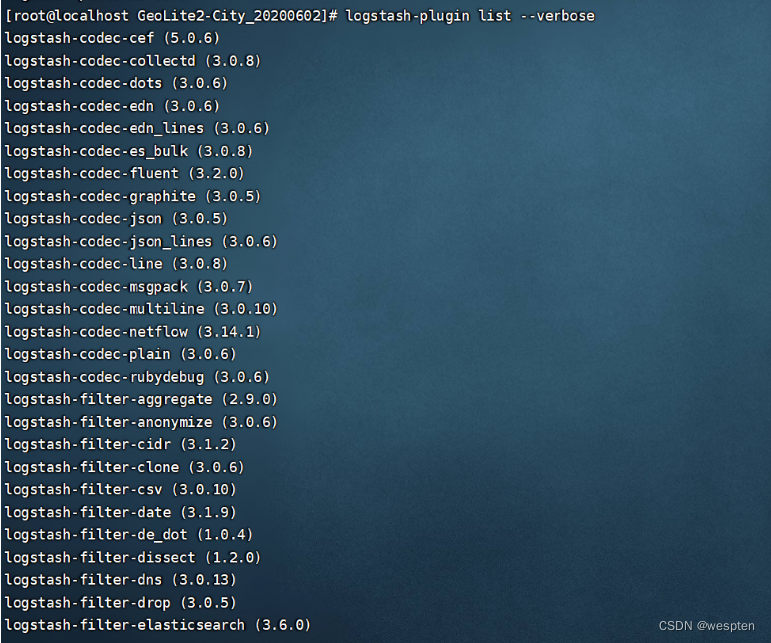

首先,我们来安装一下我们的geoip插件。首先,下载geoip的插件安装包,然后解压。进入解药后的目录后,将mmdb文件放到/etc/elasticsearch/目录下。然后,我们查看logstash的可用插件,执行命令:

logstash-plugin list --verbose执行结果如下所示:

然后,我们安装相关插件,执行命令:

logstash-plugin install logstash-filter-geoip

logstash-plugin install logstash-filter-mutate

logstash-plugin install logstash-filter-useragent执行结果如下所示:

在Logstash的插件安装完成后,接下来,我们来配置Logstash的配置文件,其内容如下所示:

input{

file{

path=>"/var/log/nginx/access.log"

type=>"geoip"

codec=>json

}

}

filter{

geoip{

source=>"clientip"

database=>"/etc/logstash/GeoLite2-City.mmdb"

fields=>["country_name","region_name","city_name","location"]

}

}

output{

elasticsearch{

hosts=>["192.168.136.101:9200"]

index=>"logstash-geoip-%{+YYYY.MM.dd}"

}

}

在上述配置中,input和output相关内容我们在前面的文章中已经详细讲解过,在这里就不过多赘述了。在filter中,我们使用了geoip的过滤插件,并只保留了国家、城市、省份、坐标这四个信息,source参数我们使用的是指定查询日志中的客户端IP地址字段的名称。

完成配置后,我们执行命令:

logstash -f /etc/elasticsearch/conf.d/geoip.conf

Kibana上得到的索引内容如下:

最后,我们使用Kibana来绘图展示一下效果。

首先,我们创建一个坐标地图的可视化,如下所示:

接下来,我们选择默认的数据选项,就可以得到一张地域热图了,结果如下所示:

可以看出,利用Kibana,我们可以绘制处非常绚丽的图标,实现数据可视化的需求。

更多详情,请参考官网:安装 Kibana | Kibana 用户手册 | Elastic

八、快速搭建一套稳定的ELK环境

安装过程可根据官网指导文档:免费且开放的搜索:Elasticsearch、ELK 和 Kibana 的开发者 | Elastic

Welcome to Elastic Docs | Elastic

1、基础环境介绍

系统: Centos7.1

防火墙: 关闭

Sellinux: 关闭

机器环境: 两台

elk-node1: 192.168.1.110 #master机器

elk-node2:192.168.1.111 #slave机器

说明:

master-slave模式:

master收集到日志后,会把一部分数据碎片到salve上(随机的一部分数据);同时,master和slave又都会各自做副本,并把副本放到对方机器上,这样就保证了数据不会丢失。

如果master宕机了,那么客户端在日志采集配置中将elasticsearch主机指向改为slave,就可以保证ELK日志的正常采集和web展示。

由于elk-node1和elk-node2两台是虚拟机,没有外网ip,所以访问需要通过宿主机进行代理转发实现。

2、软件下载

官方下载:Elastic 产品:搜索、分析、日志和安全 | Elastic

注意 JDK需要1.8。

3、ElasticSearch安装

[root@node1 ~]# rpm --import https://artifacts.elastic.co/GPG-KEY-elasticsearch

[root@node1 ~]#wget -O /etc/yum.repos.d/epel.repo http://mirrors.aliyun.com/repo/epel-7.repo

[root@node1 ~]# vim /etc/yum.repos.d/elasticsearch.repo

[elasticsearch-6.x]

name=Elasticsearch repository for 6.x packages

baseurl=https://artifacts.elastic.co/packages/6.x/yum

gpgcheck=1

gpgkey=https://artifacts.elastic.co/GPG-KEY-elasticsearch

enabled=1

autorefresh=1

type=rpm-md

[root@node1 ~]# yum install -y elasticsearch安装相关测试软件:

[root@node1 ~]# yum install -y java

[root@node1 ~]# java –version #安装完java后,检测

openjdk version "1.8.0_151"

OpenJDK Runtime Environment (build 1.8.0_151-b12)

OpenJDK 64-Bit Server VM (build 25.151-b12, mixed mode)Elasticsearch配置部署:

[root@node1 ~]# vim /etc/elasticsearch/elasticsearch.yml

cluster.name: my-application # 组名(同一个组,组名必须一致)

node.name: node-1 # 节点名称,建议和主机名一致

path.data: /var/lib/elasticsearch # 数据存放的路径

path.logs: /var/log/elasticsearch # 日志存放的路径

bootstrap.memory_lock: true # 锁住内存,不被使用到交换分区去

network.host: 192.168.80.110 # 网络设置(可以为0.0.0.0监听本地所有地址)

http.port: 9200 # 监听端口启动并查看:

[root@node1 ~]# chown -R elasticsearch.elasticsearch /var/lib/elasticsearch #授权数据目录

[root@node1 ~]# systemctl start elasticsearch

[root@node1 ~]# ls /var/log/elasticsearch/my-application.log #如果启动失败可以查看日志然后通过web访问http://192.168.80.110:9200/(访问的浏览器最好用google浏览器,360有可能打不开),显示如下:

{

"name" : "node-1",

"cluster_name" : "my-application",

"cluster_uuid" : "aHZlsoFWTGCg5wDhjWbgfg",

"version" : {

"number" : "6.0.0",

"build_hash" : "8f0685b",

"build_date" : "2017-11-10T18:41:22.859Z",

"build_snapshot" : false,

"lucene_version" : "7.0.1",

"minimum_wire_compatibility_version" : "5.6.0",

"minimum_index_compatibility_version" : "5.0.0"

},

"tagline" : "You Know, for Search"

}通过命令的方式查看数据:

[root@node2 ~]# curl http://192.168.80.110:9200/_search?pretty

{

"took" : 11,

"timed_out" : false,

"_shards" : {

"total" : 0,

"successful" : 0,

"skipped" : 0,

"failed" : 0

},

"hits" : {

"total" : 0,

"max_score" : 0.0,

"hits" : [ ]

}

}在安装过程中大家会遇到以下几个问题:

启动的时候一定要注意,如果es不可以进行root账户启动,还需要重新添加一个账户。

useradd -s /sbin/nologin elk

chown -R elk:elk /usr/local/elasticsearch-6.0.0/

su - elk -s /bin/bash

/usr/local/elasticsearch-6.0.0/bin/elasticsearch -d问题一:

max file descriptors [4096] for elasticsearch process is too low, increase to at least [65536]解决方法:

vi /etc/security/limits.conf

user hard nofile 65536

user soft nofile 65536 问题二:

max number of threads [1024] for user [apps] is too low, increase to at least [2048]解决办法:

vi /etc/security/limits.d/90-nproc.conf

* soft nproc 1024

#修改为

* soft nproc 2048问题三:

max virtual memory areas vm.max_map_count [65530] likely too low, increase to at least [262144]解决办法:

vi /etc/sysctl.conf

添加下面配置:

vm.max_map_count=655360

并执行命令:

sysctl -p4、ElasticSearch插件安装

1)安装elastic-head插件

下载地址:https://github.com/mobz/elasticsearch-head/archive/master.zip

安装:

unzip elasticsearch-head-master.zip

curl --silent --location https://rpm.nodesource.com/setup | bash -

yum install -y nodejs

npm install grunt --save-dev

npm install进入elasticsearch-head-master 文件夹下,编辑 Gruntfile.js文件:增加hostname属性,设置为*:

http.cors.enabled: true

http.cors.allow-origin: "*"运行:

./grunt server &2)安装X-Pack插件

[root@node1 ~]# cd /usr/share/elasticsearch/

[root@node1 elasticsearch]# ./bin/elasticsearch-plugin install x-pack

[root@node1 elasticsearch]# bin/elasticsearch

[root@node1 elasticsearch]# bin/x-pack/setup-passwords auto

Initiating the setup of reserved user elastic,kibana,logstash_system passwords.

The passwords will be randomly generated and printed to the console.

Please confirm that you would like to continue [y/N]y

Changed password for user kibana

PASSWORD kibana = Chom^7EknkyAX3bnNpYj

Changed password for user logstash_system

PASSWORD logstash_system = Wkh+xXpEP+u&N-3Q6J+M

Changed password for user elastic

PASSWORD elastic = _56pX&QM2k$eJN!Or8hz5、安装kibana

这个安装比较简单,yum安装即可:

[root@node1 ~]# rpm --import https://artifacts.elastic.co/GPG-KEY-elasticsearch

[root@node1 ~]# vim /etc/yum.repos.d/kibana.repo

[kibana-6.x]

name=Kibana repository for 6.x packages

baseurl=https://artifacts.elastic.co/packages/6.x/yum

gpgcheck=1

gpgkey=https://artifacts.elastic.co/GPG-KEY-elasticsearch

enabled=1

autorefresh=1

type=rpm-md

[root@node1 ~]# yum install kibana修改配置:

安装后在kibana.yml文件中指定一下你需要读取的elasticSearch地址和可供外网访问的bind地址就可以了。

elasticsearch.url: http://localhost:9200

//如果是集群则配置master节点

server.host: 0.0.0.0详细信息配置:

[root@node1 ~]# cd /etc/kibana/

[root@node1 kibana]# cat kibana.yml|egrep -v "^#|^$"

server.port: 5601

server.host: "0.0.0.0"

elasticsearch.url: "http://192.168.80.110:9200"

kibana.index: ".kibana"

elasticsearch.username: "elastic"

elasticsearch.password: "_56pX&QM2k$eJN!Or8hz"

[root@node1 ~]# cd /usr/share/kibana/

[root@node1 kibana]# ./bin/kibana #启动kibana启动命令:

./kibana接下来我们在本机的/logs文件夹下创建一个简单的1.log文件,内容为“hello world”,然后在kibana上将logstash-* 改成 log* ,create按钮就会自动出来。

echo 'hello world' > 1.log访问:

用户名密码为前面使用bin/x-pack/setup-passwords auto生成的密码:kibana = Chom^7EknkyAX3bnNpYj

6、logstash安装

1)安装

[root@node1 ~]# rpm --import https://artifacts.elastic.co/GPG-KEY-elasticsearch

[root@node1 ~]# vim /etc/yum.repos.d/logstash.repo

[logstash-6.x]

name=Elastic repository for 6.x packages

baseurl=https://artifacts.elastic.co/packages/6.x/yum

gpgcheck=1

gpgkey=https://artifacts.elastic.co/GPG-KEY-elasticsearch

enabled=1

autorefresh=1

type=rpm-md

[root@node1 ~]# yum install logstash2)bin目录下启动logstash

配置文件设置为conf/logstash.conf。

启动命令:

./logstash -f ../config/logstash.conf配置多个文件:

./logstash -f ../config 指定启动目录然后启动目录下配置多个*.conf文件,里面指定不同的logpath。

3)数据测试

在config目录建:logstash.conf。

[root@node1 ~]# cd /usr/share/logstash/

[root@node1 logstash]# mkdir conf

[root@node1 logstash]# vim conf/logstash-simple1.conf #创建配置文件

input { stdin { } }

output {

elasticsearch { hosts => ["192.168.80.110:9200"] }

stdout { codec => rubydebug }

}

[root@node1 logstash]# ./bin/logstash -f conf/logstash-simple1.conf #指定配置启动出现错误:

WARNING: Could not find logstash.yml which is typically located in $LS_HOME/config or /etc/logstash. You can specify the path using --path.settings. Continuing using the defaults解决:

cd /usr/share/logstash

ln -s /etc/logstash ./config

./bin/logstash -e 'input { stdin{} } output { stdout{} }'4)input、filter、output 模块说明

其中 input 是吸取 logs 文件下的所有log后缀的日志文件,filter是一个过滤函数,配置则可进行个性化过滤。output 配置了导入到 hosts为127.0.0.1:9200 的 elasticsearch 中,每天一个索引:

input {

file {

type => "log"

path => "/apps/svr/servers/logs/*.log"

start_position => "beginning"

}

}

output {

stdout {

codec => rubydebug { }

}

elasticsearch {

hosts => "127.0.0.1"

index => "log-%{+YYYY.MM.dd}"

}

}说明:start_position是监听的位置,默认是end,即一个文件如果没有记录它的读取信息,则从文件的末尾开始读取,也就是说,仅仅读取新添加的内容。对于一些更新的日志类型的监听,通常直接使用end就可以了;相反,beginning就会从一个文件的头开始读取。但是如果记录过文件的读取信息,则不会从最开始读取。重启读取信息不会丢失。

7、FileBeat和Logstash如何集成

Filebeat作为轻量级的logs shipper,帮助用户将无数client端上的log文件以一种轻量级的方式转发并集中日志和文件到ELK stack中,不能很好的支持过滤等个性化需求。一般可采取fileBeat收集服务器日志,发送到Logstash中进行果过滤。

集成:安装好fileBeat后只需要在logstash上面修改下input,改为从fileBeat读取即可:

input {

beats {

port => filebeat的端口号,默认为5044

}

}九、ELK与Zabbix整合

1、ELK与zabbix有什么关系

ELK大家应该比较熟悉了,zabbix应该也不陌生,那么将ELK和zabbix放到一起的话,可能大家就有疑问了?这两个放到一起是什么目的呢,听我细细道来。

ELK是一套日志收集套件,它其实有由Elasticsearch、Logstash和Kibana三个软件组成,通过ELK可以收集系统日志、网站日志、应用系统日志等各种日志数据,并且还可以对日志进行过滤、清洗,然后进行集中存放并可用于实时检索、分析。这是ELK的基础功能。

但是有些时候,我们希望在收集日志的时候,能够将日志中的异常信息(警告、错误、失败等信息)及时的提取出来,因为日志中的异常信息意味着操作系统、应用程序可能存在故障,如果能将日志中的故障信息及时的告知运维人员,那么运维就可以第一时间去进行故障排查和处理,进而也就可以避免很多故障的发生。

那么如何才能做到将ELK收集的日志数据中出现的异常信息及时的告知运维人员呢,这就需要用到zabbix了,ELK(更确切的说应该是logstash)可以实时的读取日志的内容,并且还可以过滤日志信息,通过ELK的读取和过滤功能,就可以将日志中的一些异常关键字(error、failed、OutOff、Warning)过滤出来,然后通过logstash的zabbix插件将这个错误日志信息发送给zabbix,那么zabbix在接收到这个数据后,结合自身的机制,然后发起告警动作,这样就实现了日志异常zabbix实时告警的功能了。

2、Logstash与zabbix插件的使用

Logstash支持多种输出介质,比如syslog、HTTP、TCP、elasticsearch、kafka等,而有时候我们想将收集到的日志中一些错误信息输出,并告警时,就用到了logstash-output-zabbix这个插件,此插件可以将Logstash与zabbix进行整合,也就是将Logstash收集到的数据进行过滤,将有错误标识的日志输出到zabbix中,最后通过zabbix的告警机制进行触发、告警。

logstash-output-zabbix是一个社区维护的插件,它默认没有在Logstash中安装,但是安装起来也很容易,直接在logstash中运行如下命令即可:

/usr/local/logstash/bin/logstash-plugin install logstash-output-zabbix其中,/usr/local/logstash是Logstash的安装目录。

此外,logstash-plugin命令还有多种用法,我们来看一下。

1)列出目前已经安装的插件

将列出所有已安装的插件:

/usr/local/logstash/bin/logstash-plugin list将列出已安装的插件及版本信息:

/usr/local/logstash/bin/logstash-plugin list --verbose将列出包含namefragment的所有已安装插件:

/usr/local/logstash/bin/logstash-plugin list "http" 将列出特定组的所有已安装插件( input,filter,codec,output):

/usr/local/logstash/bin/logstash-plugin list --group input2)安装插件

要安装某个插件,例如安装kafka插件,可执行如下命令:

/usr/local/logstash/bin/logstash-plugin install logstash-output-kafka要使用此命令安装插件,需要你的电脑可以访问互联网。此插件安装方法,会检索托管在公共存储库(RubyGems.org)上的插件,然后下载到本地机器并在Logstash安装之上进行自动安装。

3)更新插件

每个插件有自己的发布周期和版本更新,这些更新通常是独立于Logstash的发布周期的。因此,有时候需要单独更新插件,可以使用update子命令获得最新版本的插件。

将更新所有已安装的插件:

/usr/local/logstash/bin/logstash-plugin update 将仅更新指定的插件:

/usr/local/logstash/bin/logstash-plugin update logstash-output-kafka4)删除插件

如果需要从Logstash插件中删除插件,可执行如下命令:

/usr/local/logstash/bin/logstash-plugin remove logstash-output-kafka这样就删除了logstash-output-kafka插件。

3、logstash-output-zabbix插件的使用

logstash-output-zabbix安装好之后,就可以在logstash配置文件中使用了。

下面是一个logstash-output-zabbix使用的例子:

zabbix {

zabbix_host => "[@metadata][zabbix_host]"

zabbix_key => "[@metadata][zabbix_key]"

zabbix_server_host => "x.x.x.x"

zabbix_server_port => "xxxx"

zabbix_value => "xxxx"

}其中:

zabbix_host:表示Zabbix主机名字段名称, 可以是单独的一个字段, 也可以是 @metadata 字段的子字段, 是必需的设置,没有默认值。

zabbix_key:表示Zabbix项目键的值,也就是zabbix中的item,此字段可以是单独的一个字段, 也可以是 @metadata 字段的子字段,没有默认值。

zabbix_server_host:表示Zabbix服务器的IP或可解析主机名,默认值是 "localhost",需要设置为zabbix server服务器所在的地址。

zabbix_server_port:表示Zabbix服务器开启的监听端口,默认值是10051。

zabbix_value:表示要发送给zabbix item监控项的值对应的字段名称,默认值是 "message",也就是将"message"字段的内容发送给上面zabbix_key定义的zabbix item监控项,当然也可以指定一个具体的字段内容发送给zabbix item监控项。

4、将logstash与zabbix进行整合

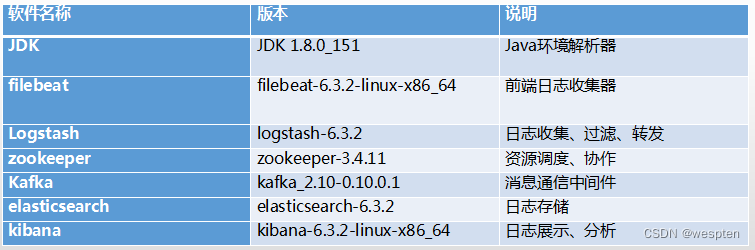

这里我们仍以ELK+Filebeat+Kafka+ZooKeeper构建大数据日志分析平台一节的架构进行讲述,由于日志已经全部进入kafka集群中,所以接下来对日志的过滤,然后选择关键字进行告警的工作,就可以在logstash上完成。

先说明一下我们的应用需求:通过对系统日志文件的监控,然后去过滤日志信息中的一些关键字,例如ERR、error、ERROR、Failed、WARNING等,将日志中这些信息过滤出来,然后发送到zabbix上,最后借助zabbix的报警功能实现对系统日志中有上述关键字的告警。

对于过滤关键字,进行告警,不同的业务系统,可能关键字不尽相同,例如对http系统,可能需要过滤500、403、503等这些错误码,对于java相关的系统,可能需要过滤OutOfMemoryError、PermGen、Java heap等关键字。在某些业务系统的日志输出中,可能还有一些自定义的错误信息,那么这些也需要作为过滤关键字来使用。

1)配置logstash事件配置文件

接下来就是创建一个logstash事件配置文件,这里将配置文件分成三个部分来介绍,首先是input部分,内容如下:

input {

file {

path => ["/var/log/secure"]

type => "system"

start_position => "beginning"

}

}input部分是从/var/log/secure文件中读取数据,start_position 表示从secure文件开头读取内容。

接着是filter部分,内容如下:

filter {

grok {

match => { "message" => "%{SYSLOGTIMESTAMP:message_timestamp} %{SYSLOGHOST:hostname} %{DATA:message_program}(?:\[%{POSINT:messag

e_pid}\])?: %{GREEDYDATA:message_content}" } #这里通过grok对message字段的数据进行字段划分,这里将message字段划分了5个子字段。其中,message_content字段会在output中用到。

}

mutate {

add_field => [ "[zabbix_key]", "oslogs" ] #新增的字段,字段名是zabbix_key,值为oslogs。

add_field => [ "[zabbix_host]", "%{host}" ] #新增的字段,字段名是zabbix_host,值可以在这里直接定义,也可以引用字段变量来获取。这里的%{host}获取的就是日志数据的主机名,这个主机名与zabbix web中“主机名称”需要保持一致。

}

mutate { #这里是删除不需要的字段

remove_field => "@version"

remove_field => "message"

}

date { #这里是对日志输出中的日期字段进行转换,其中message_timestamp字段是默认输出的时间日期字段,将这个字段的值传给 @timestamp字段。

match => [ "message_timestamp","MMM d HH:mm:ss", "MMM dd HH:mm:ss", "ISO8601"]

}

}filter部分是个重点,首先有个if判断,注意这里对字段的应用方式,[fields][log_topic]这个字段是在filebeat中定义的,使用if判断可以对多个日志类别进行过滤、分析,根据不同字段的标识区分不同的任务。

在这个部分中,重点关注的是message_timestamp字段、message_content字段。

最后是output部分,内容如下:

output {

if [message_content] =~ /(ERR|error|ERROR|Failed)/ { #定义在message_content字段中,需要过滤的关键字信息,也就是在message_content字段中出现给出的这些关键字,那么就将这些信息发送给zabbix。

zabbix {

zabbix_host => "[zabbix_host]" #这个zabbix_host将获取上面filter部分定义的字段变量%{[host][name]的值

zabbix_key => "[zabbix_key]" #这个zabbix_key将获取上面filter部分中给出的值

zabbix_server_host => "172.16.213.140" #这是指定zabbix server的IP地址

zabbix_server_port => "10051" #这是指定zabbix server的监听端口

zabbix_value => "message_content" #这个很重要,指定要传给zabbix监控项item(oslogs)的值, zabbix_value默认的值是"message"字段,因为上面我们已经删除了"message"字段,因此,这里需要重新指定,根据上面filter部分对"message"字段的内容划分,这里指定为"message_content"字段,其实,"message_content"字段输出的就是服务器上具体的日志内容。

}

}

#stdout { codec => rubydebug } #这里是开启调试模式,当第一次配置的时候,建议开启,这样过滤后的日志信息直接输出的屏幕,方便进行调试,调试成功后,即可关闭。

}将上面三部分内容合并到一个文件file_to_zabbix.conf中,然后启动logstash服务:

[root@logstashserver ~]#cd /usr/local/logstash

[root@logstashserver logstash]#nohup bin/logstash -f config/file_to_zabbix.conf --path.data /data/osdata &这里的--path.data是指定此logstash进程的数据存储目录,用于在一个服务器上启动多个logstash进程的环境中。

2)zabbix平台配置日志告警

登录zabbix web平台,选择配置--->模板--->创建模板,名称定为logstash-output-zabbix。

如下图所示:

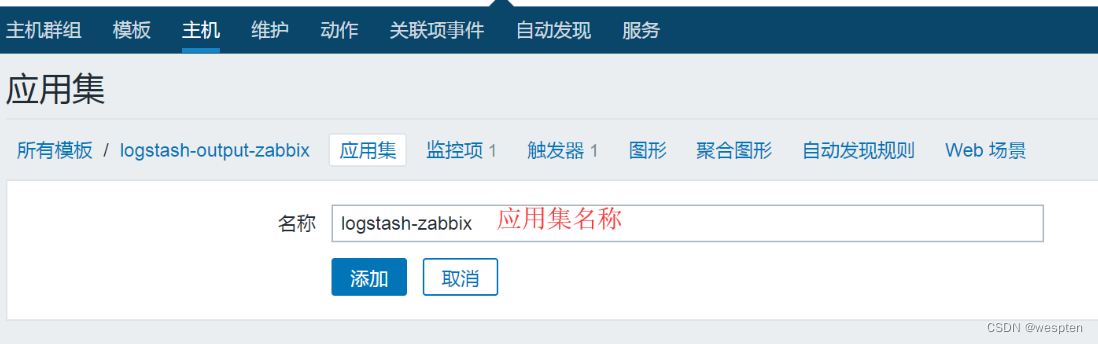

接着,在此模块下创建一个应用集,点击应用集----->创建应用集,如下图所示:

然后,在此模块下创建一个监控项,点击监控项----->创建监控项,如下图所示:

到此为止,zabbix监控logstash的日志数据配置完成。

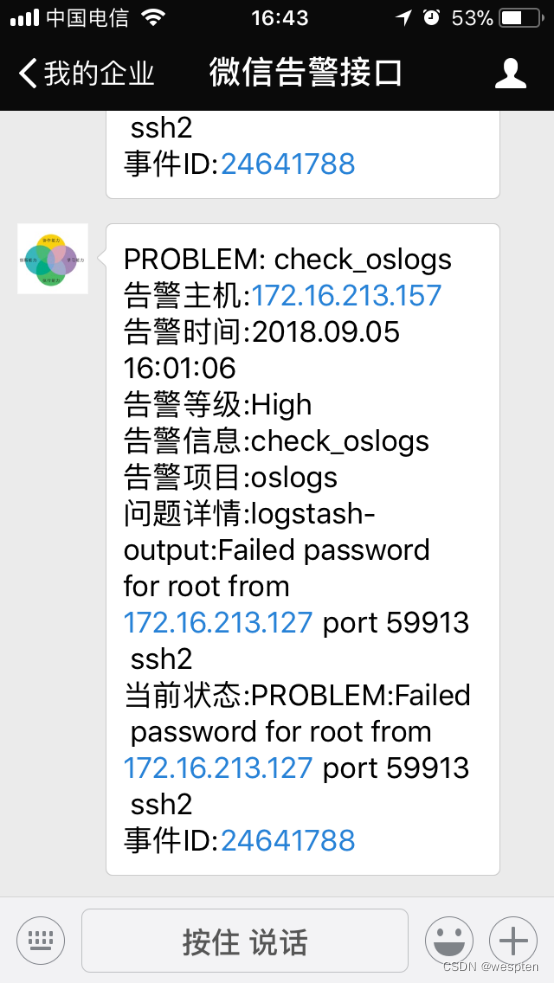

这里我们模拟一个故障,在任意主机通过ssh登录172.16.213.157主机,然后输入一个错误密码,让系统的/var/log/secure文件产生错误日志,然后看看logstash是否能够过滤到,是否能够发送到zabbix中。

首先让系统文件/var/log/secure产生类似如下内容:

Sep 5 16:01:04 localhost sshd[27159]: pam_unix(sshd:auth): authentication failure; logname= uid=0 euid=0 tty=ssh ruser= rhost=172.16.213.127 user=root

Sep 5 16:01:06 localhost sshd[27159]: Failed password for root from 172.16.213.127 port 59913 ssh2这里面有我们要过滤的关键字Failed,因此logstash会将此内容过滤出来,发送到zabbix上。

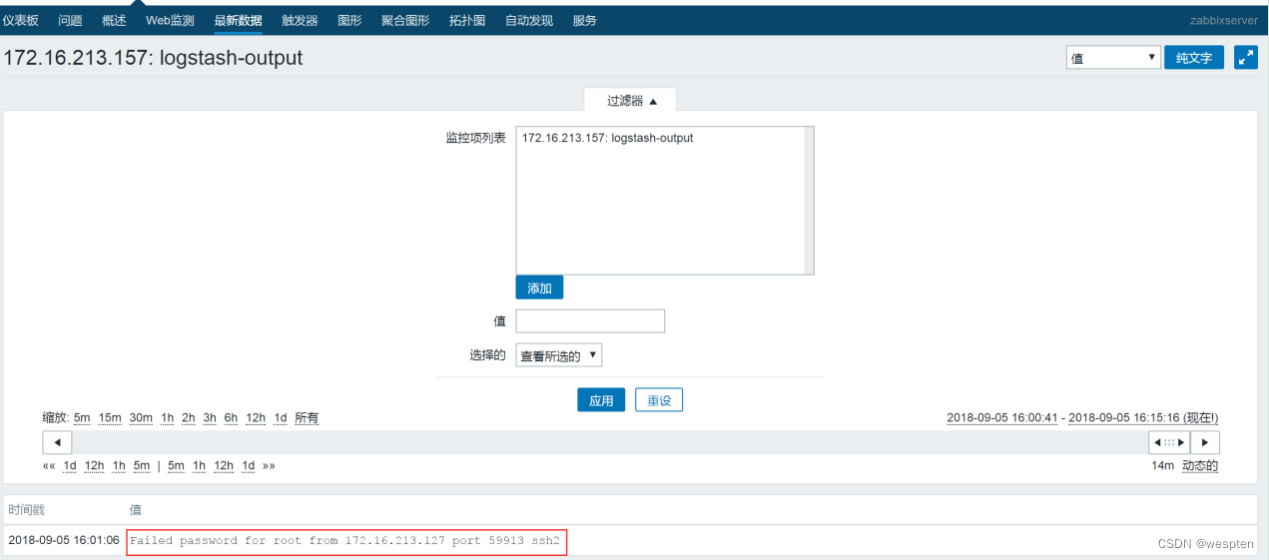

接着,登录zabbix web平台,点击监测中----->最新数据,如果zabbix能够接收到日志,就可以看到下图的最新数据:

点击历史记录,可以查看详细内容,如下图所示:

可以看到,红框中的内容就是在logstash中定义的message_content字段的内容。

到这里为止,zabbix已经可以收到logstash的发送过来的数据了,但是要实现报警,还需要在zabbix中创建一个触发器,进入配置----->模板,选择logstash-output-zabbix这个模板,然后点击上面的触发器,继续点击右上角的创建触发器,如下图所示: