不断学习原理的菜狗冯,看了一些基础的网络,个人理解,仅供参考

下期会总结一些修改的网络,学习一下修改网络的思路,或者会学习一下最新的网络结构和相关的修改网络。

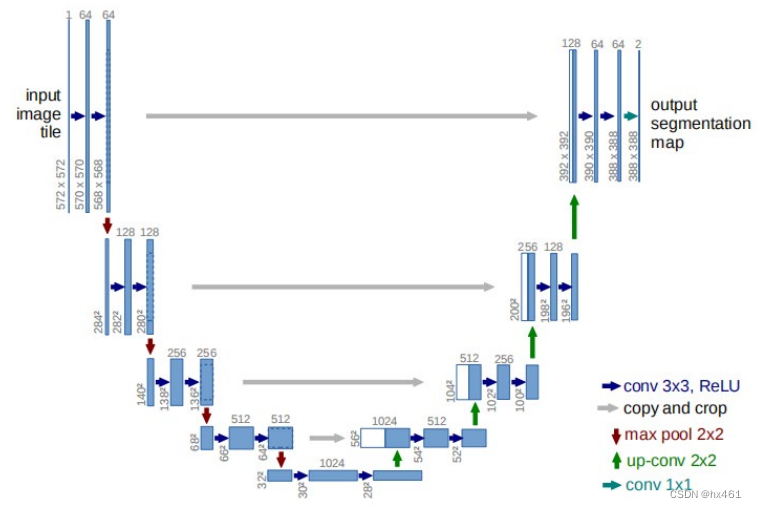

一、Unet(2015)

Unet 网络具有五层,网络中含有卷积层、池化层、反卷积层以及 ReLU 激活函数。编码时由4个block组成,每个block使用了两次3*3卷积和ReLU(激活函数之一)和1个Max Pooling(最大值池化)进行下采样,降低维度,减少计算量,通道数乘2。解码器阶段的跳跃连接不再使用相加,而是进行特征图拼接,然后再使用卷积将特征图的通道数减半。

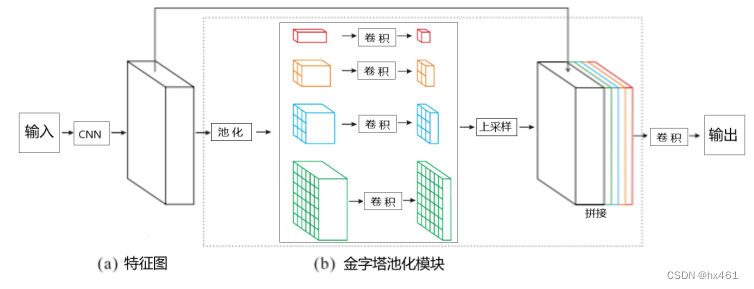

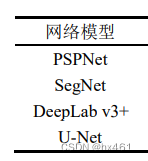

二、PSPNet(2017)

总结:操作步骤及目的:CNN(提取全局特征图)、池化(得到不同尺寸的特征图)、卷积(降维,减少计算量)、上采样(保证与输入特征尺寸相同)、拼接(融合全局特征和细节特征)、卷积(输出尺寸)

(a)使用带有扩展网络策略(空洞卷积)且预训练过的ResNet模型来提取特征图,空洞卷积的作用主要是增大感受野,最终特征图尺寸为输入图像的1/8(stride=8)。ResNet 的短路连接结构可以保证其网络不会随深度加深产生梯度爆炸现象,稳固了网络的学习性能。

(b)用1×1,2×2,3×3,6×6 的卷积核对特征图进行全局池化得到不同尺寸的特征图,然后结合 1×1 卷积进行降维。

上采样到与输入特征相同尺寸,然后和输入特征拼接,达到融合目标的细节特征(浅层特征)和全局特征(深层特征,也就是上下文信息)的目的,弥补传统卷积神经网络的感受野对于输入影像尺寸的限制,通过拼接四种不同金字塔尺度下的特征来减少网络对于输入影像的全局信息的损失。

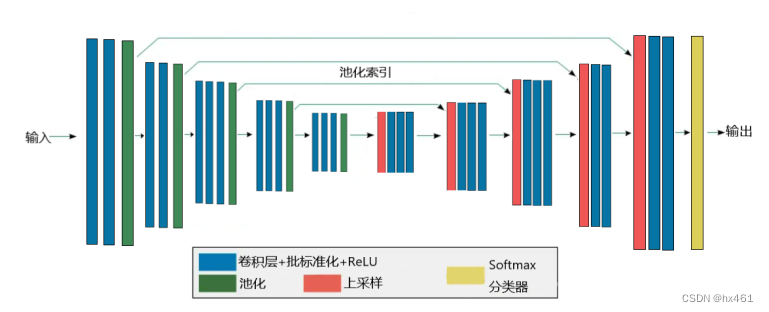

三、SegNet(2017)

卷积层+批标准化(BN)+ReLU。卷积操作提取特征,批标准化(BN)解决网络过拟合问题,ReLU为激活函数,能提高网络的容错率以及对于非线性问题的处理能力。

池化。增大网络的感受野。

在编码器阶段不再使用步长为 2 的卷积进行下采样,而是使用带有位置编码的最大值池化进行下采样。在每一个最大池化过程中保留其池化索引,对图像尺寸进行压缩,映射到像素级别的预测,在卷积操作中,SegNet 采用 same 卷积保证运算前后的图像大小不变,在解码过程中利用反卷积重现图像分类后的特征,用编码网络中得到的池化索引进行上采样, 使图像尺寸还原到原始尺寸,在最后使用 Softmax 分类器对每个像素的高维特征进行分类和识别,输出不同分类的最大值,得到最终的分割结果,实现图像语义分割。

(扩充知识,与网络无关。具体参考论文基于改进U-Net模型的无人机影像建筑物提取研究.ashx (wanfangdata.com.cn):(1)BN 层之后使用 Dropout 能够显著避免方差偏移。(2)当输入值大于 0 时,ReLU 函数的导数值恒为 1,不影响感受野且不存在梯度消失的问 题,且由于函数为线性,前向传播和反向传播都较为迅速,当输入值小于 0 时,ReLU 函数可以截断该输入值,导数和输出结果均为零,网络稀疏性得以增加,但此时函数梯度为 0,导致神经元失活,参数停止更新,可能导致梯度消失现象产生。ReLU 函数产生了一些变体函数,如 PReLU 函数和 Leaky ReLU 函数,PReLU 可以使负数输入值的输出结果非 0,解决了神经元失活的问题,Leaky ReLU 可以为所有负数输入值赋予一个非 0 斜率,也能解决神经元不响应的问题。)

四、DLinkNet(2018)

编码(左边):7×7 的卷积用于将原始的特征图的通道数从3升到 64,提取语义特征。然后经过一个最大池化下采样层,编码器阶段有分别经过 3、4、6、3 个 ResNet 结构,提取到语义信息。

中间:Dblock空洞卷积结构,增大感受野。

解码(右边):使用跳跃相加的方式保持原始特征,从而减少了大量的训练时间,同理依次进行上采样-跳跃相加,最后使用 1 ×1 的卷积减小通道数到分类的数量。

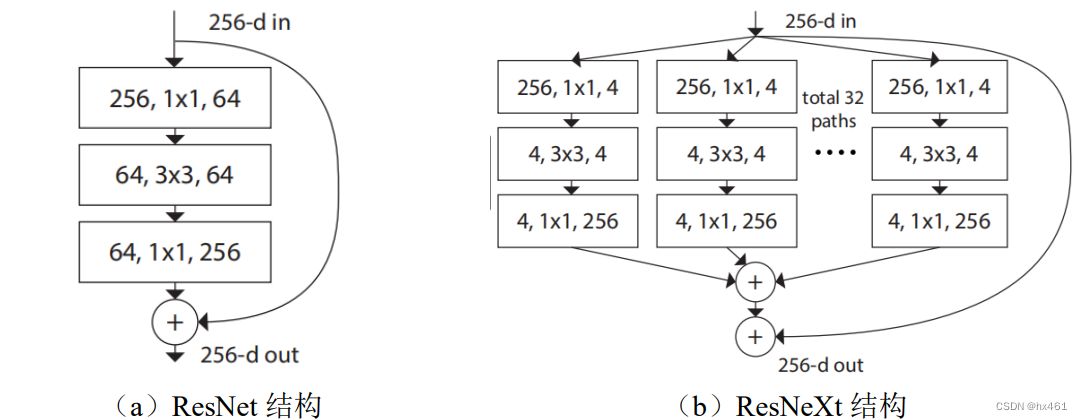

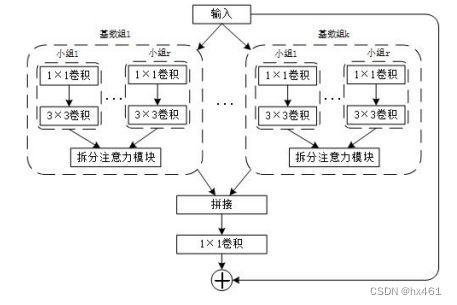

扩充知识,与网络无关:ResNet、ResNeXt、ResNeSt(具体介绍参考论文P14基于深度学习的遥感影像云检测算法研究.ashx (wanfangdata.com.cn)

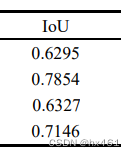

各个文章精度对比结果