图片来源:由无界AI生成

撰文:Ekrem Çetinkaya

来源:MarkTechPost

语言模型能够生成连贯且与上下文相关的文本,彻底改变了我们与计算机交流的方式。大型语言模型(LLM)一直走在这一进步的最前沿,它通过对海量文本数据的训练来学习人类语言的模式和细微差别。ChatGPT 作为 LLM 革命的先驱,在不同学科领域的人士中极受欢迎。

LLM 的超强能力让各种任务变得更容易处理。我们用它们来总结文本、撰写电子邮件、自动完成编程任务、解释文档等。所有这些任务在一年前还相当耗时,但如今只需几分钟就能完成。

然而,随着对多模态理解的需求日益增长,模型需要处理和生成文本、图像甚至视频等不同模态的内容,因此出现了对多模态大型语言模型(MLLMs)的需求。MLLM 将语言模型的强大功能与视觉理解相结合,使机器能够以更全面、更了解上下文的方式理解和生成内容。

当 ChatGPT 的热潮稍稍平息之后,MLLMs 在人工智能领域掀起了一场风暴,使机器能够理解和生成文本和图像等不同模式的内容。这些模型在图像识别、视觉基础和指令理解等任务中表现出色。然而,如何有效地训练这些模型仍然是一项挑战。最大的挑战在于,当 MLLM 遇到完全陌生的场景时,图像和标签都是未知的。

此外,MLLM 在处理较长的上下文时往往会“迷失”。这些模型严重依赖开头和中间的位置,这也是随着样本数量的增加,准确率会出现高原现象(指在学习或技能的形成过程中,出现的暂时停顿或者下降的现象)的原因。因此,MLLM 在处理较长的输入时很吃力。

现在,让我们认识一下解决 MLLM 中各种难题的链接上下文学习(LCL)。

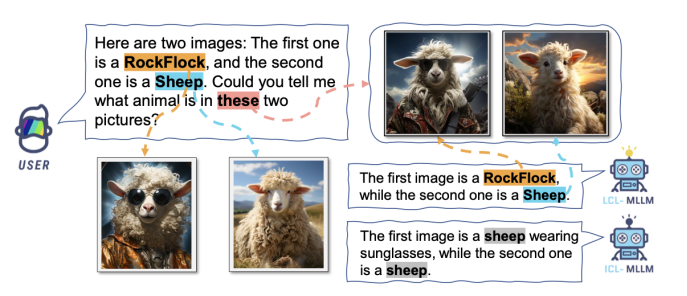

拟议的链接-上下文学习演示对话;资料来源:https://arxiv.org/abs/2308.07891

在 MLLM 中,有两种关键的训练策略。多模态提示调整(M-PT)和多模态指令调整(M-IT)。M-PT 只对模型的一小部分参数进行微调,其余参数保持不变。这种方法有助于实现与全面微调类似的结果,同时最大限度地减少计算资源。另一方面,M-IT 通过在包含指令描述的数据集上对 MLLM 进行微调,增强了 MLLM 的零样本能力。这种策略提高了模型理解和应对新任务的能力,而无需事先训练。这些方法都很有效,但都有所牺牲。

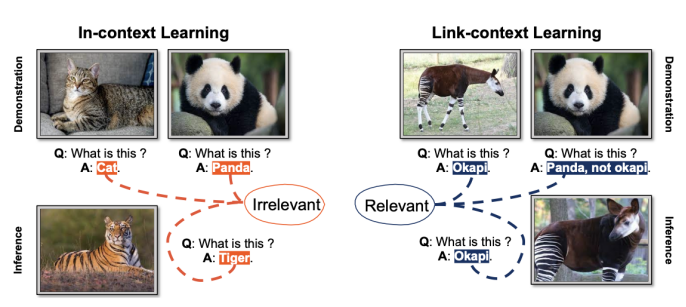

上下文学习和链接上下文学习之间的区别。资料来源:https ://arxiv.org/abs/2308.07891

LCL 探索了不同的训练策略:混合策略、双向策略、双向随机策略和双向加权策略。混合策略的突出特点是能显著提高零样本的准确性,并在样本数量达到 6 个的时候,取得令人印象深刻的效果。然而,样本为 16 个时,其性能略有下降。相反,双向策略的准确率从 2 个样本到 16 个样本逐渐提高,这表明它与训练模式更接近。

与传统的上下文学习不同,LCL 更进一步,赋予模型在源和目标之间建立映射的能力,从而提高其整体性能。通过提供具有因果联系的演示,LCL 使 MLLM 不仅能识别类比,还能识别数据点之间的潜在因果联系,从而更有效地识别未见图像和理解新概念。

此外,LCL 还引入了 ISEKAI 数据集,这是一个新颖而全面的数据集,专门用于评估 MLLM 的能力。ISEKAI 数据集由完全生成的图像和捏造的概念组成。它对 MLLM 从正在进行的对话中吸收新概念并保留这些知识以准确回答问题提出了挑战。

总之,LCL 为多模态语言模型所采用的训练策略提供了宝贵的见解。混合策略和双向策略为提高多模态语言模型的性能提供了不同的方法,每种方法都有自己的优势和局限性。上下文分析揭示了多模态语言模型在处理较长输入时所面临的挑战,也强调了在这一领域开展进一步研究的重要性。

巴比特园区开放合作啦!

中文推特:https://twitter.com/8BTC_OFFICIAL

英文推特:https://twitter.com/btcinchina

Discord社区:https://discord.gg/defidao

电报频道:https://t.me/Mute_8btc

电报社区:https://t.me/news_8btc