文章目录

大家好,我是脚丫先生 (o^^o)

小伙伴们都知道,在之前数据中台的研发中,我们一直使用Datax进行数据汇聚。

并且在数据湖项目中,采用的是Kettle作为离线开发的核心功能。

这个两个开源项目虽然很优秀,但是只是针对单一的方向,一旦有实时或者其他需求,难免捉襟见肘。

因此一直苦于没有一个菜单式的流批数据集成平台,在之后我们进行了全网调研~~~最终选择了全域数据集成平台RestCloud。

自从使用了RestCloud,在大数据项目交付中大大提高了我们的进度,非常Nice。

全域数据集成平台RestCloud

ETLCloud为最新一代的数据集成平台,我们致力于打造一款集离线数据集成ETL、ELT、CDC实时数据集成、编排调度、数据服务API为一体的数据集成平台(DataOps),一站式满足企业的各种最为复杂的数据集成场景。提供私有化部署能力和云原生架构,满足企业不同发展阶段的业务需求。 提供开放的组件市场,企业通过本平台可以快速构建大数据基础底座,同时快速打通ERP、MES、OA、SaaS、API、MQ、IOT等数据构建数据仓库。

一、产品架构

RestCloud数据集成平台采用SprigCloud微服务架构技术开发,底层基于纯Java语言采用前后端分离架构,前端采用React技术进行开发。 RestCloud数据集成平台是基于数据流+工作流引擎的架构进行研发的。

其底层设计了一个专门为数据处理任务流而研发的工作流引擎用以支撑任意复杂的数据流处理包括:串行、同步并行、异步并行、同步子流程、异步子流程、事务控制、循环任务执行、多流合并、数据折分、数据流复制等。

而不是基于DAG这种简单的有向无环图的数据流程处理逻辑,得益于我们在工作流上面集累的优势我们不但可以做DAG这种简单的依赖任务处理还可以做复杂的多层任务调度能力,企业可以把数据处理任务分为原子层、逻辑组合层、调度层等方式来组合企业的复杂任务调度需求,可以把一个复杂的数据集成流程拆分成多个可复用的子任务来进行调度。

接下来,给小伙伴介绍下数据集成平台的各个模块,让大家嗨起来。

一、数据源管理

众所周知,数据源管理是数据平台的较为核心的功能,传统的方式都是以单一的数据源为主,但是随着业务的逐步发展,已经很难于去满足。因此异构数据源集成是当下急需的业务功能。

- 1.数据源统一管理:相比于Kettle需要在每个任务中单独维护和管理数据源的连接和认证信息,这会增加管理的复杂性。相比之下,我们提供统一的多数据源管理能力可以简化数据源管理和维护,减少错误和重复性工作。

- 2.多数据源支持:支持包括主流及国产关系型数据库、NoSQL数据库、文件系统、云存储等,可以满足链接多种不同数据源的需求。

- 3.降低管理复杂性:统一界面管理多个数据源,降低了管理复杂性。开发人员可以在一个流程中进行数据管理、转换和加载,而无需切换多个工具,从而减少了维护成本和错误率。

- 4.增强数据安全性:统一数据源连接、数据加密和安全认证等功能,可以帮助保护数据的安全性。开发人员可以在一个工具中配置和管理这些安全功能,从而提高了数据安全性和可靠性。

二、离线数据集成

通过可视化的拖、拉、拽创建异构数据源之间的集成任务,对数据进行清洗、转换、传输等操作。可以说这块功能是非常超前于其他开源的离线数据集成,其中最大的区别在于组件的丰富多样,并且支持大数据组件。

-

1.平台提供ETL和ELT双引擎模块,用户可根据不同业务场景选择使用ETL或ELT组件。

-

2.ETL可为用户实现复杂的数据集成场景以及数仓反向集成业务系统的ETL过程。

-

3.ELT可为用户快速实现业务数据到数仓及数湖的抽取过程。

-

4.具有单项目上万数据管道的稳定调度实施经验,可为用户提供复杂的数据管道架构方案,以及全球化的数据合规交换。

三、实时数据集成

实时数据集成,一般用于对时效性要求很高的场景,也可以用于离线数据集成里的数据增量采集。

在ETLCloud数据集成平台里,支持异构数据源实时数据监听读取,实时数据通过经过清选、转换后可以实时存储到数仓中并可立即发布成API服务。

- 1、能够自动根据不同的数据库类型捕获数据变化日志可实现数据表的实时毫秒级同步,实时数据可同时并行分发到多个目标库或应用中。

- 2、支持实时数据传输到Hive、MongoDB 、Doris、MQ中,同时也支持从MongoDB 、MQ、文件实时传输到SQL数据库中,支持一对多传输,支持多流合并传输,传输过程中支持数据质量检查,能实时把脏数据分发到指定表中并发送告警通知。

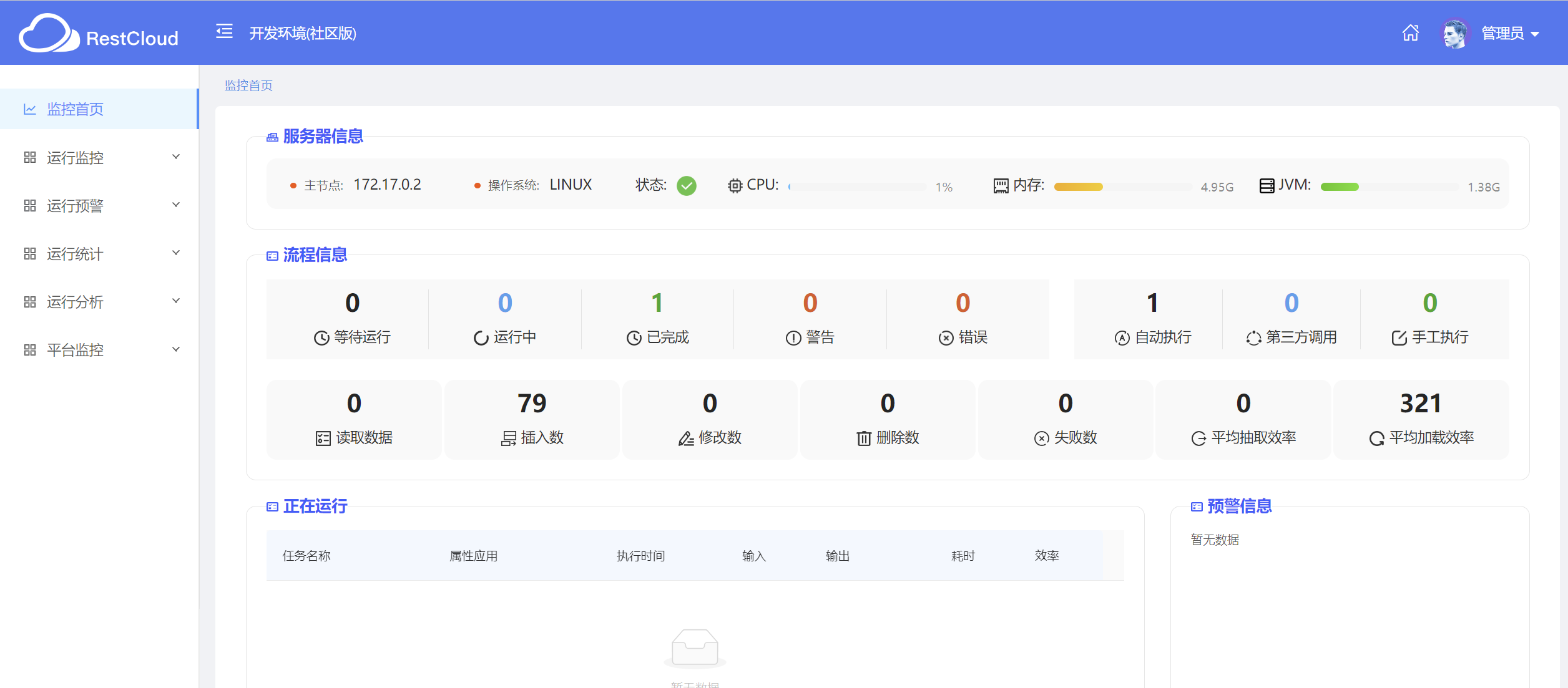

四、监控中心

采用智能算法、对运行中的自动化流程进行统一监控和告警。不单单像传统的监控方式,仅仅以插件的方式去获取任务的异常。

目前大多数的监控任务的方式,是采用了prometheus进行监控,以获取数据,通过Grafana进行显示。但是这种方式很多时候,会不精准,造成严重的经济损失。而ETLCloud数据集成平台采用的是智能算法的方式对任务监控,以达到更为精准的目的。

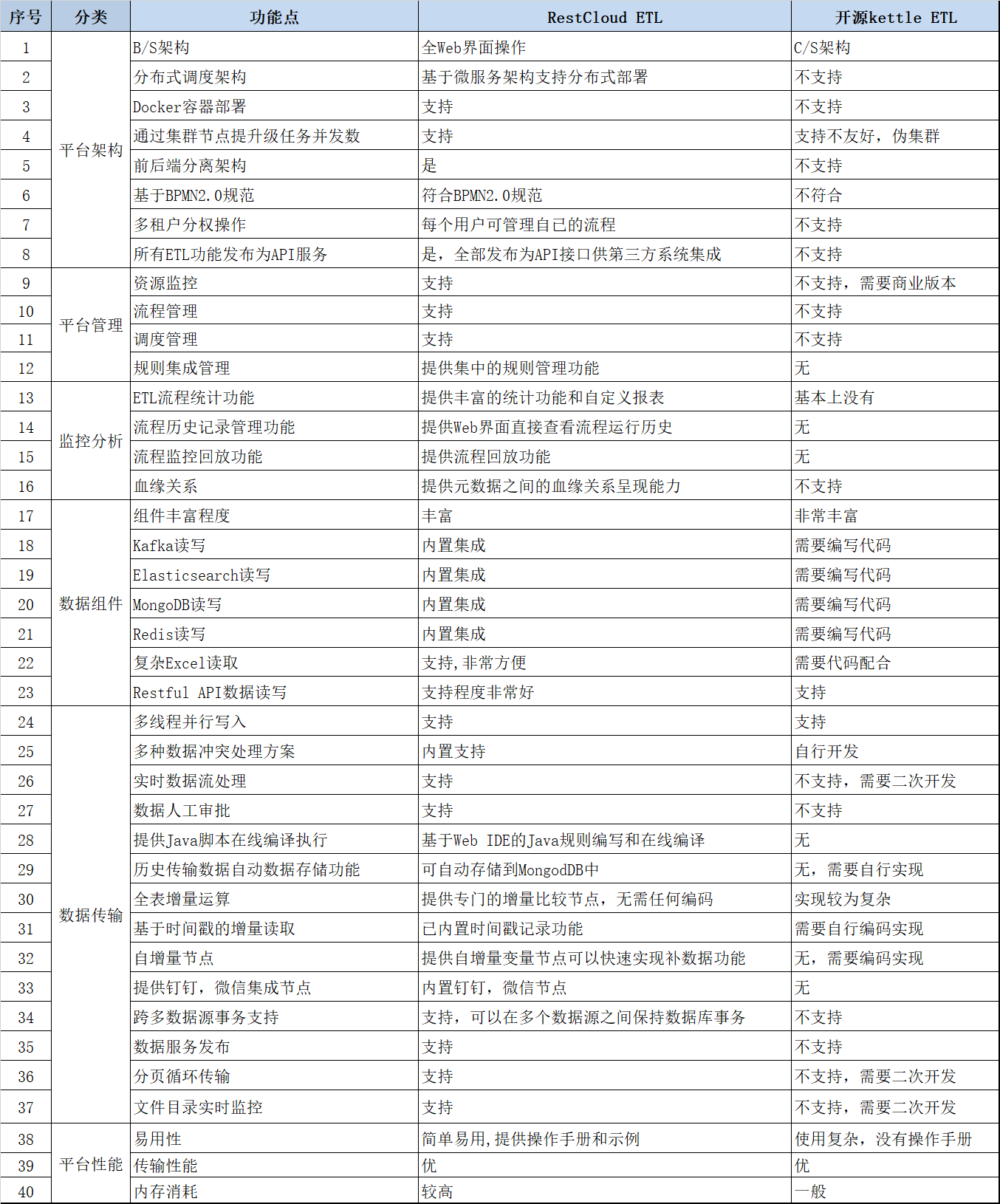

五、对比总结

当下而言,开源的异构数据源集成平台很多,其中以Kettle较为知名。那么接下来我们进行了总结对比:

RestCloud ETL和Kettle都有什么优势和劣势?

我们从平台架构、平台管理、监控分析、数据组件、数据传输、平台性能进行比较如下:

六、离线数据集成实战

接下来,我们以离线数据集成的一个案例进行演示,让小伙伴感受下:

mysql数据源,把mysql的test库的info表数据,集成到test_target库的info_target表中。

(这里小伙伴可以对不同的数据源进行数据的集成)

愉快的玩转数据集成功能!

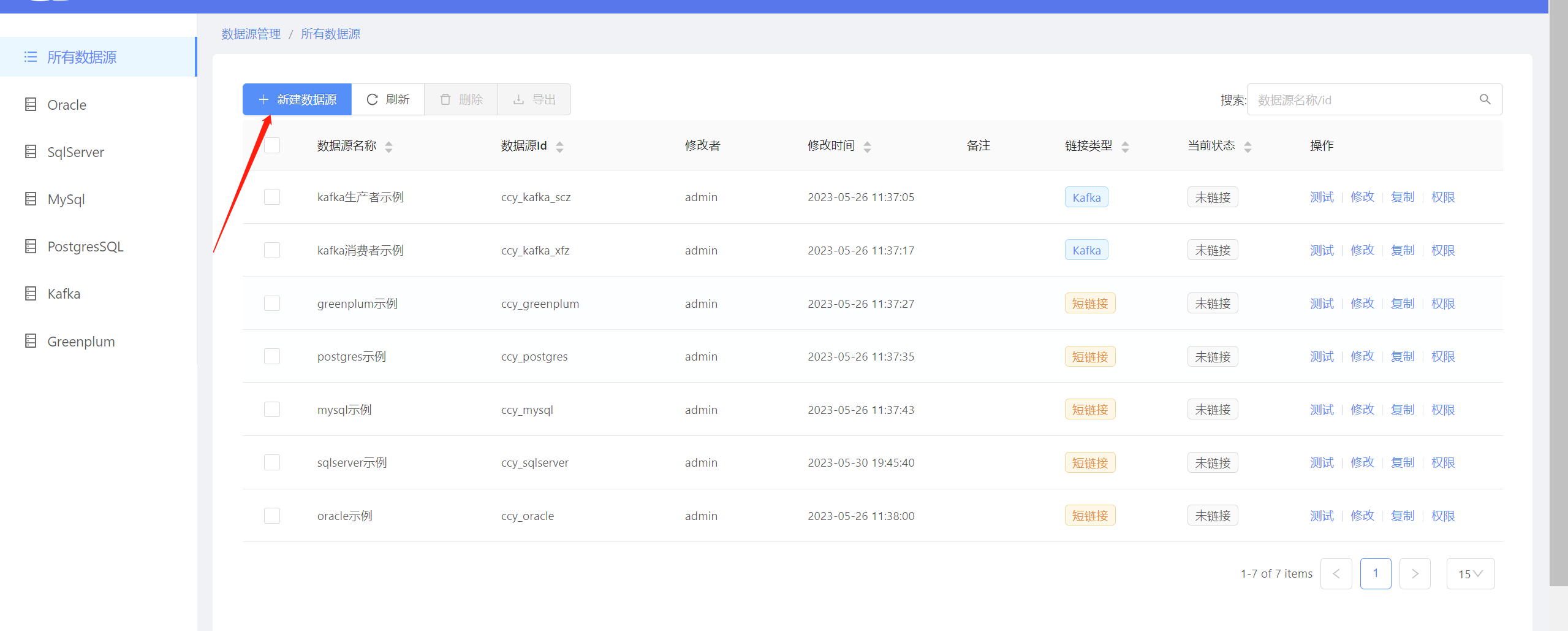

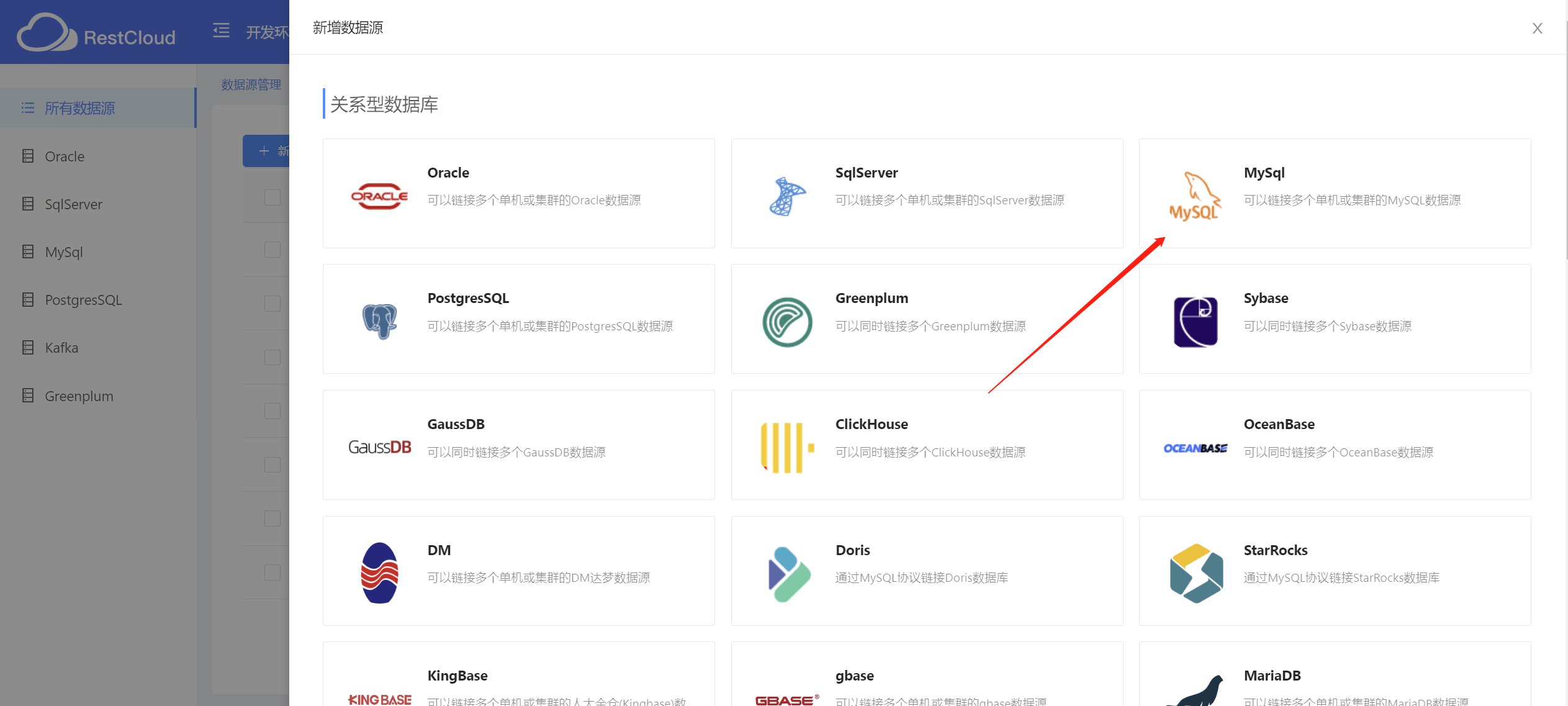

1.新建mysql数据源

在数据平台中,进入数据源管理,之后新建数据源

这里,我以mysql数据源为案例。

对mysql的参数进行配置,测试连接之后。也就完成了我们数据源的建立。

2.离线数据集成

进入离线数据集成功能模块,并创建自己项目应用

在此之后,进入应用,到达我们的核心功能区: 数据集流程

这里,小伙伴们可以进行数据流程的新建和设计

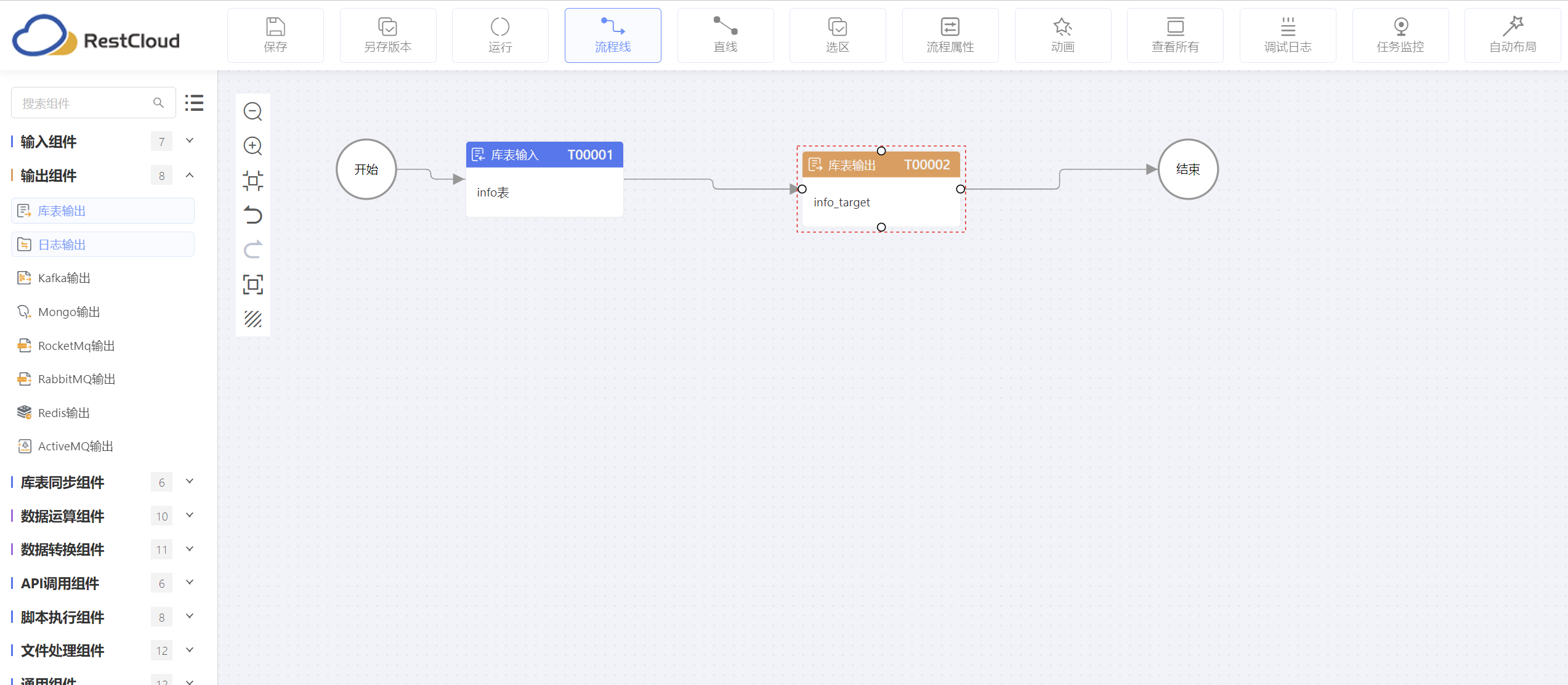

**我的数据流程设计:**把test库的info表数据,同步到 test_target库的info_target表中。

3.执行同步数据

在完成了数据流程的设计之后,我们就可以执行任务(可以自己选择手动执行或者调度执行)

在执行数据流程任务之后,我们来看看成果~~~

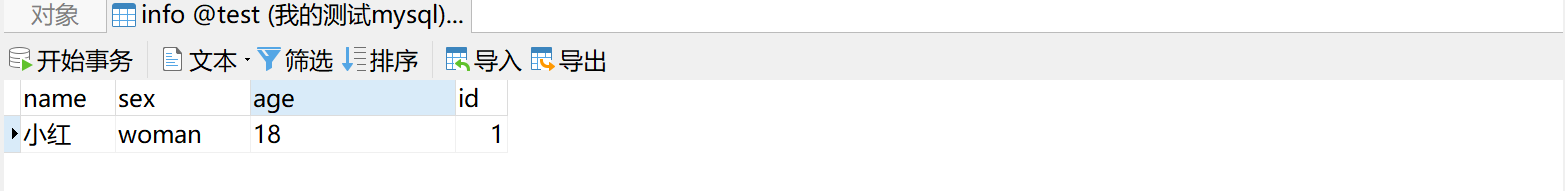

test库的info表数据:

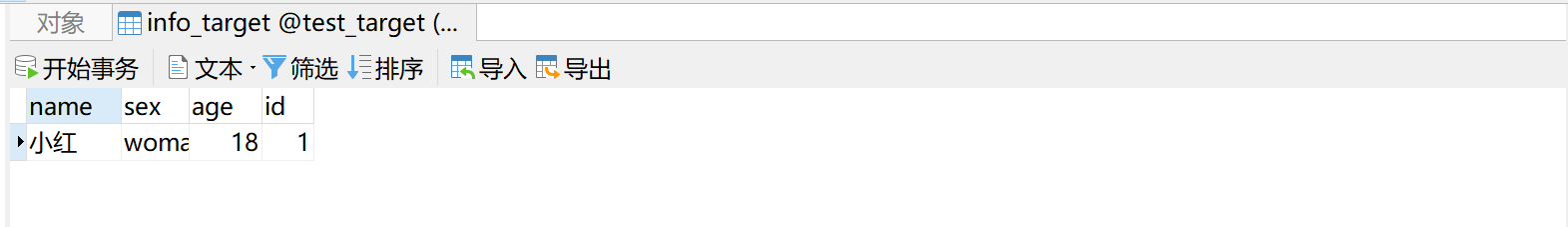

test_target的info_target数据:

到此,非常nice,一个mysql源,不同库表的数据同步就算完成,当然数据集成功能远远不止于此。

关键:在数据集成过程中,对数据流程的设计,小伙伴们可以使用去挖掘更多的功能,快速完成的自己工作,愉快的摸鱼才是我们向往!

完结,撒花。

祝各位终有所成,收获满满!