人工智能咨询培训老师叶梓 转载标明出处

大模型(LLMs)如GPT-3和GPT-4正在革新金融、医疗和法律领域的格局。这些领域以依赖专业专业知识、数据获取困难、高风险和严格的监管合规性为特征。本研究报告详细探讨了LLMs在这些高风险领域的应用方法、应用案例、挑战和未来机遇。强调了LLMs在提升医疗诊断和治疗方法、创新金融分析和完善法律解释和合规策略中的关键作用。还批判性地审视了这些领域LLM应用的伦理问题,指出了现有的伦理问题,并强调了需要透明、公平和强大的AI系统来尊重监管规范。

论文链接:https://arxiv.org/pdf/2405.01769

金融

金融NLP任务和数据集

图1总结了现有的金融自然语言处理(Financial NLP)任务和代表性数据集。展示了金融NLP任务的分类,包括情感分析、信息提取、问题回答、文本增强的股票走势预测以及其他金融NLP任务。

在金融自然语言处理(NLP)领域,已经定义了一系列任务,这些任务通过使用大模型相关方法进行了广泛的研究。这些任务包括情感分析、信息提取、问题回答、文本增强的股票运动预测等。情感分析专注于分析金融领域的文本数据,如新闻文章、分析师报告和社交媒体帖子,以评估对特定金融工具或市场的情绪。这项任务通常是分类问题,目标是从文本中识别出积极、消极或中性的情绪。

信息提取(IE)是金融NLP中的另一个关键任务,它包括命名实体识别(NER)和关系提取(RE)。NER的目标是识别文本中的实体,如公司名称和股票符号,而RE则专注于识别实体之间的关系。此外,事件检测涉及从新闻文章或社交媒体中识别重要的金融事件,如并购或收益报告。

在金融领域的问题回答(QA)任务中,系统被设计为回答特定于金融的查询,这些查询通常涉及大量金融数据。这可能包括从在线论坛、博客、新闻等来源中提取的信息。

文本增强的股票运动预测(SMP)任务涉及分析金融文本,以预测股价趋势和市场行为。这通常涉及基于文本分析和历史股价数据来预测未来的股票运动。

此外,还有许多其他金融NLP任务,如新闻标题分类、货币政策声明的鹰派-鸽派分类、财务句子边界检测、多重分类任务等。这些任务通常需要对金融领域的深入了解,并且需要处理大量的数值数据。

想要掌握如何将大模型的力量发挥到极致吗?2024年10月26日叶老师带您深入了解 Llama Factory —— 一款革命性的大模型微调工具。

留言“参加”即可来叶老师的直播间互动,1小时讲解让您轻松上手,学习如何使用 Llama Factory 微调模型。互动交流,畅谈工作中遇到的实际问题。

金融领域的LLMs

随着BERT等模型的出现,已经有许多尝试构建专门针对金融领域的预训练语言模型(PLMs)和大模型。这些模型通常采用预训练加下游任务微调的范式,并且已经从相对较小的模型发展到更大规模的模型。最近的工作甚至采用了指令微调,以评估更广泛的金融任务。

例如,BloombergGPT是由Bloomberg构建的一个大型英文金融语言模型,它使用了大量内部金融资源进行预训练。这个模型在处理金融领域的任务时表现出色,尤其是在涉及数值推理的金融QA任务上。

除了英文模型,还有针对中文金融领域的模型,如BBT-Fin,它基于T5架构,并在大规模中文金融语料库上进行预训练。这些模型在处理中文金融文本时表现出了强大的能力。

表格1总结了金融领域的预训练语言模型(PLMs)和大模型(LLMs)。

LLMs评估和分析

在金融领域的流行任务上,不同的方法和模型已经得到了广泛的评估和分析。表格2展示了在情感分析任务(FPB数据集和FiQA-SA数据集)、新闻标题分类任务(Headline数据集)和信息提取任务(NER FIN3数据集)上不同方法的性能比较。

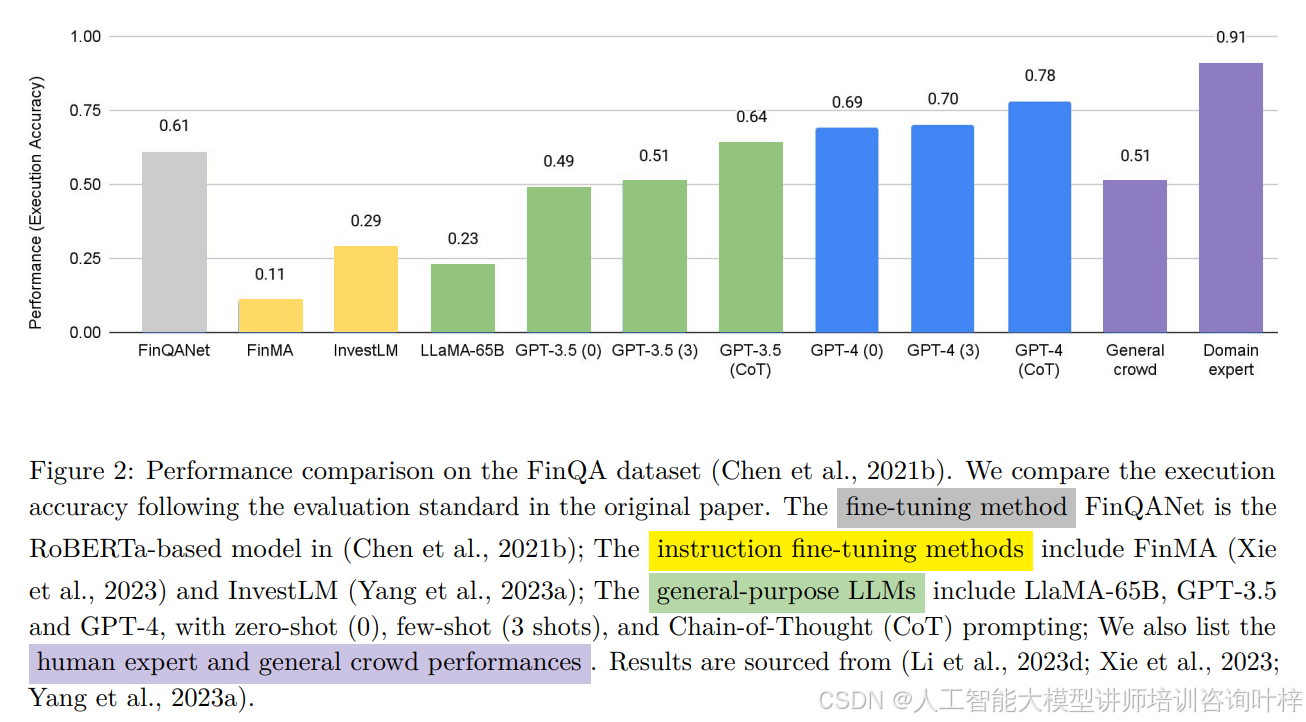

然而,在需要复杂推理能力的任务上,如金融QA,尽管采用了指令微调,但性能仍然落后于特定任务的微调模型或通用大型模型。这表明在这些任务上仍有改进的空间,特别是在开发能够处理复杂推理任务的开源指令微调模型方面。

图2比较了在FinQA数据集上不同方法的执行准确性。展示了不同的模型,包括基于指令微调的模型、一般目的的LLMs以及特定于任务的微调模型。

金融任务中的大模型方法

为了应对金融NLP中的一些关键挑战,如公共领域高质量数据的稀缺性、金融文件的多模态性、定量推理的挑战、大模型中缺乏领域知识以及检测或预防幻觉的重要性,已经提出了一些基于大模型的方法。

例如,为了解决数据稀缺问题,一些研究评估了大模型在注释数据方面的有效性,特别是对于需要金融领域知识的任务。在定量推理方面,提出了一些提示策略,以增强大模型在金融QA任务中的定量推理能力。

此外,为了处理金融文件的多模态性,一些研究提出了框架,以增强大模型对包含混合文本/表格内容的长文档的理解。在处理时间序列数据方面,研究表明,预训练的大模型可以被“修补”以模拟时间序列数据。

在金融领域的大模型应用中,幻觉的检测和预防也是一个重要问题。一些研究分析了大模型在金融任务中的幻觉行为,并提出了一些缓解策略,如检索增强生成(RAG)。

未来展望

在金融NLP领域,未来的研究需要探索更现实的任务,这些任务要求复杂的推理能力,如多步骤的财务分析、欺诈检测、风险评估等。此外,未来的研究还需要处理更丰富的模态和结构,如复杂表格和图表。

在方法论方面,未来的研究需要强调如何以成本效益的方式为大模型配备领域知识和推理技能。此外,未来的研究还需要探索如何将大模型从理论学术模型转变为对金融生态系统有积极和道德贡献的实际部署。

未来的研究还需要解决责任、伦理、法规和法律问题,确保大模型在金融领域的部署是负责任和符合道德的。

医疗保健

医疗NLP任务和基准测试

在临床NLP中,一个基本任务是对句子和文档进行处理,这有助于从临床文档中提取有意义的信息,协助临床医生进行决策过程。例如,Dernoncourt & Lee (2017) 提出了一个用于顺序句子分类的数据集,其中医学摘要中的句子被标记为以下类别之一:背景、目的、方法、结果或结论,这可以帮助研究人员更有效地浏览文献。异常检测旨在识别临床报告中的异常发现,目标是减少放射科医生的工作量。歧义分类则关注患者护理,旨在发现医生写的可能引起患者误解的模糊句子。

临床信息提取是生物医学NLP社区的一个主要目标,即从生物医学文本中提取关键变量,以实现有效的生物医学文本分析。临床意义消歧解释将临床上下文中的医学缩写转换为特定术语,或者相反,将医学术语转换为缩写。这对于理解充满复杂术语和缩写的临床记录至关重要。例如,缩写“pt”可能意味着患者、物理治疗或凝血酶原时间等。这项任务通常格式化为多项选择问题,并通过准确率和F1分数进行评估。

医疗问答(QA)是NLP中的一个基本任务,要求语言模型根据其内部医学知识回答特定问题。这项任务不仅要求对临床术语和概念有深入的理解,还要求能够理解和解释问题中给出的复杂医学推理。医疗QA任务主要形成多项选择问题,为每个问题提供一组可能的答案,从中选择正确的答案。这种格式特别适用于测试语言模型区分相关概念以及理解医学知识细微差别的能力。

图3总结了医疗自然语言处理(Medical NLP)任务和代表性数据集,展示了医疗NLP任务的分类,包括句子分类、信息提取、问题回答和报告生成等。

医疗LLMs

封闭源的医疗LLMs,如ChatGPT(OpenAI, 2022)和GPT-4(OpenAI, 2023),已经在医学基准测试和实际应用中显示出强大的医疗能力。例如,Liévin等人(2023)使用GPT-3.5进行不同的提示策略,包括链式思考、少量样本和检索增强,针对三个医学推理基准测试,展示了模型在没有特定微调的情况下的医学推理能力。对LLMs,如ChatGPT,在医学考试上的评估,包括美国医学考试(Kung等人,2023)和耳鼻喉科-头颈外科认证考试(Long等人,2023),表明它们得分接近或达到及格门槛。这表明LLMs有潜力支持实际医疗用途,如医学教育和临床决策。

开源医疗LLMs:由于隐私问题和高昂成本,一些开源医疗LLMs通过在医疗语料库上调整开源基础模型(如LLaMA)而建立。这些工作主要采用两种不同的策略:1)继续预训练后进行指令微调;2)直接指令微调。例如,PMC-LLAMA(Wu等人,2023b)采用两步训练过程,首先扩展LLaMA的训练,增加数百万篇医学教科书和论文,然后对模型进行指令微调。表格3总结了开源医疗领域大模型的培训模式、培训语料库和参数。

多模态医疗LLMs:虽然LLMs有潜力处理和协助临床NLP任务,但多模态数据(例如,X射线放射学、CT、MRI、超声波)在医疗和保健应用中起着至关重要的作用。在做出诊断和医疗建议时,模型能够访问并理解超出文本的其他临床模态非常重要。因此,有必要构建能够连接语言与其他模态的多模态LLMs。例如,LLaVA-Med(Li等人,2024a)利用从PubMed Central提取的图-标题数据集,并使用GPT-4来自我指导开放式指令跟随数据,以训练视觉AI助手。

异常和歧义检测

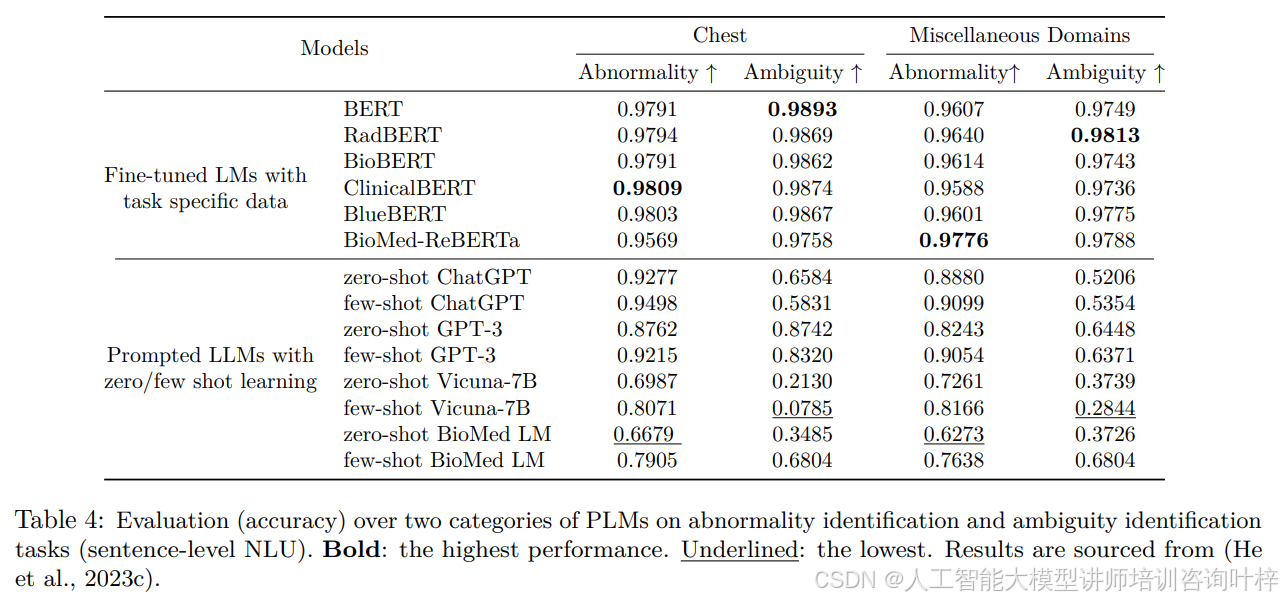

异常检测旨在通过分类报告正常或异常条件来识别放射学报告中的异常发现。在这项任务中,语言模型被用来自动阅读医疗报告,减少医生的工作量。歧义检测首次在He等人(2023d)中提出,旨在检测出现在放射学报告中可能导致报告误解的模糊句子。准确识别这些句子至关重要,因为它们妨碍了患者对诊断决策的理解,并可能导致潜在的治疗延迟和不可逆转的后果。

表格4评估了不同的预训练语言模型(PLMs)在异常检测和歧义检测任务上的性能。

医疗报告生成

医疗报告生成的目标是构建模型,输入医学影像研究(例如,X射线)并自动生成信息丰富的医疗报告。与常规图像描述基准(例如,MS-COCO)不同,放射学报告通常更长,包含多个句子,这对信息选择、关系提取和内容排序提出了更高的要求。要从放射学图像研究中生成有信息量的文本,标题模型需要理解内容,识别图像中的异常位置,并组织措辞来描述图像中的发现。

表格5比较了在MIMIC-CXR测试集上不同模型在自然语言生成(NLG)和临床效率(CE)指标上的性能。

医疗自由形式指令评估

自由形式指令评估从用户中心的角度评估语言模型的实际医疗价值。这项任务涉及将医疗查询以自由文本格式输入模型,然后模型生成相应的响应。例如,如果用户输入“以项目符号格式讨论四种主要的白细胞类型及其在人体免疫系统中的作用”,模型将基于其内部医学知识产生一个信息丰富的答案。这项任务旨在衡量模型的医学知识能力和遵循指令的能力。

表格6比较了医疗LLMs在医疗自由形式指令评估上的性能。

通过自然语言进行医学影像分类

使用深度学习的医学影像分类在计算机视觉和临床社区中已经得到了长期研究。这项任务要求模型将医学影像(例如,CT扫描)作为输入,并为它们分配诊断标签。然而,使用“黑箱”深度神经模型预测医疗症状可能会引发安全和信任问题,因为人类很难理解模型行为并轻易信任模型决策。临床医生通常需要理解模型背后的推理以便仔细做出决策。可解释模型允许更好地进行错误分析、偏差检测、确保患者安全和建立信任。

表格7比较了在具有不同混杂因素的数据集上进行稳健医学成像分类的性能。

未来展望

提高开源医疗LLMs的能力:开源、领域特定的医疗LLMs旨在缩小功能强大的封闭源LLMs与增强较小模型遵循各种医疗指令和与用户意图对齐的能力之间的性能差距,通过持续的预训练和指令微调来实现。为了进一步提高这些模型的能力,可以考虑几个未来方向:数据多样性和质量、检索增强生成、解决隐私问题。

在数据稀疏环境中学习:在医学领域训练大规模模型的一个关键挑战是数据使用的限制。由于隐私和保密性考虑、数据获取和注释的成本以及道德考虑,数据稀疏性是一个持续存在的问题。对于许多实际任务,例如医疗报告生成、临床聊天机器人、医学影像分类,数据稀疏性问题将是一个剩余的挑战。

评估实际医疗应用能力:尽管在医学领域提出了各种基准测试,但它们大多侧重于从医学知识的角度评估模型,而不是从用户导向的角度。为了弥合这一差距,自由形式指令评估数据集利用医疗对话和机器生成的文本进行医疗问题评估。然而,这些测试集在数量和任务多样性方面仍然有限。因此,需要一个大规模、多样化且经过专家验证的数据集,以评估LLMs在实际医疗用户应用中的医疗能力。

法律

法律NLP任务和数据集

通过LLM方法研究的一系列法律任务和相应的数据集,涉及的领域包括法律问答(LQA)、法律判决预测(LJP)、法律事件检测(LED)、法律文本分类(LTC)、法律文件摘要(LDS)和其他NLP任务。Figure 5提供了这些既定的法律NLP任务和相关数据集的概览。

法律问答(LQA)是提供法律问题答案的过程,促进了系统在处理与法律、法规、案例先例和理论综合相关的复杂查询方面的熟练程度。LQA数据集包括广泛的问答对,用于评估系统在法律推理方面的能力。例如,CRJC(Duan等人,2019)类似于SQUAD 2.0(Rajpurkar等人,2018)格式,包括提取跨度、是非问题和无法回答的问题等挑战。此外,像法考这样的专业资格考试需要专门的法律知识和技能,使得像MBE(Wyner等人,2016)这样的数据集尤其具有挑战性。

法律判决预测(LJP)专注于分析法律文本,如案例法、法规和审判记录,以预测法律案件的结果。这可以帮助法官、律师和法律学者根据历史数据理解潜在的案件结果。这项任务通常被视为分类问题,其中输入是法律文件,目标是法律决定(例如,定罪、无罪释放、责任)。研究人员已经开发了针对全球不同法律体系的几个数据集。例如,CAIL2018(Xiao等人,2018)是一个全面的中国刑事判决预测数据集,包含超过268万份中国政府发布的法律文件。

法律事件检测(LED)涉及识别法律文件中的重要法律程序或决定,如裁决、动议或修正案。这项任务对于使法律专业人士能够高效监控案件中的关键发展至关重要。LEVEN(Yao等人,2022a)是一个旨在增强法律信息提取和LED能力的全面且高质量的数据集。

法律文本分类(LTC)涉及对法律文件中的结构化部分进行分类,以增强它们的可访问性和可理解性。例如,大多数法律文件包含“案件事实”、“各方提出的论点”和“当前法院的决定”等部分,其识别对于理解案件的法律结果至关重要。这些文件可以被归类为事实、论点和法规等类别,使LTC成为一个多类分类任务。

法律文件摘要(LDS)旨在将法律文件压缩成简洁的摘要,同时保留关键的法律论点和结果。例如,CaseSummarizer(Polsley等人,2016)数据集专注于摘要案例判决,提供案件事实、法律论点和判决的简洁概述。

其他法律NLP任务包括法律论证挖掘(Poudyal等人,2020),信息提取:LegalNER(Păis等人),LeCaRD(Ma等人,2021),CAIL2022类似案例检索:CAIL2019-SCM(Xiao等人,2019)。

法律LLMs

自从BERT开发以来,一直在持续努力为法律领域构建PLM和LLM。早期的法律PLM采用了预训练后进行下游任务微调的范式,并最初训练了相对较小的语言模型。近来的工作已经扩大了模型规模,并引入了指令微调,评估覆盖了更广泛的法律任务。

Table 8 展示了不同法律PLMs和LLMs的模型架构、主要评估任务、语言支持、模型大小以及开发年份。例如,LegalBERT 是早期尝试构建法律PLM的模型,它针对LTC等任务进行了优化。而 Lawformer 是一个基于变压器的模型,专门为处理长篇法律文本而预训练,有助于执行如 LJP、LRC 和 LQA 等任务。

LLMs的性能评估和分析

评估和分析LLMs的性能对于理解它们在法律特定情境中的有效性和能力至关重要。Table 9 总结了在 JEC-QA 数据集、LEVEN 数据集、LawGPT 数据集和 CAIL2018 数据集上各种方法的性能。这些数据集和任务专门针对法律语言理解和推理,为评估LLMs在法律环境中的能力提供了更细致和全面的评估。例如,GPT-4 在这些任务中表现出色,这表明需要进一步开发以实现更可靠的法律特定LLMs。

针对法律任务和挑战的大模型方法论

社会法律挑战:LLMs 正在被用来解决税务准备、在线纠纷、加密货币案件和版权侵权等问题。

法律预测:通过法律提示工程(LPE)等技术,LLMs 在法律预测任务中表现出色。

文件分析:LLMs 可以帮助分析法律文件,如案例文件和备忘录,进行内容提取。

法律幻觉挑战:LLMs 可能会在不确定的情况下提供决策建议,这引发了对模型可靠性和准确性的担忧。

大模型代理挑战:开发专门用于提供法律建议和起草文件的 LLM 代理存在挑战。

未来展望

构建高质量的法律数据集:需要整合多源法律数据,并利用 LLMs 来简化数据收集和增强过程。

开发全面的 LLM-based 法律辅助系统:旨在提供实用的法律建议、解释分析和推动法律领域的发展。

伦理

Figure 6 强调了三个核心的伦理原则:透明度、正义和非伤害。这些原则是评估和指导大模型在各个领域应用时的关键标准。

透明度是其中的核心原则之一,它要求能够解释和理解系统的不同阶段,如数据使用和模型行为。在金融、医疗和法律等高风险领域,透明度尤为重要,因为它有助于评估模型的潜在风险或问题。

正义是另一个关键原则,它涉及公平、平等、包容、多样性、非偏见和非歧视。在涉及不同人群的背景下,正义尤为重要。例如,在法律领域,正义是核心的法律原则之一,在使用大模型辅助判决决策或犯罪预测时,反歧视是至关重要的。

非伤害原则强调“不造成伤害”,这在大模型的应用中尤为重要,因为它们通常在大量未知质量的语料库上进行训练。在金融领域,非伤害原则强调了防止对投资者、消费者和更广泛的金融系统造成伤害的责任。

在伦理考量方面,可解释性是指以人类可理解的方式阐明模型行为的能力。尽管大模型在传统微调范式和最近的提示范式中都存在解释方法,但解释大模型通常比大多数传统AI技术更具挑战性。

偏见与公平性是广泛涉及的伦理术语,包括与敏感特征相关的社会刻板印象或歧视,以及与训练数据不同的语言的单语种偏见。为了减轻大模型中的偏见,已经做出了许多努力,包括数据相关偏见和模型相关偏见。

鲁棒性通常表示模型即使在输入与训练数据偏离时也能保持其性能的能力。缺乏鲁棒性的模型可能导致隐私泄露、模型脆弱性和泛化问题。

幻觉是NLP中的一个普遍问题,指的是生成错误、无意义或误导性信息。在金融、医疗和法律领域,幻觉问题尤为紧迫,因为它涉及到追求的真实性和精确性。

在特定领域的伦理问题上,不同领域对伦理的定义显示出其独特的焦点和微妙的差异。例如,在金融领域,大模型的伦理问题已经开始被讨论,如ChatGPT和BloombergGPT。在医疗领域,现有的大模型在满足理想的伦理标准方面仍有很大的差距。在法律领域,大模型的进步带来了新的挑战和讨论,刺激了现有法律伦理的完善和更可行的评估标准的开发。

未来的工作需要采取多方面策略来解决大模型的伦理问题,包括数据集审查、人类和领域知识的整合、建立理论界限以及深入研究大模型输出背后的因果关系。通过实施这些措施,可以提高大模型的伦理标准,促进负责任的AI发展。