简介:BERT作为Google的预训练语言模型,通过双向理解文本信息,为NLP任务提供强大的支持。本项目探讨了BERT在增强器分类中的应用,增强器作为软件系统关键元素对性能、稳定性和安全性至关重要。项目首先理解BERT的工作原理,然后将其应用于编码代码或文档,转化为高维向量表示,再通过添加分类层学习区分不同类型的增强器。使用 bert-enhancer-main 代码库完成数据预处理、模型构建、训练和评估。优化BERT性能涉及超参数调整和模型泛化能力确保,旨在提高软件开发自动化水平和代码质量。

1. BERT模型简介和工作原理

自然语言处理(NLP)技术的快速发展,很大程度上归功于各种预训练语言模型的创新。BERT(Bidirectional Encoder Representations from Transformers)是由Google在2018年推出的一种预训练语言表示模型,它通过从大规模语料库中学习语言的双向上下文关系,显著提升了多项NLP任务的效果。BERT的出现标志着从单向的模型向更深层次的双向理解的重大转变。

BERT模型的核心创新点

BERT的核心创新在于其Transformer的编码器架构。它使用Masked Language Model(MLM)和Next Sentence Prediction(NSP)两个预训练任务,在丰富和多样的语料上进行预训练,从而学会语言的深层次语义和句法信息。MLM允许模型预测遮蔽掉的单词,而NSP则训练模型判断两个句子是否在原文中连续出现。

BERT的工作流程

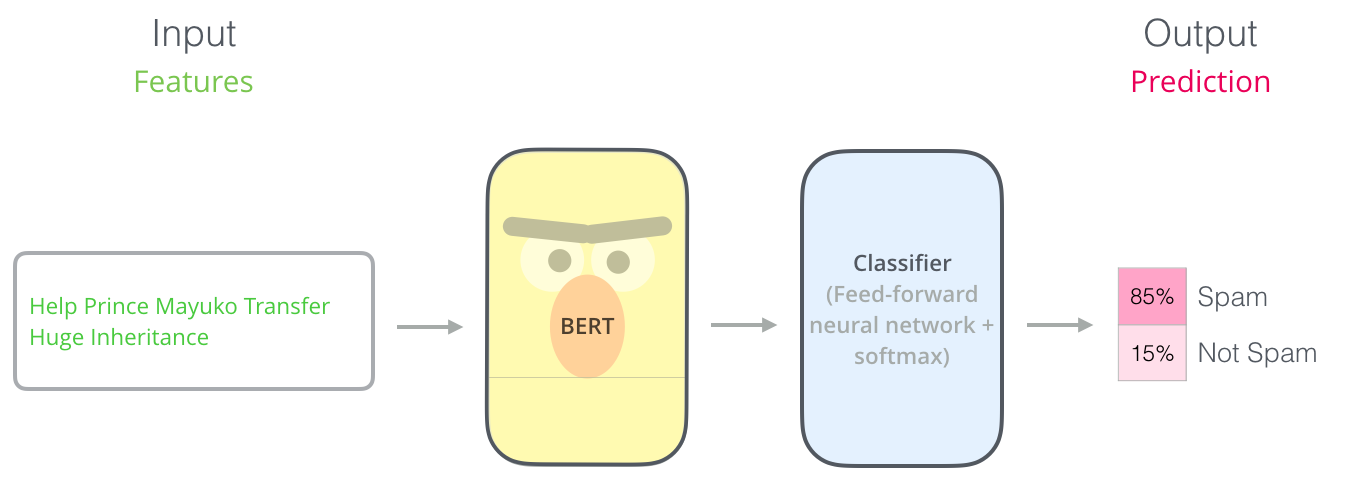

BERT的工作流程分为两个阶段:预训练和微调。预训练阶段,BERT在大型文本语料库上学习语言的通用特征,生成一种通用的语言表示。微调阶段,模型在特定的NLP任务上进行细调,使其能够解决如文本分类、问答系统、命名实体识别等问题。BERT的这种预训练+微调模式极大地提高了模型在各种NLP任务上的性能。

graph LR

A[开始] --> B[预训练BERT模型]

B --> C[微调BERT模型]

C --> D[解决具体NLP任务]

预训练阶段涉及的MLM和NSP任务使得BERT能够理解语言的上下文和句子间的关系。这种双向的学习能力是BERT与其他语言模型如ELMo和GPT的主要区别所在,也是其在NLP领域取得突破性进展的关键。

随着BERT模型的成功,它已经成为了后续研究的基础,例如RoBERTa、ALBERT等模型也相继在此基础上进行创新和优化,推动了NLP领域的发展。

2. BERT在增强器分类中的应用

随着自然语言处理(NLP)技术的飞速发展,BERT模型已经成为诸多文本相关任务的首选解决方案。本章节将深入探讨BERT模型在增强器分类任务中的应用,从定义到实际案例,分析BERT是如何克服传统方法的局限性,并展示它在分类任务中的实际效果。

2.1 增强器分类任务的背景和挑战

增强器分类是信号处理领域的一个重要任务,旨在对各种信号增强设备进行准确分类。这些设备通常具有复杂的数据特性和技术参数,传统分类方法往往面临着高维度特征空间和非线性模式难以捕捉等挑战。

2.1.1 增强器分类问题的定义

在信号处理领域,增强器是指一系列用于增强信号质量的设备,比如放大器、压缩器和均衡器等。分类问题就是要将这些设备根据其工作原理、用途、技术指标等进行细分。这些设备的分类准确率直接关系到信号处理的效率和质量。

2.1.2 传统方法在增强器分类中的局限性

传统方法在处理高维、非线性数据时往往不够高效,诸如支持向量机(SVM)、随机森林等算法在面对复杂的特征空间时性能受限。此外,文本描述和技术参数的自然语言处理也是传统方法难以解决的问题。

2.2 BERT模型对增强器分类的影响

BERT模型的出现为增强器分类任务带来了新的解决方案。其基于深度双向Transformer结构,能够捕捉文本中的丰富语义信息,极大改善了传统方法的局限性。

2.2.1 BERT模型如何解决传统方法的问题

BERT模型通过预训练和微调两个阶段学习语言表示。预训练阶段,BERT利用大量未标注数据学习语言的深层特征;微调阶段,针对特定任务进一步调整模型参数。这种学习模式使得BERT能够在高维、非线性的分类任务中表现优异。

2.2.2 增强器分类中BERT的应用案例

在实际应用中,BERT模型被用于提取增强器的技术文档和用户手册中的语义特征,然后通过微调将这些特征映射到对应的分类标签上。案例显示,与传统方法相比,BERT能够更准确地识别和分类不同类型的增强器。

2.2.3 代码示例与解释

下面是一个使用BERT进行增强器分类的简单代码示例。我们使用Hugging Face的transformers库来加载预训练的BERT模型,并针对特定的增强器分类任务进行微调。

from transformers import BertTokenizer, BertForSequenceClassification

from transformers import Trainer, TrainingArguments

# 加载预训练模型和分词器

model = BertForSequenceClassification.from_pretrained('bert-base-uncased')

tokenizer = BertTokenizer.from_pretrained('bert-base-uncased')

# 预处理数据

def preprocess_function(examples):

return tokenizer(examples['text'], truncation=True)

# 加载并预处理数据集

train_dataset = load_dataset('your_dataset', split='train')

train_dataset = train_dataset.map(preprocess_function)

# 定义训练参数

training_args = TrainingArguments(

output_dir='./results',

num_train_epochs=3,

per_device_train_batch_size=16,

)

# 初始化Trainer

trainer = Trainer(

model=model,

args=training_args,

train_dataset=train_dataset

)

# 开始训练

trainer.train()

在上述代码中,我们首先加载了bert-base-uncased模型及其对应的分词器。然后对数据集进行预处理,包括分词和截断,以适应模型的输入格式。接着设置训练参数,最后通过初始化Trainer并调用其train方法开始训练模型。这是一个典型的BERT微调过程,它能够将预训练模型调整为适用于特定分类任务的模型。

通过本节的介绍,我们了解了BERT模型在增强器分类任务中的应用背景、挑战、影响以及实际案例。下一章将继续深入探讨BERT预训练和微调阶段的细节。

3. BERT预训练和微调阶段

3.1 BERT预训练过程的细节

3.1.1 预训练任务:Masked Language Model和Next Sentence Prediction

BERT模型在预训练阶段采用了两个独特的任务来学习语言的深层特征:Masked Language Model(MLM)和Next Sentence Prediction(NSP)。MLM任务随机地将一定比例的输入单词遮蔽,然后让模型预测这些遮蔽单词。这种方法迫使模型学习理解句子的上下文信息,因为要预测一个单词,模型需要理解它周围的词。MLM的一个关键点是,被遮蔽的单词中有80%会被替换为一个特殊的[MASK]标记,10%会被随机替换为一个错误的单词,另外10%保持不变,这样模型在训练时会看到各种情况。

NSP任务要求模型预测两个句子是否在原始文本中是相邻的。这个任务使得模型能够更好地理解和学习句子间的关系。例如,在处理问答任务时,这个能力可以用来判断问题和答案是否在逻辑上是相关的。

3.1.2 预训练数据和策略的选择

预训练数据的选择对模型的性能有着重要的影响。BERT使用了大规模的无监督语料库,例如WikiText-103和BooksCorpus,这些数据集足够多样化,能够提供丰富的语言特征。为了减少计算资源的消耗和加速训练过程,BERT使用了书籍语料库(BooksCorpus),它包含了7,000多本未发布的书籍,语料丰富且涵盖了多种主题和风格。

在预训练策略方面,BERT采用了一种被称为双向Transformer的架构。与其他语言模型相比,BERT的Transformer能够处理双向的上下文信息,使得每个单词都能接触到句子中所有其他单词的信息。这种模型结构对于学习复杂的语言特征至关重要。

3.2 BERT微调过程的策略

3.2.1 微调过程中的超参数设置

微调是将预训练好的BERT模型应用到特定任务的过程。在微调过程中,模型的参数会被进一步优化以适应特定的数据集。选择合适的超参数对于取得好的微调效果至关重要。超参数包括学习率、批次大小、训练周期数(Epochs)、dropout比率等。

学习率的设置尤其关键,它决定了在训练过程中参数更新的幅度。对于BERT微调来说,通常会使用较小的学习率,例如2e-5到5e-5之间,以避免模型在微调过程中过度调整参数而忘记在预训练中学到的知识。批次大小也会影响模型训练的稳定性和效率,通常在16到32之间选择。

3.2.2 微调实例:从预训练模型到特定分类任务的转换

微调BERT模型到特定的分类任务是一个相对直接的过程。首先,你需要准备你的数据集,并将其转换成BERT能够理解的格式。通常,这意味着将输入文本分成特定长度的段落,并添加适当数量的特殊标记(如CLS和SEP),以符合BERT的输入要求。

一旦数据准备就绪,你可以加载预训练好的BERT模型,并在特定任务的数据集上继续训练。在这个过程中,BERT模型的大部分参数会固定不变,只有顶层(通常是分类层)的参数会被更新。此外,为了适应特定的任务,可能需要添加一个或多个新的分类层(例如,使用全连接层)。

微调过程中,你可以通过监控验证集上的性能来调整超参数。此外,还需要对模型进行适当的正则化,如增加dropout比率,以防止过拟合。训练完成后,模型会在测试集上进行评估,以确定其在特定任务上的表现。

# 以下是一个PyTorch中的简单BERT微调实例代码块

from transformers import BertTokenizer, BertForSequenceClassification

from torch.utils.data import DataLoader, RandomSampler

from torch.optim import AdamW

# 加载预训练模型和分词器

model = BertForSequenceClassification.from_pretrained('bert-base-uncased')

tokenizer = BertTokenizer.from_pretrained('bert-base-uncased')

# 准备数据集

def encode_examples(examples, tokenizer):

return [tokenizer.encode(e, truncation=True, padding='max_length', max_length=128) for e in examples]

train_encodings = encode_examples(train_examples, tokenizer)

valid_encodings = encode_examples(valid_examples, tokenizer)

train_dataset = TensorDataset(torch.tensor(train_encodings), torch.tensor(train_labels))

valid_dataset = TensorDataset(torch.tensor(valid_encodings), torch.tensor(valid_labels))

train_loader = DataLoader(train_dataset, batch_size=16, sampler=RandomSampler(train_dataset))

valid_loader = DataLoader(valid_dataset, batch_size=16)

# 微调模型

optimizer = AdamW(model.parameters(), lr=3e-5)

for epoch in range(num_epochs):

model.train()

for batch in train_loader:

input_ids, labels = batch

optimizer.zero_grad()

outputs = model(input_ids, labels=labels)

loss = outputs.loss

loss.backward()

optimizer.step()

model.eval()

在上述代码中,我们首先加载了BERT模型和分词器,然后对训练和验证数据集进行了编码处理,以便它们能够被BERT模型处理。接着我们创建了数据加载器,并开始微调模型。在微调过程中,我们计算了损失并进行了反向传播,以更新模型的参数。最终我们评估模型在验证集上的性能。注意,这只是一个简单的例子,实际应用中可能需要更复杂的数据处理和训练策略。

4. 高维向量表示在代码或文档编码中的应用

在第四章中,我们将深入探讨高维向量表示在编码代码或文档时的应用,特别关注于如何通过这些表示形式提高机器学习模型的性能。

4.1 文档编码的高维向量表示方法

4.1.1 文档编码的重要性和挑战

文档编码是自然语言处理(NLP)中的一个基本任务,它旨在将文本转换为计算机可以理解的数值格式。高维向量表示在此过程中扮演了核心角色。这种表示形式能够捕获文本数据中的复杂语义信息和结构信息,对于提高机器学习模型的性能至关重要。

文档编码的主要挑战在于如何有效地捕捉上下文信息,保持词义的丰富性,以及如何在高维空间中减少数据的稀疏性。传统的词袋模型(BOW)或TF-IDF方法往往忽略了单词之间的顺序和上下文关系,因此无法有效地应对这些挑战。

4.1.2 高维向量表示技术的选择和实现

当前,有多种高维向量表示技术可供选择,包括Word2Vec、GloVe、FastText和BERT等。BERT(双向编码器表示)由于其双向上下文理解能力,已成为许多NLP任务中的首选方法。BERT通过在预训练阶段对大量文本进行处理,学习到了丰富的语言表示,并在微调阶段可以适应到具体的下游任务中。

在实现高维向量表示时,需要考虑以下几点: - 模型选择 :选择适合任务的模型和预训练版本。 - 超参数设置 :例如向量的维度大小、序列的最大长度等。 - 编码实现 :使用合适的库,如Hugging Face的Transformers库,来实现BERT等模型的编码过程。

接下来,让我们探讨高维向量表示在分类任务中的具体作用。

4.2 高维向量表示在分类任务中的作用

4.2.1 向量表示在特征提取中的应用

向量表示在特征提取中的应用是通过将文本数据转化为高维空间的数值向量来实现的。这些向量捕捉了词汇、句子或文档的语义信息,因此可以作为分类模型的输入特征。

在分类任务中,向量表示的应用通常包括以下几个步骤: 1. 文本预处理 :包括分词、去除停用词等。 2. 向量化 :将处理后的文本转换为向量形式。 3. 特征提取 :选择或训练适合的模型,如BERT,来提取文本特征。

4.2.2 向量表示对于模型性能的影响分析

高维向量表示对模型性能的影响是显著的。通过使用BERT等高级表示方法,可以提高模型对于文本细微差异的感知能力,从而改善分类准确率。

为了更好地理解这种影响,我们可以从以下几个方面进行分析: - 语义丰富性 :高维向量能够表达词汇间的复杂关系和上下文依赖性。 - 表征能力 :通过预训练获得的表示能够更好地泛化到不同领域。 - 计算效率 :一些预训练模型可能需要高性能硬件来快速处理数据。

具体到代码示例,以下是使用BERT模型对句子进行向量化的一个简单例子:

from transformers import BertTokenizer, BertModel

# 加载预训练模型和分词器

tokenizer = BertTokenizer.from_pretrained('bert-base-uncased')

model = BertModel.from_pretrained('bert-base-uncased')

# 编码文本

input_text = "Replace me by any text you'd like."

encoded_input = tokenizer(input_text, return_tensors='pt')

output = model(**encoded_input)

在这段代码中,我们首先加载了BERT模型和其对应的分词器。随后,我们通过分词器将文本编码为适合模型处理的格式,并通过BERT模型生成高维向量表示。这样的表示随后可以被用于下游的任务,如分类、实体识别等。

为了更全面地了解BERT模型的输出,我们可以分析它产生的一系列向量,并与传统的表示方法进行比较。例如,BERT不仅为每个单词生成向量,还为整个输入序列生成一个上下文相关的表示。

在表格中,我们可以总结BERT和传统方法的性能差异:

| 特征提取方法 | 上下文感知能力 | 适应性 | 计算资源需求 | |-------------|--------------|-------|------------| | BERT | 高 | 强 | 高 | | Word2Vec | 低 | 弱 | 低 | | TF-IDF | 低 | 一般 | 低 |

表格展示了BERT模型与传统表示方法在不同方面的对比。BERT的上下文感知能力显著高于传统方法,但这也意味着更高的计算资源需求。

在高维向量表示的探索中,我们不断发现其在NLP任务中的优势,比如提高模型的性能和准确性。接下来,我们将深入探讨分类层的学习过程及其在增强器识别中的应用。

5. 分类层的学习和增强器识别

在机器学习的多分类问题中,分类层是连接模型特征提取与最终决策的关键组成部分。第五章探讨了分类层的设计、实现和在增强器识别任务中的应用。本章节将深入分析分类层的不同架构选择,以及如何训练并调整其参数以获得最优的模型性能。此外,本章还将讨论增强器特征的提取,模型集成的方法,以及评估模型准确性的指标。

5.1 分类层的设计和实现

分类层是神经网络模型中用于执行最终分类决策的部分。它通常紧跟在特征提取层之后,并将提取到的特征转换为类别概率分布。为了达到最佳性能,需要精心设计分类层的架构,并进行适当的参数调优。

5.1.1 分类层架构的选择

在选择分类层架构时,有几个因素需要考虑,包括问题的复杂度、可用的数据量以及计算资源。常见的分类层架构包括全连接层(Fully Connected Layers, FC)、卷积神经网络(Convolutional Neural Networks, CNNs)和循环神经网络(Recurrent Neural Networks, RNNs)。对于BERT模型而言,分类层通常采用全连接层,因为BERT已经能够提取到强有力的文本特征。

5.1.2 分类层的训练和参数调优

分类层的训练过程中,需要对权重进行更新以最小化损失函数。在本节中,我们将讨论以下关键参数的调优:

- 学习率(Learning Rate)

- 批量大小(Batch Size)

- 正则化方法(Regularization)

学习率

学习率是控制权重更新步长的关键参数。学习率过大可能会导致模型无法收敛,过小则会使训练过程缓慢。一种常见的策略是使用学习率衰减,即在训练过程中逐渐减小学习率。

批量大小

批量大小决定了每次迭代中用于计算梯度的样本数。较大的批量大小能够提供更稳定的梯度估计,但也可能导致内存消耗增加和模型收敛速度变慢。

正则化方法

正则化是一种防止模型过拟合的技术。常见的正则化方法包括L1和L2正则化,以及Dropout。L1和L2正则化通过对权重添加惩罚项来限制模型的复杂度,而Dropout通过随机丢弃一些神经元来增强模型的泛化能力。

下面是一个使用PyTorch进行分类层训练的简单代码示例:

import torch

import torch.nn as nn

import torch.optim as optim

# 假设input_dim是特征维度,num_classes是类别数

input_dim = 768

num_classes = 10

# 创建一个全连接层作为分类器

class Classifier(nn.Module):

def __init__(self):

super(Classifier, self).__init__()

self.fc = nn.Linear(input_dim, num_classes)

def forward(self, x):

return self.fc(x)

# 实例化模型

model = Classifier()

# 定义损失函数和优化器

criterion = nn.CrossEntropyLoss()

optimizer = optim.Adam(model.parameters(), lr=0.001)

# 假设train_loader是包含训练数据的DataLoader

for epoch in range(num_epochs):

for inputs, labels in train_loader:

# 清除梯度

optimizer.zero_grad()

# 前向传播

outputs = model(inputs)

# 计算损失

loss = criterion(outputs, labels)

# 反向传播和优化

loss.backward()

optimizer.step()

# 可以在这里进行验证和调整学习率等操作

5.2 增强器的识别与分类过程

本节讨论增强器的识别与分类过程,涵盖特征提取、分类模型集成以及如何评估模型性能。

5.2.1 增强器特征的提取和分类模型的集成

为了识别和分类增强器,首先需要提取能够有效表示增强器特征的向量。BERT模型已经能够提供深层次的语义理解,因此可以将BERT模型输出的最后一个隐藏层向量作为分类模型的输入。接下来,将这些特征输入到分类层,得到增强器的类别预测。

分类模型的集成可以采用多种技术,如Bagging、Boosting或Stacking。这些方法通过结合多个模型的预测来提高整体性能。在本章后续部分,我们将详细探讨这些集成方法的实施。

5.2.2 模型评估指标和增强器识别的准确性

模型的性能评估通常使用准确度(Accuracy)、精确率(Precision)、召回率(Recall)、F1分数(F1 Score)等指标。对于不平衡数据集,还需要考虑ROC-AUC(Receiver Operating Characteristic - Area Under Curve)和PR-AUC(Precision-Recall Area Under Curve)。

准确度表示预测正确的样本占总样本的比例。精确率是正确预测为正的样本占所有预测为正样本的比例,召回率是正确预测为正的样本占实际正样本的比例。F1分数则是精确率和召回率的调和平均值,用来综合考虑二者。

在不平衡数据集中,ROC-AUC和PR-AUC提供了更全面的性能评估。ROC曲线通过改变分类阈值来展示模型的真阳性率(Recall)和假阳性率的平衡,而PR曲线则专注于正样本的预测。

下面是使用Python的scikit-learn库计算上述性能评估指标的示例代码:

from sklearn.metrics import accuracy_score, precision_score, recall_score, f1_score, roc_auc_score, precision_recall_curve

# 假设y_true是真实的标签,y_pred是模型预测的标签

y_true = [0, 1, 0, 1, 0]

y_pred = [0, 1, 0, 0, 1]

# 计算准确度

accuracy = accuracy_score(y_true, y_pred)

print(f'Accuracy: {accuracy}')

# 计算精确率、召回率和F1分数

precision = precision_score(y_true, y_pred)

recall = recall_score(y_true, y_pred)

f1 = f1_score(y_true, y_pred)

print(f'Precision: {precision}')

print(f'Recall: {recall}')

print(f'F1 Score: {f1}')

# 计算ROC-AUC和PR-AUC

y_score = [0.1, 0.4, 0.35, 0.8, 0.7]

roc_auc = roc_auc_score(y_true, y_score)

precision, recall, thresholds = precision_recall_curve(y_true, y_score)

pr_auc = auc(recall, precision)

print(f'ROC-AUC: {roc_auc}')

print(f'PR-AUC: {pr_auc}')

在进行性能评估时,应根据具体问题和数据集选择合适的评估指标,并对模型进行细致的调整,以达到最佳性能。

6. 实践与优化

6.1 bert-enhancer-main 代码库的使用方法

bert-enhancer-main 是一个为增强器分类任务专门设计的代码库,它集成了BERT模型预训练、微调以及在特定任务中的应用。在这一节中,我们将深入了解如何使用这一代码库,并指导您通过具体的步骤来完成一个增强器分类项目。

6.1.1 代码库结构和功能概述

bert-enhancer-main 代码库的结构大致分为以下几个模块:

- 预训练模块: 包含了BERT模型预训练的脚本,可以通过调整参数来定制不同的预训练策略。

- 微调模块: 提供了多种微调脚本,用于将预训练好的模型适配到特定的增强器分类任务。

- 模型评估模块: 实现了不同的评估指标,帮助用户衡量模型在分类任务中的表现。

- 数据处理模块: 提供了数据加载和处理的工具,支持多种格式数据的输入。

代码库的安装非常简单,您可以使用 pip 来安装它:

pip install bert-enhancer-main

安装后,您可以通过命令行来运行不同的脚本,或在Python代码中导入相关模块来执行特定任务。

6.1.2 如何使用代码库进行增强器分类

要使用 bert-enhancer-main 进行增强器分类,首先需要准备训练数据和测试数据。通常情况下,数据是准备好的CSV文件,其中包含了文本数据和对应的分类标签。

以下是一个使用脚本进行增强器分类的基本步骤:

- 预训练BERT模型(如果还没有预训练模型的话)。

- 微调模型,使其适应增强器分类任务。

- 使用训练好的模型对测试数据进行预测。

- 评估模型性能,并进行后续的分析或优化。

一个简单的微调脚本例子可以是:

from bert_enhancer_main import BERTClassifier, load_dataset

# 加载数据集

train_dataset, test_dataset = load_dataset('path_to_train.csv', 'path_to_test.csv')

# 实例化BERT分类器

model = BERTClassifier()

# 微调模型

model.fit(train_dataset)

# 进行预测

predictions = model.predict(test_dataset)

# 评估模型

model.evaluate(test_dataset)

上述代码仅作为一个简单的例子, bert-enhancer-main 提供了更丰富的配置选项和功能,用户可以根据自己的需求进行定制。

6.2 优化BERT模型性能的策略

BERT模型虽然强大,但在实际应用中往往需要根据特定任务进行优化。以下是几个常用的优化策略,它们可以显著提升BERT模型在增强器分类任务中的性能。

6.2.1 模型训练过程中的常见问题及解决方案

过拟合: 这是在训练BERT模型时经常遇到的问题。为了解决它,可以采用数据增强、正则化技术(比如dropout)和早停策略。

梯度消失/爆炸: 使用适当的初始化方法和梯度裁剪(gradient clipping)可以有效缓解这个问题。另外,学习率预热和学习率衰减也是常用的方法。

计算资源限制: BERT模型非常占用计算资源。通过使用更小的模型版本、减少模型层数、使用混合精度训练(比如FP16)等策略,可以在不显著降低模型性能的前提下减少资源消耗。

6.2.2 模型泛化能力的提升策略

为了提升模型的泛化能力,可以考虑以下方法:

- 集成学习: 结合多个模型的预测结果,一般可以有效提高模型的泛化能力。

- 超参数调优: 通过系统地遍历不同的超参数设置,找到最优化模型性能的超参数组合。

- 半监督学习: 如果标注数据有限,可以使用未标注数据来辅助模型训练。

通过综合运用以上策略,我们可以有效地提升BERT模型在增强器分类任务中的性能。在实践中,不断调整和优化这些策略是实现最佳模型性能的关键。

简介:BERT作为Google的预训练语言模型,通过双向理解文本信息,为NLP任务提供强大的支持。本项目探讨了BERT在增强器分类中的应用,增强器作为软件系统关键元素对性能、稳定性和安全性至关重要。项目首先理解BERT的工作原理,然后将其应用于编码代码或文档,转化为高维向量表示,再通过添加分类层学习区分不同类型的增强器。使用 bert-enhancer-main 代码库完成数据预处理、模型构建、训练和评估。优化BERT性能涉及超参数调整和模型泛化能力确保,旨在提高软件开发自动化水平和代码质量。