四、异构计算案例分析

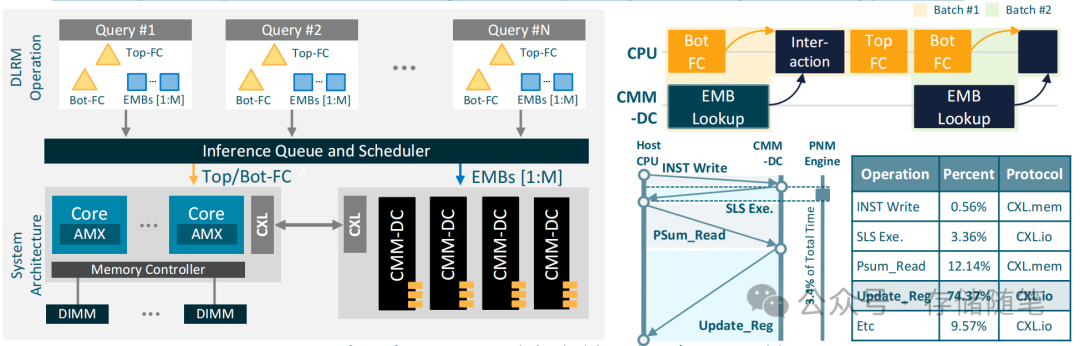

深度学习推荐系统(DLRM)是一种典型的混合负载应用,它结合了计算密集型和内存密集型操作。为了提高DLRM的吞吐性能,异构计算平台(xPU + CMM-DC)通过将计算密集型任务和内存密集型任务分别分配给最适合处理它们的硬件资源,来实现更高效的执行。

计算密集型操作

-

全连接层(FC):DLRM中的全连接层(FC)是典型的计算密集型操作,涉及大量的矩阵乘法和非线性激活函数计算。这些操作需要大量的计算资源,并且通常由CPU或GPU等计算单元来处理。

-

特征交互(Feature Interaction):特征交互也是计算密集型操作的一部分,它涉及到将不同的特征组合起来以生成更高级别的表示。

内存密集型操作

-

嵌入查找(Embedding Lookup):嵌入查找是指在嵌入表(Embedding Tables)中查找对应的项,这些表通常非常大,并且访问模式是不规则的。嵌入查找属于内存密集型操作,因为它们需要大量的内存读取,并且对内存带宽有较高的要求。

异构 xPU + CMM-DC 平台的设计思路

计算单元(xPU)

-

xPU:xPU代表了多种类型的计算单元,包括CPU、GPU、FPGA、ASIC等。在这个平台上,计算密集型任务(如FC层和特征交互)由最适合处理这些任务的计算单元来执行。例如,GPU通常用于加速矩阵运算,而CPU则负责控制流逻辑。

近内存处理单元(CMM-DC)

-

CMM-DC:通过将计算能力集成到内存附近来优化内存密集型任务的性能。CMM-DC控制器将PNM Engine IP放在CXL IP和内存控制器之间,使得嵌入查找等内存密集型操作可以在靠近数据存储的位置进行处理,从而减少数据传输的延迟。

提升性能的关键因素

完成检查(Completion Check)的延迟

-

延迟敏感性:对于一些延迟敏感的应用程序,如在线推荐系统,完成检查(Completion Check)可能会成为一个瓶颈。完成检查是指确认所有必要的计算任务已经完成,以便可以继续后续的处理步骤。

-

优化策略:为了减轻完成检查带来的延迟影响,可以采取多种优化策略,如异步计算、流水线处理以及预取机制等。此外,通过CXL技术提供的高速互连,可以进一步减少完成检查所需的时间。

实现异构计算平台的优势

分布式计算

-

计算与内存分离:通过将计算密集型任务分配给xPU,而将内存密集型任务交给CMM-DC处理,可以实现计算与内存的有效分离,从而提高整体系统的性能。

-

资源共享:异构平台允许不同计算单元之间共享资源,如内存池,这有助于提高资源利用率并减少数据复制带来的开销。

灵活性与扩展性

-

灵活配置:异构平台可以根据具体应用需求灵活配置计算单元和内存资源,以达到最佳性能。

-

易于扩展:通过CXL技术的支持,系统可以方便地添加更多的计算或内存资源,以应对不断增长的工作负载需求。

异构 xPU + CMM-DC 平台通过将计算密集型任务和内存密集型任务合理分配给最适合处理它们的硬件资源,显著提升了DLRM推理的吞吐性能。通过优化完成检查的延迟,并利用CXL技术实现高效的数据传输,该平台不仅提高了计算效率,还降低了延迟,增强了系统的整体性能。随着技术的不断进步,这种异构计算方案将在更多领域得到应用,为高性能计算环境提供更强有力的支持。

如果您看完有所受益,欢迎点击文章底部左下角“关注”并点击“分享”、“在看”,非常感谢!

精彩推荐: