首先,给出一个学习清单:

构建大语言模型(LLM)所需知识与资源清单

前排提示,文末有大模型AGI-CSDN独家资料包哦!

1.基础知识与技能

-

编程语言:Python

-

深度学习库:TensorFlow, PyTorch

-

算法知识:自然语言处理(NLP),机器学习,深度学习

2.推荐书籍

-

《深度学习》 by Ian Goodfellow, Yoshua Bengio, and Aaron Courville

-

《Speech and Language Processing》 by Daniel Jurafsky and James H. Martin

-

《自然语言处理综论》 by Christopher Manning, Hinrich Schütze

3.开发工具

-

Jupyter Notebook

-

Hugging Face Transformers库

4.开源资源

-

开源项目:Hugging Face Transformers, OpenAI GPT

-

数据集:Wikipedia, Common Crawl, OpenWebText

5.计算资源

-

高性能GPU/TPU

-

云计算平台:AWS, Microsoft Azure,阿里云、腾讯云,华为云等

有了清单后,我们就可以来逐步攻克这个难关了。

我们要梳理一下构建一个大语言模型的整个流程。

从零开始构建大语言模型(LLM)的难度与要求

构建大语言模型(LLM)对于没有团队支持的个人来说是一个巨大的挑战,需要深厚的技术知识、丰富的计算资源和大量的数据。以下是详细步骤和要求,通过一个人的独立流程,让大家对整个过程有清晰的认识。

1. 编程与算法

掌握Python和深度学习库:

-

例子:学习并熟练使用Python的TensorFlow和PyTorch库。

-

具体步骤:通过在线课程和项目练习,掌握Python编程基础;然后深入学习TensorFlow和PyTorch的基本概念和应用。

理解自然语言处理(NLP)和深度学习算法:

-

例子:理解并实现Transformer架构。

-

具体步骤:阅读并理解论文《Attention is All You Need》,然后尝试用TensorFlow实现一个简单的Transformer模型。

2. 模型结构

理解Transformer模型:

-

例子:从头实现一个简化版的Transformer模型。

-

具体步骤:在理解论文的基础上,先实现一个简单的Encoder-Decoder模型,然后逐步增加复杂性。

进行模型调优和性能优化:

-

例子:通过调整超参数提高模型性能。

-

具体步骤:尝试不同的学习率、批量大小等参数,使用验证集评估模型性能,找到最佳配置。

3. 计算资源

需要高性能GPU/TPU支持:

-

例子:使用Google Colab进行初步实验。

-

具体步骤:注册Google Colab,配置环境,使用免费提供的GPU资源进行小规模实验。

考虑使用云计算资源:

-

例子:租用AWS的EC2实例进行大规模训练。

-

具体步骤:注册AWS账号,选择适合的EC2实例,配置深度学习环境,上传数据集并开始训练。

4. 数据准备

收集大量高质量文本数据:

-

例子:使用公开的Wikipedia数据集。

-

具体步骤:从Wikipedia下载数据集,使用Python进行数据清洗和预处理。

进行数据清洗和预处理:

-

例子:编写脚本去除无关内容和格式化文本。

-

具体步骤:编写Python脚本,去除HTML标签、特殊字符等,整理成训练所需的格式。

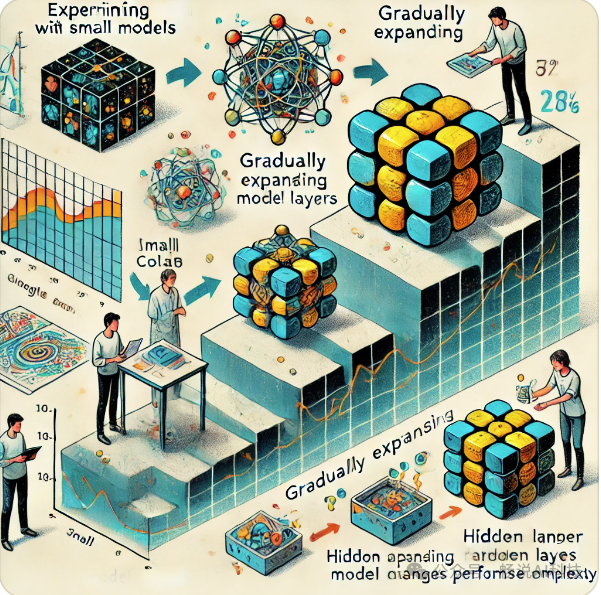

5. 小规模实验

从小模型开始实验:

-

例子:训练一个小型GPT模型。

-

具体步骤:在Google Colab上实现并训练一个小型GPT模型,使用小规模数据集进行测试和调整。

逐步扩展模型规模和复杂性:

-

例子:逐步增加模型层数和参数规模。

-

具体步骤:从小规模模型开始,逐步增加Transformer层数和隐藏层大小,观察性能变化。

6. 学习与实践

学习NLP和深度学习基础知识:

-

例子:学习经典教材《Speech and Language Processing》和《Deep Learning》。

-

具体步骤:系统学习相关教材,完成书中的练习和项目,打好理论基础。

参与开源项目积累实践经验:

-

例子:参与Hugging Face Transformers库的开发。

-

具体步骤:在GitHub上查找并参与开源项目,解决实际问题,积累实战经验。

7. 工具和资源

使用开发工具如Jupyter Notebook和Hugging Face Transformers库:

-

例子:在Jupyter Notebook中实现一个文本生成模型。

-

具体步骤:安装Jupyter Notebook,使用Hugging Face库加载预训练模型,进行文本生成实验。

利用开源数据集进行模型训练:

-

例子:使用OpenAI提供的预训练数据集。

-

具体步骤:下载数据集,进行预处理,训练模型,评估结果并进行优化。

8. 社区参与

参与NLP社区,学习前沿技术:

-

例子:加入AI和NLP论坛,参加相关讨论和研讨会。

-

具体步骤:注册并活跃于Reddit的r/MachineLearning和AI Alignment Forum,参与讨论并分享自己的项目。

参加研讨会和培训:

-

例子:参加ACL、EMNLP等顶级会议。

-

具体步骤:关注会议官网,提交论文或报名参会,参与技术交流和学习。

写在最后

从零开始构建大语言模型需要强大的技术能力、丰富的计算资源和持续的学习与实践。

通过从小规模实验和现有开源资源入手,逐步积累经验,并积极参与NLP社区和相关项目,可以逐步实现构建大语言模型的目标。

通过上述具体步骤和案例,可以更清晰地了解整个过程和所需的积累。

如何学习AI大模型?

我在一线互联网企业工作十余年里,指导过不少同行后辈。帮助很多人得到了学习和成长。

我意识到有很多经验和知识值得分享给大家,也可以通过我们的能力和经验解答大家在人工智能学习中的很多困惑,所以在工作繁忙的情况下还是坚持各种整理和分享。但苦于知识传播途径有限,很多互联网行业朋友无法获得正确的资料得到学习提升,故此将并将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

如何学习AI大模型?

作为一名热心肠的互联网老兵,我决定把宝贵的AI知识分享给大家。 至于能学习到多少就看你的学习毅力和能力了 。我已将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

一、全套AGI大模型学习路线

AI大模型时代的学习之旅:从基础到前沿,掌握人工智能的核心技能!

二、640套AI大模型报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

三、AI大模型经典PDF籍

随着人工智能技术的飞速发展,AI大模型已经成为了当今科技领域的一大热点。这些大型预训练模型,如GPT-3、BERT、XLNet等,以其强大的语言理解和生成能力,正在改变我们对人工智能的认识。 那以下这些PDF籍就是非常不错的学习资源。

四、AI大模型商业化落地方案

作为普通人,入局大模型时代需要持续学习和实践,不断提高自己的技能和认知水平,同时也需要有责任感和伦理意识,为人工智能的健康发展贡献力量。

本文转自 https://blog.csdn.net/2301_82275412/article/details/143213581?spm=1001.2014.3001.5501,如有侵权,请联系删除。