AI时代,知识库的构建和管理变得愈发重要。无论是企业级应用还是个人项目,选择一个合适的知识库方案都能大大提升效率和效果。本文将基于DeepSeek的强大,深入分析 Dify + DeepSeek、Anything LLM + DeepSeek、Ollama + DeepSeek 和硅基流动 + DeepSeek 四种方案,帮助你找到最适合自己的选择。

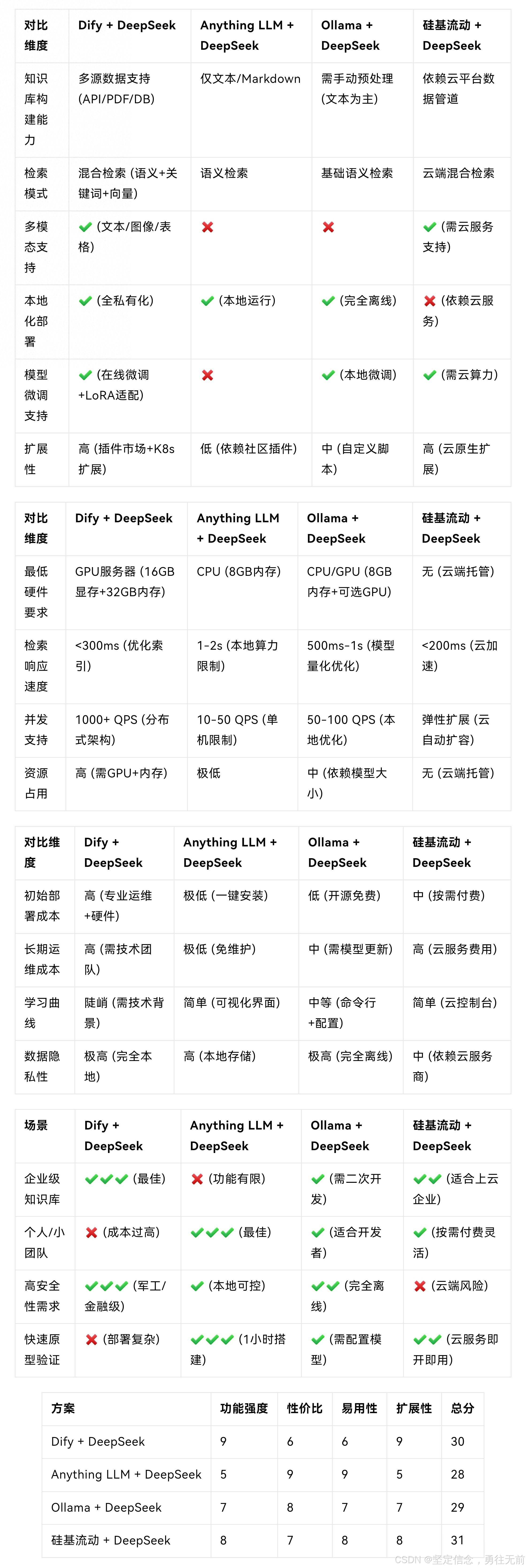

功能与特性对比

首先,我们来看功能与特性方面的对比。这四个方案在知识库构建能力、检索模式、多模态支持、本地化部署、模型微调支持和扩展性上各有优劣。

- 知识库构建能力:

- Dify + DeepSeek:支持多源数据(API/PDF/DB),适合需要整合多种数据源的场景。

- Anything LLM + DeepSeek:仅支持文本和 Markdown,适合简单的文本知识库。

- Ollama + DeepSeek:需要手动预处理(文本为主),适合对数据预处理有较高要求的场景。

- 硅基流动 + DeepSeek:依赖云平台数据管道,适合需要云端数据整合的场景。

- 检索模式:

- Dify + DeepSeek:混合检索(语义+关键词+向量),适合复杂的检索需求。

- Anything LLM + DeepSeek:语义检索,适合需要语义理解的场景。

- Ollama + DeepSeek:基础语义检索,适合基本的语义检索需求。

- 硅基流动 + DeepSeek:云端混合检索,适合需要云端支持的复杂检索需求。

- 多模态支持:

- Dify + DeepSeek:支持文本、图像和表格,适合多模态数据的场景。

- Anything LLM + DeepSeek:不支持多模态。

- Ollama + DeepSeek:不支持多模态。

- 硅基流动 + DeepSeek:支持多模态(需云服务支持),适合需要云端多模态支持的场景。

- 本地化部署:

- Dify + DeepSeek:全私有化,适合对数据隐私要求极高的场景。

- Anything LLM + DeepSeek:本地运行,适合需要本地部署的场景。

- Ollama + DeepSeek:完全离线,适合需要完全离线的场景。

- 硅基流动 + DeepSeek:依赖云服务,适合需要云端支持的场景。

- 模型微调支持:

- Dify + DeepSeek:支持在线微调和 LoRA 适配,适合需要模型微调的场景。

- Anything LLM + DeepSeek:不支持模型微调。

- Ollama + DeepSeek:支持本地微调,适合需要本地微调的场景。

- 硅基流动 + DeepSeek:支持云算力,适合需要云端微调的场景。

- 扩展性:

- Dify + DeepSeek:高(插件市场+K8s扩展),适合需要高扩展性的场景。

- Anything LLM + DeepSeek:低(依赖社区插件),适合对扩展性要求不高的场景。

- Ollama + DeepSeek:中(自定义脚本),适合需要中等扩展性的场景。

- 硅基流动 + DeepSeek:高(云原生扩展),适合需要高扩展性的云端场景。

性能与资源对比

接下来,我们来看性能与资源方面的对比。这四个方案在最低硬件要求、检索响应速度、并发支持和资源占用上各有特点。

- 最低硬件要求:

- Dify + DeepSeek:GPU服务器(16GB显存+32GB内存),适合对硬件要求较高的场景。

- Anything LLM + DeepSeek:CPU(8GB内存),适合对硬件要求较低的场景。

- Ollama + DeepSeek:CPU/GPU(8GB内存+可选GPU),适合对硬件要求适中的场景。

- 硅基流动 + DeepSeek:无(云端托管),适合不需要本地硬件的场景。

- 检索响应速度:

- Dify + DeepSeek:<300ms(优化索引),适合对响应速度要求较高的场景。

- Anything LLM + DeepSeek:1-2s(本地算力限制),适合对响应速度要求适中的场景。

- Ollama + DeepSeek:500ms-1s(模型量化优化),适合对响应速度要求适中的场景。

- 硅基流动 + DeepSeek:<200ms(云加速),适合对响应速度要求较高的云端场景。

- 并发支持:

- Dify + DeepSeek:1000+ QPS(分布式架构),适合高并发需求的场景。

- Anything LLM + DeepSeek:10-50 QPS(单机限制),适合对并发需求不高的场景。

- Ollama + DeepSeek:50-100 QPS(本地优化),适合对并发需求适中的场景。

- 硅基流动 + DeepSeek:弹性扩展(云自动扩容),适合高并发需求的云端场景。

- 资源占用:

- Dify + DeepSeek:高(需GPU+内存),适合对资源占用要求较高的场景。

- Anything LLM + DeepSeek:极低,适合对资源占用要求极低的场景。

- Ollama + DeepSeek:中(依赖模型大小),适合对资源占用要求适中的场景。

- 硅基流动 + DeepSeek:无(云端托管),适合不需要本地资源的场景。

成本与易用性对比

最后,我们来看成本与易用性方面的对比。这四个方案在初始部署成本、长期运维成本、学习曲线和数据隐私性上各有优劣。

- 初始部署成本:

- Dify + DeepSeek:高(专业运维+硬件),适合预算充足的场景。

- Anything LLM + DeepSeek:极低(一键安装),适合预算有限的场景。

- Ollama + DeepSeek:低(开源免费),适合预算有限的场景。

- 硅基流动 + DeepSeek:中(按需付费),适合预算适中的场景。

- 长期运维成本:

- Dify + DeepSeek:高(需技术团队),适合有技术团队支持的场景。

- Anything LLM + DeepSeek:极低(免维护),适合不需要长期维护的场景。

- Ollama + DeepSeek:中(需模型更新),适合需要定期更新的场景。

- 硅基流动 + DeepSeek:高(云服务费用),适合有长期云服务预算的场景。

- 学习曲线:

- Dify + DeepSeek:陡峭(需技术背景),适合有技术背景的用户。

- Anything LLM + DeepSeek:简单(可视化界面),适合没有技术背景的用户。

- Ollama + DeepSeek:中等(命令行+配置),适合有一定技术背景的用户。

- 硅基流动 + DeepSeek:简单(云控制台),适合没有技术背景的用户。

- 数据隐私性:

- Dify + DeepSeek:极高(完全本地),适合对数据隐私要求极高的场景。

- Anything LLM + DeepSeek:高(本地存储),适合对数据隐私要求较高的场景。

- Ollama + DeepSeek:极高(完全离线),适合对数据隐私要求极高的场景。

- 硅基流动 + DeepSeek:中(依赖云服务商),适合对数据隐私要求适中的场景。

场景适配度对比

根据上述对比,我们可以得出以下场景适配度的结论:

- 企业级知识库:

- Dify + DeepSeek:最佳选择,适合有技术团队的中大型企业。

- Ollama + DeepSeek:需二次开发,适合需要定制化的企业。

- 硅基流动 + DeepSeek:适合上云企业。

- 个人/小团队:

- Anything LLM + DeepSeek:最佳选择,适合零代码+低成本的个人或小团队。

- Ollama + DeepSeek:适合开发者,需要一定的技术背景。

- 硅基流动 + DeepSeek:按需付费,适合需要灵活扩展的个人或小团队。

- 高安全性需求:

- Dify + DeepSeek:最佳选择,适合军工/金融级的安全需求。

- Ollama + DeepSeek:本地可控,适合需要本地部署的高安全性需求。

- 硅基流动 + DeepSeek:云端风险,不适合高安全性需求。

- 快速原型验证:

- Anything LLM + DeepSeek:最佳选择,适合快速搭建原型的场景。

- Ollama + DeepSeek:需配置模型,适合需要快速验证的开发者。

- 硅基流动 + DeepSeek:云服务即开即用,适合需要快速验证的云端场景。

推荐选择策略

综上所述,我们可以得出以下推荐选择策略:

1.追求极致功能与企业级服务:

Dify + DeepSeek:适合有技术团队的中大型企业,提供全面的功能和高扩展性。

2.个人/小团队快速启动:

Anything LLM + DeepSeek:零代码+低成本的最佳选择,适合快速搭建知识库的个人或小团队。

3.开发者自定义需求:

Ollama + DeepSeek:灵活控制模型与本地资源,适合需要定制化的开发者。

4.云原生与弹性扩展:

硅基流动 + DeepSeek:适合接受云端服务的互联网公司,提供高扩展性和弹性支持。

希望本文的分析能帮助你找到最适合自己的 DeepSeek 知识库方案,提升你的工作效率和效果。

以下是将上述内容以表格形式呈现:

希望这能满足你的需求!