目录

Seq2Seq(Sequence-to-Sequence)模型详解

DeiT(Data-efficient Image Transformer)详解

CLIP(Contrastive Language–Image Pretraining)详解

DDPM(Denoising Diffusion Probabilistic Models)详解

误差反向传播

误差反向传播是神经网络训练中的关键步骤,用于计算损失函数对每个参数的梯度。具体过程如下:

-

前向传播:输入数据通过神经网络,计算输出。

-

计算损失:比较输出与真实值,计算损失函数。

-

反向传播:从输出层开始,逐层计算损失函数对每个参数的梯度。

-

参数更新:使用梯度下降法更新参数,最小化损失。

BP算法

BP算法是完整的训练过程,包含以下步骤:

-

初始化参数:随机设置网络参数。

-

前向传播:计算网络输出。

-

计算损失:评估输出与真实值的差异。

-

误差反向传播:计算损失函数对每个参数的梯度。

-

参数更新:使用梯度下降法更新参数。

-

迭代:重复上述步骤,直到损失函数收敛。

区别

-

误差反向传播:仅指计算梯度的过程。

-

BP算法:包含误差反向传播在内的完整训练流程。

总结

误差反向传播是BP算法的一部分,负责梯度计算,而BP算法则涵盖了从初始化到参数更新的整个训练过程。

推理的具体含义

-

输入数据:将新的数据(如图像、文本、音频等)输入到训练好的模型中。

-

前向计算:模型根据学习到的参数(如权重和偏置)对输入数据进行计算,生成输出。

-

输出结果:输出可以是分类标签、回归值、概率分布等,具体取决于任务类型。

推理的典型应用场景

-

图像分类:输入一张图片,模型输出其所属类别(如猫、狗)。

-

目标检测:输入一张图片,模型输出图中物体的位置和类别。

-

自然语言处理:输入一段文本,模型输出翻译结果、情感分析或文本生成。

-

语音识别:输入一段音频,模型输出对应的文字。

-

推荐系统:输入用户行为数据,模型输出推荐内容。

推理与训练的区别

| 阶段 | 训练(Training) | 推理(Inference) |

|---|---|---|

| 目的 | 学习模型参数 | 使用模型进行预测 |

| 数据 | 使用带标签的训练数据 | 使用新的、未见过的数据 |

| 计算 | 需要反向传播和优化 | 仅需前向计算 |

| 资源 | 计算量大,耗时长 | 计算量小,实时性高 |

推理的优化

在实际应用中,推理的效率至关重要,尤其是在实时场景(如自动驾驶、语音助手)中。常见的推理优化方法包括:

-

模型压缩:通过剪枝、量化、蒸馏等技术减少模型大小和计算量。

-

硬件加速:使用GPU、TPU或专用AI芯片(如NVIDIA TensorRT、Google Edge TPU)加速推理。

-

批处理:同时对多个输入数据进行推理,提高吞吐量。

-

模型转换:将模型转换为更高效的格式(如ONNX、TensorFlow Lite)。

总结

推理是模型从训练到实际应用的核心步骤,通过前向计算对新数据进行预测。与训练不同,推理更注重效率和实时性,通常需要针对具体场景进行优化。

在网络中,**归一化(Normalization)**是一种对数据进行标准化处理的技术,目的是将数据调整到特定的范围或分布,以改善模型的训练效果和稳定性。归一化通常作用于网络的输入数据或中间层的激活值。

归一化的目标

-

加速收敛:通过将数据调整到合适的范围,减少训练过程中的梯度消失或爆炸问题,加快模型收敛。

-

提高稳定性:使数据分布更加一致,避免某些特征或激活值对模型训练产生过大的影响。

-

改善泛化能力:通过规范化数据分布,提高模型在测试数据上的表现。

归一化的对象

在网络中,归一化可以应用于以下两种主要对象:

归一化的作用

-

缓解梯度问题:通过调整数据分布,避免梯度消失或爆炸。

-

减少对初始化的依赖:归一化可以使网络对参数初始化不那么敏感。

-

允许更高的学习率:归一化后的数据分布更稳定,可以使用更大的学习率加速训练。

-

正则化效果:某些归一化方法(如Batch Normalization)在训练时引入了噪声,具有一定的正则化效果。

归一化的选择

-

输入数据归一化:通常使用Min-Max或Z-score方法。

-

中间层归一化:

-

Batch Normalization:适用于批量较大的场景(如图像分类)。

-

Layer Normalization:适用于序列数据(如自然语言处理)。

-

Instance Normalization:适用于图像生成任务。

-

Group Normalization:适用于小批量或动态批量场景。

-

总结

归一化是将数据调整到特定范围或分布的技术,主要应用于输入数据或中间层的激活值。它可以加速训练、提高稳定性,并改善模型的泛化能力。具体选择哪种归一化方法,取决于任务类型和数据特点。

**正则化(Regularization)**是机器学习和深度学习中用于防止模型过拟合(Overfitting)的技术。它的主要作用是通过对模型的复杂性进行约束,使模型在训练数据上表现良好的同时,也能在未见过的测试数据上保持较好的泛化能力。

正则化的作用对象

正则化主要作用于模型的参数或损失函数,具体包括:

-

模型参数(如权重):

-

通过对参数施加约束,限制模型的复杂性。

-

例如,L1正则化和L2正则化直接作用于权重。

-

-

损失函数:

-

在损失函数中加入正则化项,惩罚模型的复杂性。

-

例如,L2正则化将权重的平方和添加到损失函数中。

-

6.数据增强(Data Augmentation)

-

通过对训练数据进行变换(如旋转、缩放、翻转等)增加数据多样性。

-

作用:

-

间接正则化模型,提高泛化能力。

-

正则化的作用

-

防止过拟合:

-

通过限制模型的复杂性,避免模型过度拟合训练数据中的噪声或细节。

-

-

提高泛化能力:

-

使模型在训练集和测试集上都能表现良好。

-

-

控制模型复杂度:

-

通过惩罚较大的权重,使模型更加简单和稳定。

-

-

特征选择:

-

例如,L1正则化可以使不重要的特征权重变为0,从而实现特征选择。

-

正则化的超参数

正则化方法通常涉及超参数(如λλ),用于控制正则化的强度:

-

λλ较大:正则化效果强,模型更简单,但可能欠拟合。

-

λλ较小:正则化效果弱,模型可能过拟合。

总结

正则化是通过对模型参数或损失函数施加约束,防止模型过拟合的技术。常见的正则化方法包括L1、L2、Dropout、早停等。正则化的核心目标是提高模型的泛化能力,使其在未见过的数据上也能表现良好。

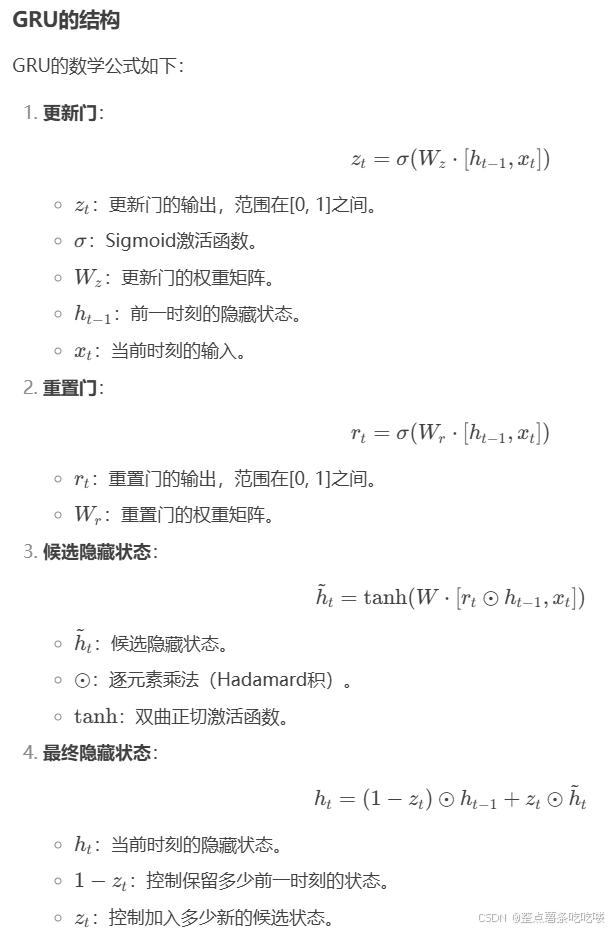

**GRU(Gated Recurrent Unit,门控循环单元)**是一种改进的循环神经网络(RNN)结构,专门设计用于处理序列数据(如时间序列、文本、语音等)。GRU通过引入门控机制,解决了传统RNN在长序列训练中容易出现的梯度消失或梯度爆炸问题,同时比LSTM(长短期记忆网络)更简单高效。

GRU的核心思想

GRU通过两个门控机制(更新门和重置门)来控制信息的流动,从而有效地捕捉序列中的长期依赖关系。

-

更新门(Update Gate):

-

决定当前时刻的状态有多少来自前一时刻的状态,有多少来自新的候选状态。

-

作用:帮助模型记住长期信息。

-

-

重置门(Reset Gate):

-

决定是否忽略前一时刻的状态,从而更好地捕捉短期依赖关系。

-

作用:帮助模型忘记不相关的信息。

-

GRU的优点

-

解决梯度问题:

-

通过门控机制,GRU能够有效地捕捉长期依赖关系,缓解梯度消失或爆炸问题。

-

-

计算效率高:

-

相比LSTM,GRU只有两个门控机制,参数更少,计算速度更快。

-

-

性能优异:

-

在许多任务(如文本生成、机器翻译、语音识别)中,GRU的表现与LSTM相当,甚至更好。

-

GRU vs LSTM

| 特性 | GRU | LSTM |

|---|---|---|

| 门控机制 | 更新门、重置门 | 输入门、遗忘门、输出门 |

| 参数数量 | 较少 | 较多 |

| 计算复杂度 | 较低 | 较高 |

| 训练速度 | 较快 | 较慢 |

| 适用场景 | 短序列或中等长度序列 | 长序列或复杂依赖关系 |

GRU的应用场景

-

自然语言处理(NLP):

-

文本生成、机器翻译、情感分析等。

-

-

时间序列预测:

-

股票价格预测、天气预测等。

-

-

语音处理:

-

语音识别、语音合成等。

-

-

推荐系统:

-

基于用户行为序列的推荐。

-

总结

GRU是一种高效的门控循环神经网络,通过更新门和重置门控制信息流动,解决了传统RNN的梯度问题。它在处理序列数据时表现出色,且计算效率高于LSTM。GRU广泛应用于自然语言处理、时间序列预测和语音处理等领域。

**DDPM(Denoising Diffusion Probabilistic Models,去噪扩散概率模型)**是一种基于扩散过程的生成模型,用于生成高质量的数据(如图像、音频等)。DDPM通过模拟数据从噪声到真实样本的逐步去噪过程,实现了强大的生成能力。它在图像生成任务中表现尤为突出,能够生成细节丰富、逼真的图像。

DDPM的核心思想

DDPM的灵感来源于物理学中的扩散过程,其核心思想是通过以下两个步骤生成数据:

-

前向过程(扩散过程):

-

逐步向真实数据添加噪声,最终将数据转化为纯噪声。

-

-

反向过程(去噪过程):

-

从纯噪声开始,逐步去噪,最终生成真实数据。

-

DDPM的特点

-

高质量的生成能力:

-

DDPM能够生成细节丰富、逼真的图像,尤其在图像生成任务中表现优异。

-

-

稳定的训练过程:

-

由于扩散过程的逐步性,DDPM的训练相对稳定,不易出现模式崩溃(Mode Collapse)问题。

-

-

灵活的噪声调度:

-

通过调整噪声调度参数βtβt,可以控制生成过程的速度和质量。

-

-

可解释性强:

-

扩散过程具有清晰的物理意义,生成过程易于理解和解释。

-

DDPM的改进与变体

-

DDIM(Denoising Diffusion Implicit Models):通过非马尔可夫链的扩散过程加速生成,减少生成步骤。

-

Score-Based Generative Models:基于分数匹配的生成模型,与DDPM有密切联系。

-

Conditional DDPM:在DDPM中引入条件信息(如类别标签、文本描述),实现条件生成。

DDPM的应用场景

-

图像生成:生成高质量的逼真图像。

-

图像修复:对缺失或损坏的图像进行修复。

-

超分辨率:将低分辨率图像转换为高分辨率图像。

-

音频生成:生成高质量的语音或音乐。

-

数据增强:生成合成数据以增强训练集。

总结

DDPM是一种基于扩散过程的生成模型,通过逐步去噪生成高质量的数据。它在图像生成任务中表现优异,具有稳定的训练过程和灵活的噪声调度能力。DDPM及其变体(如DDIM)在生成模型领域具有重要的研究和应用价值。

KL散度(Kullback-Leibler Divergence,Kullback-Leibler散度),也称为相对熵(Relative Entropy),是衡量两个概率分布之间差异的一种方法。它主要用于信息论、统计学和机器学习中,用来量化一个概率分布与另一个概率分布的不同程度。

KL散度的直观意义

KL散度衡量的是用分布QQ来近似分布PP时,信息损失的量。具体来说:

-

如果PP和QQ完全相同,KL散度为0。

-

如果PP和QQ差异越大,KL散度越大。

KL散度的应用

-

机器学习中的损失函数:

-

在生成模型(如变分自编码器VAE)中,KL散度用于衡量生成分布与目标分布之间的差异。

-

在强化学习中,KL散度用于策略优化(如TRPO、PPO算法)。

-

-

信息论:用于衡量两个概率分布之间的信息差异。

-

模型选择:在贝叶斯推断中,KL散度用于比较不同模型的拟合效果。

-

数据压缩:用于衡量编码效率的损失。

总结

KL散度是衡量两个概率分布之间差异的重要工具,广泛应用于机器学习、信息论和统计学中。它具有非负性和不对称性,常用于模型优化、分布比较和信息损失量化。尽管KL散度不是严格的距离度量,但它在许多场景中具有重要的理论和实践意义。

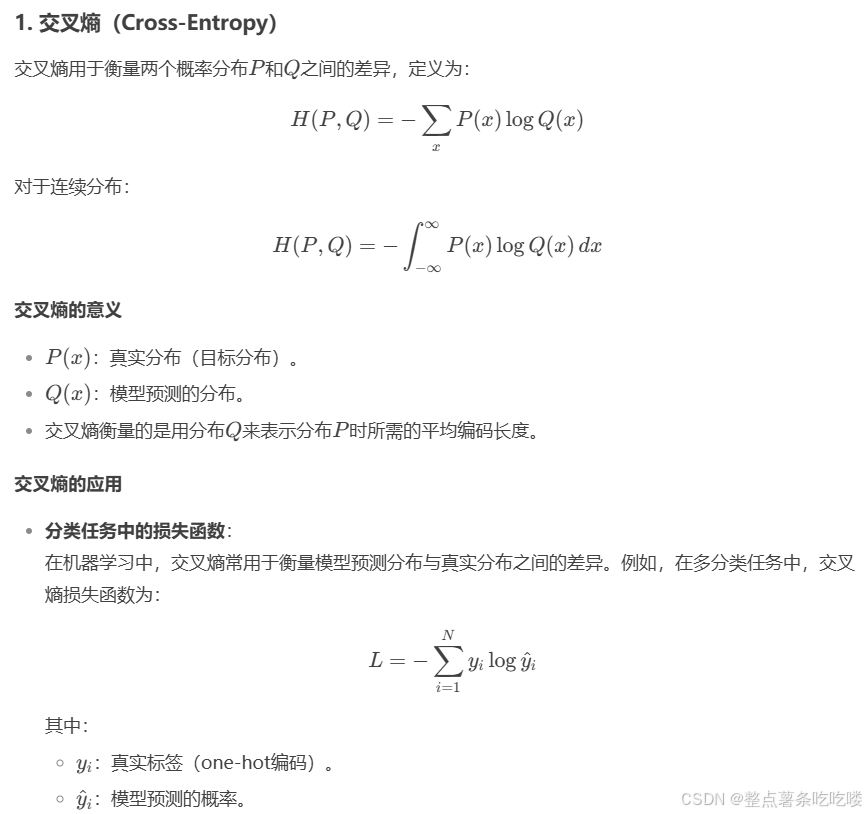

**交叉熵(Cross-Entropy)和相对熵(Relative Entropy,即KL散度)**是信息论和机器学习中两个密切相关的概念,用于衡量概率分布之间的差异。它们之间有着紧密的数学联系,但在应用场景和意义上有一些区别。

**注意力机制(Attention Mechanism)**是一种用于增强神经网络处理序列数据能力的技术,最初在机器翻译任务中提出,现已成为深度学习中的重要组成部分。它的核心思想是让模型在处理输入数据时,能够动态地关注与当前任务最相关的部分,从而提高模型的性能。

注意力机制的核心思想

-

动态权重分配:传统的序列模型(如RNN)对所有输入赋予相同的权重,而注意力机制能够根据任务需求动态分配权重。

-

关注重要信息:通过计算输入数据的重要性分数(Attention Score),模型可以聚焦于与当前任务最相关的部分,忽略不相关的信息。

注意力机制的基本结构

注意力机制通常包括以下三个部分:

-

查询(Query):表示当前任务需要关注的内容。

-

键(Key):表示输入数据的特征。

-

值(Value):表示输入数据的具体信息。

计算步骤

-

计算注意力分数(Attention Score):

-

通过查询(Query)和键(Key)的相似性计算每个输入的重要性分数。

-

常用的相似性计算方法包括点积、加性注意力等。

-

-

计算注意力权重(Attention Weight):对注意力分数进行Softmax归一化,得到权重分布。

-

加权求和:使用注意力权重对值(Value)进行加权求和,得到最终的输出。

注意力机制的类型

-

加性注意力(Additive Attention):通过一个全连接网络计算查询和键的相似性。

-

点积注意力(Dot-Product Attention):通过点积计算查询和键的相似性。

-

缩放点积注意力(Scaled Dot-Product Attention):在点积注意力的基础上,引入缩放因子dkdk,防止点积过大导致梯度消失。

-

自注意力(Self-Attention):查询、键和值都来自同一输入序列,用于捕捉序列内部的依赖关系。

-

多头注意力(Multi-Head Attention):使用多个注意力头并行计算,捕捉不同子空间的特征。

注意力机制的应用

-

机器翻译:在Transformer模型中,注意力机制用于捕捉源语言和目标语言之间的对齐关系。

-

文本生成:在生成任务中,注意力机制用于动态关注输入序列的不同部分。

-

图像处理:图像分类、目标检测等任务中,注意力机制用于聚焦于图像的关键区域。

-

语音识别:在语音任务中,注意力机制用于对齐音频和文本。

注意力机制的优点

-

捕捉长距离依赖:注意力机制能够直接捕捉序列中任意两个位置的关系,解决了传统RNN的长距离依赖问题。

-

并行计算:与RNN不同,注意力机制的计算可以并行化,提高训练效率。

-

可解释性强:注意力权重可以直观地显示模型关注的内容,增强模型的可解释性。

注意力机制的经典模型

-

Transformer:完全基于注意力机制的模型,广泛应用于自然语言处理任务。

-

BERT:基于Transformer的双向编码模型,使用自注意力机制捕捉上下文信息。

-

GPT:基于Transformer的生成模型,使用自注意力机制进行文本生成。

总结

注意力机制通过动态分配权重,使模型能够聚焦于输入数据的重要部分,从而提升性能。它在机器翻译、文本生成、图像处理等任务中表现出色,并成为Transformer等现代深度学习模型的核心组件。注意力机制的优势在于其并行计算能力、长距离依赖捕捉能力以及可解释性。

自注意力(Self-Attention),也称为内部注意力(Intra-Attention),是注意力机制的一种特殊形式。它的核心特点是:查询(Query)、键(Key)和值(Value)都来自同一输入序列。自注意力机制通过计算序列中每个元素与其他元素之间的关系,捕捉序列内部的依赖结构,从而更好地理解上下文信息。

自注意力机制是Transformer模型的核心组件,广泛应用于自然语言处理(NLP)、计算机视觉(CV)等领域。

自注意力的核心思想

-

捕捉序列内部关系:自注意力机制通过计算序列中每个元素与其他元素之间的相关性,捕捉序列内部的依赖关系。

-

动态权重分配:根据元素之间的相关性,动态分配注意力权重,从而聚焦于重要的信息。

自注意力的优点

-

捕捉长距离依赖:自注意力机制能够直接计算序列中任意两个元素之间的关系,解决了传统RNN的长距离依赖问题。

-

并行计算:自注意力的计算可以并行化,提高训练效率。

-

可解释性强:注意力权重可以直观地显示序列中元素之间的关系,增强模型的可解释性。

自注意力的应用

-

自然语言处理(NLP):在Transformer、BERT、GPT等模型中,自注意力用于捕捉文本中的上下文关系。

-

计算机视觉(CV):在Vision Transformer(ViT)等模型中,自注意力用于捕捉图像中不同区域之间的关系。

-

语音处理:在语音识别、语音合成等任务中,自注意力用于捕捉音频序列中的依赖关系。

自注意力 vs 传统注意力

| 特性 | 自注意力 | 传统注意力 |

|---|---|---|

| 输入来源 | 查询、键、值来自同一输入序列 | 查询、键、值可以来自不同输入 |

| 应用场景 | 捕捉序列内部关系(如文本、图像) | 捕捉序列间关系(如机器翻译) |

| 计算复杂度 | 较高(需计算序列内所有元素关系) | 较低 |

总结

自注意力机制通过计算序列内部元素之间的关系,动态分配注意力权重,从而捕捉序列的上下文信息。它是Transformer模型的核心组件,广泛应用于自然语言处理、计算机视觉等领域。自注意力的优点在于其并行计算能力、长距离依赖捕捉能力以及可解释性。

Seq2Seq(Sequence-to-Sequence)模型详解

Seq2Seq(序列到序列) 是一种深度学习模型,用于处理输入和输出均为变长序列的任务,如机器翻译、文本摘要、对话系统等。其核心思想是通过编码器(Encoder) 将输入序列编码为固定长度的上下文向量(Context Vector),再由解码器(Decoder) 逐步生成输出序列。

1. Seq2Seq 的基本结构

Seq2Seq 模型通常由两部分组成:

-

编码器(Encoder):将输入序列(如句子)编码为一个固定长度的上下文向量(Context Vector),通常使用 RNN(LSTM/GRU) 或 Transformer 结构。

-

解码器(Decoder):基于上下文向量,逐步生成输出序列(如翻译后的句子),通常也使用 RNN 或 Transformer。

4. Seq2Seq 的应用场景

| 任务 | 输入 | 输出 | 典型模型 |

|---|---|---|---|

| 机器翻译 | 源语言句子 | 目标语言句子 | Transformer (Google NMT) |

| 文本摘要 | 长文章 | 摘要句子 | BART, PEGASUS |

| 对话系统 | 用户输入 | 机器人回复 | GPT, DialoGPT |

| 语音识别 | 音频信号 | 文本转录 | Listen-Attend-Spell |

| 代码生成 | 自然语言描述 | 编程代码 | Codex, GitHub Copilot |

5. Seq2Seq 的优缺点

✅ 优点

-

适用于变长输入和输出。

-

结合 Attention 后,能有效处理长序列。

-

Transformer 版本具有更强的并行计算能力。

❌ 缺点

-

传统 RNN 版本训练慢(无法并行)。

-

解码时可能出现曝光偏差(Exposure Bias)(训练用真实标签,推理用预测值)。

-

长序列生成时可能遗忘早期信息(除非用 Attention)。

import torch

import torch.nn as nn

# 编码器

class Encoder(nn.Module):

def __init__(self, input_dim, emb_dim, hidden_dim):

super().__init__()

self.embedding = nn.Embedding(input_dim, emb_dim)

self.rnn = nn.GRU(emb_dim, hidden_dim)

def forward(self, x):

embedded = self.embedding(x)

outputs, hidden = self.rnn(embedded)

return hidden

# 解码器

class Decoder(nn.Module):

def __init__(self, output_dim, emb_dim, hidden_dim):

super().__init__()

self.embedding = nn.Embedding(output_dim, emb_dim)

self.rnn = nn.GRU(emb_dim + hidden_dim, hidden_dim)

self.fc = nn.Linear(hidden_dim, output_dim)

def forward(self, x, hidden, context):

embedded = self.embedding(x)

combined = torch.cat((embedded, context), dim=2)

output, hidden = self.rnn(combined, hidden)

prediction = self.fc(output)

return prediction, hidden

# Seq2Seq 模型

class Seq2Seq(nn.Module):

def __init__(self, encoder, decoder):

super().__init__()

self.encoder = encoder

self.decoder = decoder

def forward(self, src, trg):

hidden = self.encoder(src)

outputs = []

for t in range(trg.size(0)):

output, hidden = self.decoder(trg[t], hidden)

outputs.append(output)

return torch.stack(outputs)7. 总结

-

Seq2Seq 是一种处理变长序列的经典模型,广泛应用于 NLP 任务。

-

传统 RNN 版本 依赖编码器-解码器结构,但存在信息瓶颈问题。

-

Attention 机制 显著提升长序列建模能力。

-

Transformer 彻底取代 RNN,成为现代 Seq2Seq 的主流架构(如 BERT、GPT)。

-

应用场景:机器翻译、文本摘要、对话系统、语音识别等。

交叉注意力(Cross-Attention)详解

交叉注意力(Cross-Attention)是注意力机制的一种重要变体,主要用于处理两个不同序列之间的关系,例如在机器翻译中让目标语言的每个词关注源语言的相关部分。它是Transformer架构中编码器-解码器交互的核心机制,也是现代多模态模型(如文本-图像生成)的关键组件。

1. 核心思想

-

目标:让一个序列(Query序列)动态关注另一个序列(Key-Value序列)的信息。

-

典型应用场景:

-

机器翻译:解码器(生成目标语言)关注编码器(源语言)的隐藏状态。

-

多模态任务:文本查询(Query)关注图像特征(Key-Value)。

-

推荐系统:用户行为序列(Query)关注商品特征(Key-Value)。

-

3. 交叉注意力 vs 自注意力

| 特性 | 交叉注意力(Cross-Attention) | 自注意力(Self-Attention) |

|---|---|---|

| 输入来源 | Query来自序列A,Key-Value来自序列B | Query、Key、Value均来自同一序列 |

| 应用场景 | 编码器-解码器交互、多模态融合 | 序列内部关系建模(如文本上下文) |

| 计算目标 | 捕捉跨序列的依赖关系 | 捕捉序列内部的依赖关系 |

| 典型模型 | Transformer解码器、DETR(目标检测) | BERT、GPT |

4. 在Transformer中的应用

以机器翻译为例,Transformer的解码器层包含两种注意力:

-

自注意力:解码器关注已生成的部分(防止未来信息泄露,需Masked)。

-

交叉注意力:解码器关注编码器的输出(源语言信息)。

import torch

import torch.nn as nn

import torch.nn.functional as F

class CrossAttention(nn.Module):

def __init__(self, d_model, d_k, d_v):

super().__init__()

self.W_q = nn.Linear(d_model, d_k) # Query投影

self.W_k = nn.Linear(d_model, d_k) # Key投影

self.W_v = nn.Linear(d_model, d_v) # Value投影

def forward(self, query, key_value):

# query: [batch_size, n, d_model]

# key_value: [batch_size, m, d_model]

Q = self.W_q(query) # [batch_size, n, d_k]

K = self.W_k(key_value) # [batch_size, m, d_k]

V = self.W_v(key_value) # [batch_size, m, d_v]

# 计算注意力分数

scores = torch.matmul(Q, K.transpose(-2, -1)) / torch.sqrt(torch.tensor(K.size(-1)))

alpha = F.softmax(scores, dim=-1) # [batch_size, n, m]

# 加权求和

output = torch.matmul(alpha, V) # [batch_size, n, d_v]

return output

# 示例用法

d_model, d_k, d_v = 512, 64, 64

cross_attn = CrossAttention(d_model, d_k, d_v)

query = torch.randn(2, 10, d_model) # 解码器状态(目标语言)

key_value = torch.randn(2, 20, d_model) # 编码器输出(源语言)

output = cross_attn(query, key_value) # [2, 10, d_v]6. 实际应用案例

(1) 机器翻译(Transformer)

-

编码器:将源语言(如英语)编码为隐藏状态。

-

解码器:通过交叉注意力动态关注源语言的相关词,生成目标语言(如中文)。

(2) 多模态模型(CLIP、Flamingo)

-

文本Query:关注图像/视频的Key-Value特征,实现图文对齐。

(3) 目标检测(DETR)

-

物体查询(Query):关注图像特征(Key-Value),直接预测物体类别和位置。

7. 关键问题与改进

(1) 计算复杂度

-

交叉注意力的计算复杂度为 O(n×m)O(n×m)(n和m是两个序列的长度)。

-

改进方案:

-

稀疏注意力:只计算部分位置的分数(如Longformer)。

-

低秩近似:用矩阵分解降低计算量(如Linformer)。

-

(2) 信息融合效率

-

若两个序列差异过大(如文本和图像),直接交叉注意力可能效果不佳。

-

改进方案:

-

跨模态对齐预训练(如CLIP)。

-

层次化注意力:先分别建模序列内部关系,再交叉。

-

8. 总结

-

交叉注意力是处理跨序列依赖关系的核心机制,广泛用于Transformer、多模态模型等。

-

与自注意力的区别:Query和Key-Value来自不同序列。

-

应用场景:机器翻译、图文生成、视频理解、推荐系统等。

迁移学习(Transfer Learning)详解

迁移学习是一种机器学习方法,其核心思想是将已训练好的模型(预训练模型)的知识迁移到新任务中,从而显著减少新任务对数据和计算资源的需求,并提升模型性能。它是现代深度学习中最重要的技术之一,尤其在计算机视觉(CV)、自然语言处理(NLP)等领域广泛应用。

1. 核心思想

-

核心目标:利用源领域(Source Domain)学到的知识,帮助目标领域(Target Domain)的任务。

-

关键假设:不同任务或领域之间存在共享的底层特征(如边缘、纹理、语义等)。

-

典型场景:

-

用ImageNet预训练的模型初始化医学图像分类模型。

-

用BERT预训练的语言模型完成文本情感分析。

-

2. 迁移学习的分类

根据源任务和目标任务的关系,迁移学习可分为以下几类:

| 类型 | 描述 | 示例 |

|---|---|---|

| 领域自适应(Domain Adaptation) | 源领域和目标领域任务相同,但数据分布不同(如真实照片→卡通画分类) | 用真实图像训练的模型适配漫画图像分类 |

| 任务自适应(Task Adaptation) | 源任务和目标任务不同,但数据相似(如用图像分类模型初始化目标检测模型) | ResNet用于医学影像分割 |

| 多任务学习(Multi-Task Learning) | 同时学习多个相关任务,共享部分模型参数 | 同一模型完成文本分类和命名实体识别 |

3. 迁移学习的常见方法

(1) 基于模型的迁移(Model-based Transfer)

-

方法:直接复用预训练模型的部分或全部结构。

-

特征提取器:冻结预训练模型的底层,仅训练顶层新层(适用于目标数据较少)。

-

微调(Fine-tuning):解冻部分或全部层,用目标数据微调(适用于数据较多)。

-

-

示例:

-

用VGG16的卷积层提取图像特征,仅训练新的全连接层。

-

用BERT的Transformer层初始化文本分类模型。

-

(2) 基于特征的迁移(Feature-based Transfer)

-

方法:将预训练模型的中间层输出作为新任务的输入特征。

-

适用于不支持端到端微调的场景(如传统机器学习模型)。

-

-

示例:用ResNet提取图像特征,输入SVM分类器。

(3) 对抗迁移学习(Adversarial Transfer)

-

方法:通过对抗训练(如GAN、Domain Adversarial Neural Network)减少领域差异。

-

适用于源领域和目标领域分布差异大的情况。

-

-

示例:在自动驾驶中,将游戏场景生成的数据适配到真实场景。

4. 经典预训练模型

(1) 计算机视觉(CV)

| 模型 | 预训练数据 | 典型任务 |

|---|---|---|

| VGG16/19 | ImageNet | 图像分类、特征提取 |

| ResNet50 | ImageNet | 目标检测、分割 |

| EfficientNet | ImageNet | 轻量化图像分类 |

| CLIP | 图文对 | 跨模态检索、零样本分类 |

(2) 自然语言处理(NLP)

| 模型 | 预训练数据 | 典型任务 |

|---|---|---|

| BERT | 英文/中文维基百科 | 文本分类、问答系统 |

| GPT-3 | 大规模互联网文本 | 文本生成、代码补全 |

| T5 | 多任务文本数据 | 文本摘要、翻译 |

5. 迁移学习的优势

-

降低数据需求:小数据即可训练高性能模型。

-

减少计算成本:无需从头训练,节省时间和算力。

-

提升泛化能力:预训练模型已学习通用特征,避免过拟合。

-

跨领域适配:支持不同但相关的任务迁移(如自然图像→医学图像)。

6. 实际应用案例

(1) 图像分类(PyTorch示例)

import torch

import torchvision.models as models

# 加载预训练ResNet(冻结底层)

model = models.resnet50(pretrained=True)

for param in model.parameters(): # 冻结所有层

param.requires_grad = False

# 替换最后一层(适配新任务)

model.fc = torch.nn.Linear(2048, 10) # 假设新任务有10类

# 仅训练最后一层

optimizer = torch.optim.Adam(model.fc.parameters(), lr=1e-3)7. 关键挑战与解决方案

| 挑战 | 解决方案 |

|---|---|

| 领域差异大 | 使用对抗训练(DANN)、领域自适应(MMD损失) |

| 目标任务数据少 | 冻结大部分层,仅微调顶层;使用数据增强 |

| 负迁移(Negative Transfer) | 选择相关性强的源任务;采用渐进式微调(如Layer-wise Learning Rate Decay) |

8. 总结

-

迁移学习的本质:利用已有知识解决新问题,是深度学习的“捷径”。

-

核心方法:模型复用、特征提取、微调、对抗训练。

-

适用场景:数据少、计算资源有限、跨领域任务。

-

典型模型:ResNet(CV)、BERT(NLP)、CLIP(多模态)。

归纳偏置(Inductive Bias)详解

归纳偏置是机器学习模型为从有限数据中泛化到未知数据而内置的假设或偏好。它决定了模型如何对未见过的输入做出预测,是模型设计中的核心概念,直接影响学习效率和泛化能力。

1. 核心概念

-

定义:模型为引导学习过程而隐含或显式引入的假设集合。

-

作用:缩小假设空间,避免“无免费午餐定理”描述的绝对泛化失败。

-

类比:像“解题技巧”——没有通用解法时,特定方法对特定问题更有效。

2. 常见归纳偏置类型

(1) 模型架构偏置

| 模型 | 归纳偏置 | 示例应用 |

|---|---|---|

| 卷积神经网络 (CNN) | 平移不变性、局部性 | 图像分类、目标检测 |

| 循环神经网络 (RNN) | 序列依赖性、时间连续性 | 语音识别、时间序列预测 |

| 图神经网络 (GNN) | 拓扑结构重要性 | 社交网络分析、分子建模 |

| 自注意力模型 | 全局依赖关系、位置无关性 | 机器翻译、文本生成 |

(2) 正则化偏置

-

L2正则化:偏好小权重(奥卡姆剃刀原则)

-

Dropout:假设多个稀疏子网络组合更鲁棒

-

早停 (Early Stopping):防止复杂度过拟合

(3) 优化偏置

-

梯度下降:偏好平坦的损失曲面最小值(与SGD噪声相关)

-

动量 (Momentum):假设参数更新方向具有惯性

3. 归纳偏置的作用

-

加速学习:缩小假设空间,更快找到有效解。

-

示例:CNN的局部连接性让图像特征学习效率远超全连接网络。

-

-

提升泛化:防止记忆噪声,关注数据本质规律。

-

示例:Transformer的位置编码使模型能处理可变长度序列。

-

-

领域适配:编码先验知识(如物理规律)。

-

示例:在蛋白质结构预测中引入几何约束。

-

4. 经典案例分析

(1) CNN vs 全连接网络

-

任务:图像分类

-

CNN偏置:

-

局部性:通过卷积核捕捉局部模式(如边缘、纹理)

-

平移不变性:同一特征在不同位置共享权重

-

-

效果:参数效率提升100倍以上,准确率更高。

(2) BERT的位置编码

-

偏置:绝对位置信息通过正弦函数编码

-

对比RNN:无需逐步处理序列,支持并行计算

-

结果:长文本建模能力显著增强

5. 如何设计好的归纳偏置

-

领域知识融合:

-

视觉任务→CNN的局部性

-

时序任务→RNN的马尔可夫性

-

-

平衡灵活性与约束:

-

过强偏置:模型僵化(如线性模型无法拟合非线性数据)

-

过弱偏置:需要海量数据(如GPT-3依赖1750亿参数)

-

-

可学习偏置:

-

现代方法(如神经架构搜索)让模型自动发现最优偏置

-

6. 归纳偏置的局限性

-

错误偏置导致失败:

-

假设数据符合高斯分布,但实际是长尾分布→模型偏差

-

-

与数据冲突:

-

使用RNN处理非时序图数据→性能低下

-

-

新兴解决方案:

-

元学习(Learning to Learn):让模型学会调整自身偏置

-

因果推断:区分相关性与因果性

-

7. 代码示例:CNN的归纳偏置体现

import torch.nn as nn

# 全连接网络(无归纳偏置)

class MLP(nn.Module):

def __init__(self):

super().__init__()

self.fc = nn.Linear(784, 10) # 784像素→10类别

# CNN(内置平移不变性和局部性)

class CNN(nn.Module):

def __init__(self):

super().__init__()

self.conv = nn.Conv2d(1, 32, kernel_size=3) # 局部3x3卷积

self.pool = nn.MaxPool2d(2) # 平移不变的下采样

self.fc = nn.Linear(32*13*13, 10) # 最终分类层

# 实验对比:在MNIST上CNN用更少参数达到更高准确率8. 总结

-

核心价值:归纳偏置是模型解决“从有限数据泛化”难题的关键。

-

设计原则:匹配任务特性(如CNN对图像,RNN对时序)。

-

趋势:从人工设计(如CNN)→ 自动学习(如Transformer的注意力机制)。

-

警示:错误的偏置比没有偏置更危险——需通过实验验证假设合理性。

将 CNN(卷积神经网络) 和 ViT(Vision Transformer) 结合,是为了 融合两者的优势,弥补单一架构的局限性。这种混合模型在计算机视觉任务中表现出更强的性能、更高的效率或更好的泛化能力。以下是详细的解释:

1. CNN 和 ViT 的互补性

(1) CNN 的优势与局限

-

优势:

-

局部性(Locality):卷积核天然捕捉局部特征(如边缘、纹理),适合图像的底层结构。

-

平移等变性(Translation Equivariance):卷积操作对平移变化具有鲁棒性。

-

参数效率高:权重共享减少参数量。

-

-

局限:

-

长距离依赖弱:大感受野需堆叠多层卷积,难以建模全局关系。

-

刚性结构:固定尺寸的卷积核可能不适应多尺度目标。

-

(2) ViT 的优势与局限

-

优势:

-

全局建模能力:自注意力机制直接捕捉图像任意区域的关系。

-

灵活性:可处理可变分辨率输入(需调整位置编码)。

-

-

局限:

-

数据需求大:纯ViT需海量数据(如JFT-300M)才能达到CNN的同等效果。

-

计算开销高:自注意力复杂度随序列长度平方增长(O(n2)O(n2))。

-

缺乏局部先验:需从头学习局部模式,效率低于CNN。

-

2. 结合方式与典型方法

(1) 混合架构(Hybrid Architecture)

方法:用CNN提取局部特征,再输入ViT进行全局建模。

代表模型:

-

ConViT:在ViT中引入“门控卷积”替代部分注意力头。

-

CvT(Convolutional vision Transformer):用卷积嵌入代替ViT的线性投影。

-

BoTNet:在ResNet最后阶段用自注意力替换空间卷积。

结构示例:输入图像 → CNN骨干(如ResNet) → 特征图 → 展平为序列 → ViT编码 → 分类头

(2) 局部-全局分阶段处理

方法:低层用CNN处理局部细节,高层用ViT建模全局关系。

优点:

-

早期卷积减少计算量(下采样后序列更短)。

-

保留ViT的全局交互能力。

案例:

-

CMT(Convolutional Meet Transformer):CNN和ViT交替堆叠。

-

CoAtNet:将卷积和注意力合并到单个算子中。

(3) 注意力增强卷积

方法:在CNN中嵌入注意力模块,引入全局感知。

代表工作:

-

CBAM(Convolutional Block Attention Module):空间+通道注意力。

-

Squeeze-and-Excitation Networks(SENet):通道注意力。

3. 结合后的优势

-

数据效率提升:CNN的局部先验减少ViT对小数据的依赖(如用ImageNet预训练混合模型)。

-

计算效率优化:先用CNN降维(如将224x224图像→14x14特征图),再输入ViT,降低自注意力计算量。

-

多尺度特征融合:CNN提取多尺度局部特征,ViT建模全局关系,适合复杂场景(如目标检测)。

-

鲁棒性增强:CNN对局部变形鲁棒,ViT对全局结构敏感,两者互补提升泛化能力。

4. 典型应用场景

| 任务 | 模型示例 | 结合方式 |

|---|---|---|

| 图像分类 | CMT, CoAtNet | CNN+ViT分阶段处理 |

| 目标检测 | DETR with CNN backbone | CNN提取特征,ViT解码检测框 |

| 医学图像分割 | TransUNet | CNN编码局部特征,ViT建模长距离依赖 |

| 视频理解 | TimeSformer + 3D CNN | CNN捕捉时空局部性,ViT建模帧间关系 |

5. 代码示例(PyTorch)

import torch

import torch.nn as nn

from torchvision.models import resnet50

from transformers import ViTModel

# 1. 用CNN(ResNet)提取特征

class CNNBackbone(nn.Module):

def __init__(self):

super().__init__()

self.cnn = resnet50(pretrained=True)

self.cnn.fc = nn.Identity() # 移除原始分类头

def forward(self, x):

return self.cnn(x) # 输出特征图 [B, 2048, H/32, W/32]

# 2. 将特征图输入ViT

class HybridModel(nn.Module):

def __init__(self):

super().__init__()

self.cnn = CNNBackbone()

self.vit = ViTModel.from_pretrained("google/vit-base-patch16-224")

self.classifier = nn.Linear(768, 10) # 假设10分类

def forward(self, x):

cnn_features = self.cnn(x) # [B, 2048, 7, 7]

B, C, H, W = cnn_features.shape

patches = cnn_features.flatten(2).transpose(1, 2) # [B, 49, 2048]

vit_outputs = self.vit(inputs_embeds=patches)

logits = self.classifier(vit_outputs.last_hidden_state[:, 0, :])

return logits

# 使用示例

model = HybridModel()

x = torch.randn(2, 3, 224, 224) # 输入图像

y = model(x) # 输出预测 [2, 10]6. 总结

-

为什么结合:CNN的局部先验与ViT的全局建模能力互补,实现更高性能、更低计算成本。

-

如何结合:分阶段处理(CNN→ViT)、混合算子(如CoAtNet)、注意力增强卷积。

-

适用场景:数据有限、需多尺度特征、计算资源受限的任务。

这种混合架构代表了视觉模型的未来趋势——融合归纳偏置(CNN)与通用建模(ViT),而非非此即彼的选择。

在计算机视觉领域,图像分类、目标检测和图像分割是三大核心任务,各自有代表性的经典网络架构。以下是它们的典型网络及其特点总结:

1. 图像分类(Image Classification)

任务:将图像分配到预定义的类别标签。

典型网络:

| 网络 | 核心贡献 | 特点 | 适用场景 |

|---|---|---|---|

| AlexNet (2012) | 首个深度CNN成功模型(ImageNet冠军) | 5层卷积+3层全连接,ReLU激活 | 基础分类任务 |

| VGG (2014) | 统一使用3×3卷积堆叠 | 结构简单(VGG16/VGG19),参数量大 | 特征提取骨干网络 |

| ResNet (2015) | 残差连接(Residual Block)解决梯度消失 | 极深网络(如ResNet50/101),高效训练 | 通用分类、下游任务 backbone |

| EfficientNet (2019) | 复合缩放(深度/宽度/分辨率) | 参数量与计算量优化,高精度轻量化 | 移动端/边缘设备 |

| Vision Transformer (ViT) (2020) | 纯Transformer架构应用于图像 | 全局注意力机制,需大数据预训练 | 大规模分类任务 |

2. 目标检测(Object Detection)

任务:定位(Bounding Box)并分类图像中的物体。

典型网络:

| 网络 | 核心贡献 | 特点 | 适用场景 |

|---|---|---|---|

| Faster R-CNN (2015) | 引入RPN(Region Proposal Network) | 两阶段检测,高精度但速度较慢 | 高精度需求(如医学检测) |

| YOLO系列 (2016~2023) | 单阶段端到端检测(You Only Look Once) | 速度快(YOLOv8实时检测),精度权衡 | 实时检测(自动驾驶、视频) |

| SSD (2016) | 多尺度特征图预测 | 单阶段,平衡速度与精度 | 通用物体检测 |

| RetinaNet (2017) | Focal Loss解决类别不平衡 | 单阶段,对小物体检测效果好 | 密集物体检测(如人群) |

| DETR (2020) | Transformer端到端检测(无需NMS) | 全局建模,训练复杂但无手工设计组件 | 新颖架构研究 |

3. 图像分割(Image Segmentation)

(1) 语义分割(Semantic Segmentation)

任务:对每个像素分类(不区分实例)。

典型网络:

| 网络 | 核心贡献 | 特点 | 适用场景 |

|---|---|---|---|

| FCN (2015) | 全卷积网络(取代全连接层) | 首次端到端像素级预测,输出低分辨率 | 基础分割任务 |

| U-Net (2015) | 编码器-解码器结构 + 跳跃连接 | 医学图像分割标杆,小数据友好 | 医学影像、生物图像 |

| DeepLab系列 (2017~) | 空洞卷积(Atrous Conv) + ASPP模块 | 多尺度上下文信息捕捉,高分辨率输出 | 街景分割(如Cityscapes) |

| PSPNet (2017) | 金字塔池化模块(Pyramid Pooling) | 融合全局与局部上下文 | 场景理解 |

(2) 实例分割(Instance Segmentation)

任务:区分不同实例的像素级分割。

| 网络 | 核心贡献 | 特点 | 适用场景 |

|---|---|---|---|

| Mask R-CNN (2017) | Faster R-CNN扩展,添加分割分支 | 两阶段,高精度但计算量大 | 精细分割(如COCO竞赛) |

| YOLACT (2019) | 单阶段实例分割(原型生成+掩码组合) | 实时性能(30+ FPS) | 视频分割 |

| SOLOv2 (2020) | 按位置直接预测实例掩码 | 无需ROI操作,端到端训练 | 快速实例分割 |

4. 网络选择建议

-

图像分类:

-

轻量化:EfficientNet / MobileNet

-

高精度:ResNet / ViT(需大数据)

-

-

目标检测:

-

实时性:YOLOv8 / YOLO-NAS

-

高精度:Faster R-CNN / Cascade R-CNN

-

-

语义分割:

-

医学图像:U-Net / nnUNet

-

街景分割:DeepLabv3+ / HRNet

-

-

实例分割:

-

通用场景:Mask R-CNN

-

实时需求:YOLACT++

-

总结

-

分类网络:从CNN(ResNet)到Transformer(ViT)演进,注重特征提取能力。

-

检测网络:两阶段(Faster R-CNN)与单阶段(YOLO)并存,权衡速度与精度。

-

分割网络:编码器-解码器结构(U-Net)与上下文模块(DeepLab)结合,提升像素级预测。

实际应用中需根据数据规模、硬件条件、任务需求选择合适架构,并优先考虑预训练模型微调(Transfer Learning)。

DeiT(Data-efficient Image Transformer)详解

DeiT(Data-efficient Image Transformer)是一种专为图像分类任务设计的Transformer模型,由Facebook AI Research(FAIR)于2020年提出。其核心目标是在有限数据(如ImageNet-1K)上高效训练Vision Transformer(ViT),无需依赖海量预训练数据(如ViT需JFT-300M)。DeiT通过引入蒸馏策略和优化训练技巧,显著提升了小数据集上的性能。

1. DeiT的核心贡献

(1) 数据效率优化

-

问题:原始ViT需在超大规模数据集(如JFT-300M)预训练才能达到CNN(如ResNet)的性能。

-

解决方案:DeiT通过改进训练策略,仅用ImageNet-1K(120万张图像)即可训练高性能Transformer。

(2) 知识蒸馏(Knowledge Distillation)

-

蒸馏机制:

-

传统ViT:仅使用真实标签(Hard Label)训练。

-

DeiT:引入**教师模型(如CNN)**的软标签(Soft Label)作为额外监督信号。

-

(3) 训练技巧优化

-

数据增强:RandAugment、MixUp、CutMix等。

-

优化器:AdamW + 余弦学习率调度。

-

正则化:DropPath(随机丢弃注意力头或FFN路径)。

2. DeiT的模型架构

DeiT基于ViT架构,但针对小数据训练进行了优化:

(1) 主要组件

| 组件 | 描述 |

|---|---|

| Patch Embedding | 将图像分割为16×16的Patch,线性投影为嵌入向量(如224×224→14×14 Patch)。 |

| Class Token | 添加可学习的[CLS]标记,用于分类输出。 |

| Transformer Encoder | 多层自注意力(Self-Attention)和前馈网络(FFN)。 |

| Distillation Token | 新增一个可学习标记,专门接收教师模型的监督信号(与Class Token并行)。 |

(2) 两种蒸馏策略

| 策略 | 教师模型 | 特点 |

|---|---|---|

| 硬蒸馏(Hard Distill) | CNN(如RegNetY) | 直接拟合教师模型的类别预测(One-hot)。 |

| 软蒸馏(Soft Distill) | CNN | 拟合教师模型的概率分布(更鲁棒)。 |

3. DeiT的性能表现

(1) 与ViT和CNN的对比

| 模型 | 预训练数据 | ImageNet-1K Top-1 Acc | 参数量 |

|---|---|---|---|

| ViT-B/16 | JFT-300M | 77.9% | 86M |

| DeiT-B/16 | ImageNet-1K | 81.8% | 86M |

| ResNet50 | ImageNet-1K | 76.1% | 25M |

(2) 模型变体

| 模型 | 分辨率 | Top-1 Acc | 速度(GPU) |

|---|---|---|---|

| DeiT-Tiny | 224×224 | 72.2% | 快 |

| DeiT-Small | 224×224 | 79.8% | 中等 |

| DeiT-Base | 224×224 | 81.8% | 慢 |

| DeiT-Base ↑384 | 384×384 | 83.1% | 更慢 |

4. DeiT的应用场景

-

图像分类:适用于中小规模数据集(如医学图像、遥感影像)。

-

迁移学习:作为预训练骨干网络,用于目标检测、分割等下游任务。

-

边缘设备:轻量级变体(如DeiT-Tiny)适合移动端部署。

6. 总结

-

核心创新:通过知识蒸馏和高效训练策略,实现在小数据(ImageNet-1K)上训练高性能ViT。

-

关键优势:

-

无需海量预训练数据,媲美CNN的效率和精度。

-

支持硬蒸馏和软蒸馏,灵活适配不同教师模型。

-

-

适用领域:图像分类、迁移学习、资源受限场景。

DeiT证明了Transformer在视觉任务中不依赖超大规模数据的可行性,为后续工作(如Swin Transformer、ConvNeXt)提供了重要启示。

U-Net详解:医学图像分割的标杆架构

U-Net是由Olaf Ronneberger等人于2015年提出的全卷积网络(FCN)变体,专为小样本医学图像分割设计。其独特的对称编码器-解码器结构和跳跃连接(Skip Connections),使其在生物医学图像分割任务中表现卓越,成为该领域的基准模型。

1. 核心架构

U-Net的结构形似字母“U”,包含两部分:

-

编码器(下采样路径):提取多尺度特征

-

解码器(上采样路径):恢复空间分辨率并精确定位

(1) 编码器(Contracting Path)

-

由多个重复的卷积块(每个块含2个3×3卷积+ReLU)和最大池化(2×2,步长2)组成。

-

逐步下采样,增加通道数(如64→128→256→512),捕获上下文信息。

(2) 解码器(Expansive Path)

-

通过转置卷积(Transposed Conv)或上采样+卷积逐步恢复分辨率。

-

每层与编码器对应层的特征图通过跳跃连接拼接(Concatenation),融合低级细节与高级语义。

(3) 跳跃连接(Skip Connections)

-

将编码器的多尺度特征直接传递到解码器,解决梯度消失问题。

-

保留边缘等局部信息,提升分割精度。

2. 关键创新与优势

| 特性 | 说明 | 优势 |

|---|---|---|

| 对称编码器-解码器 | 下采样与上采样路径严格对称 | 结构规整,易于扩展 |

| 跳跃连接 | 跨层融合不同分辨率的特征 | 解决信息丢失,提升小目标分割能力 |

| 全卷积设计 | 无全连接层,支持任意尺寸输入 | 适用于不同分辨率的医学图像 |

| 数据增强策略 | 使用弹性变形(Elastic Deformation)增强训练数据 | 在小样本数据上有效防止过拟合 |

4. 代码实现(PyTorch)

import torch

import torch.nn as nn

class DoubleConv(nn.Module):

"""(卷积 => [BN] => ReLU) × 2"""

def __init__(self, in_channels, out_channels):

super().__init__()

self.double_conv = nn.Sequential(

nn.Conv2d(in_channels, out_channels, kernel_size=3, padding=1),

nn.BatchNorm2d(out_channels),

nn.ReLU(inplace=True),

nn.Conv2d(out_channels, out_channels, kernel_size=3, padding=1),

nn.BatchNorm2d(out_channels),

nn.ReLU(inplace=True)

)

def forward(self, x):

return self.double_conv(x)

class UNet(nn.Module):

def __init__(self, n_channels=1, n_classes=2):

super(UNet, self).__init__()

# 编码器

self.inc = DoubleConv(n_channels, 64)

self.down1 = nn.Sequential(nn.MaxPool2d(2), DoubleConv(64, 128))

self.down2 = nn.Sequential(nn.MaxPool2d(2), DoubleConv(128, 256))

self.down3 = nn.Sequential(nn.MaxPool2d(2), DoubleConv(256, 512))

self.down4 = nn.Sequential(nn.MaxPool2d(2), DoubleConv(512, 1024))

# 解码器

self.up1 = nn.ConvTranspose2d(1024, 512, kernel_size=2, stride=2)

self.conv1 = DoubleConv(1024, 512)

self.up2 = nn.ConvTranspose2d(512, 256, kernel_size=2, stride=2)

self.conv2 = DoubleConv(512, 256)

self.up3 = nn.ConvTranspose2d(256, 128, kernel_size=2, stride=2)

self.conv3 = DoubleConv(256, 128)

self.up4 = nn.ConvTranspose2d(128, 64, kernel_size=2, stride=2)

self.conv4 = DoubleConv(128, 64)

# 输出层

self.outc = nn.Conv2d(64, n_classes, kernel_size=1)

def forward(self, x):

# 编码器

x1 = self.inc(x)

x2 = self.down1(x1)

x3 = self.down2(x2)

x4 = self.down3(x3)

x5 = self.down4(x4)

# 解码器 + 跳跃连接

x = self.up1(x5)

x = torch.cat([x, x4], dim=1)

x = self.conv1(x)

x = self.up2(x)

x = torch.cat([x, x3], dim=1)

x = self.conv2(x)

x = self.up3(x)

x = torch.cat([x, x2], dim=1)

x = self.conv3(x)

x = self.up4(x)

x = torch.cat([x, x1], dim=1)

x = self.conv4(x)

# 输出

return self.outc(x)5. 变体与改进

| 变体 | 改进点 | 应用场景 |

|---|---|---|

| U-Net++ | 嵌套跳跃连接,多尺度特征融合 | 复杂结构分割(如器官) |

| ResUNet | 引入残差连接(ResNet风格) | 深层网络训练稳定性提升 |

| Attention U-Net | 添加注意力门控机制 | 聚焦关键区域(如肿瘤) |

| 3D U-Net | 3D卷积处理体积数据(如CT/MRI) | 医学影像三维分割 |

6. 应用场景

-

医学图像分割:细胞显微镜图像分割(原始论文任务)、脑肿瘤(BraTS)、肝脏(LiTS)分割挑战赛

-

遥感图像处理:地表覆盖分类、建筑物提取

-

自动驾驶:道路、车道线分割

7. 性能对比(ISBI细胞分割挑战赛)

| 模型 | 交并比(IoU) | 参数量 | 训练数据量 |

|---|---|---|---|

| 传统方法 | 0.83 | - | >1000 |

| U-Net | 0.92 | 7.8M | 30 |

8. 总结

-

核心价值:U-Net通过跳跃连接和对称结构,在小样本医学图像分割中实现SOTA性能。

-

设计哲学:

-

编码器捕获上下文 → 解码器精确定位

-

局部细节与全局语义的平衡

-

-

发展趋势:与Transformer结合(如UNETR)、轻量化(Mobile-UNet)。

CLIP(Contrastive Language–Image Pretraining)详解

CLIP是OpenAI于2021年提出的多模态模型,通过对比学习将图像和文本映射到共享的语义空间,实现零样本(Zero-Shot)分类、图文检索等任务,成为多模态领域的里程碑式工作。

1. 核心思想

-

目标:让模型理解图像和文本的语义关联,无需特定任务微调即可泛化到新任务。

-

方法:

-

对比学习:拉近匹配的图文对距离,推开不匹配的对。

-

共享嵌入空间:图像和文本编码为同一空间的向量,相似度计算(如余弦相似度)决定匹配程度。

-

2. 关键组件

(1) 双编码器结构

| 组件 | 架构 | 输出 | 示例 |

|---|---|---|---|

| 图像编码器 | Vision Transformer (ViT) 或 ResNet | 图像特征向量 II | 狗的图片 → [0.2, -0.3, ..., 0.8] |

| 文本编码器 | Transformer | 文本特征向量 TT | "一只狗" → [0.1, 0.5, ..., -0.2] |

3. 训练数据与规模

-

数据集:4亿对互联网图文(WebImageText)。

-

计算资源:256张GPU训练2周。

-

模型变体:

-

ViT-B/32:63M参数

-

ViT-L/14:302M参数

-

4. 核心优势

| 优势 | 说明 |

|---|---|

| 零样本能力 | 无需微调直接应用于新任务(如分类、检索)。 |

| 跨模态泛化 | 同一模型处理图像生成、文本描述等多任务。 |

| 对抗鲁棒性 | 对图像对抗攻击的鲁棒性优于传统监督模型。 |

| 可解释性 | 相似度分数直观反映图文匹配程度。 |

6. 性能对比(零样本分类)

| 模型 | ImageNet Top-1 Acc | 所需训练数据量 |

|---|---|---|

| 监督ResNet-50 | 76.2% | 1.2M标注样本 |

| CLIP-ViT | 72.3% | 零样本 |

7. 局限性

| 问题 | 原因/改进 |

|---|---|

| 细粒度分类能力弱 | 训练数据覆盖长尾类别不足 → 结合Few-shot Learning |

| 计算成本高 | 大模型推理慢 → 蒸馏为轻量版(TinyCLIP) |

| 文本偏见 | 从互联网数据继承社会偏见 → 数据清洗/去偏算法 |

8. 改进与变体

| 模型 | 改进点 | 机构 |

|---|---|---|

| ALIGN | 更大规模数据(1.8B图文对) | |

| Florence | 多模态统一表征支持视频 | Microsoft |

| CoCa | 融合对比损失与生成损失 |

9. 总结

-

革新性:CLIP证明了通过海量弱监督数据训练的统一多模态模型可超越传统监督学习。

-

设计启示:

-

对比学习是多模态对齐的有效方法。

-

规模(数据+算力)是性能突破的关键。

-

-

应用方向:

-

零样本分类/检索

-

生成模型的语义控制器

-

多模态内容审核

-

Transformer 详解:从理论到实践

Transformer 是由 Google 团队在 2017 年提出的基于自注意力机制的神经网络架构,彻底改变了自然语言处理(NLP)和计算机视觉(CV)领域。以下是其核心原理、关键组件和实际应用的系统解析:

1. 核心思想

-

目标:解决 RNN 的长距离依赖问题,实现并行化序列建模。

-

创新点:

-

自注意力机制(Self-Attention):直接建模序列中任意两个元素的关系。

-

位置编码(Positional Encoding):替代 RNN 的时序处理,保留位置信息。

-

纯注意力架构:无需卷积或循环结构。

-

2. 关键组件

3. 编码器-解码器结构

| 组件 | 功能 | 关键操作 |

|---|---|---|

| 编码器 | 将输入序列映射为上下文相关的表示 | 多头自注意力 + FFN(堆叠 N 层) |

| 解码器 | 基于编码器输出生成目标序列 | Masked 多头注意力 + 交叉注意力 + FFN |

| Mask 机制 | 解码时屏蔽未来位置(防止信息泄露) | 上三角矩阵设为 -∞ |

5. 代码实现(PyTorch)

import torch

import torch.nn as nn

class MultiHeadAttention(nn.Module):

def __init__(self, d_model, num_heads):

super().__init__()

self.d_k = d_model // num_heads

self.num_heads = num_heads

self.W_q = nn.Linear(d_model, d_model)

self.W_k = nn.Linear(d_model, d_model)

self.W_v = nn.Linear(d_model, d_model)

self.W_o = nn.Linear(d_model, d_model)

def forward(self, Q, K, V, mask=None):

# 线性变换并分头

Q = self.W_q(Q).view(-1, Q.size(1), self.num_heads, self.d_k)

K = self.W_k(K).view(-1, K.size(1), self.num_heads, self.d_k)

V = self.W_v(V).view(-1, V.size(1), self.num_heads, self.d_k)

# 计算注意力分数

scores = torch.matmul(Q, K.transpose(-2, -1)) / torch.sqrt(torch.tensor(self.d_k))

if mask is not None:

scores = scores.masked_fill(mask == 0, -1e9)

attn_weights = torch.softmax(scores, dim=-1)

# 加权求和

output = torch.matmul(attn_weights, V)

output = output.transpose(1, 2).contiguous().view(-1, output.size(1), self.num_heads * self.d_k)

return self.W_o(output)

# 示例用法

d_model = 512

num_heads = 8

attn = MultiHeadAttention(d_model, num_heads)

x = torch.randn(1, 10, d_model) # 输入序列

output = attn(x, x, x)6. 变体与改进

| 模型 | 改进点 | 应用场景 |

|---|---|---|

| BERT | 双向Transformer编码器 | 文本分类、问答 |

| GPT | 自回归Transformer解码器 | 文本生成 |

| ViT | 图像分块输入Transformer | 图像分类 |

| Swin Transformer | 分层窗口注意力 | 高分辨率图像处理 |

7. 应用场景

-

自然语言处理:

-

机器翻译(如 Google Translate)

-

文本生成(如 ChatGPT)

-

-

计算机视觉:

-

图像分类(ViT)

-

目标检测(DETR)

-

-

多模态任务:

-

图文检索(CLIP)

-

视频理解(TimeSformer)

-

8. 性能对比

| 任务 | RNN/LSTM | Transformer | 提升 |

|---|---|---|---|

| 机器翻译(BLEU) | 28.4 | 41.8 | +47% |

| 训练速度(step/sec) | 120 | 350 | +192% |

9. 关键问题解答

Q1:Transformer 为何比 RNN 更适合长序列?

-

RNN 依赖逐步传递的隐藏状态,信息易丢失;Transformer 通过自注意力直接建模任意距离依赖。

Q2:位置编码是否必需?

-

是的,纯注意力无法感知顺序。可替换为可学习的位置嵌入(如 BERT)。

Q3:如何降低计算复杂度?

-

稀疏注意力(Longformer)、局部窗口注意力(Swin Transformer)、低秩近似(Linformer)。

10. 总结

-

核心价值:通过自注意力实现高效并行化和长距离依赖建模。

-

设计哲学:

-

全局交互(注意力) + 局部转换(FFN)

-

残差连接保障梯度流动

-

-

未来方向:

-

更高效的注意力机制(如线性注意力)

-

跨模态统一架构(如 Unified Transformer)

-

DDPM(Denoising Diffusion Probabilistic Models)详解

DDPM(去噪扩散概率模型)是2020年提出的一种生成模型,通过模拟物理中的扩散过程实现高质量数据生成(如图像、音频)。其核心思想是通过逐步加噪和逐步去噪的过程学习数据分布,已成为扩散模型领域的奠基性工作。

1. 核心思想

4. 代码实现(PyTorch精简版)

import torch

import torch.nn as nn

class DDPM(nn.Module):

def __init__(self, model, T=1000, beta_start=1e-4, beta_end=0.02):

super().__init__()

self.model = model # UNet模型

self.T = T

# 定义噪声调度

self.betas = torch.linspace(beta_start, beta_end, T)

self.alphas = 1 - self.betas

self.alpha_bars = torch.cumprod(self.alphas, dim=0)

def forward(self, x0):

t = torch.randint(1, self.T, (x0.shape[0],)) # 随机采样时间步

epsilon = torch.randn_like(x0) # 生成噪声

xt = torch.sqrt(self.alpha_bars[t]) * x0 + torch.sqrt(1 - self.alpha_bars[t]) * epsilon

epsilon_pred = self.model(xt, t) # 预测噪声

loss = torch.mean((epsilon - epsilon_pred)**2) # MSE损失

return loss

def sample(self, n_samples, img_size):

xt = torch.randn(n_samples, *img_size) # 初始噪声

for t in range(self.T, 0, -1):

epsilon_pred = self.model(xt, torch.full((n_samples,), t))

xt = (xt - (1 - self.alphas[t]) / torch.sqrt(1 - self.alpha_bars[t]) * epsilon_pred) / torch.sqrt(self.alphas[t])

if t > 1:

xt += torch.sqrt(self.betas[t]) * torch.randn_like(xt)

return xt5. 优势与局限性

| 优势 | 局限性 |

|---|---|

| 生成质量高(尤其图像细节) | 生成速度慢(需迭代多步) |

| 训练稳定(损失函数简单) | 长序列生成(如视频)计算成本高 |

| 无需对抗训练(相比GAN) | 对小数据集过拟合风险 |

6. 改进与变体

| 模型 | 改进点 | 效果 |

|---|---|---|

| DDIM | 非马尔可夫扩散加速采样 | 10~50步达到DDPM 1000步质量 |

| Stable Diffusion | 在潜在空间进行扩散 | 降低计算成本,支持高分辨率生成 |

| Cold Diffusion | 通用去噪算子(非仅高斯噪声) | 支持多种退化类型(如模糊、遮挡) |

7. 应用场景

-

图像生成:文本到图像生成(如Stable Diffusion)。

-

图像修复:填充缺失区域(如Adobe Photoshop的“内容感知填充”)。

-

超分辨率:从低分辨率图像生成高分辨率版本。

-

音频生成:音乐合成(如OpenAI的Jukebox)。

9. 总结

-

核心价值:DDPM通过扩散和去噪的物理过程实现高质量生成,避免了GAN的训练不稳定问题。

-

设计哲学:

-

前向过程:逐步破坏数据分布。

-

反向过程:学习逐步重建数据分布。

-

-

未来方向:

-

加速采样(如DDIM)。

-

多模态扩散(如文本+图像联合生成)。

-