文章目录

前言

DeepSeek开源之后,让大家意识到即便在本地硬件性能一般的环境下,也能够部署和使用大语言模型,真正实现了大模型的“私有化”。而在实现私有化大模型之后,自然会考虑生产力的私有化。例如,如何使用大模型作为工具进行编程?本文将介绍两种不同的人工智能编程方法。

一、Cursor 的安装与使用

1、Cursor 简介

第一种方法是使用 Cursor 进行编程,它是一个与 VSCode 很相似的 IDE,优点是支持很多模型的 API,如 DeepSeek、o1 - mini、o3 等,是原生为人工智能编程而设计的。

2、Cursor 安装

首先访问Cursor 官网,下载适合自己本地平台的版本。这里以 Windows 版本为例,可直接安装。

安装过程中没有太多可配置的选项,按照自己的需求进行设置即可。

3、Cursor 基本使用

打开工作空间:打开一个文件夹作为 workspace。

创建测试脚本:创建一个测试 py 脚本,只需输入一行注释。此时下面的代码呈灰色,按一下 TAB 键,就可以插入 AI 生成的代码。

生成函数:也可以选择生成一些函数。若输入的指令不明确,函数可能无输出,可要求它输出一个排序之后的列表,点击 TAB 键,即可自动填入生成的代码。甚至还会自动生成两个测试案例,对需要单元测试的项目非常友好。

项目 Chat:除了写代码,还可以把项目作为输入的知识库进行 Chat,使用快捷键 ctrl + L 即可。代码解读较为准确,可作为源码阅读的辅助工具。

直接输入需求生成代码:除了使用注释生成代码,还可以直接用 ctrl + K 快捷键弹出代码需求窗口,输入需求即可生成代码。点击绿色按钮,代码会填入到光标位置。若光标前有缩进,生成的代码块前默认会加一个缩进,可根据需求调整位置。

4、小结

Cursor 的智能编程体验不错,且使用远程的 API 对本地环境要求不高。但似乎较难配置本地的 Ollama 环境,也未找到相关文档。若本地已部署 Ollama 环境,可优先查看下面章节介绍的 VSCode 插件。

二、VSCode 插件 Continue

1、安装与配置

安装插件:直接在 VSCode 的插件商城里搜索 Continue 并点击安装,安装后左侧会显示一个 Continue 的图标。

添加 Chat Model:可以在对话选项里选择添加一个 Chat Model。若配置了 Ollama 的环境,会显示出本地的相关模型。

显示出本地的相关模型:如果配置了Ollama的环境,会显示出本地的相关模型。

查看本地 Ollama 运行情况:运行前可使用命令 $ ollama ps 查看本地 Ollama 运行情况。

$ ollama ps

NAME ID SIZE PROCESSOR UNTIL

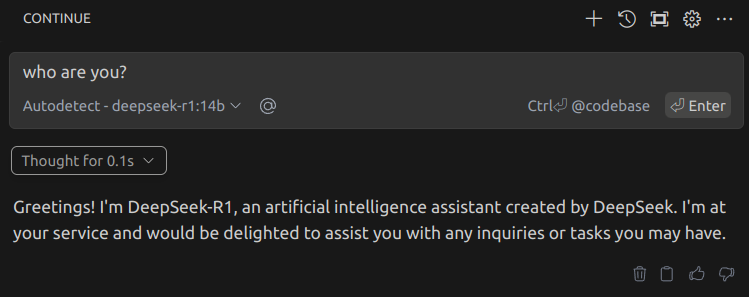

随便发送一个问题过去:

再次使用 $ ollama ps查看,若显示加载 Ollama 模型对话成功,就会收到回复:

额外设置:临时会话配置完成后,若要实现 DeepSeek 智能编程,需找到 Local with Ollama 做一些额外设置。

点击 config file 进行配置,默认是这样的:

或者也可以从continue的设置里面找到配置文件的位置:

按照自己本地模型修改下代码:

这里关于Ollama的请求格式,可以参考其官网文档 。

查看快捷键使用方法:点击设置按钮右边的三个点的按钮,可查看 Continue 插件的快捷键使用方法。

接下来开始智能编程。

2、Continue 与 DeepSeek

生成代码:先输入一个注释,选中注释,会提示快捷键使用方法。例如使用 ctrl + L 快捷键进入 Chat 模式,告知需要生成代码,点击接受,新的代码就会更新进来。

编辑代码:选中刚才生成的代码,使用 ctrl + I 快捷键启用编辑模式,告知要修改的内容,可看到自动生成的函数效果。

Chat 模式生成代码:补充一个 Chat 模式随机字符串生成的函数(要在对话框里 @ 所需修改的文件),chat 模式下生成的代码块有一个三角形,可直接 apply 到 python 文件中。

本地运行测试:使用命令测试 AI 生成代码的本地运行。

$ python3 test_chat.py

s!

3、小结

Continue 插件使用的完全是本地 Ollama 环境中的 DeepSeek 开源蒸馏模型,能很好地将本地 LLM 和 Embedding 模型应用到人工智能编程中。不过,虽然隐私性较好,但效率和质量会受限于本地的硬件条件。

三、参考链接

四、总结概要

本文介绍了两种智能编程方案,一种是使用 Cursor 结合远程 API 形式的智能化自动编程,另一种是 VSCode 插件结合本地部署的 Ollama 模型进行智能编程。用户可根据自身需求选择合适的交互方案,总体而言,智能化、自动化的编程已近在眼前。