DeepSeek 最近很火,也有不少本地化部署的文章了,这里主要是分享比较难下载的安装文件,以及如何在一台 Windows 机器上安装后让其他的同事也能用上。

百度网盘:

通过网盘分享的文件:CSDN_DeepSeek

链接: https://pan.baidu.com/s/17qK0Nx73bFOsicLgLmA8-A?pwd=tc61 提取码: tc61

阿里云盘也进行了上传,但只能进行快传分享,需要的小伙伴可以私信或留言。

1.软件安装

O 默认安装在 C 盘下载的模型文件也在 C 盘(对 C 盘的存储空间要求比较高),C 可以自定义安装位置,两个 exe 安装过程很简单,这里不赘述安装过程了。

#安装ollama到指定目录

OllamaSetup.exe /DIR="E:\DevelopmentEnvironment\ollama"

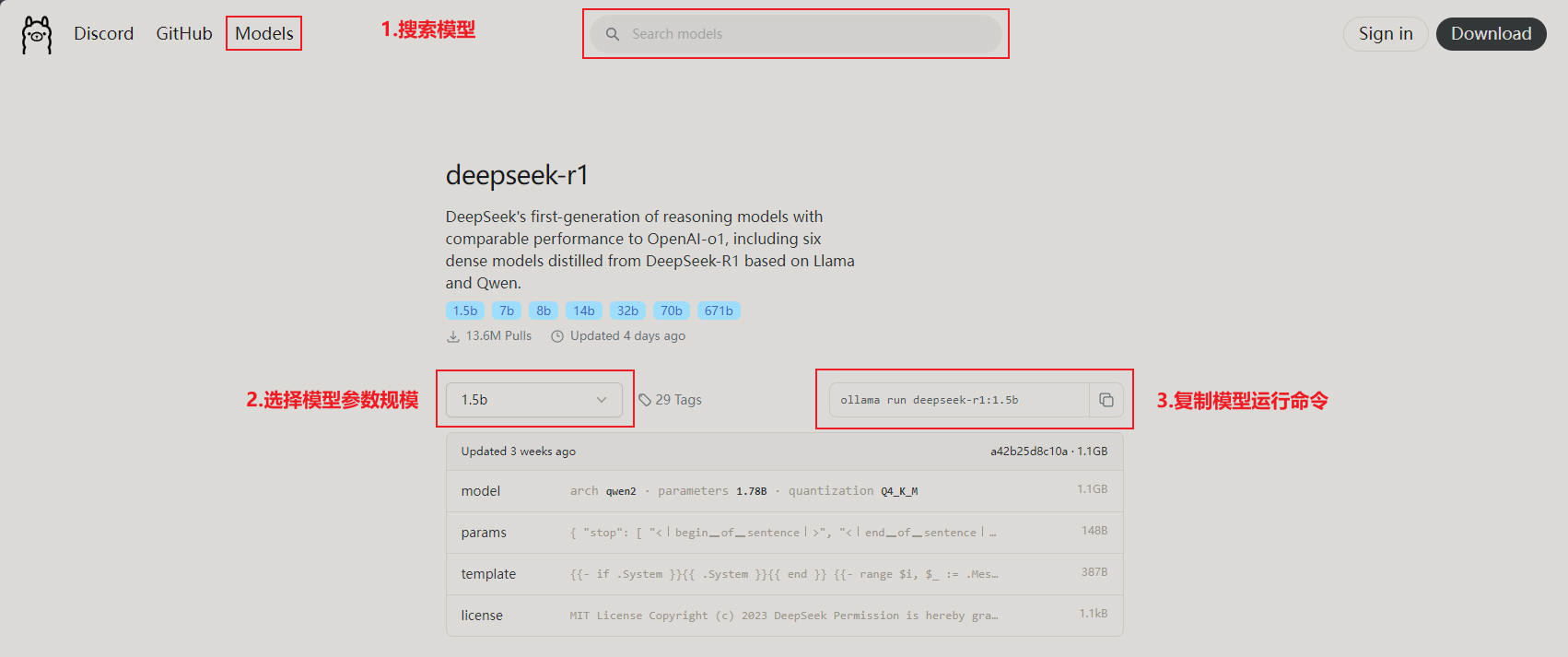

2.模型安装

O 安装后,使用 PowerShell 或者 CMD 都可以,验证 O 是否安装成功:

ollama -v

运行模型:

使用命令:

ollama run deepseek-r1:1.5b

等待模型文件下载,我这边的速度是很慢的。

如果下载过程中断开了连接,可以续传,以下是下载成功标识:

3.客户端安装

选择自定义安装目录后一路下一步即可,安装成功后:

点击使用自己的 API Key 或本地模型(这里有个小坑:不能选择 DeepSeek API):

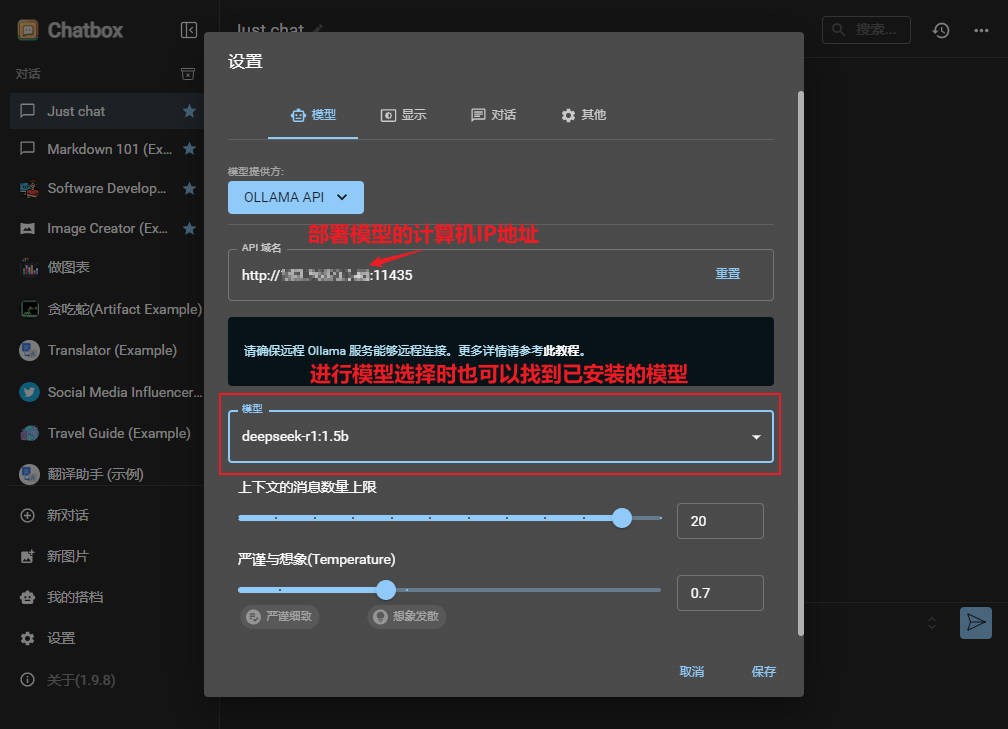

点击设置,选择模型提供方 OLLAMA API域名默认即可(这里记住这个端口号,后边有用),模型选择刚下载好的 deepseek-r1:1.5b,其他设置可以自行研究调整:

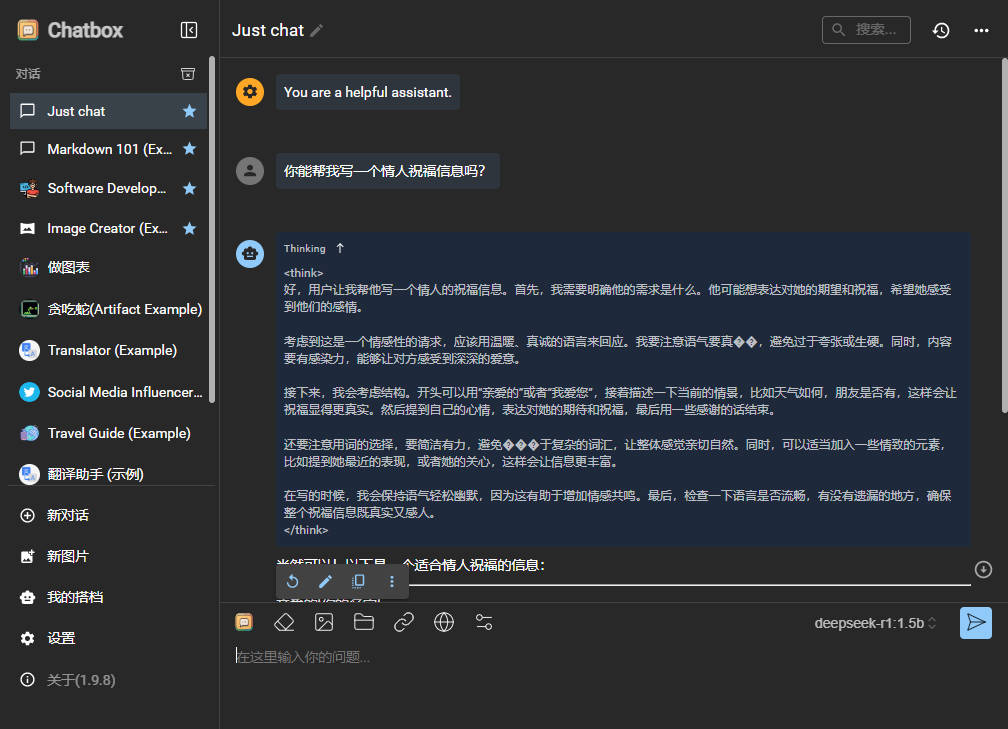

发个消息试一试,还是可以的,也可以上传文档,对文档进行提问,私有化部署就可以处理不方便上传互联网的数据了。

4.端口映射

4.1 使用 Nginx 反向代理

在安装好 O 和 C的 Windows 机器上启动一个 Nginx 进行一下配置:

server {

listen 11435;

server_name localhost;

location / {

proxy_pass http://127.0.0.1:11434;

proxy_set_header Host $host;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

proxy_set_header X-Forwarded-Proto $scheme;

}

}

4.2 客户端使用

在另一台服务器上安装 C后进行配置:

测试:

5.总结

在AI模型满天飞的当下,有一个好的模型且开源能本地部署的,真的不容易。