VLLM与Ollama简介

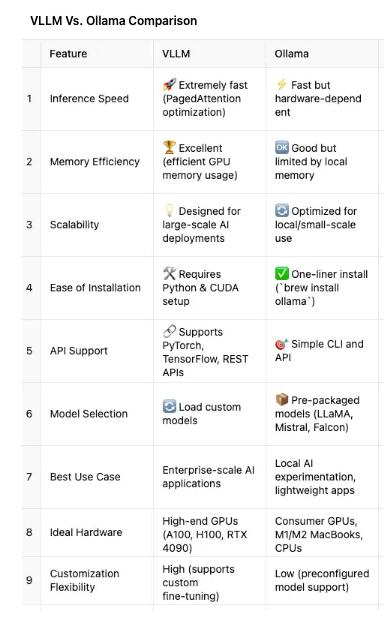

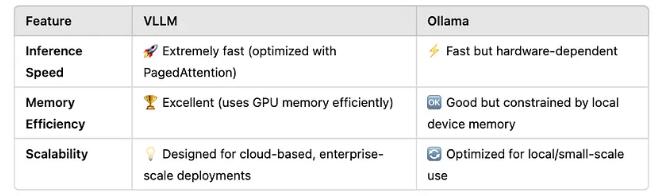

在这个科技不断进步的时代,大型语言模型(LLM)已经成为人工智能应用程序的心脏。而在这个心脏中,VLLM和Ollama就像是一对紧密相连的孪生兄弟。VLLM,作为一款超大型语言模型的优化推理引擎,由SKYPILOT精心打造。它主打高速令牌生成和高效的内存管理,宛如高性能跑车,无论是马力还是速度都远超凡车,适合企业级应用。相比之下,Ollama则更像是一位温文尔雅的贵族,简化了在本地机器上运行开源LLM的过程,让开发者轻松愉快地在家体验AI的魅力。这两个框架各自摆出了各自的招牌,全力以赴满足不同需求。

性能:速度与效率的较量

在比较VLLM和Ollama的性能时,速度、内存和扩展性是必不可少的因素。VLLM通过新颖的PagedAttention技术,以其强大的推理速度和出众的内存使用效率,以惊人的表现迅速捕获开发者的芳心,成为他们主要信赖的伙伴。高端GPU如A100、H100与RTX 4090在其怀抱中犹如鱼儿得水,游刃有余。Ollama虽然在本地硬件上也表现出色,但随着大型模型的需求增加,它时常显得力不从心,犹如一位长途跋涉的旅者,急需休整。

三、应用场景:谁更胜一筹?

在具体应用场景上,VLLM绝对是大型企业AI应用的理想选择。比如在客户服务、专业搜索引擎等场合,VLLM以庞大的上下文能力和高端性能优势,将用户体验推向了一个新的高度。想要在云上进行微调和自定义模型的开发者,VLLM也会是你火热追求的对象。但另一方面,对于个人开发者和AI爱好者来说,Ollama更像是你寻梦路上的最佳伴侣。在没有云资源的情况下,Ollama支持在Mac、Windows和Linux等本地设备上便捷使用,轻松应对各类AI模型的试验,简单易用的API如同一把神奇钥匙,打开了无数的可能。

四、选择适合你的AI武器

对于追求极致性能的开发者来说,VLLM提供了那些所需的深度定制选项,是你长途旅行中的强大支持。而对于希望迅速启动的普通开发者,Ollama无疑是另一条轻松之路,像是在熙熙攘攘的城市中,给你带来一片安静的休憩角落。两者都是AI领域的璀璨明星,选择哪一颗,关键在于你的需求与目标。无论是追求高速、强大,还是希望轻松、便捷,VLLM和Ollama都在期待着与你的相遇。