本文是安装的Linux版的Ollama。

方法一(推荐 Docker跑UI和Ollama)

1. 拉取Open WebUI 与 Ollama 捆绑在一起的单个容器映像

戳我访问OpenWebUi的github地址,复制安装命令,在linux中运行。

2. 运行容器

docker run -d -p 3000:8080 --gpus=all -v ollama:/root/.ollama -v open-webui:/app/backend/data --name ollama-open-webui --restart always ghcr.io/open-webui/open-webui:ollama

docker ps -a | grep webui

3. 进入容器通过Ollama下载运行模型

docker exec -it ollama-open-webui /bin/bash

访问 Ollama官网地址,搜索模型复制命令。

ollama run deepseek-r1:7b

等待下载完成。

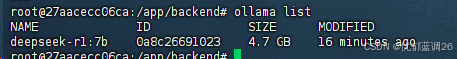

查看下载的模型

ollama list

访问3000端口,注册账户后开始使用。

方法二(Docker跑UI,本机跑Ollama)

Windows版本的方法类似,安装Ollama后,Win + R 输入 cmd 打开控制台从第二步开始看。

先安装Ollama,然后在Ollama搜索选择DeepSeek模型,在Linux服务器上部署DeepSeek。

1. 访问 Ollama官网地址,复制安装命令,在linux中运行。

curl -fsSL https://ollama.com/install.sh | sh

2. 验证Ollama安装。

ollama -v

3. 在Ollama搜索需要的模型,复制运行命令。

ollama run deepseek-r1:7b

等待模型下载完成即可使用。

这里使用 8b 模型演示效果。

4. 配置Open-WebUi可视化界面

访问Open-WebUi的Github地址,查看部署命令。

这里演示使用的Docker的方式,只单单跑Open-WebUI镜像,Ollama跑在本机。

Linux中需要先下载安装Docker,然后运行如下命令。

多说一句:强烈建议使用Docker的方式来部署,但需要有一点容器的基础知识,如果不熟悉的可以看Open-WebUi官网地址,往下划找到pip的部署方式部署WebUI。

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

访问3000端口,注册管理员账户后登录使用。