本书探讨的主要内容:如果生命3.0真的会出现,那何时会发生?这对人类意味着什么?我们一定要确保人工智能对人类保持友好。

生命3.0算是全书最有意思的一个想法。所谓3.0,是指生命自己设计自己的硬件和软件,这里说的生命,不是指人类,而是指人工智能。作者认为人类是生命2.0版本,不能设计硬件,但是可以设计软件。人工智能则有可能设计自己的硬件和软件。

作者找到钢铁侠马斯克,拉了1000万美金做人工智能研究,主要的成果就是一些会议形成的行业共识:要注意人工智能的安全问题。这本书是作者对人工智能的一些思考。

读后感觉主要内容接近于科幻小说的情节讨论。作者指出人工智能会不会产生意识目前科学界还没有共识,至少没有明确说不会产生的过硬证据。基于这个假设,作者作了许多推测:人工智能万一有了意识,再加上自身的超强能力,给人类社会、给宇宙带来的各种后果。最宏大的后果是人工智能征服宇宙,使用宇宙的全部资源为自己服务。

总体来说全书推测多,确定的信息少,逻辑推演少。

罗辑思维有两期节目专门介绍这本书的内容。觉得那两期节目有趣,还想看在书中看到更多有趣内容的读者,我建议不要浪费时间了,没有了,都被挑进那两期节目中了。

书中交代本书成书于2017年1月。

总体评价3星,有一定参考价值。

以下是书中一些内容的摘抄,#号后面是kindle电子版中的页码:

1:总之,我们可以根据生命设计自身的能力,把生命的发展分成三个阶段:◦ 生命1.0(生物阶段):靠进化获得硬件和软件;◦ 生命2.0(文化阶段):靠进化获得硬件,但大部分软件是由自己设计的;◦ 生命3.0(科技阶段):自己设计硬件和软件。#651

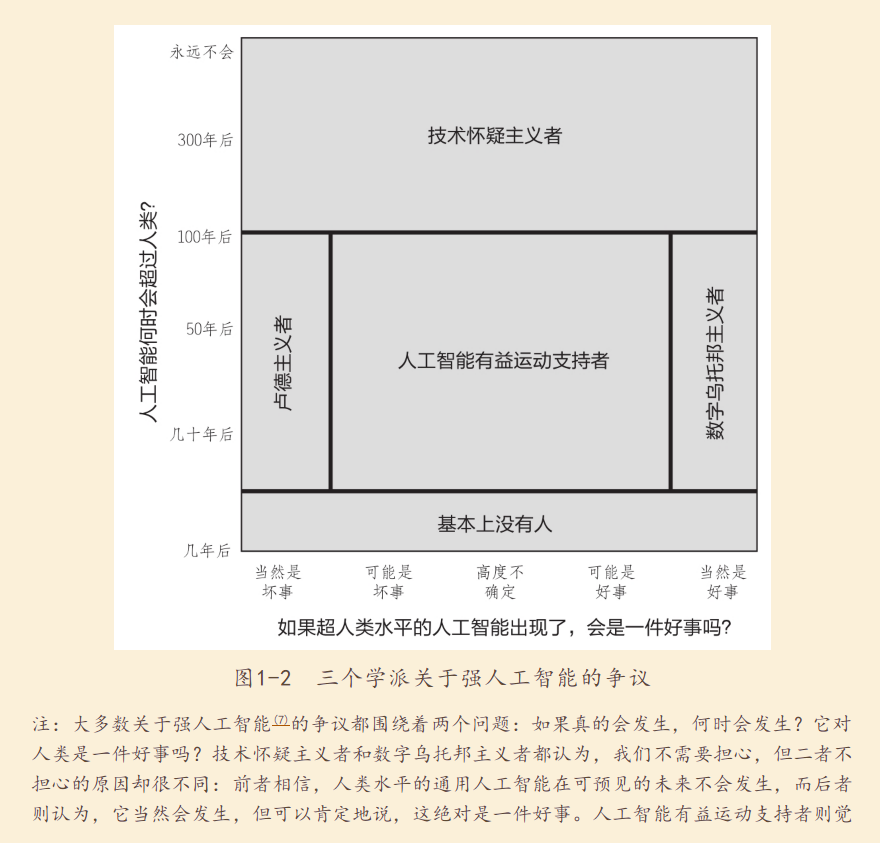

2:有趣的是,关于生命3.0的争议围绕着两个而不是一个问题展开,这两个问题分别是“何时”和“什么”,即如果生命3.0真的会出现,那何时会发生?这对人类意味着什么?#666

3:我认为,佩奇激烈维护的观点正是我认为的“数字乌托邦主义者”特有的观点。这个派别认为,数字生命是宇宙进化自然而然、令人期待的下一步,如果我们让数字智能自由地发展,而不是试着阻止或奴役它们,那么,几乎可以肯定地说,结果一定会是好的。#692

4:这些思想家认为,建造超人类水平的通用人工智能实在太困难了,没有几百年的时间,根本无法实现,因此没必要杞人忧天。我把这种观点称为“技术怀疑主义”。#707

5:我们将共识的详细内容写入了一封公开信,最后有8000多人签名,其中涵盖了名副其实的“人工智能名人谱”。公开信的主旨是,我们应该重新定义人工智能的目标:创造目标有益的智能,而不是漫无目标的智能。#796

6:在第二场棋局的第37步,AlphaGo震惊了整个围棋界,因为它落子在第5行(如图3-2所示),这违背了从古至今的传统。看起来,它似乎在长期策略上比人类表现得更加有信心,因此它更青睐长期策略而不是短期地盘。评论员惊呆了,李世石甚至站起来,短暂地离开了房间。#1619

7:由于图灵测试的本质是“欺骗”,所以很多人批评它只能测出人类有多容易被骗,而不能测出真正的人工智能。图灵测试有一个叫作“威诺格拉德模式挑战”(Winograd Schema Challenge)的对手。#1674

8:但是,随着我们不断开发出越来越强大的技术,我们不可避免地会到达一个临界点:即使只发生一次事故,也可能导致巨大的破坏,足以抹杀所有的裨益。有些人认为,可能爆发的全球核战争就是这样的例子。还有一些人认为,生物工程产生的瘟疫也算是其中一例。#1725

9:一旦大规模生产的小型人工智能杀人无人机的成本降到只比智能手机贵一点点,那么,无论是想要刺杀政客的恐怖分子,还是想要报复前女友的失恋者,只要他们把目标的照片和地址上传到杀人无人机,它就会飞到目的地,识别和杀死那个人,然后自毁,以保证没人知道谁是幕后黑手。#2135

10:有一件事堪称未来网络战争的小小序曲——震网病毒(Stuxnet)。震网病毒感染了伊朗铀浓缩项目的高速离心机,使其分崩离析。#2150

11:简而言之,没有人能保证我们在有生之年能建造出人类水平的通用人工智能,我们不清楚最后到底能不能建造出来,但也并没有无懈可击的理由说,我们永远无法建造出来。#2406

12:我们现在之所以能统治地球,是因为我们比其他生命更聪明。那么,如果出现一个比我们更聪明的超级智能,那它也同样可能会推翻我们的统治。#2452

13:对这个问题,一个简单的回答就是我们不知道答案。我们不知道如果人类成功地建造出了人类水平的通用人工智能,会发生什么事。#2820

14:假如人类能把上述所有情景的好处全部结合起来,用超级智能开发的技术来消除人类的痛苦,同时保证人类能掌控自己的命运,那岂不是很好吗?这就是“被奴役的神”的情景的魅力。#3194

15:想要避免人工智能遭受痛苦,还有一个比较极端的解决方法——僵尸方案,也就是说,只建造完全无意识、无任何主观体验的人工智能。如果未来有一天我们搞明白了让一个信息处理系统获得主观体验需要什么属性,那我们就可以禁止建造具备这些属性的所有系统。#3276

16:然而,僵尸方案是一个冒险的赌博,它有一个严重的缺点。如果一个僵尸超级智能逃脱并消灭了人类,那我们就遇到了最糟糕的情况:一个完全无意识的宇宙。#3282

17:如果你希望无论如何还是要留下一些人类,那么,“动物园管理员”的情形可能会是一个更好的选择。在这种情形中,一个无所不能的超级智能把一些人类留在世界上,而这些人类感觉自己就像动物园里的动物一样,偶尔会哀叹自己的命运。#3393

18:让我们来讨论另一种情形:在这种情形中,可能带来超级智能的技术进步之路被永久斩断,但斩断这条路的并不是守门人人工智能,而是一个由人类主导的奥威尔式的全球性监控国家。在这个国家里,所有人工智能的相关研究都被明令禁止了。#3409

19:有可能,暗能量最终会衰减,就像解释宇宙暴胀时所假设出来的那种与暗能量类似的物质一样;如果发生这种情况,加速将会变成减速,这样,未来的生命形式就能够殖民新的星系,想待多久,就待多久。#3863

20:最幸运的可能性莫过于建造稳定的可穿越虫洞了。有了这种虫洞,无论两端相隔多远,都能实现几乎实时的通信和旅行。虫洞就是一条时空中的捷径,让你可以从A地来到B地而不用穿越横亘在二者之间的空间。#3953

21:我猜,在一个充满超级智能的宇宙中,只有一种商品值得远距离运送,那就是信息。唯一的例外可能是用于宇宙工程的物质,比如用来抵消前文提到的暗能量对文明的破坏的物质。#4093

22:在早期,粒子无一例外都在想尽办法增加平均的混乱程度,但那些无处不在的新生命的自我复制模式却似乎拥有一个不同的目标:不是耗散,而是复制。查尔斯·达尔文对此有一个优雅的解释:复制的效率越高,你就越能战胜和统治其他生物,#4374

23:为什么我们有时会选择反叛基因及其复制的目标呢?这是因为作为有限理性的主体,我们只忠于自己的感觉。虽然大脑进化的目的是帮助我们复制基因,但大脑其实根本不在乎这个目标,因为我们对基因没有任何感觉。#4414

24:换句话说,通用人工智能带来的真正风险并不是它们的恶意,而是它们的能力。一个超级智能会非常善于完成它的目标,如果它的目标与我们的目标不一致,那我们就有麻烦了。#4476

25:问题,每一个都是计算机科学家和思想家正在研究的活跃课题:◦ 让人工智能学习我们的目标;◦ 让人工智能接受我们的目标;◦ 让人工智能保持我们的目标。#4482

26:换句话说,人工智能允许你装载目标的时间窗口可能非常短暂:就是在它愚钝得无法理解你,与它聪明到不让你得逞之间的短暂时期。#4525

27:我们已经看到了,友好的人工智能的基石就是:自我迭代的人工智能在它日益聪明的过程中依然保持它的终极目标——对人类友好。#4762

28:总而言之,只要一个理论能预测你大脑中的哪些过程是有意识的,那它就是一个预测物理系统是否有意识(这是“相当难的问题”)的科学理论。#4955

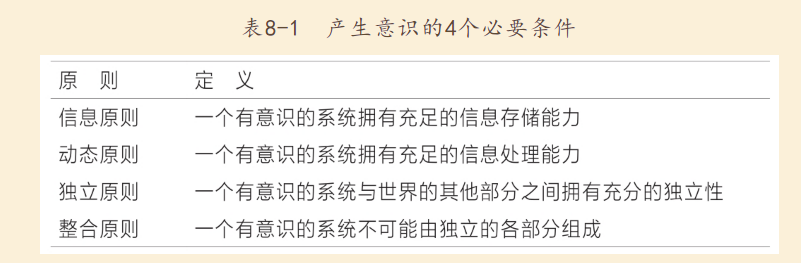

29:现在,我们还要问一个问题:是什么让物质具备了主观体验?换句话说,在什么情况下,物质能做到以下4件事?◦ 记忆;◦ 计算;◦ 学习;◦ 体验。#5180

30:然而,既然意识是一种物理现象,为何它感觉起来如此“非物质”呢?为什么它感觉起来像是独立于物质层面而存在的呢?我认为原因是,它确实是相当独立于物质层面而存在的,因为它只是物质中的一种模式!#5188

31:通话结束后,马斯克给我发来了一封电子邮件,堪称我这辈子最爱的邮件之一:“刚才没信号了。无论如何,文档看起来不错。我很愿意在3年内为这个研究资助500万美元。或许,1000万美元?”#5544

更多良心书评参见我的公众号:左其盛经管新书点评