话不多说,上demo~

test.txt文件里包含了hello world行,读者可自己修改测试、

val inputfile=“file:///home/wangyang/helloSpark.txt” //文件的绝对路径

val conf = new SparkConf().setAppName(“HelloWorld”).setMaster(“spark://IP地址:7077”) //提交的服务器地址

val sc = new SparkContext(conf)

val textfile = sc.textFile(inputfile)

//查询包含hello world的行

val lines = textfile.filter(line => line.contains(“helloworld”))

lines.foreach(println)

HDFS 文件系统

Hadoop之HDFS上测试创建目录、上传、下载文件

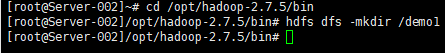

1、HDFS上创建目录

${HADOOP_HOME}/bin/hdfs dfs -mkdir /demo1

2、上传本地文件到HDFS上

${HADOOP_HOME}/bin/hdfs dfs -put ${HADOOP_HOME}/etc/hadoop/core-site.xml /demo1

3、上传本地文件到HDFS上

${HADOOP_HOME}/bin/hdfs dfs -cat /demo1/core-site.xml

4、从HDFS上下载文件到本地

${HADOOP_HOME}/bin/hdfs dfs -get /demo1/core-site.xml

IDEA 打成jar包

将jar上传至服务器下任意文件夹

将上面Java实现的单词计数打成jar包FirstSpark.jar,并且将jar包上传到Master节点,我是将jar包上传到/opt目录下。

我是以spark-submit的方式完成任务提交。

参考链接:https://www.cnblogs.com/xxbbtt/p/8143593.html

参考链接:https://www.cnblogs.com/zengxiaoliang/p/6508330.html