- 损失函数——交叉熵损失函数

- 摘录:

https://zhuanlan.zhihu.com/p/35709485

http://jackon.me/posts/why-use-cross-entropy-error-for-loss-function/

1.分类模型 与 Loss 函数的定义

监督学习的 2 大分支:

分类问题:目标变量是离散的。

回归问题:目标变量是连续的数值。

本文讨论的是分类模型。

例如:根据年龄、性别、年收入等相互独立的特征, 预测一个人的政治倾向(民主党、共和党、其他党派)。

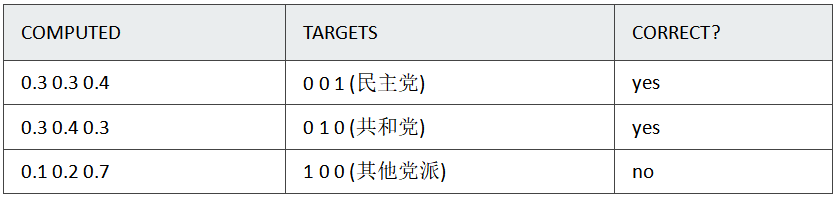

Eg:使用 3 组训练数据,来预测政治

computed 一栏是预测结果,targets 是预期结果。 二者的数字,都可以理解为概率。 correct 一栏表示预测是否正确。

模型1:

模型1对于样本1和样本2以非常微弱的优势判断正确,对于样本3的判断则彻底错误。

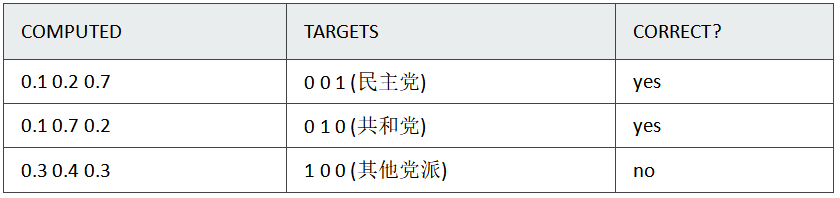

模型2:

模型2对于样本1和样本2判断非常准确,对于样本3判断错误,但比较轻。

有了模型以后,我们需要通过定义损失函数来判断模型在样本上的表现了,那么我们可以定义哪些损失函数呢?

为了训练模型,必须先定义衡量模型好与坏的标准。

在机器学习中,我们使用 loss / cost,即, 当前模型与理想模型的差距。

训练的目的,就是不断缩小 loss / cost.

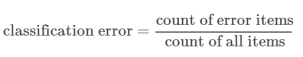

为什么不能用 classification error(分类错误率)?

大多数人望文生义的 loss,可能是这个公式。

我们来看 classification error 的弊端:

模型1: classification error = 1/3

模型2: classification error = 1/3

结论:

2个模型的 classification error 相等,但模型 2 要明显优于模型 1.

classification error 很难精确描述模型与理想模型之间的距离。

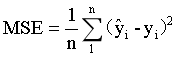

为什么不用 Mean Squared Error (均方误差)?

均方误差损失也是一种比较常见的损失函数,其定义为:

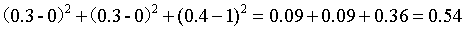

第一个模型第一项的 loss 是

第一个模型的MAE是

(0.54+0.54+1.34)/3=0.81

第二个模型的 loss 是

(0.14+0.14+0.74)/3=0.34

我们发现,MSE能够判断出来模型2优于模型1,那为什么不采用这种损失函数呢?主要原因是逻辑回归配合MSE损失函数时,采用梯度下降法进行学习时,会出现模型一开始训练时,学习速率非常慢的情况,而使用交叉熵作为损失函数则不会导致这样的情况发生。

有了上面的直观分析,我们可以清楚的看到,对于分类问题的损失函数来说,分类错误率和平方和损失都不是很好的损失函数,下面我们来看一下交叉熵损失函数的表现情况。

Cross Entropy Error Function(交叉熵损失函数)

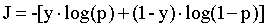

二分类

在二分的情况下,模型最后需要预测的结果只有两种情况,对于每个类别我们的预测得到的概率为p和1-p。此时表达式为:

其中:

- y——表示样本的label,正类为1,负类为0

- p——表示样本预测为正的概率

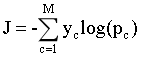

多分类

多分类的情况实际上就是对二分类的扩展:

其中:

- M——类别的数量;

- y——指示变量(0或1),如果该类别和样本的类别相同就是1,否则是0;

- p——对于观测样本属于类别c的预测概率。

现在我们利用这个表达式计算上面例子中的损失函数值:

根据公式, 第一个模型中第一项的 cross-entropy 是:

−((ln(0.3)∗0)+(ln(0.3)∗0)+(ln(0.4)∗1))=−ln(0.4)

所以,第一个模型的 ACE ( average cross-entropy error ) 是

−(ln(0.4)+ln(0.4)+ln(0.1))/3=1.38

第二个模型的 ACE 是:

(ln(0.7)+ln(0.7)+ln(0.3))/3=0.64

结论:

ACE 结果准确的体现了模型 2 优于模型 1。

cross-entropy 更清晰的描述了模型与理想模型的距离。

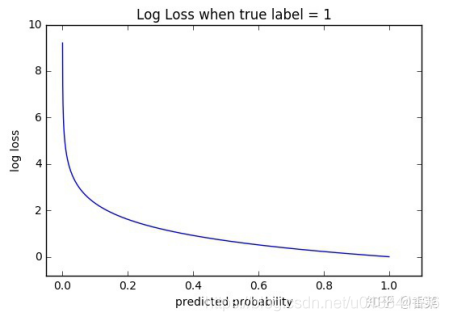

函数性质

可以看出,该函数是凸函数,求导时能够得到全局最优值。

导函数性质

交叉熵损失函数经常用于分类问题中,特别是在神经网络做分类问题时,也经常使用交叉熵作为损失函数,此外,由于交叉熵涉及到计算每个类别的概率,所以交叉熵几乎每次都和softmax函数一起出现。

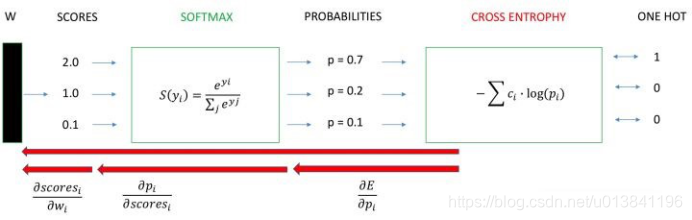

我们用神经网络最后一层输出的情况,来看一眼整个模型预测、获得损失和学习的流程:

1)神经网络最后一层得到每个类别的得分scores;

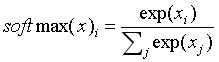

2)该得分经过softmax转换为概率输出;

3)模型预测的类别概率输出与真实类别的one hot形式进行cross entropy损失函数的计算。

在计算各个 label 概率的时候,用的是 softmax 函数。

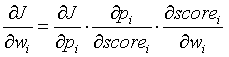

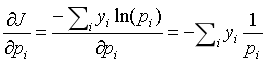

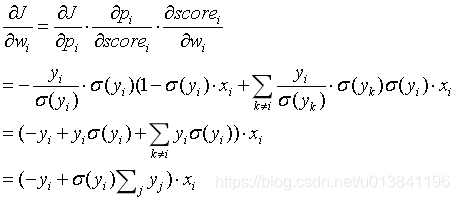

下面,我们来推导一下整个求导公式,我们将求导分成三个过程,即拆成三项偏导的乘积:

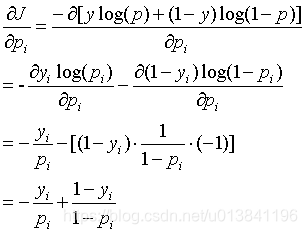

计算第一项:

通常以e为底。

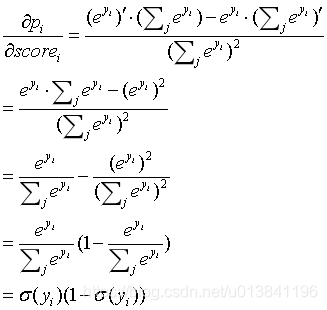

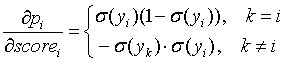

计算第二项:

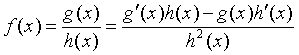

这一项要计算的是softmax函数对于score的导数,我们先回顾一下分数求导的公式:

考虑k等于i的情况:

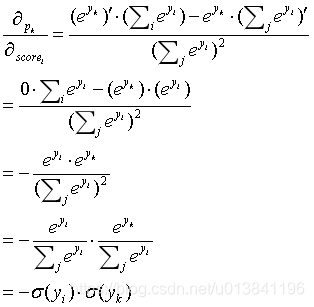

考虑k不等于i的情况:

综上可得softmax损失函数的求导结果:

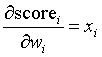

计算第三项:

一般来说,scores是输入的线性函数作用的结果,所以有:

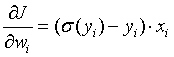

最后的结果看起来简单了很多,最后,针对分类问题,我们给定的结果yi最终只会有一个类别是1,其他类别都是0,因此,对于分类问题,这个梯度等于:

可以看到,我们得到了一个非常漂亮的结果,所以,使用交叉熵损失函数,不仅可以很好的衡量模型的效果,又可以很容易的的进行求导计算。

优点

在用梯度下降法做参数更新的时候,模型学习的速度取决于两个值:一、学习率;二、偏导值。其中,学习率是我们需要设置的超参数,所以我们重点关注偏导值。从上面的式子中,我们发现,偏导值的大小取决于

和

,我们重点关注后者,后者的大小值反映了我们模型的错误程度,该值越大,说明模型效果越差,但是该值越大同时也会使得偏导值越大,从而模型学习速度更快。所以,使用逻辑函数得到概率,并结合交叉熵当损失函数时,在模型效果差的时候学习速度比较快,在模型效果好的时候学习速度变慢。