Heute früh hat OpenAI die Schnittstelle zwischen ChαtGPTT und Whisper offiziell freigegeben, und Entwickler können jetzt die neueste Textgenerierung und Speech-to-Text-Funktionen über die API nutzen. Laut OpenAI wurden die Kosten von ChαtGPT durch eine Reihe von Optimierungen auf Systemebene seit Dezember letzten Jahres um 90 % gesenkt; jetzt nutzt OpenAI diese eingesparten Kosten zum Nutzen der Entwickler. Entwickler können jetzt große Whisper v2-Modelle über die API verwenden, was zu einer höheren Geschwindigkeit und Kosteneffizienz führt. Das ChαtGPT-Modell wird kontinuierlich aktualisiert und verbessert, und es werden dedizierte Kapazitäten für eine tiefere Steuerung des Modells bereitgestellt.

Artikelverzeichnis

ChatGPT-Schnittstelle

Modell

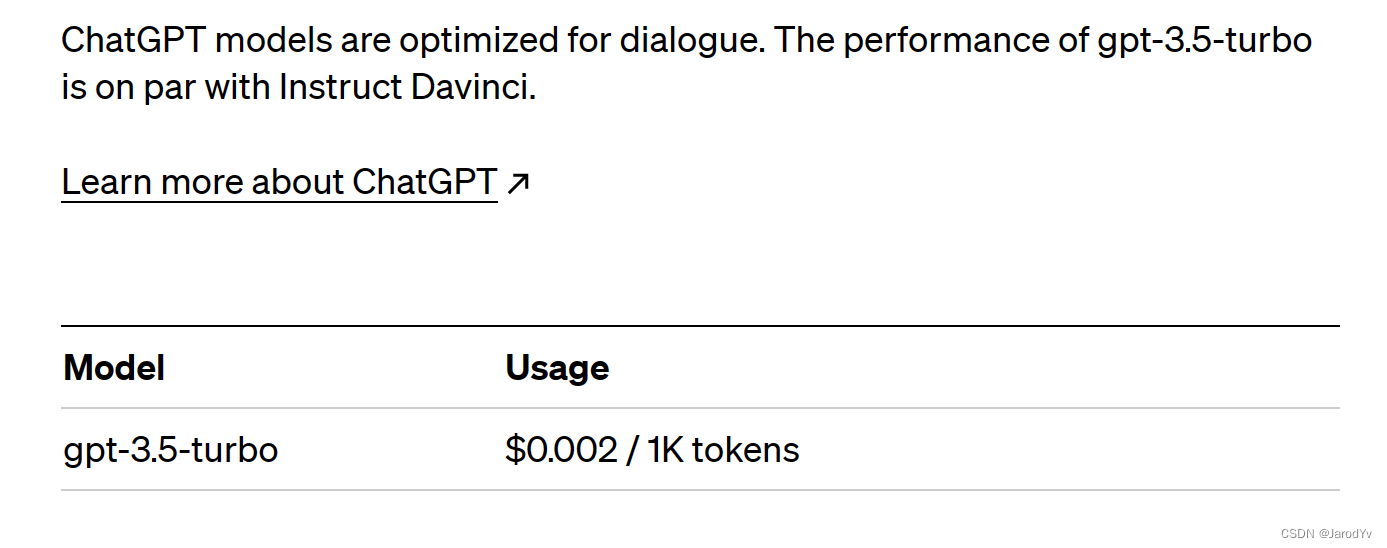

Der Name des von OpenAI veröffentlichten ChαtGPT-Modells lautet gpt-3.5-turbo, das gleiche Modell, das im ChαtGPT-Produkt verwendet wird. text-davinci-003Der Preis beträgt 0,002 $/1000 Token, was zehnmal billiger ist als zuvor . gpt-3.5-turboExpress-Erfahrung in Chat-Szenarien, und viele Nicht-Chat-Szenarioanwendungen können ebenfalls gut funktionieren, und Entwickler können mit minimalen Anpassungen vom Modell zum Modell text-davinci-003wechseln gpt-3.5-turbo.

OpenAI wird das ChαtGPT-Modell weiter verbessern, sodass gpt-3.5-turbodas Modell kontinuierlich aktualisiert wird (es wird im April auf die neueste stabile Version aktualisiert), und OpenAI empfiehlt Ihnen auch, gpt-3.5-turbodas Modell zu verwenden. Um den Anforderungen der Entwickler nach bestimmten Modellversionen gerecht zu werden, stellt OpenAI auch bestimmte Snapshot-Versionen bereit. Die derzeit verfügbare spezifische Snapshot-Version gpt-3.5-turbo-0301wird in den nächsten drei Monaten nicht aktualisiert und ist bis zum 1. Juni 2023 gültig.

| Modellname | beschreiben | maximale Anfrage | Trainingsdaten |

|---|---|---|---|

| gpt-3.5-turbo | Das leistungsstärkste GPT-3.5-Modell und speziell für Chat-Szenarien optimiert, zu nur 1/10 text-davinci-003der . Es wird iterativ aktualisiert. |

4.096 Token | Stand Juni 2021 |

| gpt-3.5-turbo-0301 | gpt-3.5-turboDie Snapshot-Version vom 1. März 2023 von . Dieses Modell wird innerhalb der nächsten 3 Monate nicht aktualisiert und die Gültigkeitsdauer endet am 1. Juni 2023. |

4.096 Token | Stand Oktober 2019 |

Schnittstelle

Aufgrund gpt-3.5-turbodes Szenendesigns zum Chatten hat eine kleine Änderung im Interfacedesign stattgefunden. In der GPT-3-Schnittstelle werden Fragen promptüber Felder übergeben, gpt-3.5-turboes gibt keine promptFelder, sondern messagesein Array. Das Folgende ist ein typisches Beispiel für einen Schnittstellenaufruf:

import openai

completion = openai.ChatCompletion.create(

model="gpt-3.5-turbo",

messages=[

{

"role": "system", "content": "你是一个聪明的助理"},

{

"role": "user", "content": "哪支球队赢得了2018世界杯?"},

{

"role": "assistant", "content": "法国国家男子足球队获得2018年俄罗斯世界杯。"},

{

"role": "user", "content": "决赛对手是谁?"}

]

)

print(completion)

Im obigen Beispielcode kapseln wir mehrere Gesprächsrunden in messageseinem Array, und jede Nachricht hat roleeine Summe content. roleDer optionale Wert von system, user, ist der assistantNachrichteninhalt content.

Typischerweise besteht das Format der Konversation systemzuerst aus Nachrichten, gefolgt von abwechselnden userNachrichten und assistantNachrichten.

systemNachrichten helfen, das Verhalten des Modells einzustellen. Im obigen Beispiel wird dem Modell gesagt: „Sie sind ein intelligenter Assistent“, das Modell spielt die Rolle eines Assistenten, und die Ausgabe ist so prägnant und klar wie ein Assistent.

userNachrichten helfen, das Modell zu führen. Dies kann entweder eine Benutzerfrage (normalerweise die letzte) oder eine Entwicklerdirektiveneinstellung oder kontextbezogene Eingabeaufforderung sein.

assistantNachrichten helfen, Kontext zu speichern. Es kann entweder die vorherige Ausgabe des Modells sein oder vom Entwickler geschrieben werden, um ein Beispiel für das gewünschte Verhalten zu geben.

Da das Modell keine Erinnerung an frühere Anfragen hat, müssen alle relevanten Informationen im Dialog bereitgestellt werden. Daher kann das Einbeziehen historischer Sitzungen dem Modell helfen, das Problem besser zu verstehen. Wenn es im obigen Beispiel keine Zwischennachricht userund assistantNeuigkeiten gibt, ist es für das Modell schwierig, eine richtige Antwort zu geben, wenn es alleine gefragt wird "Wer ist der Gegner im Finale?"

gpt-3.5-turboDas Format der zurückgegebenen Daten hat sich ebenfalls geringfügig geändert. Die Ausgabe der GPT-3-Schnittstelle ist in textFelder gekapselt, und gpt-3.5-turbodie Ausgabe der GPT-3-Schnittstelle ist in messageFelder gekapselt und besteht ebenfalls aus roleund content. Wir können completion['choices'][0]['message']['content']die Ausgabe einfach per erhalten.

Empfohlene Vorgehensweise

Da gpt-3.5-turbodie Leistung text-davinci-003ähnlich der des ist, der Preis aber text-davinci-0031/10 beträgt, wird es für die meisten Anwendungsfälle offiziell empfohlen gpt-3.5-turbo.

Für Entwickler gibt es nur sehr wenige Stellen, die geändert werden müssen, sie müssen nur das Format promptändern .messages

"prompt": "哪支球队赢得了2018世界杯?"

Ändern:

messages: [

{

"role": "system", "content": "你是一个聪明的助理"},

{

"role": "user", "content": "哪支球队赢得了2018世界杯?"}

]

oder einfacher stattdessen:

messages: [

{

"role": "user", "content": "哪支球队赢得了2018世界杯?"}

]

⚠Hinweis: gpt-3.5-turbo und gpt-3.5-turbo-0301 unterstützen keine Feinabstimmung.

Flüsterschnittstelle

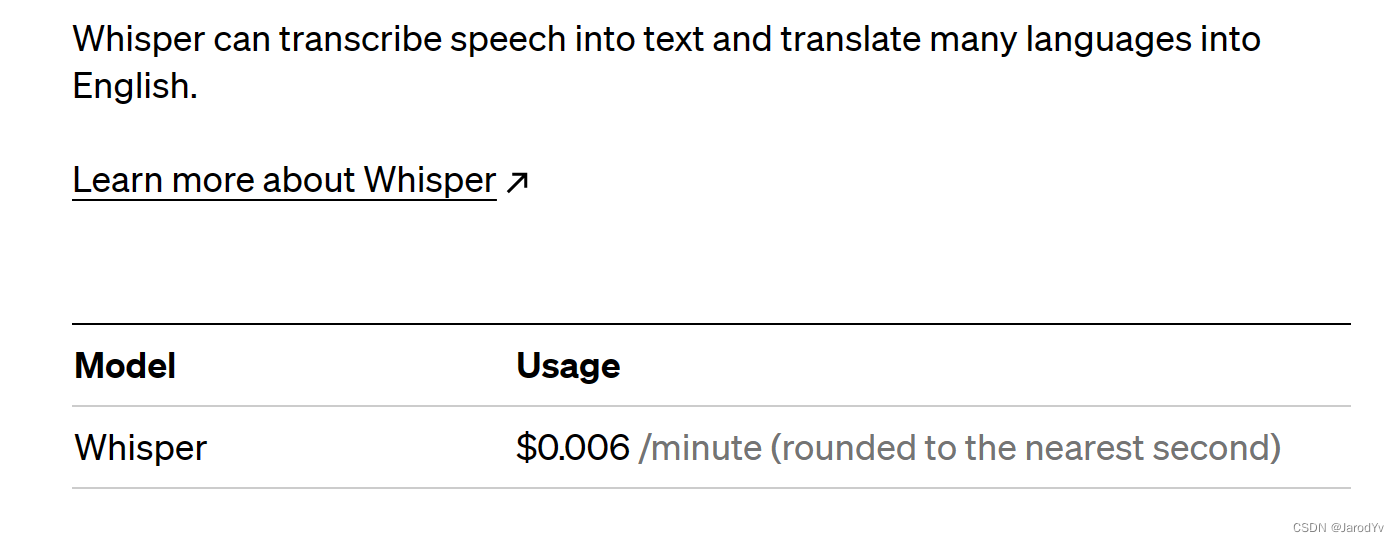

Whisper ist ein Speech-to-Text-Modell, das im September 2022 von OpenAI als Open Source bereitgestellt wurde. Nach seiner Einführung erhielt es großes Lob von der Entwickler-Community. Jetzt können wir das Whisper v2-Modell über die API zu einem Preis von 0,006 $/Minute aufrufen. Ein hochgradig optimierter Service-Stack stellt sicher, dass Whisper im Vergleich zu anderen Diensten eine schnellere Leistung bietet.

Whisper API bietet transcribeund translateSchnittstellen , unterstützt mehrere Audioformate (m4a, mp3, mp4, mpeg, mpga, wav, webm).

transkribieren

import openai

audio_file= open("/path/to/file/audio.mp3", "rb")

transcript = openai.Audio.transcribe("whisper-1", audio_file)

übersetzen

import openai

audio_file= open("/path/to/file/audio.mp3", "rb")

transcript = openai.Audio.translate("whisper-1", audio_file)

Whisper unterstützt derzeit Afrikaans, Arabisch, Armenisch, Aserbaidschanisch, Weißrussisch, Bosnisch, Bulgarisch, Katalanisch, Chinesisch, Kroatisch, Tschechisch, Dänisch, Niederländisch , Englisch, Estnisch, Finnisch, Französisch, Galizisch, Deutsch, Griechisch, Hebräisch, Hindi, Ungarisch, Isländisch , Indonesisch, Italienisch, Japanisch, Kannada, Kasachisch, Koreanisch, Lettisch-Litauisch, Mazedonisch, Malaiisch, Marathi, Maori, Nepali, Norwegisch, Persisch, Polnisch, Portugiesisch, Rumänisch, Russisch, Serbisch, Slowakisch, Slowenisch, Spanisch Suaheli, Schwedisch, Tagalog , Tamil, Thai, Türkisch, Ukrainisch, Urdu, Vietnamesisch und Walisisch.

Chinesisch unterstützen! Chinesisch unterstützen! Chinesisch unterstützen!