In diesem Artikel werden die Kernkonzepte, Tools und erweiterten Anwendungen der Container-Orchestrierungstechnologie umfassend untersucht, einschließlich wichtiger Plattformen wie Docker Compose und Kubernetes und ihrer erweiterten Funktionen wie Netzwerk- und Speicherverwaltung, Überwachung, Sicherheit usw. Darüber hinaus untersucht der Artikel Beispiele für praktische Anwendungen dieser Technologien und bietet Einblicke in zukünftige Trends.

Folgen Sie [TechLeadCloud], um umfassendes Wissen über Internetarchitektur und Cloud-Service-Technologie zu teilen. Der Autor verfügt über mehr als 10 Jahre Erfahrung in der Internetdienstarchitektur, in der Forschung und Entwicklung von KI-Produkten sowie in der Teamleitung. Er hat einen Master-Abschluss der Tongji-Universität der Fudan-Universität, ist Mitglied des Fudan Robot Intelligence Laboratory und ein von Alibaba Cloud zertifizierter leitender Architekt , ein Projektmanagement-Profi sowie Forschung und Entwicklung von KI-Produkten mit einem Umsatz von Hunderten von Millionen

1. Einführung in die Container-Orchestrierung

Die Container-Orchestrierung ist das Herzstück des modernen Cloud-nativen Anwendungsmanagements und umfasst die Automatisierung der Bereitstellung, Verwaltung, Skalierung und Netzwerkkonfiguration von Containern im großen Maßstab. Mit dem Aufstieg der Microservice-Architektur und der zunehmenden Komplexität von Anwendungen ist die Container-Orchestrierung zu einer Schlüsseltechnologie für ein effizientes, zuverlässiges und dynamisches Service-Management geworden.

Das Konzept und die Bedeutung der Container-Orchestrierung

Das Konzept der Container-Orchestrierung entsteht aus der Notwendigkeit, Hunderte oder Tausende von Containern auf einer großen Anzahl physischer oder virtueller Maschinen effektiv zu verwalten. Während Container selbst leichtgewichtig und schnell sind, ist die manuelle Verwaltung der Bereitstellung und des Lebenszyklus dieser Container in komplexen Produktionsumgebungen unpraktisch. Durch die Automatisierung dieser Prozesse bietet die Container-Orchestrierung mehrere wichtige Vorteile:

- Effiziente Ressourcennutzung : Durch intelligente Planung können Orchestrierungstools sicherstellen, dass Container auf dem am besten geeigneten Host ausgeführt werden, und die Ressourcennutzung optimieren.

- Schnelle Erweiterung und Wiederherstellung : Als Reaktion auf plötzliche Verkehrsspitzen oder Dienstausfälle kann die Container-Orchestrierung Dienste schnell erweitern oder neu bereitstellen.

- Automatisierung und Konsistenz : Orchestrierungstools gewährleisten die Konsistenz der Bereitstellung, reduzieren menschliche Fehler und machen den Bereitstellungsprozess automatisierter und wiederholbarer.

- Serviceerkennung und Lastausgleich : Netzwerkkonfiguration und Kommunikation zwischen Containern werden automatisch durch Orchestrierungstools verwaltet, wodurch die Gesamtleistung der Anwendung verbessert wird.

Der Entwicklungstrend der Container-Orchestrierung

In den letzten Jahren hat sich die Container-Orchestrierung mit der rasanten Entwicklung der Technologie von der anfänglichen Automatisierung einzelner Dienste zu einer umfassenden Lösung entwickelt, die komplexe Anwendungen unterstützt. Kubernetes unterstützt beispielsweise nicht nur die grundlegende Bereitstellung und Erweiterung, sondern stellt auch ein Service Mesh (wie Istio) bereit, um komplexe Kommunikations- und Sicherheitsanforderungen zwischen Microservices zu unterstützen. Darüber hinaus nutzt der Aufstieg von GitOps das Git-Repository als Quelle der Wahrheit für die Anwendungsbereitstellung, wodurch die Container-Orchestrierung transparenter und einfacher zu verwalten wird.

Praktische Anwendungsfälle der Container-Orchestrierung

In praktischen Anwendungen ist die Container-Orchestrierung zum Grundstein vieler erfolgreicher Projekte geworden. Beispielsweise nutzt die Containerisierungsplattform Spinnaker von Netflix die Container-Orchestrierungstechnologie, um ihre riesige Microservice-Architektur zu unterstützen und so eine schnelle Servicebereitstellung und ein effizientes Ressourcenmanagement zu erreichen. Im Finanzbereich verwaltet Goldman Sachs sein Handelssystem über Kubernetes, was nicht nur die Stabilität des Systems verbessert, sondern auch die Einführung neuer Funktionen beschleunigt.

2. Übersicht über Container-Orchestrierungstools

Im Bereich der Container-Orchestrierung sind mehrere wichtige Tools und Plattformen zu Industriestandards geworden. Diese Tools bieten nicht nur grundlegende Containerverwaltungsfunktionen, sondern führen auch erweiterte Funktionen wie automatische Skalierung, Serviceerkennung und Selbstheilungsfunktionen ein. Wir werden einige der wichtigsten Tools erkunden: Docker Compose, Kubernetes und Docker Swarm und ihre grundlegenden Konzepte, Funktionen und anwendbaren Szenarien verstehen.

Docker Compose

Docker Compose ist ein Tool zum Definieren und Ausführen von Docker-Anwendungen mit mehreren Containern. Über Compose können Benutzer YAML-Dateien zum Konfigurieren von Anwendungsdiensten verwenden. Anschließend können alle Dienste mit nur einem einfachen Befehl erstellt und gestartet werden. Docker Compose eignet sich besonders für Entwicklungsumgebungen und kleine Projekte, da es den Prozess der Erstellung und Verwaltung von Multi-Container-Anwendungen vereinfacht.

Merkmale

- Einfach zu verwenden : Verwalten Sie die gesamten Dienste der Anwendung über eine YAML-Datei.

- Entwicklungsfreundlich : geeignet für schnelle Bereitstellung und Tests in einer Entwicklungsumgebung.

- Leicht : Keine zusätzliche Infrastruktur oder komplexe Konfiguration erforderlich.

Anwendungen

Ein Entwicklungsteam kann beispielsweise Docker Compose verwenden, um seine lokale Entwicklungsumgebung einzurichten, einschließlich Anwendungsservern, Datenbanken und Caching-Diensten. Dies ermöglicht dem gesamten Team, in einer einheitlichen Umgebung zu arbeiten, wodurch die „Es funktioniert einfach auf meinem Rechner“-Probleme reduziert werden.

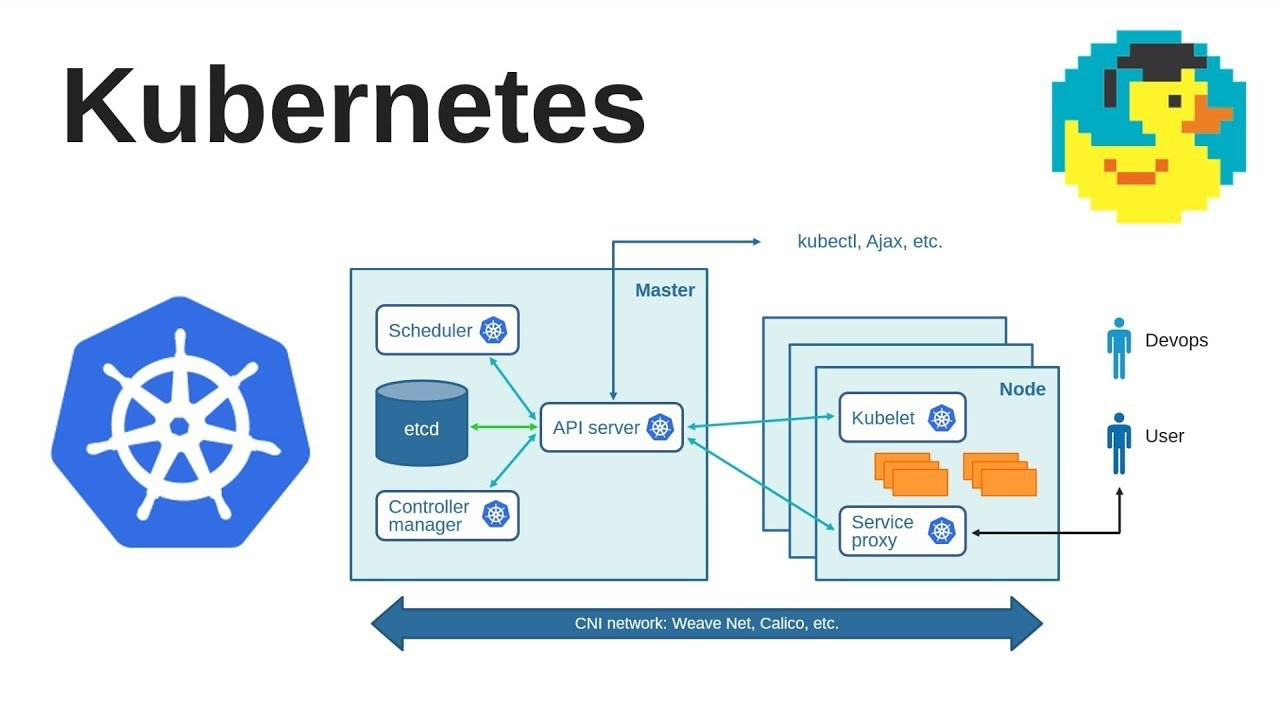

Kubernetes

Kubernetes (K8s) ist derzeit das beliebteste Open-Source-Container-Orchestrierungssystem für die automatische Bereitstellung, Skalierung und Verwaltung von Containeranwendungen. Entwickelt von Google und verwaltet von der Cloud Native Computing Foundation (CNCF).

Kubernetes (K8s) ist derzeit das beliebteste Open-Source-Container-Orchestrierungssystem für die automatische Bereitstellung, Skalierung und Verwaltung von Containeranwendungen. Entwickelt von Google und verwaltet von der Cloud Native Computing Foundation (CNCF).

Merkmale

- Hoch skalierbar : Kann große Containerbereitstellungen verwalten.

- Robustes Ökosystem : Unterstützt eine Vielzahl von Workload-Typen, Serviceerkennung und Lastausgleich.

- Automatisierter Betrieb und Wartung : einschließlich automatischer Erweiterung, Selbstheilung und fortlaufender Updates.

Anwendungen

Weltweit nutzen viele große Unternehmen wie Spotify, Huawei und IBM Kubernetes zur Unterstützung ihrer Produktionsumgebungen. Kubernetes verbessert nicht nur die Betriebs- und Wartungseffizienz dieser Unternehmen, sondern bietet ihnen auch eine beispiellose Systemstabilität und Skalierbarkeit.

Docker-Schwarm

Docker Swarm ist das native Cluster-Management-Tool von Docker. Es verwendet die Docker-API, sodass Benutzer, die bereits mit Docker vertraut sind, den Einstieg und die Verwendung von Swarm einfach finden werden.

Merkmale

- Docker nativ : Eng in das Docker-Ökosystem integriert.

- Einfach und benutzerfreundlich : Für kleine bis mittelgroße Projekte bietet Swarm genügend Funktionen.

- Leicht : Keine zusätzliche Installation erforderlich, nur Docker.

Anwendungen

Docker Swarm bietet eine ideale Option für Teams, die Docker bereits verwenden und eine einfachere Lösung benötigen, um ihre Anwendungen auf mehrere Hosts zu skalieren. Beispielsweise kann ein kleines bis mittleres Unternehmen Swarm verwenden, um mehrere seiner Dienste zu verwalten, ohne mehr Ressourcen in das Erlernen und Bereitstellen von Kubernetes zu investieren.

3. Komplettlösung für Docker Compose

Docker Compose ist ein Tool zum Definieren und Ausführen von Docker-Anwendungen mit mehreren Containern. Es ermöglicht Benutzern die deklarative Definition von Diensten, Netzwerken und Volumes mithilfe von YAML-Dateien, um Anwendungen in einer Docker-Umgebung einfach zu erstellen, zu testen und bereitzustellen.

Grundkonzepte von Docker Compose

1. Dienst

- Definition : Service ist das Kernkonzept in Docker Compose, das die Komponenten einer Anwendung darstellt (z. B. Datenbank, Frontend, Backend).

- Funktionen : Jeder Dienst kann seine Container-Images, Port-Zuordnungen, Volume-Mounts und Abhängigkeiten definieren.

2. Netzwerk

- Definition : Compose ermöglicht die Definition von Netzwerken, um die Kommunikation zwischen Containern zu implementieren.

- Merkmale : Unterstützt verschiedene Netzwerktypen wie Bridged- oder Overlay-Netzwerke, um Isolation und sichere Kommunikation zwischen Containern zu gewährleisten.

3. Lautstärke

- Definition : Volumes werden für die Datenpersistenz und -freigabe verwendet.

- Funktionen : Kann von mehreren Containern gemeinsam genutzt und zum Speichern von Datenbankdateien, Konfigurationsdateien usw. verwendet werden.

Docker Compose-Dateistruktur

YAML-Dateien sind der Kern von Docker Compose und definieren alle relevanten Dienst-, Netzwerk- und Volume-Konfigurationen.

Beispiel

version: "3.9" # 使用的Compose文件版本

services:

web:

image: "my-web-app:latest" # 定义使用的镜像

ports:

- "5000:5000" # 端口映射

networks:

- webnet # 网络配置

redis:

image: "redis:alpine"

networks:

- webnet

networks:

webnet:

Erweiterte Funktionen

1. Serviceerweiterung (Skala)

- Beschreibung : Erhöhen oder verringern Sie automatisch die Anzahl der Instanzen des Dienstes.

- Zweck : Dynamische Skalierung von Dienstinstanzen, um die Last in Zeiten mit hohem Datenverkehr zu bewältigen.

2. Gesundheitscheck

- Beschreibung : Überwachen Sie den Ausführungsstatus des Dienstes.

- Zweck : Stellen Sie den normalen Betrieb des Dienstes sicher und starten Sie ausgefallene Instanzen automatisch neu.

3. Umgebungsvariablen

- Beschreibung : Umgebungsvariablen festlegen und verwalten, wenn der Dienst ausgeführt wird.

- Zweck : Datenbankverbindungen, API-Schlüssel und andere vertrauliche Informationen konfigurieren.

Docker Compose in praktischen Anwendungen

In der Microservice-Architektur wird Docker Compose häufig in lokalen Entwicklungs- und Testumgebungen verwendet. Entwickler können damit Produktionsumgebungen lokal replizieren und so sicherstellen, dass jede Komponente der Anwendung in einer isolierten und konsistenten Umgebung ausgeführt wird.

Anwendungsbeispiele

Angenommen, ein Team entwickelt eine Webanwendung, die ein Front-End, ein Back-End und eine Datenbank umfasst. Mithilfe von Docker Compose können sie drei Dienste definieren: eine Node.js-Anwendung für das Frontend, eine Python-API für das Backend und eine PostgreSQL-Datenbank. Jeder Dienst kann in einem eigenen dedizierten Container ausgeführt werden und über ein definiertes Netzwerk miteinander kommunizieren. Auf diese Weise kann das gesamte Team mit derselben Konfiguration arbeiten, wodurch Probleme aufgrund von Umgebungsunterschieden reduziert werden.

Zusammenfassen

Docker Compose bietet ein einfaches, aber leistungsstarkes Tool zum Verwalten und Orchestrieren von Multi-Container-Anwendungen. Aufgrund seiner Benutzerfreundlichkeit und Flexibilität eignet es sich ideal für Entwicklungs- und kleine Bereitstellungsumgebungen. Durch den Erwerb eines umfassenden Verständnisses der verschiedenen Funktionen und Best Practices von Compose können Entwicklungsteams ihre Entwicklungseffizienz und Anwendungsqualität erheblich verbessern.

4. Komplettlösung für Kubernetes

Kubernetes, allgemein bekannt als K8s, ist derzeit die beliebteste Open-Source-Container-Orchestrierungsplattform. Es bietet ein robustes Framework für die Automatisierung der Bereitstellung, Skalierung und Verwaltung von Containeranwendungen.

Kernkonzepte von Kubernetes

1. Pod

- Definition : Pod ist die kleinste bereitstellbare Einheit in Kubernetes und enthält normalerweise einen oder mehrere Container.

- Funktionen : Container im Pod teilen sich Speicher, Netzwerk und laufende Konfiguration.

2. Service

- Definition : Ein Dienst ist eine abstrakte Möglichkeit, zu definieren, wie auf eine Reihe von Pods mit derselben Funktionalität zugegriffen wird.

- Funktionen : Gewährleisten Sie die Stabilität des Netzwerkzugriffs und den Lastausgleich.

3. Bereitstellung

- Definition : Die Bereitstellung bietet deklarative Aktualisierungsfunktionen für Pods und ReplicaSets (Sammlungen von Pods).

- Funktionen : Unterstützt fortlaufende Updates und Versions-Rollback.

Architekturkomponenten von Kubernetes

1. Kontrollebene

- Funktion : Clusterstatus verwalten, z. B. Planung, Reaktion auf Pod-Lebenszyklusereignisse usw.

- Komponenten : einschließlich API-Server, Scheduler, Controller-Manager usw.

2. Knoten

- Funktion : Anwendungscontainer ausführen.

- Komponenten : einschließlich Kubelet, Kube-Proxy und Container-Laufzeit.

3. Lagerung

- Funktion : Bereitstellung einer dauerhaften Speicherlösung.

- Komponenten : Unterstützt mehrere Speicheroptionen, z. B. lokaler Speicher, öffentlicher Cloud-Speicher usw.

Erweiterte Funktionen von Kubernetes

1. Automatische Skalierung

- Beschreibung : Erhöhen oder verringern Sie die Anzahl der Pods automatisch je nach Auslastung.

- Anwendung : Stellen Sie die Anwendungsleistung und Kosteneffizienz unter verschiedenen Lasten sicher.

2. Diensterkennung und Lastausgleich

- Beschreibung : Konfigurieren Sie das Netzwerk automatisch, damit Dienste sich gegenseitig erkennen und einen Lastausgleich durchführen können.

- Anwendung : Vereinfacht die Komplexität der Kommunikation zwischen Diensten in der Microservice-Architektur.

3. Automatisierte Bereitstellung und Rollback

- Beschreibung : Verwalten Sie die Anwendungsbereitstellung und das Rollback automatisch durch deklarative Konfiguration.

- Anwendung : Verbessern Sie die Zuverlässigkeit und Häufigkeit der Bereitstellung und verringern Sie das Risiko eines Bereitstellungsfehlers.

Kubernetes in realen Anwendungen

Kubernetes ist zum De-facto-Standard für Microservice-Architekturen geworden. Es unterstützt Anwendungen jeder Größe, vom kleinen Start-up bis zum Großunternehmen.

Anwendungsbeispiele

Angenommen, eine Online-Einzelhandelsplattform muss ihre zahlreichen Mikrodienste verwalten (z. B. Bestellabwicklung, Zahlungsabwicklung, Benutzerauthentifizierung usw.). Mithilfe von Kubernetes können diese Dienste als unabhängige Pods oder Bereitstellungen bereitgestellt und über Dienste miteinander verbunden werden. Wenn die Anzahl der Benutzer wächst, kann Kubernetes Dienste automatisch skalieren, um die Zuverlässigkeit und Leistung der Anwendung sicherzustellen.

Zukünftige Trends von Kubernetes

Kubernetes entwickelt sich weiter und integriert mehr Cloud-native Technologien wie Service Grid, serverlose Architektur usw. In Zukunft könnte Kubernetes die Komplexität der Anwendungsbereitstellung und -verwaltung weiter vereinfachen und es nicht nur zu einem Container-Orchestrierungstool, sondern zum Kern des gesamten Cloud-nativen Anwendungsökosystems machen.

5. Fortschrittliche Container-Orchestrierungstechnologie

Im modernen Container-Ökosystem werden mit zunehmender Anwendungs- und Bereitstellungskomplexität fortschrittliche Container-Orchestrierungstechnologien zu einem integralen Bestandteil. Diese Technologien verbessern nicht nur die Effizienz und Flexibilität des Containermanagements, sondern gewährleisten auch die Zuverlässigkeit und Sicherheit des Systems.

Netzwerk Management

Das Container-Netzwerkmanagement ist ein wichtiger Teil der Gewährleistung einer korrekten und sicheren Kommunikation zwischen Containern. In komplexen Containerumgebungen umfasst das Netzwerkmanagement unter anderem die folgenden Aspekte:

1. Netzwerkmodell

- Konzept : Das Container-Netzwerkmodell definiert, wie Container im Netzwerk interagieren.

- Technologie : Wie CNI (Container Network Interface), Flannel, Calico.

2. Servicenetz

- Konzept : Service Grid verwaltet die Kommunikation zwischen Microservices und bietet Funktionen wie Lastausgleich und Serviceerkennung.

- Technologie : Wie Istio, Linkerd.

- Anwendung : Service Mesh macht komplexe Kommunikation zwischen Microservices transparent und kontrollierbar.

Speicherverwaltung

Bei der Container-Orchestrierung sorgt das Speichermanagement für Datenpersistenz und -konsistenz. Zu den fortschrittlichen Speicherverwaltungstechnologien gehören:

1. Permanente Speicherung

- Konzept : Bereitstellung dauerhafter Speicherlösungen für Container.

- Technologie : Beispielsweise die Anwendung von Persistent Volumes (PV) und Persistent Volume Claims (PVC) in Kubernetes.

2. Speicherorchestrierung

- Konzept : Automatische Verwaltung der Zuweisung und des Lebenszyklus von Speicherressourcen.

- Technologie : Wie Rook, Portworx.

Containerüberwachung und Protokollverwaltung

Um den Zustand und die Leistung Ihrer Containerumgebung sicherzustellen, sind Überwachung und Protokollverwaltung unerlässlich.

1. Überwachung

- Konzept : Echtzeitüberwachung von Container- und Cluster-Leistungsmetriken.

- Werkzeuge : wie Prometheus, Grafana.

2. Protokollverwaltung

- Konzept : Containerprotokolle zentral sammeln, speichern und analysieren.

- Tools : wie ELK Stack (Elasticsearch, Logstash, Kibana), Fluentd.

Containersicherheit

Containersicherheit ist ein wichtiger und wachsender Bereich von Interesse bei der Container-Orchestrierung, einschließlich:

1. Container-Sicherheitsscan

- Konzept : Erkennen von Sicherheitslücken in Container-Images.

- Tools : wie Clair, Trivy.

2. Laufzeitsicherheit

- Konzept : Schutz laufender Container vor Angriffen.

- Tools : Wie Falco, Sysdig.

Automatisierung und richtliniengesteuertes Management

Die automatisierte und richtliniengesteuerte Verwaltung der Container-Orchestrierung sorgt für ein höheres Maß an Kontrolle und Effizienz.

1. Automatisierte Bereitstellung

- Technologie : wie GitOps, das das Git-Repository als einzige Quelle der Wahrheit nutzt, um eine automatisierte Anwendungsbereitstellung zu erreichen.

2. Richtliniengesteuertes Management

- Technologie : Wie OPA (Open Policy Agent), das eine einheitliche Richtlinienausführung für Cloud-native Umgebungen bietet.

Folgen Sie [TechLeadCloud], um umfassendes Wissen über Internetarchitektur und Cloud-Service-Technologie zu teilen. Der Autor verfügt über mehr als 10 Jahre Erfahrung in der Internetdienstarchitektur, in der Forschung und Entwicklung von KI-Produkten sowie in der Teamleitung. Er hat einen Master-Abschluss der Tongji-Universität der Fudan-Universität, ist Mitglied des Fudan Robot Intelligence Laboratory und ein von Alibaba Cloud zertifizierter leitender Architekt , ein Projektmanagement-Profi sowie Forschung und Entwicklung von KI-Produkten mit einem Umsatz von Hunderten von Millionen

Das erste große Versionsupdate von JetBrains 2024 (2024.1) ist Open Source. Sogar Microsoft plant, dafür zu bezahlen. Warum steht es immer noch in der Kritik? [Wiederhergestellt] Tencent Cloud-Backend stürzte ab: Viele Servicefehler und keine Daten nach der Anmeldung an der Konsole. Deutschland muss auch 30.000 PCs von Windows auf Linux Deepin-IDE migriert haben Bootstrapping! Visual Studio Code 1.88 wurde veröffentlicht. Tencent hat Switch wirklich in eine „denkende Lernmaschine“ verwandelt. Der auf SQLite basierende Web-Client WCDB hat ein umfangreiches Upgrade erhalten.Wenn es hilft, schenken Sie TeahLead KrisChang bitte mehr Aufmerksamkeit, mehr als 10 Jahre Erfahrung in der Internet- und Künstliche-Intelligenz-Branche, mehr als 10 Jahre Erfahrung im technischen und geschäftlichen Teammanagement, Bachelor-Abschluss in Software-Engineering von Tongji, Master-Abschluss in Engineering Management aus Fudan, Alibaba Cloud-zertifizierter Senior-Architekt für Cloud-Dienste, Leiter des KI-Produktgeschäfts mit einem Umsatz von über 100 Millionen.