18.–20. August 2023, Park Plaza Hotel, Peking

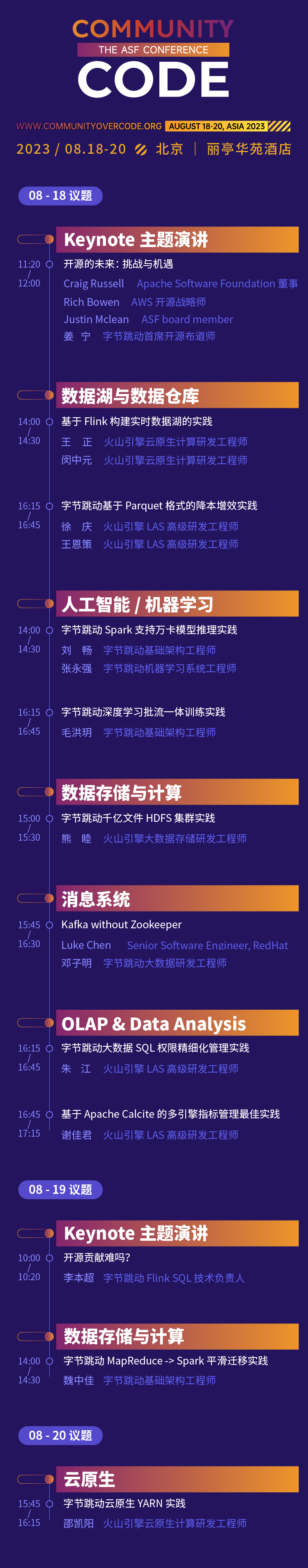

Der erste China-Offline-Gipfel der offiziellen globalen Konferenzreihe der Apache Software Foundation, CommunityOverCode Asia (ehemals ApacheCon Asia), findet vom 18. bis 20. August 2023 im Park Plaza Hotel in Peking statt. Die Konferenz umfasst 17 Forumsanweisungen und Hunderte von aktuellen Themen.

Die Open-Source-Erfahrung von ByteDance hat verschiedene Phasen durchlaufen: „Die Nutzung von Open Source, die Teilnahme an Open Source und das Ergreifen der Initiative für Open Source.“ Seine Haltung gegenüber Open Source war immer offen und ermutigend. Bei diesem CommunityOverCode Asia-Gipfel werden 15 Studenten von Byte die praktischen Erfahrungen von Apache-Open-Source-Projekten im Geschäft von ByteDance rund um 10 Themen unter 6 Themen teilen, und ein Apache Calcite PMC-Mitglied wird in der Grundsatzrede dabei sein. Ich freue mich darauf, meine Erfahrungen und Gewinne zu teilen durch die Teilnahme an Open-Source-Beiträgen mit Teilnehmern vor Ort.

Keynote-Rede: Ist es schwierig, zu Open Source beizutragen?

Vielleicht haben viele Studenten darüber nachgedacht, an einigen Open-Source-Beiträgen teilzunehmen, um ihre technischen Fähigkeiten und ihren Einfluss zu verbessern. Aber zwischen Idealen und Realität besteht meist eine gewisse Distanz: Weil ich bei der Arbeit zu beschäftigt bin und keine Zeit habe, mich zu beteiligen; die Hemmschwelle für Open-Source-Projekte ist zu hoch und ich weiß nicht, wie ich anfangen soll; ich habe einige Beiträge ausprobiert; , aber die Community-Reaktion ist nicht hoch und ich habe nicht durchgehalten. In dieser Keynote wird Li Benchao seine eigenen Erfahrungen kombinieren, um einige Kurzgeschichten und Gedanken über seinen Beitrag zur Open-Source-Community zu teilen, wie man diese Schwierigkeiten überwindet, endlich Durchbrüche in der Open-Source-Community erzielt und ein Gleichgewicht zwischen Arbeit und Offenheit schafft Quellenbeitrag.

Li Benchao

Technischer Direktor von ByteDance Flink SQL

Apache Calcite PMC-Mitglied, Apache Flink Committer, Absolvent der Peking-Universität, arbeitet derzeit im ByteDance-Streaming-Computing-Team und ist der technische Leiter von Flink SQL.

Grundsatzrede

Thema: Data Lakes und Data Warehouses

Die Praxis, einen Echtzeit-Datensee auf Basis von Flink aufzubauen

Echtzeit-Data Lakes sind eine Kernkomponente moderner Datenarchitekturen und ermöglichen es Unternehmen, große Datenmengen in Echtzeit zu analysieren und abzufragen. In diesem Austausch werden wir zunächst die aktuellen Schwachstellen von Echtzeit-Datenseen vorstellen, wie z. B. die hohe Aktualität, Vielfalt, Konsistenz und Genauigkeit von Daten. Anschließend stellen wir vor, wie wir einen Echtzeit-Datensee basierend auf Flink und Iceberg aufbauen, hauptsächlich anhand der folgenden zwei Teile: Wie man Daten in Echtzeit in den See einfügt und wie man mit Flink OLAP-Ad-hoc-Abfragen durchführt. Lassen Sie uns abschließend einige praktische Vorteile von ByteDance im Echtzeit-Data-Lake vorstellen.

Wang Zheng

Forschungs- und Entwicklungsingenieur für Cloud Native Computing bei Volcano Engine

Kam 2021 zu ByteDance und arbeitete im Infrastruktur-Open-Platform-Team, hauptsächlich verantwortlich für die Forschung und Entwicklung von Serverless Flink und anderen Richtungen.

Min Zhongyuan

Forschungs- und Entwicklungsingenieur für Cloud Native Computing bei Volcano Engine

Kam 2021 zu ByteDance und arbeitet im Team für offene Infrastrukturplattformen, hauptsächlich verantwortlich für die Forschung und Entwicklung von Serverless Flink, Flink OLAP und anderen Richtungen.

ByteDances Praxis der Kostensenkung und Effizienzsteigerung basierend auf dem Parquet-Format

Das Offline-Data-Warehouse von ByteDance verwendet standardmäßig das Parquet-Format zur Datenspeicherung. Bei der geschäftlichen Nutzung traten jedoch damit verbundene Probleme auf, wie z. B. zu viele kleine Dateien und hohe Datenspeicherkosten. Um das Problem zu vieler kleiner Dateien anzugehen, besteht die bestehende technische Lösung im Allgemeinen darin, mehrere kleine Parquet-Dateien über Spark zu lesen, die Daten dann erneut auszugeben und in einer oder mehreren großen Dateien zusammenzuführen. Für das Problem übermäßiger Speicherkosten verfügen Offline-Data Warehouses derzeit nur über TTL-Lösungen auf Partitionsebene, wenn Sie detaillierte Felddaten (TTL auf Spaltenebene) löschen müssen, die in der Partition nicht mehr verwendet werden und einen großen Teil davon ausmachen Im Verhältnis dazu müssen Sie die Daten über Spark lesen und die zu löschenden Felder überschreiben, indem Sie sie auf NULL setzen. Unabhängig davon, ob es sich um das Zusammenführen kleiner Dateien oder um TTL auf Spaltenebene handelt, gibt es eine große Anzahl von Überschreibvorgängen für Parquet-Datendateien. Da das Parquet-Format über spezielle Codierungsregeln verfügt, sind zum Lesen und Schreiben von Daten in Parquet eine Reihe von Vorgängen wie spezielle (De-)Serialisierung, (De-)Komprimierung und (De-)Codierung erforderlich. In diesem Prozess sind Vorgänge wie Kodierung, Dekodierung und Dekomprimierung CPU-intensive Berechnungen, die eine große Menge an Rechenressourcen verbrauchen. Um die Effizienz des Überschreibens von Dateien im Parquet-Format zu verbessern, haben wir die Definition des Parquet-Dateiformats eingehend untersucht und die binäre Kopiermethode verwendet, um den Datenüberschreibvorgang zu optimieren und redundante Vorgänge wie Codierung und Decodierung beim normalen Überschreiben zu überspringen Die Effizienz beim Überschreiben von Dateien wird erheblich verbessert und die Leistung ist mehr als zehnmal so hoch wie bei herkömmlichen Überschreibmethoden. Um die Benutzerfreundlichkeit zu verbessern, stellen wir außerdem eine neue SQL-Syntax bereit, die Benutzern dabei hilft, Vorgänge wie das Zusammenführen kleiner Dateien und TTL auf Spaltenebene bequem durchzuführen.

Xu Qing

Volcano Engine LAS Leitender Forschungs- und Entwicklungsingenieur

Er beschäftigt sich seit vielen Jahren mit der Forschung und Entwicklung von Big-Data-bezogenen Komponenten wie Hive Metastore, SparkSQL, Hudi usw.

Wang Ence

Volcano Engine LAS Leitender Forschungs- und Entwicklungsingenieur

Verantwortlich für das Design und die Entwicklung der verteilten Big-Data-Computing-Engine von ByteDance, die dem Unternehmen hilft, hochwertige Informationen aus riesigen Datenmengen zu extrahieren.

Thema: Künstliche Intelligenz/Maschinelles Lernen

ByteDance Deep Learning Batch-Stream integrierte Trainingspraxis

Mit der Geschäftsentwicklung des Unternehmens nimmt die Komplexität der Algorithmen weiter zu, und immer mehr Algorithmusmodelle erforschen Echtzeittraining auf der Grundlage von Offline-Updates, um die Modelleffekte zu verbessern. Um eine flexible Anordnung und freie Umschaltung komplexer Offline- und Echtzeitschulungen zu erreichen und Offline-Rechnerressourcen in einem größeren Bereich zu planen, tendiert das Modelltraining für maschinelles Lernen dazu, nach und nach Batch und Stream zu integrieren. Dieses Mal werden wir das maschinelle Lernen von ByteDance teilen Trainingsplanung Einige Inhalte umfassen die architektonische Entwicklung des Frameworks, die Praxis der Batch-Stream-Integration, heterogenes elastisches Training usw. Der Schwerpunkt liegt auch auf der praktischen Erfahrung der mehrstufigen Hybrid-Orchestrierung mit mehreren Datenquellen, der globalen Mischung von Streaming-Beispielen, der Full-Link-Nativeisierung und den Einblicken in Trainingsdaten im MFTC-Szenario (Batch-Stream Integrated Collaborative Training).

Mao Hongyue

ByteDance-Infrastrukturingenieur

Kam 2022 zu ByteDance und beschäftigt sich mit der Forschung und Entwicklung von maschinellem Lernen. Er ist hauptsächlich für die groß angelegte Cloud-native Batch-Stream-integrierte KI-Modell-Trainings-Engine verantwortlich, die Unternehmen wie Douyin-Videoempfehlungen, Toutiao-Empfehlungen und Pangolin-Werbung unterstützt. Qianchuan grafische Werbung und andere Unternehmen.

ByteDance Spark unterstützt die Inferenzpraxis des Wanka-Modells

Mit der Geschäftsentwicklung des Unternehmens nimmt die Komplexität der Algorithmen weiter zu, und immer mehr Algorithmusmodelle erforschen Echtzeittraining auf der Grundlage von Offline-Updates, um die Modelleffekte zu verbessern. Um eine flexible Anordnung und freie Umschaltung komplexer Offline- und Echtzeitschulungen zu erreichen und Offline-Rechnerressourcen in einem größeren Bereich zu planen, tendiert das Modelltraining für maschinelles Lernen dazu, nach und nach Batch und Stream zu integrieren. Dieses Mal werden wir das maschinelle Lernen von ByteDance teilen Trainingsplanung Einige Inhalte umfassen die architektonische Entwicklung des Frameworks, die Praxis der Batch-Stream-Integration, heterogenes elastisches Training usw. Der Schwerpunkt liegt auch auf der praktischen Erfahrung der mehrstufigen Hybrid-Orchestrierung mit mehreren Datenquellen, der globalen Mischung von Streaming-Beispielen, der Full-Link-Nativeisierung und den Einblicken in Trainingsdaten im MFTC-Szenario (Batch-Stream Integrated Collaborative Training).

Liu Chang

ByteDance-Infrastrukturingenieur

Kam 2020 zu ByteDance und arbeitet im Infrastruktur-Batch-Computing-Team. Er ist hauptsächlich für die Entwicklung von Spark Cloud Native und Spark On Kubernetes verantwortlich.

Zhang Yongqiang

ByteDance-Systemingenieur für maschinelles Lernen

Kam 2022 zu ByteDance, arbeitete im AML-Systemteam für maschinelles Lernen und beteiligte sich am Aufbau einer groß angelegten Plattform für maschinelles Lernen.

Spezialthema: Datenspeicherung und Datenverarbeitung

Bytedance MapReduce -> Spark reibungslose Migrationspraxis

Mit der Geschäftsentwicklung führt ByteDance täglich etwa 1,2 Millionen Spark-Jobs online aus. Im Gegensatz dazu sind täglich immer noch etwa 20.000 bis 30.000 MapReduce-Aufgaben online. Als Batch-Verarbeitungs-Framework mit langer Geschichte ist der Betrieb und die Wartung der MapReduce-Engine aus Sicht der Big-Data-Forschung und -Entwicklung mit einer Reihe von Problemen konfrontiert. Beispielsweise ist der ROI der Framework-Update-Iteration gering, die Anpassungsfähigkeit an das neue Computing-Scheduling-Framework schlecht und so weiter. Aus Anwendersicht gibt es auch eine Reihe von Problemen bei der Verwendung der MapReduce-Engine. Beispielsweise ist die Rechenleistung schlecht und es sind zusätzliche Pipeline-Tools erforderlich, um seriell laufende Jobs zu verwalten. Sie möchten Spark migrieren, es gibt jedoch eine große Anzahl vorhandener Jobs und eine große Anzahl von Jobs verwendet verschiedene Skripte, die Spark selbst nicht unterstützt . In diesem Zusammenhang hat das Bytedance Batch-Team eine Lösung für die reibungslose Migration von MapReduce-Aufgaben zu Spark entworfen und implementiert. Diese Lösung ermöglicht es Benutzern, die reibungslose Migration von MapReduce zu Spark abzuschließen, indem sie nur eine kleine Anzahl von Parametern oder Umgebungsvariablen zu vorhandenen Jobs hinzufügen. Migrationskosten deutlich reduzieren und gute Kostenvorteile erzielen.

Wei Zhongjia

ByteDance-Infrastrukturingenieur

Er kam 2018 zu ByteDance und ist derzeit Big-Data-Entwicklungsingenieur der ByteDance-Infrastruktur. Er konzentriert sich auf den Bereich Big Data Distributed Computing und ist hauptsächlich für die Entwicklung des Spark-Kernels und die Entwicklung des selbst entwickelten Shuffle-Dienstes von ByteDance verantwortlich.

ByteDances Hunderte Milliarden Dateien HDFS-Cluster-Praxis

Mit der tiefgreifenden Entwicklung der Big-Data-Technologie werden der Datenumfang und die Nutzungskomplexität immer höher und Apache HDFS steht vor neuen Herausforderungen. Bei ByteDance ist HDFS der Speicher für das traditionelle Hadoop-Data-Warehouse-Geschäft, die Basis für Speicher- und Computing-Separation-Architektur-Computing-Engines und die Speicherbasis für das Training von Modellen für maschinelles Lernen. In ByteDance baut HDFS nicht nur Speicherplanungsfunktionen auf, um die Planung umfangreicher Rechenressourcen über mehrere Regionen hinweg zu ermöglichen und die Stabilität von Rechenaufgaben zu verbessern, sondern bietet auch Datenidentifizierung und Hot- und Cold-Planung, die benutzerseitigen Cache, herkömmliche drei Kopien, integriert. und Kühllagerfähigkeit. Dieser Austausch stellt vor, wie ByteDance intern die neuen Anforderungen für die traditionelle Big-Data-Speicherung in neuen Szenarien versteht und die Systemstabilität in verschiedenen Szenarien durch technologische Entwicklung sowie den Aufbau von Betriebs- und Wartungssystemen unterstützt.

Xiong Mu

Forschungs- und Entwicklungsingenieur für Big Data Storage bei Volcano Engine

Hauptverantwortlich für die Entwicklung der Big-Data-Speicherung, HDFS-Metadatendienste und die ökologische Unterstützung des High-Layer-Computings.

Thema: OLAP & Datenanalyse

Best Practices für das Multi-Engine-Indikatormanagement basierend auf Apache Calcite

Themeneinführung

Bei der Datenanalyse gibt es verschiedene Indikatoren. Bei der Pflege massiver Indikatoren gibt es häufig die folgenden Schwachstellen:

- Wiederholte Segmente können nicht wiederverwendet werden

- Unterschiedliche Engines erfordern das Schreiben unterschiedlicher SQL

- Es ist schwierig, Kaliberänderungen mit allen nachgeschalteten Geräten zu synchronisieren

Um diese Probleme zu lösen, hat ByteDance versucht, die vorhandenen technischen Möglichkeiten zu nutzen, um Lösungen zu entwerfen:

- Speichern Sie Indikatoren so weit wie möglich in Hive-Tabellen: Dadurch werden die Speicherkosten und die Backtracking-Kosten erheblich erhöht, was nicht machbar ist

- Kapselung von Indikatoren in View: Dadurch werden nicht nur zusätzliche Tabelleninformationen in Hive generiert und die Anzahl der Tabellen verdoppelt, sondern es ist auch unfreundlich, Partitionierung zu unterstützen. Die Erfahrung mit der Abfragenutzung ist schlecht, daher ist es schwierig, sie zu fördern

Da die aktuelle Technologie nicht ausreicht, um die oben genannten Probleme zu lösen, hat ByteDance zwei Sätze neuer Syntaxfunktionen basierend auf Apache Calcite entwickelt und implementiert:

- Virtuelle Spalten: Ansichten auf Spaltenebene, Wiederverwendung von Tabellenspaltenberechtigungen, einfache Heraufstufung

- SQL-Funktion definieren: Verwenden Sie SQL, um Funktionen direkt zu definieren und die Wiederverwendung von SQL-Fragmenten zu erleichtern

Durch die Kombination dieser beiden Funktionen können die Kosten für das Indikatorenmanagement effektiv gesenkt werden:

- Der Indikator muss nur einmal geändert werden und es besteht keine Notwendigkeit, ihn synchron nachgelagert zu ändern.

- Felder in Sammlungstypen wie MAP und JSON können als virtuelle Spalten definiert werden, wodurch die Logik klarer und benutzerfreundlicher wird.

Spezifische typische Fälle und Umsetzungsprinzipien werden im Rede-PPT vorgestellt.

Xie Jiajun

Volcano Engine LAS Leitender Forschungs- und Entwicklungsingenieur

Teilnahme an einer Rede auf der Apache Asia Con 2022. Ich liebe Open Source und beteilige mich oft an der Community-Arbeit. Ich bin jetzt ein aktiver Apache Calcite-Committer und ein Linkedin Coral-Mitwirkender.

Praxis der verfeinerten Verwaltung gemischter Berechtigungen in Big-Data-Warteschlangen

Hintergrund:

In den letzten Jahren haben Datensicherheitsfragen nach und nach die Aufmerksamkeit von Regierungen und Unternehmen auf der ganzen Welt auf sich gezogen. Mit der Verabschiedung und Umsetzung nationaler Gesetze zur Datensicherheit und zum Schutz personenbezogener Daten wurden klare Anforderungen an den Grundsatz der Mindestdatengenügsamkeit gestellt. Daher ist die differenziertere Steuerung von Berechtigungen zu einem Problem geworden, das jedes Unternehmen lösen muss.

Aktuelle Probleme:

Die Branche extrahiert normalerweise Berechtigungspunkte in SQL basierend auf Regeln und verwaltet diese Berechtigungspunkte horizontal entsprechend der Zeilendimension oder vertikal entsprechend der Spaltendimension.

Diese eindimensionale Granularität der Berechtigungssteuerung ist zu grob und kann die kombinierte Beziehung zwischen mehreren Berechtigungen nicht unterstützen. In einem mittelgroßen Szenario mit großen, breiten Tabellen wie ByteDance, in dem mehrere Geschäftsbereiche auf einheitliche Weise gespeichert werden, ist es schwierig, die Nachfrage nach einer feinkörnigen Berechtigungskontrolle für Daten zu erfüllen.

Lösung:

Basierend auf den oben genannten Problemen hat ByteDance eine verfeinerte Verwaltungslösung für gemischte Berechtigungen in Zeilen und Spalten entwickelt, die auf Apache Calcite und seinem selbst entwickelten Berechtigungsdienst Gemini basiert.

-

Präzise Extraktion von Autoritätspunkten basierend auf der Calcit-Blutlinie

- Basierend auf der Blutsverwandtschaftsfunktion werden die tatsächlich in SQL verwendeten Berechtigungspunktinformationen (Tabelle, Zeile, Spalte usw.) genau lokalisiert und eine verfeinerte Berechtigungsextraktion durchgeführt.

-

Mehrdimensionale Berechtigungsverwaltung und -steuerung mit gemischten Berechtigungen in Zeilen und Spalten

- Zusätzlich zu den herkömmlichen Bibliotheksberechtigungen, Tabellenberechtigungen und Spaltenberechtigungen kann eine neue Zeilenbeschränkungsberechtigung als spezielle Ressource an Tabellenberechtigungen/Spaltenberechtigungen angehängt werden.

- Jede Tabellenberechtigung/Spaltenberechtigung kann gleichzeitig mit mehreren Zeilenberechtigungsressourcen gebündelt werden, und die Zeilenbeschränkungen verschiedener Tabellenberechtigungen/Spaltenberechtigungen sind unabhängig voneinander.

- Durch die Bündelung horizontaler/vertikaler Berechtigungspunkte werden die Abfrageressourcen auf den „Ressourcenzellen“ mit überlappenden Zeilen und Zeilen positioniert, um detailliertere Berechtigungen auf Ressourcenebene zu erreichen.

Vorteile der Lösung:

- Mit der neuen Lösung wird die Ressourcenverwaltung und -steuerung durch präzise feinkörnige Berechtigungspunktextraktion und mehrdimensionale Zeilen- und Spaltenberechtigungsunterstützung von einer horizontalen Zeile oder einer vertikalen Spalte auf „Ressourcenzellen“ mit überlappenden Zeilen und Zeilen verfeinert .

- Der Umfang der Berechtigungskontrolle wird weiter verfeinert und die erforderlichen Berechtigungen werden mit der kleinsten Granularität gewährt, während gleichzeitig die normale Nutzung durch Benutzer gewährleistet wird.

- Spezifische typische Fälle und Umsetzungsprinzipien werden im Rede-PPT vorgestellt.

Zhu Jiang

Volcano Engine LAS Leitender Forschungs- und Entwicklungsingenieur

Thema: Cloud Native

ByteDance Cloud Native YARN-Praxis

Das interne Offline-Geschäft von Bytedance ist riesig. Täglich laufen Hunderttausende Knoten und Millionen von Aufgaben, und die Menge der täglich genutzten Ressourcen beträgt intern das Offline-Planungssystem und das Online-Planungssystem jeweils verantwortlich für das Offline-Geschäft und das Online-Geschäftsplanungsmanagement. Mit der Entwicklung des Geschäftsumfangs hat dieses System jedoch einige Mängel aufgedeckt: Es gehört zu zwei Offline-Systemen, und einige wichtige Aktivitätsszenarien erfordern eine Offline-Ressourcenkonvertierung durch Betrieb und Wartung. Der Betriebs- und Wartungsaufwand ist hoch und der Konvertierungszyklus ist lang ; Der Mangel an Einheitlichkeit führt dazu, dass die Gesamtressourcenauslastung niedrig ist und die Quotenverwaltung und -steuerung, der Maschinenbetrieb und die Wartung usw. nicht in den Genuss der verschiedenen Vorteile von Cloud Native kommen können, wie z. B. zuverlässige und stabile Isolierung Funktionen, komfortable Betriebs- und Wartungsfunktionen usw. Offline-Systeme müssen dringend vereinheitlicht werden, und herkömmliche Big-Data-Engines sind nicht für Cloud-Native konzipiert und lassen sich nur schwer direkt in der Cloud-Native bereitstellen. Jede Computing-Engine und Aufgabe erfordert eine tiefgreifende Transformation, um verschiedene Funktionen ursprünglich auf YARN zu unterstützen, und die Kosten sind hoch der Transformation ist enorm. Vor diesem Hintergrund schlägt ByteDance eine Cloud-native YARN-Lösung vor – Serverless YARN, die zu 100 % mit dem Hadoop YARN-Protokoll kompatibel ist. Big-Data-Jobs im Hadoop-Ökosystem können ohne Änderungen und Online-Ressourcen transparent auf Cloud-native Systeme migriert werden Offline-Ressourcen können im Time-Sharing effizient und flexibel umgewandelt und wiederverwendet werden, und die Gesamtressourcenauslastung des Clusters wird deutlich verbessert.

Shao Kaiyang

Forschungs- und Entwicklungsingenieur für Cloud Native Computing bei Volcano Engine

Verantwortlich für Offline-Planungsarbeiten in der ByteDance-Infrastruktur und verfügt über langjährige Erfahrung in der technischen Architektur.

Thema: Nachrichtensystem

Kafka ohne Tierpfleger

Derzeit verlässt sich Kafka auf ZooKeeper, um seine Metadaten wie Brokerinformationen, Themen, Partitionen usw. zu speichern. KRaft ist eine neue Generation von Kafka ohne Zookeeper. Diese Vorlesung beinhaltet:

- Warum Kafka neue KRaft-Funktionen entwickeln muss

- Architektur des alten (mit Zookeeper) Kafka und des neuen (ohne Zookeeper) Kafka

- Vorteile der Einführung von Kafka

- wie es intern funktioniert

- Überwachungsindikatoren

- Tools zur Lösung von Kafka-Problemen

- Eine Demo, um zu zeigen, was wir bisher erreicht haben

- Die Roadmap der Kafka-Community für KRaft

Nach diesem Vortrag wird das Publikum besser verstehen, was KRaft ist, wie es funktioniert, wie es sich vom Zookeeper-basierten Kafka unterscheidet und vor allem, wie es überwacht und Fehler behoben werden kann.

Luke Chen

RedHat, leitender Softwareentwickler

Leitender Softwareentwickler bei RedHat, der sich der Ausführung von Apache Kafka-Produkten in der Cloud widmet. Apache Kafka-Committer und PMC-Mitglied, trägt seit mehr als drei Jahren zu Apache Kafka bei.

Deng Ziming

ByteDance Big Data R&D Engineer, Apache Kafka Committer

Die Interaktion am Stand wartet darauf, von Ihnen gespielt zu werden

ByteDance Open Source wird auf dem Konferenzgelände einen interaktiven Stand einrichten, an dem die Open-Source-Projekte von ByteDance ausgestellt und mit den Teilnehmern interagiert werden. Vor Ort gibt es nicht nur ein reichhaltiges Community-Umfeld, sondern auch verschiedene interaktive Links. Freunde, die teilnehmen, sind herzlich eingeladen, einzuchecken

Folgen Sie dem öffentlichen Open-Source-Konto von ByteDance, es wird Überraschungen vor Ort geben!

Den vollständigen Zeitplan finden Sie unter: https://apachecon.com/acasia2023/en/tracks.html

Fellow Chicken „Open-Source“ -Deepin-IDE und endlich Bootstrapping erreicht! Guter Kerl, Tencent hat Switch wirklich in eine „denkende Lernmaschine“ verwandelt. Tencent Clouds Fehlerüberprüfung und Situationserklärung vom 8. April RustDesk-Remote-Desktop-Startup-Rekonstruktion Web-Client WeChats Open-Source-Terminaldatenbank basierend auf SQLite WCDB leitete ein großes Upgrade ein TIOBE April-Liste: PHP fiel auf ein Allzeittief, Fabrice Bellard, der Vater von FFmpeg, veröffentlichte das Audiokomprimierungstool TSAC , Google veröffentlichte ein großes Codemodell, CodeGemma , wird es dich umbringen? Es ist so gut, dass es Open Source ist – ein Open-Source-Bild- und Poster-Editor-Tool