Geschwindigkeit entscheidet oft über Erfolg oder Misserfolg im Geschäft.

Die Beschleunigung des Modelltrainings bedeutet, dass Unternehmen neue KI-Produkte oder -Dienstleistungen schneller entwickeln und diese dadurch schneller auf den Markt bringen und Kundenbedürfnisse erfüllen können. Diese schnelle Reaktionsfähigkeit hilft Unternehmen, Chancen im Wettbewerb zu nutzen und sich Marktvorteile zu verschaffen. Darüber hinaus bedeutet die Beschleunigung, dass Unternehmen die für die Schulung erforderliche Zeit reduzieren können, wodurch die Belegung von Hardware-Ressourcen und der Energieverbrauch reduziert werden, was zu einem höheren ROI führt.

Als weltweit führende Hochleistungs-KI-Datenzugriffsplattform wird Alluxio häufig in den Kernphasen des KI-Modelltrainings und der Inferenz eingesetzt. Dieses Mal haben wir uns mit Zhongguancuns bekannter Inkubatormarke Taili Station und DataFun, einer vertikalen Community von Data-Intelligence-Entwicklern , zusammengetan , um KI-Infra-Experten aus der Internet-, Automobil- und großen Modellindustrie einzuladen , um Industriepartnern ein beschleunigtes KI-Modell zu bieten Schulung. Ein wunderbarer Offline-Salon mit Themen.

Wir laden IT-/Technikleiter, Architekten, Entwickler und Forscher sowie Umweltpartner im Bereich KI-Infrastruktur herzlich ein, sich anzumelden und teilzunehmen.

QR-Code erkennen

Melden Sie sich jetzt an, um teilzunehmen

√

Veranstaltungszeit: 26. April 2024 (Freitag) 14:00–17:10 Uhr

√

Mitveranstalter: Alluxio x Inno.EcoS Lab x DataFun

√

Veranstaltungsort: Raum 401, 4. Etage, Turm A, Dongsheng-Gebäude, Nr. 8 Zhongguancun East Road, Bezirk Haidian, Peking

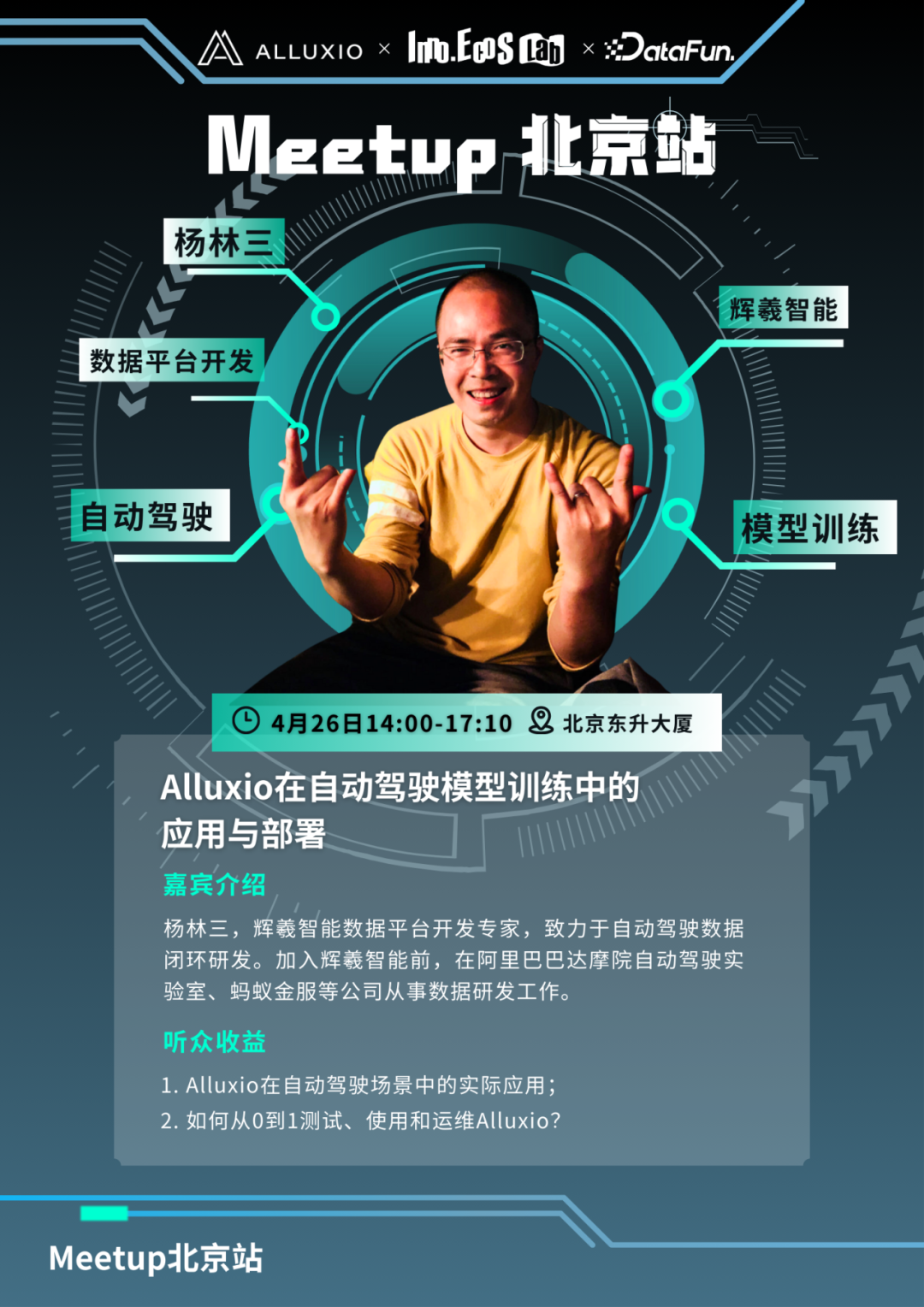

Thema 1: Anwendung und Einsatz von Alluxio im autonomen Fahrmodelltraining

Huixi Intelligence wird 2023 den Dateicache für das Training des autonomen Fahralgorithmus von NAS auf Alluxio umstellen. Das auf Alluxio basierende Caching-System löst die Probleme, die Forschung und Entwicklung seit langem plagen: gravierende Verzögerungen beim gleichzeitigen Datenzugriff, wiederholte Datendownloads, Platzverschwendung durch wiederholte Daten, Ineffizienz und hohe Betriebsrisiken durch manuelle Speicherverwaltung Kapazität , wodurch die Verfügbarkeit des Datensystems um das Zehnfache verbessert wird. Die Kosten werden halbiert und die Benutzerfreundlichkeit wird erheblich verbessert, wodurch das Team die Effizienz der Algorithmusentwicklung erheblich verbessern kann.

√

Warum hat sich Huixi für Alluxio entschieden?

√

Wie nutzt man es beim autonomen Fahren über Cluster hinweg?

√

Wie können Funktionalität und Leistung ausreichend getestet und verifiziert werden?

√

Wie können die Betriebs- und Wartungsfunktionen von Alluxio verbessert werden?

Thema 2: Wie Alluxio die KI-Speicherung in der Hybrid Cloud beschleunigt

Im Jahr 2023 führte Zhihu Alluxio zum ersten Mal im Modellverteilungsszenario ein, was nicht nur das Problem der Cloud-übergreifenden Standleitungsbandbreite löste, sondern auch zu einer zwei- bis dreifachen Verbesserung der Leseleistung führte.

Mit der Entwicklung des Trainings für große Sprachmodelle in Zhihu hat das Algorithmenteam auch höhere Anforderungen an die Speicherung gestellt. Die von Alluxio bereitgestellte Fuse-Schnittstelle hat die Anforderungen der Geschäftsseite gut erfüllt und innerhalb von Zhihu schnell Fuß gefasst Die Entwicklung entwickelte sich vom anfänglichen Cluster zu mehreren Clustern.

Zhihu verfügt über eine Hybrid-Cloud-Architektur, um die Verzögerung beim Datenzugriff während des Modelltrainings zu reduzieren. In jeder öffentlichen Cloud wird eine Reihe von Alluxio-Clustern eingesetzt, um Trainingsdaten auf Offline-HDFS-Clustern schnell an alle öffentlichen Clouds zu verteilen Auf einer GPU-Maschine und ohne jegliche Datenmigration oder -kopie verbessert es die GPU-Auslastung für Trainingsaufgaben erheblich.

Thema 3: Alluxio AI – eine neue Generation der Daten-I/O-Lösung für KI/ML-Trainingsplattformen

Im Zeitalter der datengesteuerten KI ist ein effizienter Zugriff auf große Datenmengen im Speicher für das Training und die Bereitstellung von Modellen von entscheidender Bedeutung. I/O-Herausforderungen beeinträchtigen jedoch häufig die Leistung und schränken die GPU-Auslastung ein.

In diesem Beitrag stellen wir vor, wie die auf Alluxio basierende Hochleistungs-Datenzugriffsschicht I/O-Herausforderungen bewältigen und die GPU-Auslastung deutlich verbessern kann. Anhand umfangreicher Benutzerfälle und experimenteller Daten erfahren Sie, wie Sie Datensätze und Modelle in Alluxio zwischenspeichern und die Leistung verbessern.

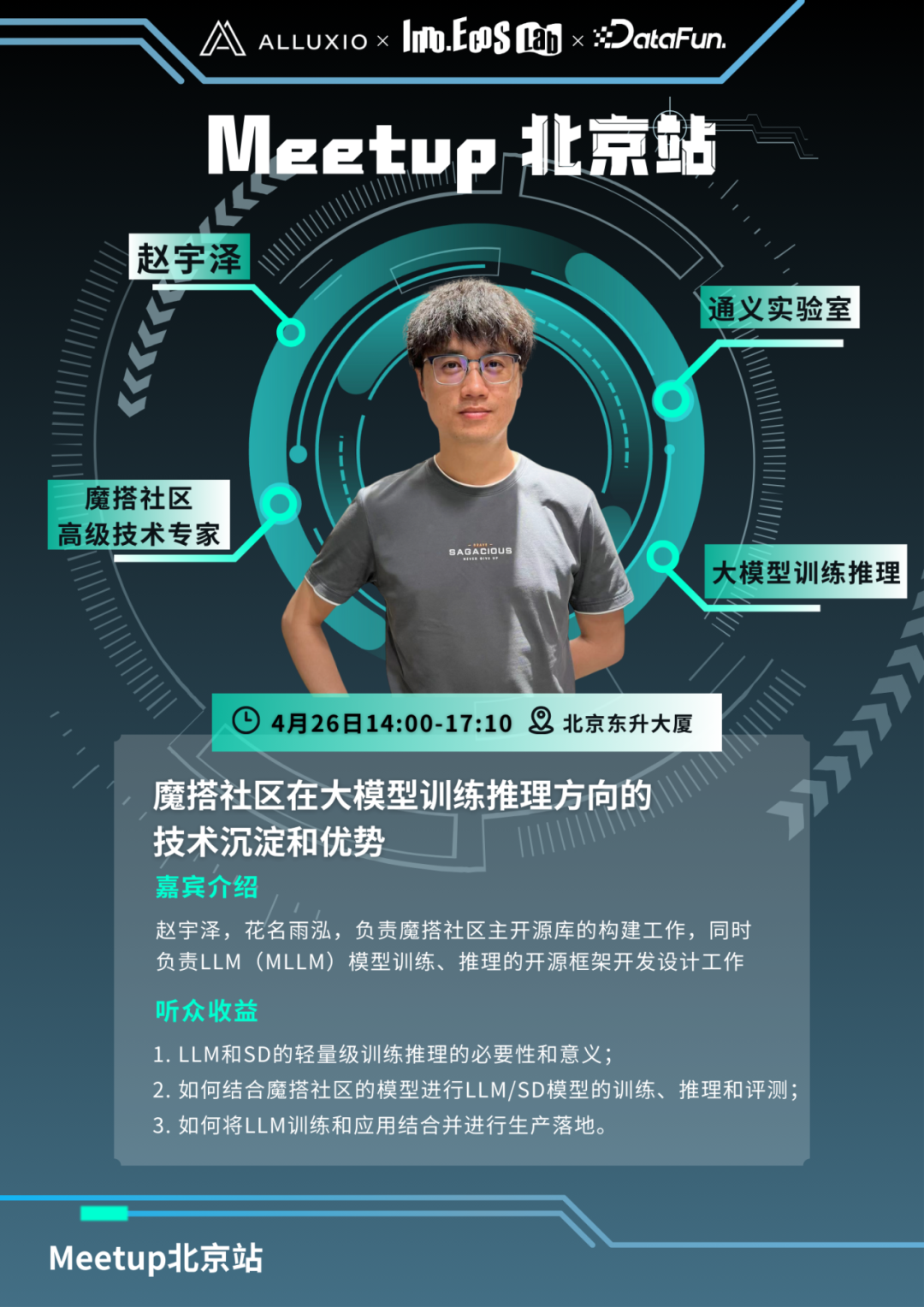

Thema 4: Die technische Anhäufung und Vorteile der Moda-Community in Richtung Training und Inferenz großer Modelle

Die dem Tongyi Lab angeschlossene MoTa-Community hat zahlreiche Schulungen in Richtung LLM/MLLM/SD durchgeführt. Um Community-Entwicklern das Training und die Anwendung von LLM zu erleichtern und wirklich inklusive KI zu erreichen, hat die MoTa-Community Open Source entwickelt Training Das Inferenz-Framework SWIFT verfügt über die Trainingsfähigkeiten von über 200 LLM- und über 100 Open-Source-Datensätzen und kann problemlos auf neue Modelle erweitert werden. Unter der Leitung von SD AIGC entwickelten Moda Community und das Basic Vision-Team des Tongyi Laboratory das Trainings-Framework Scepter. Dieses Framework nutzt LoRA und die selbst entwickelte SCEdit-Technologie, um eine bequeme Feinabstimmung und Inferenz von Vincentian-Graphmodellen zu erreichen, und kann kontrollierbare unterstützen generieren.

...

und es warten noch weitere spannende Inhalte darauf, von Ihnen vor Ort entdeckt zu werden

......

14:00–14:05 Uhr Der Moderator eröffnet die Show

14:05-14:45 Alluxio AI KI/ML-Trainingsplattform der neuen Generation für Daten-I/O-Lösung

14:45-15:25 Wie Alluxio die KI-Speicherung in der Hybrid Cloud beschleunigt

15:25-15:40 Uhr Teepause

15:40-16:20 Anwendung und Einsatz von Alluxio im autonomen Fahrmodelltraining

16:20-17:00 Die technische Anhäufung und Vorteile der Moda-Community in Richtung Training und Inferenz großer Modelle

17:00-17:10 Technischer Austausch & Ende

QR-Code erkennen

Melden Sie sich jetzt an, um teilzunehmen

Nehmen Sie an dieser Veranstaltung teil

Jeder Besucher der Veranstaltung erhält ein Souvenir

Parallel dazu gibt es vor Ort eine Aktion zum Ausfüllen von Fragebögen und zum Verlosen von Geschenken.

Bei Fragen scannen Sie bitte den QR-Code des Assistenten am Ende des Artikels und kontaktieren Sie uns ~

Alluxio ist der weltweit führende Anbieter leistungsstarker Datenplattformen für Analysen und KI, der die Wertschöpfung von KI-Produkten für Unternehmen beschleunigt und den Return on Investment der Infrastruktur maximiert. Die Alluxio-Datenplattform sitzt zwischen Computer- und Speichersystemen und bietet in jeder Phase des Datenworkflows eine einheitliche Sicht auf die Arbeitslasten auf der Datenplattform. Die Plattform bietet leistungsstarken Datenzugriff unabhängig vom Speicherort der Daten, vereinfacht das Data Engineering, verbessert die GPU-Auslastung und reduziert Cloud-Computing- und Speicherkosten. Unternehmen können das Modelltraining und die Modellbereitstellung erheblich beschleunigen und eine KI-Infrastruktur auf vorhandenen Data Lakes aufbauen, ohne dedizierten Speicher zu verwenden.

Mit der Unterstützung führender Investoren bietet Alluxio Dienstleistungen für globale Technologie-, Internet-, Finanz- und Telekommunikationsunternehmen an. Derzeit nutzen 9 der 10 größten Internetunternehmen der Welt Alluxio. Weitere Informationen finden Sie unter www.alluxio.com.cn.

Die Inno.EcoS Lab Taili Station ist die Inkubatormarke des Zhongguancun Dongsheng Science and Technology Park. Es handelt sich um ein Inkubationsbeschleunigungsnetzwerk und eine Innovationsplattform für industrielle Innovationen, die mit dem High-Tech-Unternehmenswachstumsökosystem Inno.EcoS als Kern eingerichtet wurden. Taili Station konzentriert sich auf die drei großen Industriebereiche Biowissenschaften, digitale Wirtschaft und neue Energie/neue Materialien. Das Unternehmen engagiert sich seit mehr als 10 Jahren intensiv im Bereich Industriedienstleistungen und bündelt Innovationen und unternehmerische Ressourcen aus der ganzen Welt Auswahlmöglichkeiten für High-Tech-Unternehmen in der Vorgründungs-, Beschleunigungs- und Wachstumsphase. Verschiedene Arten und Standorte von Büroräumen sowie die Unterstützung innovativer Unternehmenstechnologiedienste.

DataFun wurde Ende 2017 gegründet und ist eine vertikale Community, die sich auf die Betreuung von Data-Intelligence-Entwicklern konzentriert. Angetrieben von der Mission, „Millionen von datenintelligenten Entwicklern hervorzubringen und Zehntausenden von Unternehmen dabei zu helfen, digital intelligent zu werden“, wurden in fast sechs Jahren ununterbrochener Tätigkeit mehr als 4.000 Experten auf diesem Gebiet eingeladen, ihre Erfahrungen und mehr auszutauschen Über 100.000 Experten haben Erfahrungen in Form von Videos, Bildern und Texten gesammelt und 500.000 präzise Entwickler im gesamten Netzwerk beeinflusst. Bei DataFun können Sie sich mit renommierten Experten, modernsten Technologien, Best Practices und herausragenden Entwicklergruppen im Bereich Data Intelligence vernetzen. Ich hoffe, dass DataFun Entwickler, Unternehmen und Branchen auf ihrem Weg in das Zeitalter der Datenintelligenz begleiten kann.

✦

[Assistenten hinzufügen, um weitere Veranstaltungsdetails zu erfahren]

✦

✦

【Aktuelle Popularität】

✦

✦

【Baodian-Markt】

✦

Dieser Artikel wurde über das öffentliche WeChat-Konto – Alluxio (Alluxio_China) – geteilt.

Bei Verstößen wenden Sie sich bitte zur Löschung an [email protected].

Dieser Artikel ist Teil des „ OSC Source Creation Plan “. Alle, die ihn lesen, sind herzlich eingeladen, mitzumachen und ihn gemeinsam zu teilen.