introducción

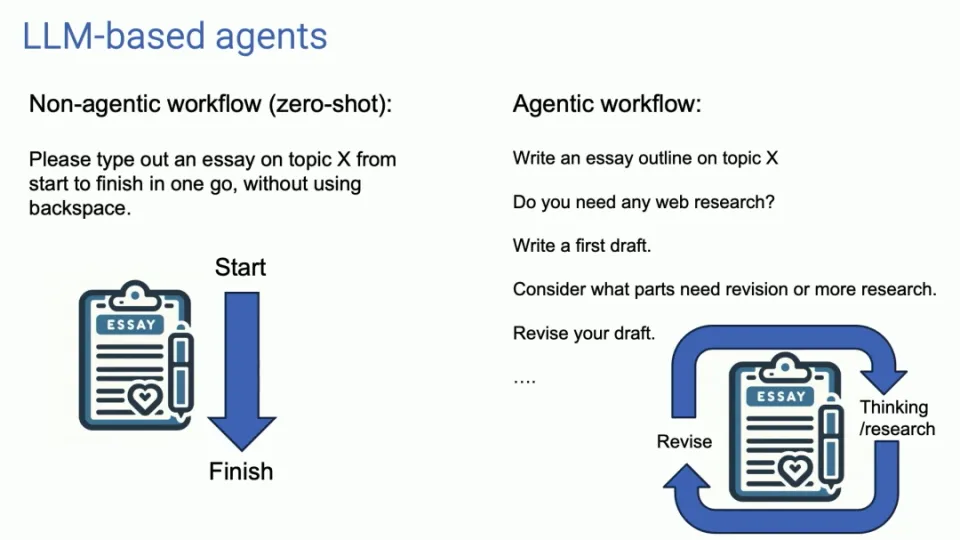

Recientemente, en la Cumbre de IA de Sequoia en los Estados Unidos, el profesor Andrew Ng, una autoridad de alto perfil en el campo de la inteligencia artificial, publicó tendencias de vanguardia y conocimientos profundos sobre los agentes de IA. Señaló que, en comparación con las aplicaciones convencionales de modelo de lenguaje a gran escala (LLM), el flujo de trabajo del Agente exhibe características más iterativas y conversacionales, lo que nos abre nuevas ideas en el campo del desarrollo de aplicaciones de IA.

En esta cumbre, el profesor Ng Enda discutió en profundidad las perspectivas de desarrollo de AI Agent, que es un tema apasionante para todos los desarrolladores e investigadores de IA. Explicó las características centrales del flujo de trabajo del Agente: en lugar de buscar retroalimentación inmediata, aboga por entregar tareas a través de comunicación continua y procesos iterativos para lograr mejores resultados.

Características del flujo de trabajo del agente

El uso tradicional de LLM es similar a la entrada y salida única, mientras que el flujo de trabajo del Agente es como un diálogo continuo, optimizando los resultados de salida a través de múltiples iteraciones. Este enfoque requiere que cambiemos la forma en que interactuamos con la IA, deleguemos más tareas al agente y esperemos pacientemente los resultados que proporciona.

Cuatro patrones principales de diseño de agentes

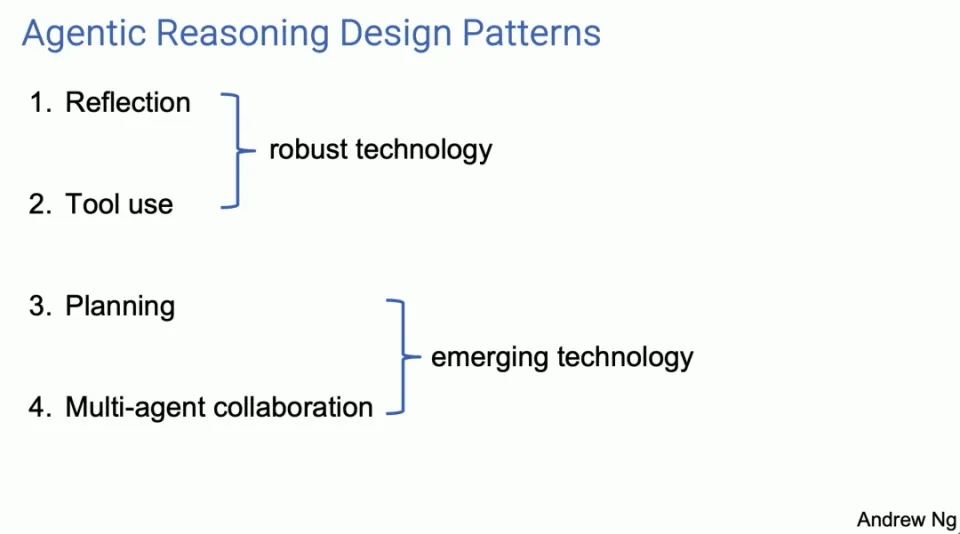

El profesor Ng Enda presentó cuatro patrones principales de diseño de agentes, cada uno de los cuales muestra el potencial para mejorar las capacidades de la IA.

-

Reflexión

- El agente mejora la calidad de los resultados mediante la autorevisión y corrección de los resultados. Por ejemplo, al escribir código, el Agente puede autorreflexionar y corregir errores, generando así un mejor código.

Agent Reflection es una herramienta que creo que muchos de nosotros usamos y es la herramienta que funciona. Creo que es más reconocido y de hecho funciona bastante bien. Creo que estas son técnicas bastante sólidas. Cuando los uso, casi siempre logro que funcionen bien con la planificación y la colaboración entre múltiples agentes.

Creo que este es más bien un campo emergente y a veces me sorprende lo bien que funcionan cuando los uso, pero al menos por el momento siento que no siempre puedo lograr que funcionen de manera confiable. Permítanme explicar estos cuatro patrones de diseño a través de varios aspectos. Si algunos de ustedes regresan y prueban esto ustedes mismos, o hacen que sus ingenieros los utilicen, creo que obtendrán un aumento de productividad con bastante rapidez.

Respecto a la Reflexión, aquí hay un ejemplo. Digamos que le pido a un sistema que escriba código para completar una tarea determinada. Y luego tenemos un agente de codificación, que es simplemente un LLM al que le pides que escriba código, como, "Oye, define doTask, escribe una función como esta".

Un ejemplo de autorreflexión podría ser si luego le pide a LLM algo como: "Aquí hay un fragmento de código destinado a realizar una tarea, simplemente dele exactamente el mismo código que acaban de generar y diga, verifique dos veces ¿Es correcto el código? eficiente, bien construido? Simplemente escribe una pista como esta”.

Puede resultar que el mismo LLM al que le solicitó que escribiera el código pueda encontrar un error como este en la línea 5 y solucionarlo de alguna manera. Si ahora le brinda sus propios comentarios y lo vuelve a solicitar, es posible que obtenga una segunda versión del código que funcione mejor que la primera.

No hay garantías, pero a menudo funciona lo suficientemente bien como para que valga la pena probarlo en muchas aplicaciones, y es un buen augurio si le permite ejecutar las pruebas unitarias y, si no las supera, ¿por qué no las supera? Tener esa conversación podría arrojar algo de luz sobre por qué fallan las pruebas unitarias. Intente cambiar algunas cosas y tal vez obtenga la versión 3.

Por cierto, para aquellos que quieran aprender más sobre estas tecnologías, estoy muy entusiasmado con ellas, para cada una de las cuatro partes, tengo una sección de Lecturas recomendadas en la parte inferior, donde se incluyen más referencias.

Nuevamente, con los sistemas multiagente, estoy describiendo un agente de código único al que usted solicita que hable consigo mismo. Una evolución natural de esta idea es que en lugar de un único agente de código, se podrían tener dos agentes, uno de los cuales es el agente de código y el otro un agente de crítica. Estos pueden ser el mismo LLM subyacente, pero motivados de diferentes maneras. Digamos que eres un escritor de códigos experto, ¿verdad? escribe el código. Otro dijo: usted es un revisor de código experto, revise este código.

Este flujo de trabajo es realmente fácil de implementar. Creo que esta es una técnica muy versátil para muchos flujos de trabajo. Esto mejorará significativamente el desempeño de LLM.

-

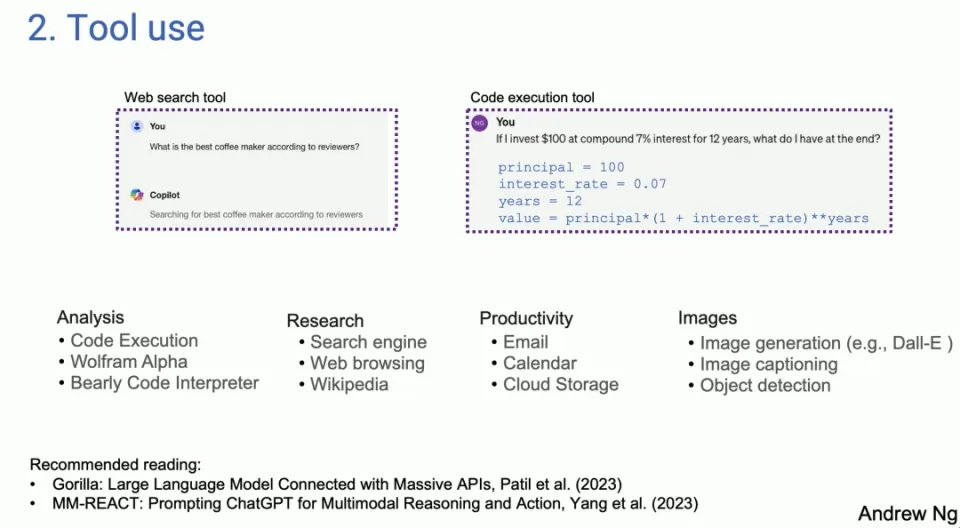

Uso de herramientas

- LLM puede generar código y llamar a API para realizar operaciones prácticas, ampliando así su alcance de aplicación. En este modo, LLM no solo puede generar texto, sino también interactuar con herramientas e interfaces externas.

El segundo patrón de diseño es uno que muchas personas han visto utilizado en sistemas basados en LLM. A la izquierda hay una captura de pantalla de Copilot. A la derecha hay algo que saqué de GPT-4, pero el LLM de hoy, si le pregunta cuál es la mejor máquina de café de una búsqueda en línea, para ciertas preguntas, LLM generará el código y ejecutará el código. Resulta que hay muchas herramientas diferentes utilizadas por muchas personas diferentes para el análisis, la adquisición de información, la acción y la productividad personal.

Los primeros trabajos se volvieron útiles, originalmente en la comunidad de visión por computadora. Porque antes de LLM, no podían procesar imágenes. Entonces, la única opción es generar una llamada de función que pueda manipular la imagen, como generar una imagen o detectar objetos, etc. Si realmente miras la literatura, es interesante que gran parte del trabajo sobre el uso parece haberse originado en el dominio de la visión, porque antes de GPT-4 y demás, LLM estaba ciego a las imágenes, y de eso se trata el uso y la extensión de LLM. Cosas que se pueden hacer.

-

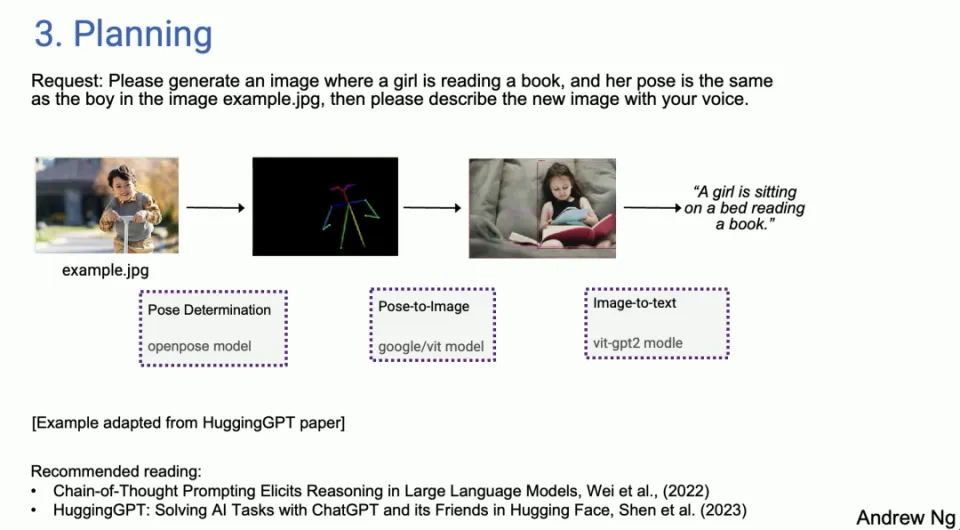

Planificación

- El agente puede dividir tareas complejas y ejecutarlas según lo planeado, lo que demuestra la capacidad de la IA para manejar problemas complejos. Los algoritmos de planificación permiten a los agentes gestionar y completar tareas de manera más eficiente.

Y luego la planificación, para aquellos que no han jugado mucho con los algoritmos de planificación, siento que mucha gente habla de momentos de ChatGPT en los que dices, guau, nunca has visto algo como esto. No creo que estés utilizando un algoritmo de planificación todavía. Mucha gente se sorprenderá con AI Agent.

No puedo imaginarme a un agente de IA haciendo esto tan bien. Hice demostraciones en vivo y algunas de ellas fallaron y el Agente de IA evitó esas fallas. De hecho, me encontré con bastantes situaciones en las que, sí, no podía creer que mi sistema de inteligencia artificial hiciera eso de forma autónoma.

Pero un ejemplo adaptado del artículo de HuggingGPT, dijiste, genera una imagen de una niña leyendo un libro en la misma postura que el niño en el ejemplo de imagen dot jpeg, describe la nueva imagen con voz. Entonces, para dar un ejemplo, hoy existe un agente de IA y puedes decidir que lo primero que debes hacer es determinar la postura del niño. Luego, encuentre el modelo correcto y posiblemente extraiga la pose en HuggingFace. A continuación, debes encontrar un modelo de imagen de pose para sintetizar una imagen de una niña y seguir las instrucciones. Luego use la detección de imágenes y finalmente el texto a voz.

De hecho, hoy en día tenemos agentes, no quiero decir que funcionen de manera confiable, son un poco quisquillosos. No siempre funcionan, pero cuando lo hacen, es realmente sorprendente, pero con Agent Sex Loops, a veces también puedes recuperarte de fallas tempranas. Entonces descubrí que ya estaba usando Research Agent. Parte de mi trabajo, parte de mi investigación, pero no tengo ganas, voy a Google y paso mucho tiempo. Se supone que debo enviar al agente de investigación y regresar unos minutos más tarde para ver qué encuentra, a veces funciona, a veces no, pero ya es parte de mi flujo de trabajo personal.

-

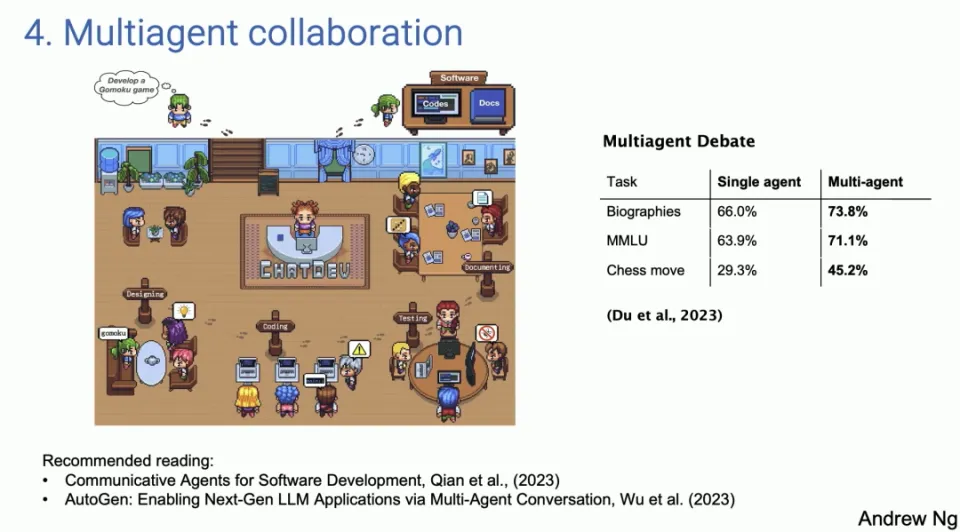

Colaboración multiagente

- Varios agentes desempeñan diferentes roles y cooperan para completar tareas, simulando la colaboración en un entorno de trabajo real. El poder de este enfoque es que permite que LLM se convierta en algo más que una simple herramienta que realiza una sola tarea, sino que se convierta en un sistema colaborativo capaz de manejar problemas y flujos de trabajo complejos.

El último patrón de diseño, la cooperación entre múltiples agentes, suena interesante, pero funciona mucho mejor de lo que piensas. A la izquierda hay una captura de pantalla de un documento llamado ChatDev, que es completamente de código abierto, en realidad de código abierto. Como muchos de vosotros habéis visto, Shining Social

La demostración publicada por el medio ChatDev es de código abierto y se ejecuta en mi computadora portátil. ChatDev es un ejemplo de un sistema multiagente en el que puede pedirle a un LLM que a veces actúe como director ejecutivo de una empresa de ingeniería de software, a veces como diseñador, a veces como gerente de producto y, a veces, como evaluador.

Al pedirle a LLM que le diga que ahora usted es el CEO, ahora es el ingeniero de software, ellos colaboran y tienen una conversación extensa hasta el punto en que si usted se lo dice, por favor desarrolle un juego, desarrolle un juego multijugador, ellos De hecho, dedica unos minutos a escribir el código, probarlo, iterarlo y terminar con un programa sorprendentemente complejo.

Este tipo de colaboración entre múltiples agentes puede parecer un poco extravagante, pero en realidad funciona mejor de lo que imagina. Esto no se debe sólo a que la cooperación entre estos agentes puede aportar aportaciones más ricas y diversas, sino también a que puede simular un escenario más cercano a un entorno laboral real, en el que personas con diferentes roles y experiencia trabajan hacia un objetivo común. El poder de este enfoque es que permite que LLM se convierta en algo más que una simple herramienta que realiza una sola tarea, sino que se convierta en un sistema colaborativo capaz de manejar problemas y flujos de trabajo complejos.

El valor potencial de este enfoque es enorme, ya que abre nuevas posibilidades para automatizar y hacer que los flujos de trabajo sean más eficientes. Por ejemplo, al simular los diferentes roles de un equipo de desarrollo de software, una empresa puede automatizar ciertas tareas de desarrollo, acelerando así los proyectos y reduciendo errores. De manera similar, este método de cooperación de múltiples agentes también se puede aplicar a otros campos, como la creación de contenido, la educación y la capacitación y la planificación estratégica, ampliando aún más el alcance de aplicación de LLM en diversas industrias.

Potencial y desafíos del flujo de trabajo de los agentes

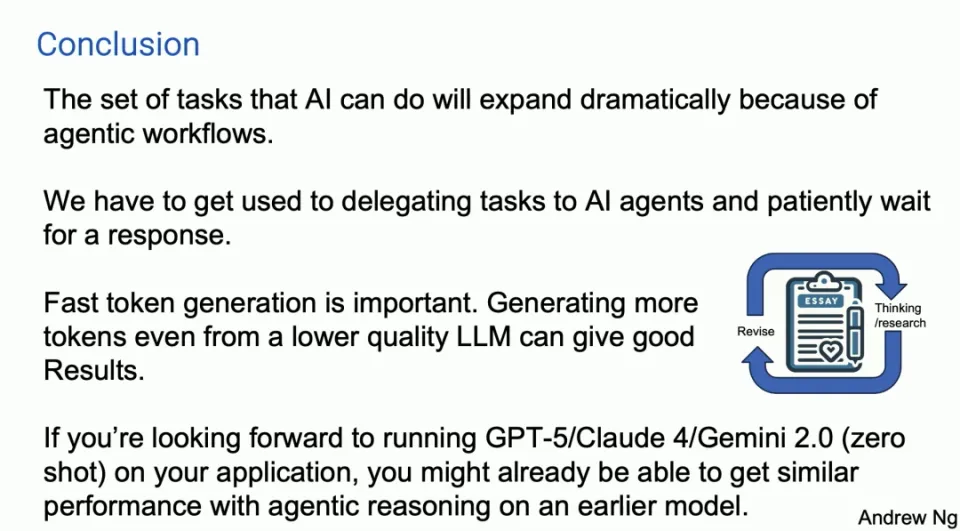

Aunque estos flujos de trabajo de agentes están llenos de potencial, aunque se desarrollan rápidamente, también presentan algunos desafíos. Algunos patrones de diseño son relativamente maduros y confiables, mientras que otros aún son inciertos. Además, no se puede ignorar la importancia de la generación rápida de tokens, ya que permite obtener buenos resultados incluso si se basa en un LLM de menor calidad y genera nuevos tokens mediante una iteración rápida.

Estudios de casos y aplicaciones prácticas.

El profesor Ng Enda explicó con más detalle la eficacia del flujo de trabajo del Agente a través de estudios de casos y aplicaciones prácticas. Por ejemplo, el análisis de codificación utilizando Human Eval Benchmark y la comparación de rendimiento entre GPT-3.5 y GPT-4 muestran la superioridad del flujo de trabajo del Agente. Especialmente en el campo del desarrollo de software, los ejemplos de aplicaciones de sistemas multiagente muestran cómo mejorar la eficiencia del desarrollo y reducir los errores simulando diferentes roles en un entorno de trabajo real.

perspectiva del futuro

El profesor Ng Enda cree que las capacidades de los agentes de IA se ampliarán enormemente y necesitamos aprender nuevas formas de trabajar con los agentes de IA. El potencial de la iteración rápida y de los primeros modelos indica que la IA se aplicará de forma más amplia y profunda en diversos campos.

Resumir

A través de patrones de diseño como la reflexión de agentes, la planificación y la cooperación entre múltiples agentes, no solo podemos mejorar el rendimiento de los LLM, sino también ampliar sus áreas de aplicación y convertirlos en herramientas más potentes y flexibles. A medida que estas tecnologías continúan desarrollándose y mejorando, esperamos que los agentes de IA desempeñen un papel clave en más escenarios en el futuro, brindando soluciones más inteligentes y eficientes a las personas.

No siempre funciona. Lo he usado. A veces no funciona, a veces es sorprendente, pero la tecnología definitivamente está mejorando. También hay un patrón de diseño, y resulta que el debate entre múltiples agentes, es decir, el debate entre diferentes agentes, por ejemplo, puedes hacer que ChatGPT y Gemini debatan entre sí, lo que en realidad conduce a un mejor rendimiento.

Por lo tanto, tener múltiples agentes aéreos simulados trabajando juntos también es un patrón de diseño poderoso. En resumen, creo que estos son los patrones que he visto. Creo que si pudiéramos utilizar estos patrones, muchos de nosotros podríamos lograr mejoras prácticas muy rápidamente. Creo que el patrón de diseño del razonamiento del Agente será importante.

Aquí está mi breve diapositiva de resumen. Predigo que debido al flujo de trabajo del Agente, las tareas que la IA puede realizar se expandirán significativamente este año. Una cosa a la que realmente es difícil acostumbrarse es que cuando enviamos un mensaje al LLM, esperamos una respuesta inmediata. De hecho, hace diez años, cuando estaba en Google hablando sobre lo que llamamos búsqueda de cuadro grande, una de las razones por las que las indicaciones son largas, una de las razones por las que no logré impulsar fue porque cuando haces una búsqueda en la web, Quieres buscar en la mitad del tiempo. Obtén una respuesta en segundos, ¿verdad? Esta es la naturaleza humana, captura instantánea, retroalimentación instantánea.

Para muchos flujos de trabajo de agentes, creo que debemos aprender a delegar tareas a agentes de IA y esperar pacientemente durante minutos o incluso horas para obtener una respuesta, pero como he visto a muchos gerentes novatos delegan tareas a alguien y luego cinco minutos después de la inspección. lo mismo no? Esto no es productivo.

Creo que también debemos aprender a hacer eso con algunos de nuestros agentes de IA, aunque es difícil. Me pareció escuchar alguna pérdida. Entonces, una tendencia importante es que los generadores rápidos de tokens son importantes porque en estos flujos de trabajo de los agentes estamos iterando constantemente. Entonces, LLM genera tokens para LLM, y es fantástico poder generar tokens mucho más rápido de lo que cualquiera puede leer.

Creo que generar más tokens rápidamente, incluso desde un LLM de calidad ligeramente inferior, puede dar buenos resultados en comparación con tokens más lentos de un LLM mejor. Esto podría ser un poco controvertido porque podría hacer que usted dé vueltas al círculo más veces, algo así como lo que mostré en la primera diapositiva con GPDC y los resultados de una arquitectura de Agente.

Francamente, tengo muchas ganas de ver Claude5 y Claude4, GPT-5 y Gemini 2.0 y todos estos maravillosos modelos que están construyendo. Una parte de mí siente que si estás buscando ejecutar tus cosas en GPT-5, sin disparo, es posible que en algunas aplicaciones te acerques más a ese nivel de rendimiento de lo que crees con la inferencia del agente, pero en un modelo inicial, Creo que esta es una tendencia importante.

Honestamente, el camino hacia AGI se siente más como un viaje que como un destino, pero creo que este flujo de trabajo del Agente podría ayudarnos a dar un pequeño paso adelante en este largo viaje.

Linus tomó el asunto en sus propias manos para evitar que los desarrolladores del kernel reemplacen las pestañas con espacios. Su padre es uno de los pocos líderes que puede escribir código, su segundo hijo es el director del departamento de tecnología de código abierto y su hijo menor es un núcleo. Colaborador de código abierto Huawei: tomó 1 año convertir 5000 aplicaciones móviles de uso común Migración completa a Hongmeng Java es el lenguaje más propenso a vulnerabilidades de terceros Wang Chenglu, el padre de Hongmeng: el código abierto Hongmeng es la única innovación arquitectónica. En el campo del software básico en China, Ma Huateng y Zhou Hongyi se dan la mano para "eliminar rencores". Ex desarrollador de Microsoft: el rendimiento de Windows 11 es "ridículamente malo " " Aunque lo que Laoxiangji es de código abierto no es el código, las razones detrás de él. Son muy conmovedores. Meta Llama 3 se lanza oficialmente. Google anuncia una reestructuración a gran escala.Este artículo es una reimpresión del artículo Heng Xiaopai y los derechos de autor pertenecen al autor original. Se recomienda visitar el texto original. Para reimprimir este artículo, comuníquese con el autor original.