1월 17일 상하이에서 학자 푸위안 2.0(InternLM2) 기자간담회와 학자 푸위안 대형 모델 챌린지 발대식이 열렸다. 상하이 인공 지능 연구소(Shanghai Artificial Intelligence Laboratory)와 SenseTime은 홍콩 중문 대학교 및 푸단 대학교와 함께 차세대 대형 언어 모델 학자 Puyu 2.0(InternLM2)을 공식 출시했습니다 .

오픈소스 주소

보고서에 따르면 InternLM2는 2조 6천억 개의 토큰으로 구성된 고품질 코퍼스에 대해 교육을 받았습니다. 1세대 학자 Puyu(InternLM)의 설정에 따라 InternLM2에는 7B와 20B의 두 가지 매개변수 사양과 기본 및 대화 버전이 포함되어 있어 다양하고 복잡한 응용 시나리오의 요구 사항을 충족합니다. Shanghai AI Laboratory는 "고품질 오픈 소스로 혁신 강화"라는 개념을 고수하며 InternLM2에 대한 무료 상용 라이센스를 계속 제공하고 있습니다.

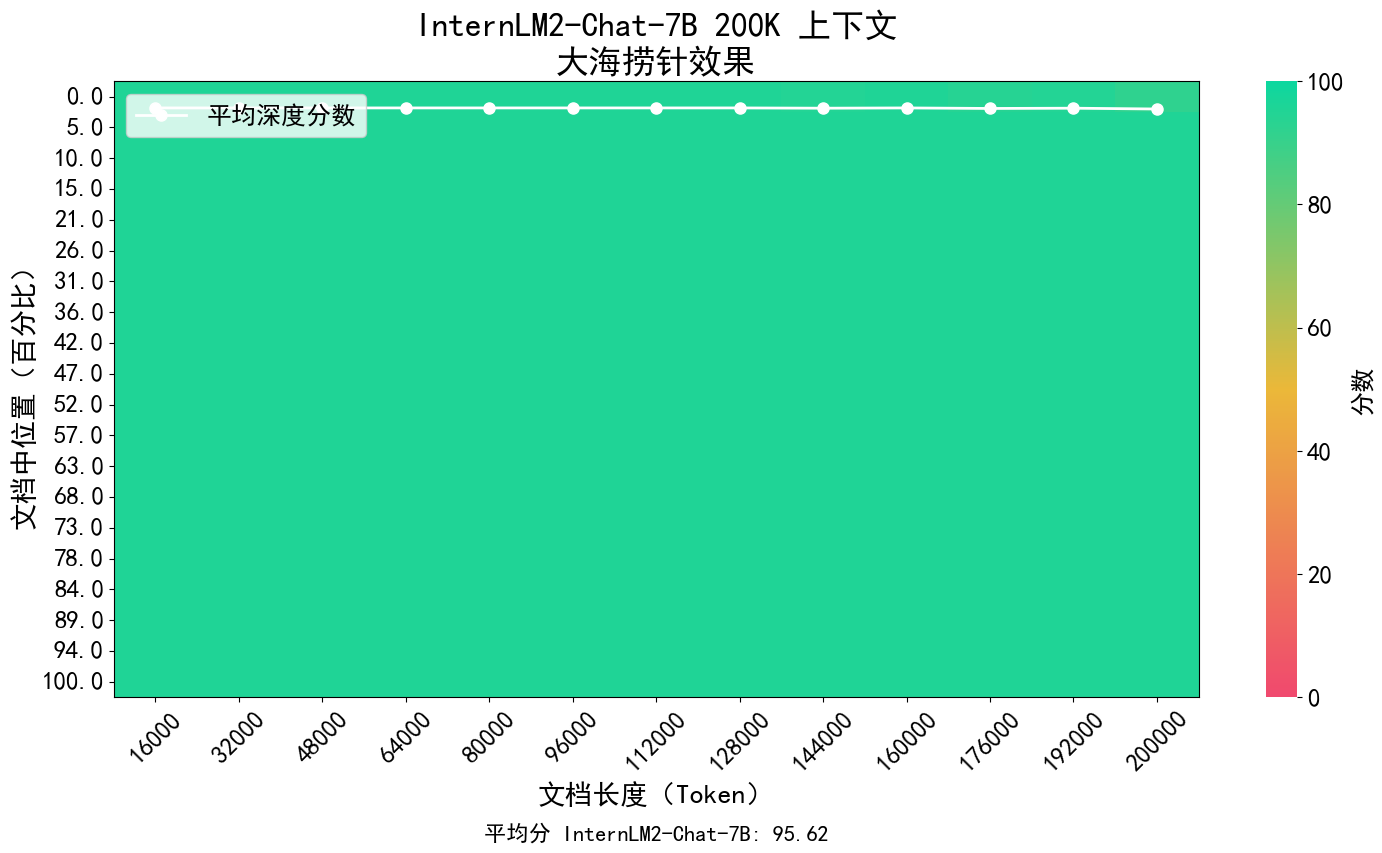

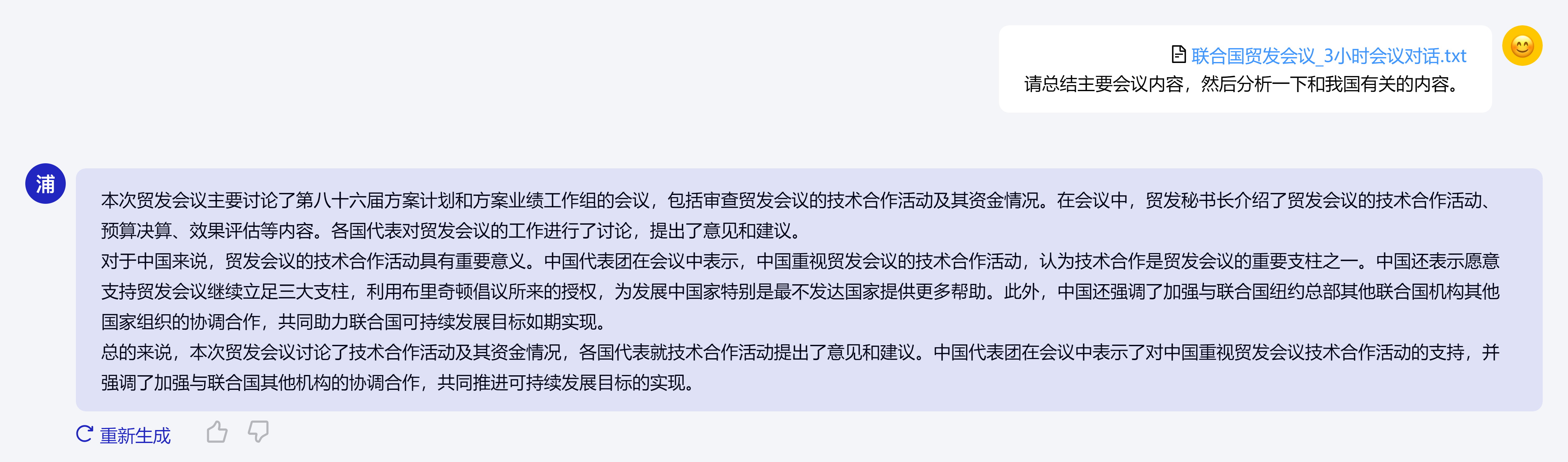

InternLM2의 핵심 개념은 언어 모델링의 본질로 돌아가는 것이며, 말뭉치의 품질과 정보 밀도를 향상시키고 수학 분야에서 큰 발전을 이루어 모델 기반의 언어 모델링 기능의 질적 향상을 달성하는 데 전념하고 있습니다. 코딩, 대화, 창작 등의 발전이 이루어졌으며 종합적인 성능은 동일한 규모의 오픈 소스 모델의 선두 수준에 도달했습니다. 200,000개 토큰의 컨텍스트를 지원하고, 한 번에 약 300,000개의 한자 입력 콘텐츠를 수신 및 처리하며, 핵심 정보를 정확하게 추출하고, 긴 텍스트의 "건초 더미에서 바늘 찾기"를 달성합니다.

또한, InternLM2는 다양한 기능에서 포괄적인 발전을 이루었으며, 1세대 InternLM과 비교하여 추론, 수학, 코딩 등의 기능이 크게 향상되었으며, 포괄적인 기능은 오픈 소스 모델과 동일한 수준보다 앞서 있습니다.

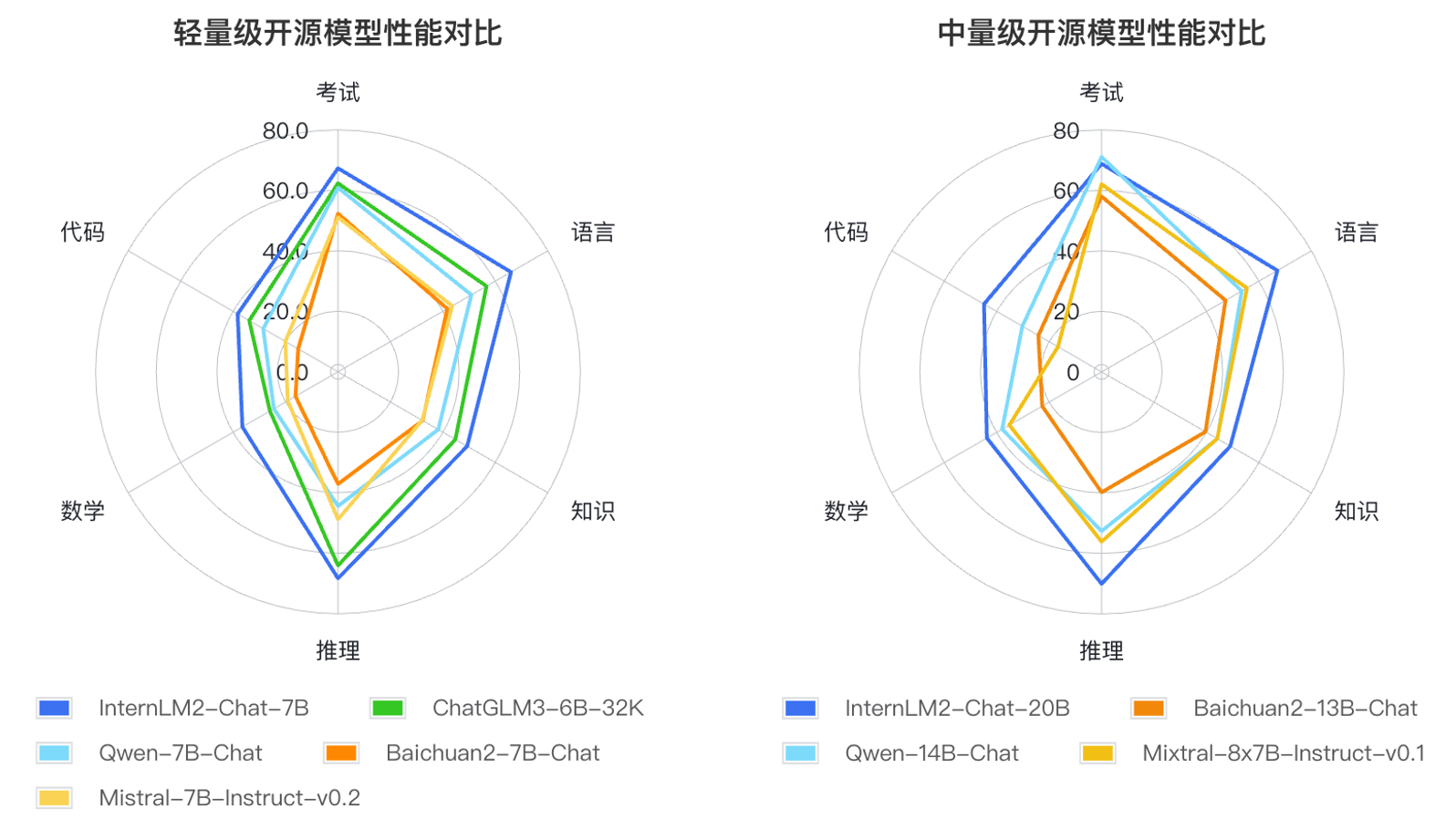

연구자들은 대규모 언어 모델의 적용 방법과 사용자가 관심을 갖는 핵심 영역을 기반으로 언어, 지식, 추론, 수학, 코드, 시험 등 6가지 역량 차원을 정의하고 동일한 규모의 여러 모델의 성능을 테스트했습니다. 55개의 주류 평가 세트 성능이 종합적으로 평가되었습니다. 평가 결과, InternLM2의 경량(7B) 버전과 미들급(20B) 버전이 동일한 크기의 모델 중에서 좋은 성능을 발휘하는 것으로 나타났습니다.